Der wachsende Einfluss von KI in großen Organisationen bringt entscheidende Herausforderungen bei der Verwaltung von KI-Plattformen mit sich. Dazu gehört die Entwicklung einer skalierbaren und betrieblich effizienten Plattform, die den Compliance- und Sicherheitsstandards der Organisation entspricht. Amazon SageMaker-Studio bietet umfassende Funktionen für Praktiker des maschinellen Lernens (ML) und Datenwissenschaftler. Dazu gehört eine vollständig verwaltete KI-Entwicklungsumgebung mit integrierter Entwicklungsumgebung (IDE), die den End-to-End-ML-Workflow vereinfacht. Seine kollaborativen Funktionen wie die gemeinsame Bearbeitung in Echtzeit und die gemeinsame Nutzung von Notizbüchern im Team sorgen für eine reibungslose Teamarbeit, während die Skalierbarkeit und das leistungsstarke Training auf große Datenmengen zugeschnitten sind. Mit integrierter Sicherheit, Kosteneffizienz und einer Reihe vorgefertigter Tools wie Amazon SageMaker-Autopilot, Amazon SageMaker-JumpStart und Amazon SageMaker Feature StoreSageMaker Studio ist eine leistungsstarke Plattform zur Beschleunigung von KI-Projekten und zur Stärkung von Datenwissenschaftlern aller Fachkenntnisse.

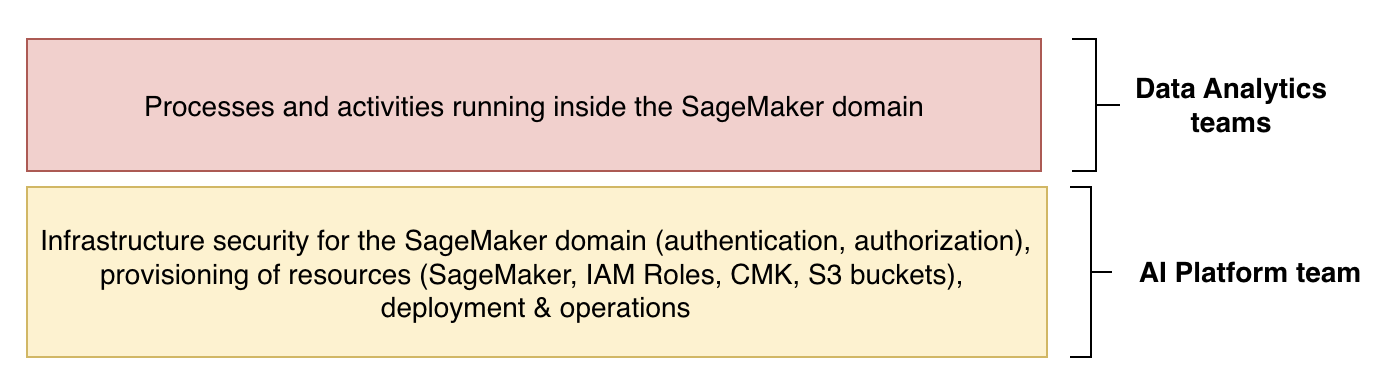

Deutsche Bahn ist ein führendes Transportunternehmen in Deutschland mit einem Umsatz von 56.3 Milliarden Euro (im Jahr 2022), einer Belegschaft von 336,884 Mitarbeitern (davon 221,343 Mitarbeiter in Deutschland) und Niederlassungen in 130 Ländern. Sie bieten eine breite Palette von Dienstleistungen an, darunter öffentlicher und regionaler Verkehr, Güterverkehr und Schieneninfrastruktur. Durch den integrierten Betrieb von Verkehrs- und Schieneninfrastruktur sowie die ökonomisch und ökologisch intelligente Verknüpfung aller Verkehrsträger bewegt die Deutsche Bahn Menschen und Güter. Die Deutsche Bahn war Vorreiter bei der Einführung von KI und nutzte SageMaker Studio als wichtige KI-Plattform. Bei der Deutschen Bahn verwaltet und betreibt ein spezielles KI-Plattform-Team die SageMaker Studio-Plattform, und mehrere Datenanalyseteams innerhalb der Organisation nutzen die Plattform, um verschiedene Analyse- und ML-Aktivitäten zu entwickeln, zu trainieren und durchzuführen.

Das Hauptziel des KI-Plattform-Teams besteht darin, allen Teams und Projekten der Deutschen Bahn einen nahtlosen Zugriff auf Workbench-Dienste und SageMaker Studio zu gewährleisten, wobei der Schwerpunkt vor allem auf Datenwissenschaftlern und ML-Ingenieuren liegt. Diese Plattform unterstützt die Deutsche Bahn dabei, ein Spektrum an Anwendungsfällen zu realisieren, die von der Eisenbahninstandhaltung über Prognosen bis hin zu zukünftigen Anwendungen in der generativen KI reichen.

Der auf SageMaker Studio basierende KI-Plattform-Managed-Service fügt sich nahtlos in die konzernweite Plattformstrategie der Deutschen Bahn ein. Es erfüllt die Compliance-Anforderungen des Unternehmens, ermöglicht durch die Bereitstellung einer SageMaker-Domäne eine schnelle Projektinitiierung für das Team und reduziert den Wartungsaufwand aufgrund eines übergreifenden Betriebsmodells. Zu den Hauptvorteilen gehören die hohe Skalierbarkeit des Dienstes, die größtenteils auf Automatisierung und ein Self-Service-Modell zurückzuführen ist, sowie ein attraktives Preismodell, das sich hauptsächlich am Ressourcenverbrauch orientiert.

„SageMaker Studio stellte uns eine gemeinsame Plattform zur Verfügung, die skalierbar und sicherheitskonform ist und die Entwicklungsanforderungen von Datenwissenschaftlern aus mehreren Datenanalyseteams innerhalb der DB-Organisation erfüllt. Zuvor verwaltete und betrieb jedes Team seine eigenen JupyterLab-Notebooks, was weder effizient noch kosteneffektiv war. Innerhalb von 8 Wochen haben wir über 120 Entwickler an Bord geholt, 25 SageMaker-Domänen bereitgestellt und schnell mit der Nutzung dieser Plattform begonnen.“

– Emmanuel Drosos, Product Owner bei DB Systel.

In diesem Beitrag untersuchen wir, wie die Deutsche Bahn ihre KI-Plattform mithilfe von SageMaker Studio für mehrere Teams skaliert und betreibt und dabei robuste Sicherheit und Aufsicht gewährleistet.

Lösungsüberblick

Die Architektur bei der Deutschen Bahn besteht aus einem zentralen Plattformkonto, das von einem Plattformteam verwaltet wird, das für die Verwaltung der Infrastruktur und des Betriebs von SageMaker Studio verantwortlich ist. SageMaker Studio-Ressourcen werden nach gruppiert SageMaker-Domänen, jeweils bestehend aus einem zugehörigen Amazon Elastic File System (Amazon EFS)-Volume, eine Liste autorisierter Benutzer sowie eine Vielzahl von Sicherheits-, Anwendungs-, Richtlinien- und Amazon Virtual Private Cloud (Amazon VPC)-Konfigurationen. Bei der Deutschen Bahn nutzen Datenwissenschaftler verschiedener Teams SageMaker-Domänen für ihre ML-Aktivitäten; Jedes Team verfügt über eine eigene SageMaker-Domäne, die es zum Entwickeln und Testen von ML-Modellen verwendet und mithilfe von Funktionen wie der Notebook-Freigabe zusammenarbeitet.

Aus infrastruktureller Sicht ist die VPC Das im AI-Plattform-Konto bereitgestellte, wie in der folgenden Abbildung dargestellte, verfügt über keine ausgehende Internetverbindung, um Sicherheit und Compliance zu gewährleisten. Für eine hohe Verfügbarkeit werden mehrere identische private isolierte Subnetze bereitgestellt. Die SageMaker Studio-Domänen werden im Nur-VPC-Modus bereitgestellt, wodurch eine elastische Netzwerkschnittstelle für die Kommunikation zwischen dem SageMaker-Dienstkonto (AWS-Dienstkonto) und der VPC des Plattformkontos erstellt wird. Die Endpunkte wie SageMaker API, SageMaker Studio und SageMaker Notebook ermöglichen eine sichere und zuverlässige Kommunikation zwischen der VPC des Plattformkontos und der von AWS im SageMaker-Dienstkonto verwalteten SageMaker-Domäne.

Jedes Datenanalyseteam kann über das unternehmensinterne Self-Service-Portal eine oder mehrere SageMaker-Domänen anfordern. Dieser Prozess der Bestellung einer SageMaker-Domain wird durch einen separaten Workflow-Prozess orchestriert (via AWS Step-Funktionen). Während dieses Orchestrierungsablaufs wird eine Azure Active Directory (AD)-Gruppe für das Datenanalyseteam mit dem AD-Gruppennamen bereitgestellt, der dem Domänennamen entspricht. Die Orchestrierung führt zu einer Pipeline für kontinuierliche Integration und kontinuierliche Bereitstellung (CI/CD), die eine bereitstellt AWS Cloud-Entwicklungskit (AWS CDK) App bestehend aus einer SageMaker-Domäne für das jeweilige Team.

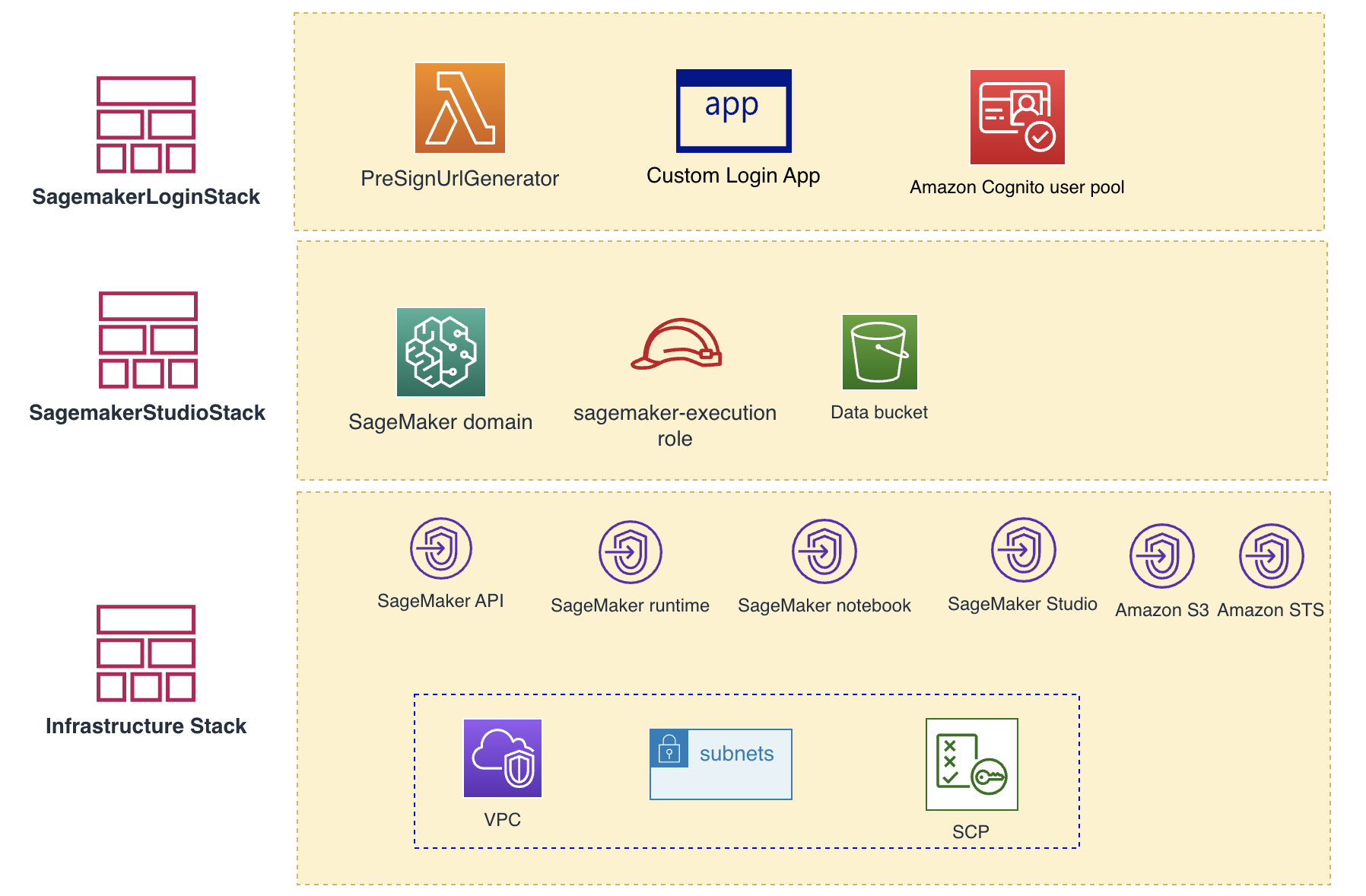

Zusätzlich zur SageMaker-Domäne gibt es eine angepasste AWS Identity and Access Management and (IAM)-Rolle (SageMaker-execution-role), Amazon Simple Storage-Service (Amazon S3) Bucket (Data-Bucket), Customer Managed Key (CMK) und andere AWS-Ressourcen werden während des Bereitstellungsprozesses von der AWS CDK-App bereitgestellt, wie in der folgenden Abbildung dargestellt. Die AD-Gruppe enthält Wissenschaftler, die Zugriff auf die SageMaker-Domäne ihres Teams benötigen. Der AD-Gruppenname entspricht dem Namen der SageMaker-Domäne und wird hauptsächlich während des Autorisierungsprozesses verwendet.

Die Client-Trennung wird auf der Ebene der SageMaker-Domänen mithilfe des IAM-Authentifizierungsmodus implementiert. Jeder Domäne ist eine domänenspezifische IAM-Rolle (SageMaker-Ausführungsrolle) zugeordnet, die dem Prinzip der geringsten Rechte folgt und vom Datenanalyseteam während des Anmeldevorgangs übernommen wird. Diese Rolle gewährt Datenwissenschaftlern im Team die Möglichkeit, verschiedene Aktivitäten durchzuführen, wie z. B. die Ausführung von Verarbeitungsjobs, Hyperparameter-Tuning-Jobs, Transformationsjobs und Experimenten sowie die Erstellung von Modellen. Diese ML-Aktivitäten werden im Namen des Benutzers von SageMaker mithilfe der IAM-Pass-Rollenberechtigung ausgeführt. Bestimmte Aktionen wie das Erstellen von S3-Buckets, das Ändern von IAM-Rollen, das Aktualisieren von SageMaker-Domänen und die Bereitstellung großer Instanzen sind jedoch aus Sicherheits-, Compliance- und Kostenkontrollgründen eingeschränkt. Die zugehörige IAM-Richtlinie stellt sicher, dass das Datenanalyseteam nur Zugriff auf den relevanten S3-Bucket und CMK für seine autorisierte Domäne hat, wie in der folgenden Abbildung dargestellt. Darüber hinaus ermöglicht die Rolle SageMaker-execution-role den Teammitgliedern, von SageMaker Studio aus Rollen in anderen Konten innerhalb der Deutschen Bahn-Organisation zu übernehmen, was ihnen Flexibilität beim Zugriff auf Ressourcen wie z Relationaler Amazon-Datenbankdienst (Amazon S3), andere S3-Buckets und Amazonas Athena. Die IAM-Richtlinie verwendet aws:RequestTag und aws:ResourceTag für eine differenzierte Zugriffskontrolle während SageMaker-Aktivitäten, wie z. B. Verarbeitungsaufträge, Schulungsaufträge und Erstellung von Modellen. Diese Tags helfen auch dabei, die damit verbundenen Kosten für die Domain zu verfolgen. Weitere Informationen finden Sie unter Aktionen, Ressourcen und Bedingungsschlüssel für Amazon SageMaker.

Der CMK verschlüsselt sowohl die in Amazon EFS gespeicherten Dateisysteminhalte der SageMaker-Domäne als auch die Inhalte des S3-Buckets (Daten-Bucket), der zum Speichern von Daten für SageMaker-Verarbeitungs- und Transformationsaufträge bereitgestellt wird. Darüber hinaus bieten ressourcenbasierte Richtlinien wie die Bucket-Richtlinie und die CMK-Richtlinie eine zusätzliche Sicherheitsebene, indem sie sowohl den Zugriff auf nur autorisierte KI-Teammitglieder als auch zulässige Aktionen auf diese Ressourcen beschränken.

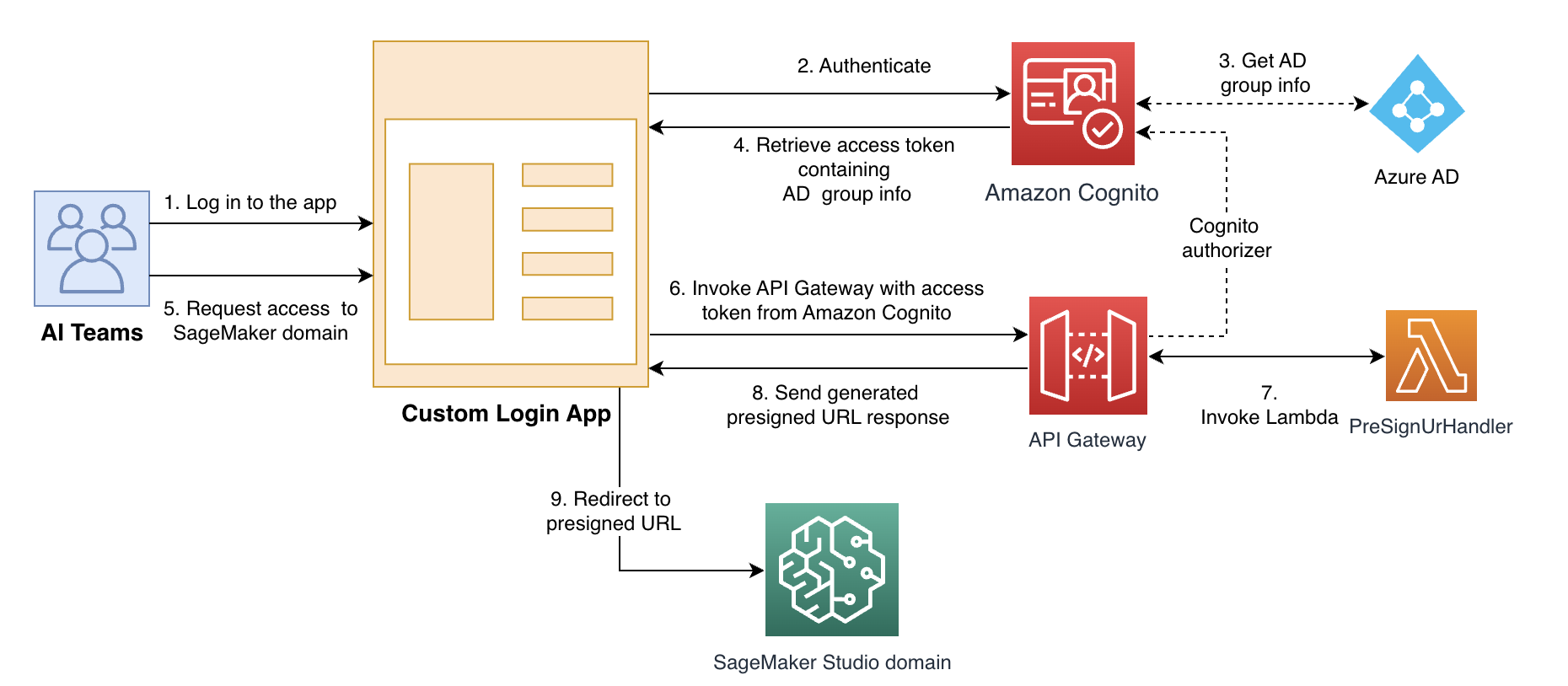

Das KI-Team hat es nicht AWS-Managementkonsole Zugriff auf das Konto des AI-Plattform-Teams. Um auf SageMaker Studio zuzugreifen, wie in der folgenden Abbildung dargestellt, verwenden die Datenwissenschaftler des Datenanalyseteams eine generierte vorsignierte URL, indem sie sich über eine authentifizieren Amazon Cognito basierte benutzerdefinierte Anmeldeanwendung. Nachdem sich der Benutzer bei dieser benutzerdefinierten Anwendung angemeldet hat, erhält er ein OAuth-Zugriffstoken, das Informationen wie den AD-Gruppennamen enthält. Nachdem er sich bei der benutzerdefinierten Anwendung angemeldet hat, fordert der Benutzer über die Benutzeroberfläche den Zugriff auf die SageMaker-Domäne an, indem er eine auslöst Amazon API-Gateway Aufruf zum Generieren einer vorsignierten URL. API Gateway ruft den PreSignUrlGenerator auf AWS Lambda Funktion und verwendet eine Autorisierung von Amazon Cognito um das OAuth-Zugriffstoken im Anforderungsheader zu validieren. Die PreSignUrlGenerator-Funktion validiert Benutzerzugriffsberechtigungen für die angeforderte SageMaker-Domäne, indem sie den AD-Namen im Zugriffstoken mit der angeforderten SageMaker-Domäne vergleicht. Nach erfolgreicher Autorisierung erstellt die PreSignUrlGenerator-Funktion bei der ersten Anmeldung ein SageMaker-Benutzerprofil und generiert eine vorsignierte URL-Antwort. Die benutzerdefinierte Anmeldeanwendung leitet die Benutzer dann zur angeforderten SageMaker-Domäne weiter.

AWS-CDK

Die Lösung bei der Deutschen Bahn nutzt AWS CDK als Infrastructure as Code (IaC), um eine SageMaker-Domäne zusammen mit Ressourcen wie S3-Buckets und einem CMK bereitzustellen. Die folgende Abbildung zeigt die Stacks und zugehörigen Ressourcen, die für die SageMaker-Bereitstellung verwendet werden. Der Infrastruktur-Stack kümmert sich um die Einrichtung wichtiger Ressourcen wie VPC, Subnetze und mehrerer SageMaker-Endpunkte. Die Ressourcen wie VPC, Subnetze und Service Control Policies (SCPs) werden von einem zentralen Cloud-Team über einen anderen Stack verwaltet (der Einfachheit halber wird er hier jedoch angezeigt). Der SageMakerStudioStack ist in erster Linie für die Bereitstellung einer SageMaker-Domäne, eines dedizierten Daten-Buckets, eines CMK und der dedizierten IAM-Rolle SageMaker-execution-role verantwortlich. Insbesondere wird jede SageMaker-Domäne über ihren individuellen SageMakerStudioStack bereitgestellt.

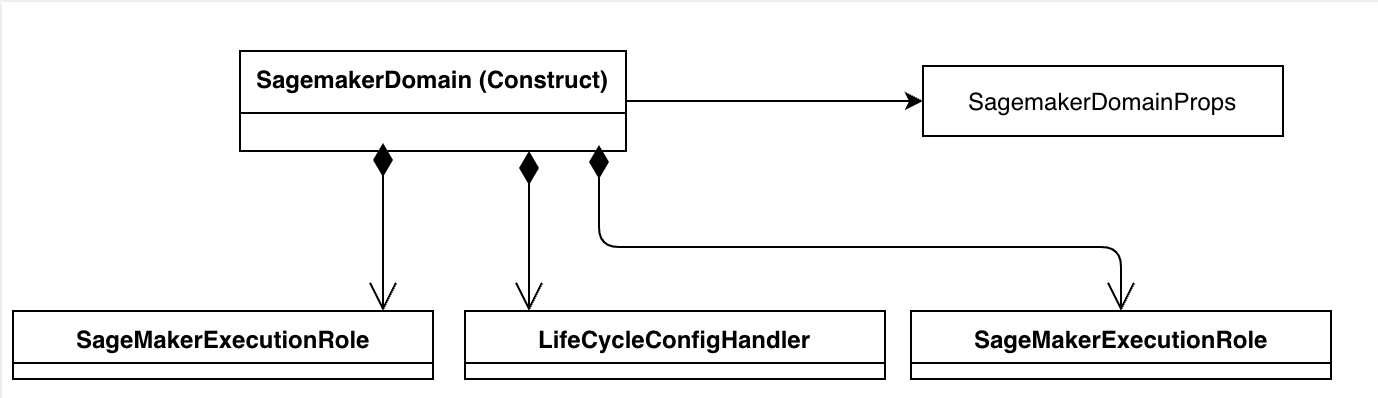

Die Lösung verwendet ein speziell entwickeltes L3-Konstrukt (SageMaker Studio-Domäne), wie in der folgenden Abbildung dargestellt, für die SageMaker-Domänenressource. SageMaker Studio verfügt über eine Lebenszykluskonfiguration Funktion, die bestimmte Initialisierungen während des Starts von JupyterLab- oder KernelGateway-Apps ermöglicht.

Die Deutsche Bahn verwendet die in der folgenden Abbildung dargestellte Lebenszykluskonfiguration, um inaktive Instanzen in der SageMaker-Domäne automatisch zu erkennen und herunterzufahren und so unnötige Kosten zu reduzieren. Aufgrund der eingeschränkten ausgehenden Konnektivität verwendet das Datenanalyseteam intern gehostete Bilder und Bibliotheken von Drittanbietern aus der internen Artefaktsammlung des Unternehmens. Das Lebenszyklus-Konfigurationsskript für KernelGateway konfiguriert Pip- und Conda-Paketmanager so, dass Downloads an den intern gehosteten Artefaktspeicherort umgeleitet werden. Zum jetzigen Zeitpunkt gibt es kein AWS CDK-Konstrukt für die Lebenszyklus-Konfigurationsressource; Daher verwenden sie eine benutzerdefinierte CDK-Ressource, um das LifeCycleConfig-Skript bereitzustellen und zu verwalten. Benutzerdefinierte Ressourcen im AWS CDK bieten die Möglichkeit, Ressourcen bereitzustellen und zu verwalten, die nicht direkt von unterstützt werden AWS CloudFormation oder AWS CDK-Konstrukte.

Installation

Die AWS CDK-Beispielanwendung zeigt, wie verschiedene Komponenten, einschließlich der SageMaker-Domäne, der Lebenszykluskonfiguration, Amazon Cognito und der IAM-Rolle mit den geringsten Berechtigungen, zusammenarbeiten. Innerhalb der Anwendung übernimmt die SagemakerStudioStack-Klasse die Bereitstellung einer SageMaker-Domäne, einer IAM-Rolle (sagemaker-execution-role), die Benutzer übernehmen, CMK, Lebenszykluskonfiguration, SageMaker-Benutzerprofil, S3-Bucket für die Datenverarbeitung und Amazon Cognito-Benutzergruppe. Die Demo-AWS CDK-Anwendung bietet einen prägnanten Überblick über Schlüsselkomponenten wie die SageMaker-Domäne, die Lebenszykluskonfiguration, die Authentifizierung über Amazon Cognito und die IAM-Rolle mit den geringsten Berechtigungen. Der SagemakerLoginStack hingegen ist für die Bereitstellung des Amazon Cognito-Benutzerpools, der Lambda-Funktion und des API-Gateways zur Generierung vorsignierter URLs verantwortlich. Der CognitoUserStack konzentriert sich hauptsächlich auf die Bereitstellung eines Benutzers innerhalb des Amazon Cognito-Benutzerpools.

Sie können die folgenden Befehle ausführen, um die Anwendung zu kompilieren, zu synthetisieren und bereitzustellen. Sie sollten Konto, Benutzer und Passwort im Beispielcode für Ihre Anwendung anpassen. Das Passwort sollte mindestens 8 Zeichen lang sein, mit Großbuchstaben und Zahlen. Der Benutzerparameter ist der SageMaker-Domänenbenutzer, der von Amazon Cognito authentifiziert wird.

- Laden Sie den Quellcode von herunter GitHub Repo.

- Bootstrap des AWS-Kontos. Passen Sie im folgenden Code die Kontonummer und die Region nach Bedarf an:

- Installieren Sie die Pakete und kompilieren Sie den Code:

- Synthetisieren Sie die AWS CDK-Anwendung:

- Stellen Sie die Anwendung mit allen Stacks im Konto und in der Region Ihrer Wahl bereit:

- Laden Sie die Postman-App herunter, um einen API-Aufruf durchzuführen.

Wenn Sie kein Postman-Konto haben, erstellen Sie ein kostenloses Konto mit Ihrer E-Mail-Adresse. Wenn Sie bereits ein Konto haben, melden Sie sich bei Ihrem Konto an.

- Auf dem Reichen Sie das Menü, wählen Sie Import und importieren Sie die JSON-Datei der Postman-Umgebung im GitHub-Repo enthalten.

- Auf dem Environments Suchen Sie auf der Registerkarte Postman nach der Umgebung namens SageMaker.

- Fügen Sie die folgenden Umgebungsvariablen hinzu, die Sie als Teil der Stack-Bereitstellungsausgabe sehen

SagemakerLoginStack:

Verwenden Sie die folgenden Parameter (rufen Sie die Werte während der CDK-Bereitstellung aus der Ausgabe ab):

-

- Domänenname – Der Domänennamenparameter, den Sie im cdk-Deploy übergeben haben, zum Beispiel team1

- Kunden ID – Die Amazon Cognito-Client-ID

- Kundengeheimnis – Das Geheimnis des Amazon Cognito-Clients.

- SageMaker-presigned-api – Die URL des von AWS CDK erstellten API-Gateways, das die vorsignierte URL generiert

- Cognito-Signin-Endpunkt – Die Endpunkt-URL der Amazon Cognito-Domäne, an der sich die Client-App (in diesem Fall Postman) authentifiziert, indem sie Anmeldeinformationen des Benutzers (Demo-Benutzer) bereitstellt.

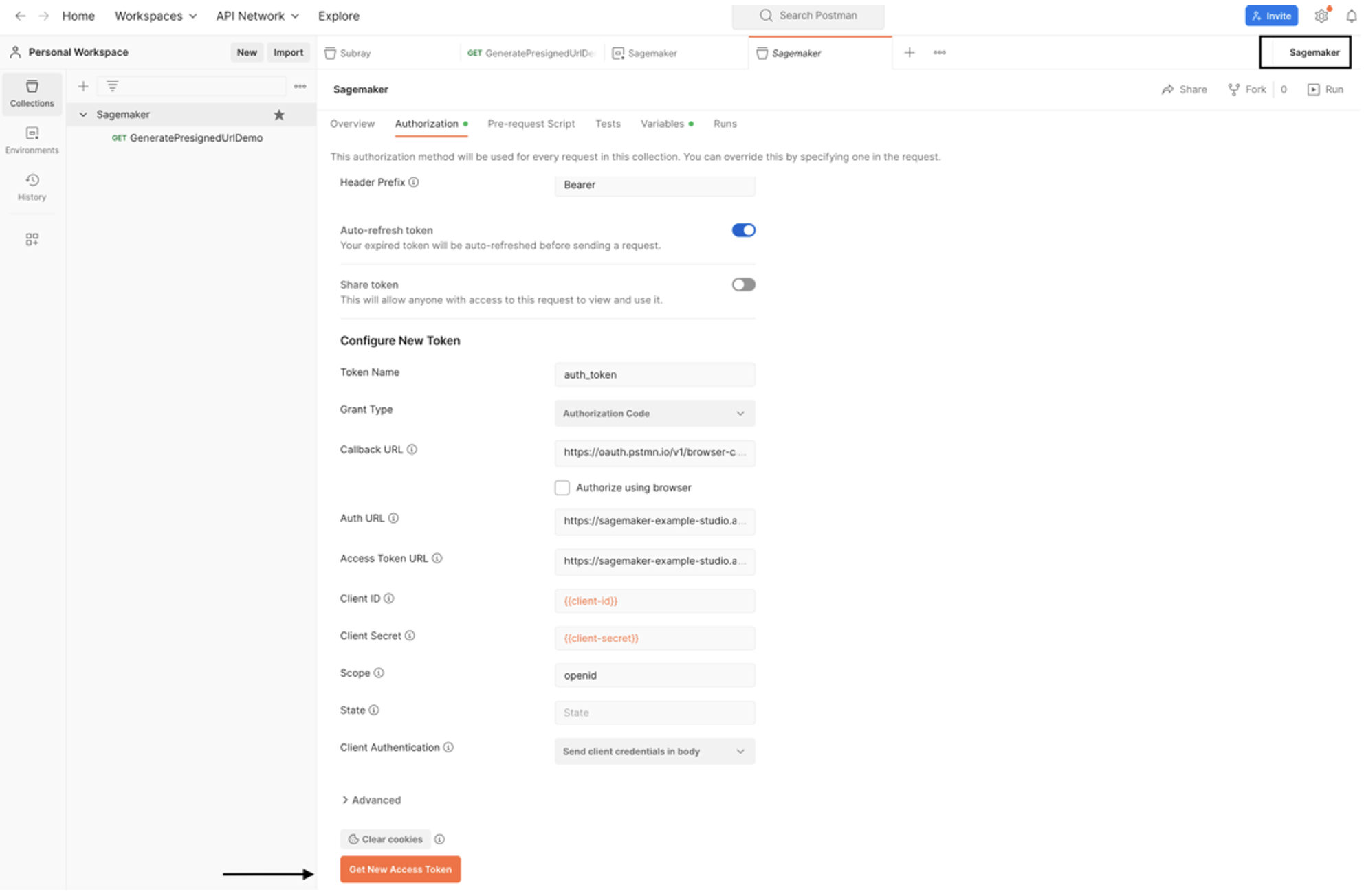

Der nächste Schritt besteht darin, ein OAuth2-Token zu generieren.

-

- Auf dem Genehmigung Wählen Sie auf der Registerkarte „SageMaker“ die SageMaker-Umgebung aus und klicken Sie auf „ Generieren Sie ein neues Zugriffstoken.

Alle Werte auf dieser Registerkarte sollten vorab ausgefüllt sein.

-

- Aktualisieren Sie die Umgebungsvariablen und wählen Sie Holen Sie sich ein neues Zugangstoken.

- Melden Sie sich im sich öffnenden Popup-Fenster mit dem zuvor verwendeten Benutzernamen (Demo-Benutzer) und Passwort bei Amazon Cognito an.

Bei erfolgreicher Authentifizierung wird ein neues Zugriffstoken generiert.

- Auswählen Verwenden Sie Token.

- Auswählen

GeneratePresignedUrlDemoin den Postman SageMaker-Sammlungen und wählen Sie Absenden. - Stellen Sie sicher, dass Sie in der Dropdown-Liste die richtige Umgebung (SageMaker) ausgewählt haben.

Dadurch wird ein REST-API-Aufruf an API Gateway durchgeführt und eine vorsignierte URL für den Zugriff auf die SageMaker-Domäne generiert. Sie können diese URL im Antworttext sehen.

- Kopieren Sie diese URL und geben Sie sie in das Browserfenster ein.

Eine neue SageMaker-Domäne wird mit Ihrem Benutzerprofil gestartet.

Diese Demoanwendung unterstützt SageMaker-Funktionen wie Trainingsjobs, Verarbeitungsjobs und Modellendpunkte. Beachten Sie, dass Funktionen wie Amazon SageMaker-Leinwand, SageMaker JumpStart und SageMaker Feature Store sind nicht aktiviert.

Aufräumen

Führen Sie die folgenden Schritte aus, um Ihre Ressourcen zu bereinigen:

- Wählen Sie in der SageMaker-Konsole im Navigationsbereich aus Domain, Benutzerprofil und Apps.

- Löschen Sie alle laufenden Apps (KernelGateway oder JupyterLab) aus dieser Lösung.

- Löschen Sie alle SageMaker-Benutzerprofile, die Sie während des Anmeldeschritts erstellt haben.

- Auf der Amazon EFS-Konsole: Löschen Sie das EFS-Dateisystem für diesen Beitrag erstellt.

- Führen Sie den folgenden Befehl aus, um die mit dem AWS CDK erstellten Ressourcen zu löschen:

Zusammenfassung

In dem Beitrag wurde hervorgehoben, wie die Deutsche Bahn SageMaker Studio effektiv zur Überarbeitung ihrer KI-Plattform eingesetzt hat, was zu einer skalierbaren, automatisierten und verwaltbaren Lösung zur Unterstützung ihrer vielfältigen Datenanalyseteams führte. Diese Architektur umfasst ein zentrales Plattformkonto, einen Self-Service-Domänenbestellprozess und die Infrastrukturbereitstellung mithilfe von AWS CDK. Der Bereitstellungsprozess umfasst eine CI/CD-Pipeline, die die reibungslose Bereitstellung von SageMaker-Domänen gewährleistet.

Insgesamt hat die durch SageMaker Studio herbeigeführte Transformation es der Deutschen Bahn ermöglicht, eine robuste Plattform für ihre KI-Initiativen aufzubauen, die über 100 Entwickler bedient und 20 SageMaker-Domänen in einem einzigen AWS-Konto verwaltet.

Abschließend gilt unser aufrichtiger Dank Nico Seegert (d-fine) und Philipp Vollmer (Deutsche Bahn), deren unschätzbare Beiträge maßgeblich zur Gestaltung dieser Architektur beigetragen haben.

Weitere Informationen finden Sie in den folgenden Ressourcen:

___________________________________________________________________________________________

Über die Autoren

Prasanna Tuladhar ist Cloud Infrastructure Architect bei AWS Professional Services in München, Deutschland. Er ist auf Cloud-Infrastruktur, Workload-Migration und DevOps auf der AWS-Plattform spezialisiert und unterstützt Kunden dabei, ihre Geschäftsziele zu erreichen. Außerhalb der Arbeit genießt er Joggen, Wandern und Zeit mit seiner Familie.

Prasanna Tuladhar ist Cloud Infrastructure Architect bei AWS Professional Services in München, Deutschland. Er ist auf Cloud-Infrastruktur, Workload-Migration und DevOps auf der AWS-Plattform spezialisiert und unterstützt Kunden dabei, ihre Geschäftsziele zu erreichen. Außerhalb der Arbeit genießt er Joggen, Wandern und Zeit mit seiner Familie.

Emmanuel Drosos ist Product Owner für die KI-Plattform bei DBSystel, einer Tochtergesellschaft der Deutschen Bahn (DB) Deutschland. Mit einer Leidenschaft für Innovation und Technologie leitet Emmanuel Initiativen, die darauf abzielen, die Leistungsfähigkeit der Cloud zu nutzen, um die KI-Plattform bei der DB (Deutsche Bahn) voranzutreiben. Die AI.Platform ist eine der konzernweiten Entwicklungsplattformen der DB. Es umfasst KI-Dienste und Werkzeuge zur Entwicklung von KI-Modellen (Machine Learning) und direkt nutzbare KI-Dienste. Einfach, integriert und skalierbar. Er arbeitet eng mit anderen DB-Kunden zusammen, um das volle Potenzial der KI-Plattform auszuschöpfen und ihnen zu ermöglichen, ihre Geschäftsziele effizient und effektiv zu erreichen. Außerhalb seiner beruflichen Aktivitäten reist Emmanuel gerne und ist ein begeisterter Natur- und Wanderliebhaber.

Emmanuel Drosos ist Product Owner für die KI-Plattform bei DBSystel, einer Tochtergesellschaft der Deutschen Bahn (DB) Deutschland. Mit einer Leidenschaft für Innovation und Technologie leitet Emmanuel Initiativen, die darauf abzielen, die Leistungsfähigkeit der Cloud zu nutzen, um die KI-Plattform bei der DB (Deutsche Bahn) voranzutreiben. Die AI.Platform ist eine der konzernweiten Entwicklungsplattformen der DB. Es umfasst KI-Dienste und Werkzeuge zur Entwicklung von KI-Modellen (Machine Learning) und direkt nutzbare KI-Dienste. Einfach, integriert und skalierbar. Er arbeitet eng mit anderen DB-Kunden zusammen, um das volle Potenzial der KI-Plattform auszuschöpfen und ihnen zu ermöglichen, ihre Geschäftsziele effizient und effektiv zu erreichen. Außerhalb seiner beruflichen Aktivitäten reist Emmanuel gerne und ist ein begeisterter Natur- und Wanderliebhaber.

Vishwanath Bhat ist DevOps-Architekt bei AWS Professional Services mit Sitz in Deutschland. Er hilft Kunden dabei, den vollen Nutzen aus der Cloud zu ziehen und ihre Geschäftsziele mit der AWS Cloud zu erreichen. Wenn er nicht arbeitet, geht er gerne in Alpenseen schwimmen, wandern, lesen oder Fußball spielen.

Vishwanath Bhat ist DevOps-Architekt bei AWS Professional Services mit Sitz in Deutschland. Er hilft Kunden dabei, den vollen Nutzen aus der Cloud zu ziehen und ihre Geschäftsziele mit der AWS Cloud zu erreichen. Wenn er nicht arbeitet, geht er gerne in Alpenseen schwimmen, wandern, lesen oder Fußball spielen.

Kumudhan Cherarajan ist DevOps-Berater bei AWS Professional Services mit Sitz in der Schweiz. Es ist ihm eine Leidenschaft, Kunden bei der Einführung von Prozessen und Services zu unterstützen, die ihre Effizienz auf dem Weg in die Cloud steigern. Wenn er nicht arbeitet, spielt er gerne Cricket und Musik.

Kumudhan Cherarajan ist DevOps-Berater bei AWS Professional Services mit Sitz in der Schweiz. Es ist ihm eine Leidenschaft, Kunden bei der Einführung von Prozessen und Services zu unterstützen, die ihre Effizienz auf dem Weg in die Cloud steigern. Wenn er nicht arbeitet, spielt er gerne Cricket und Musik.

- SEO-gestützte Content- und PR-Distribution. Holen Sie sich noch heute Verstärkung.

- PlatoData.Network Vertikale generative KI. Motiviere dich selbst. Hier zugreifen.

- PlatoAiStream. Web3-Intelligenz. Wissen verstärkt. Hier zugreifen.

- PlatoESG. Kohlenstoff, CleanTech, Energie, Umwelt, Solar, Abfallwirtschaft. Hier zugreifen.

- PlatoHealth. Informationen zu Biotechnologie und klinischen Studien. Hier zugreifen.

- Quelle: https://aws.amazon.com/blogs/machine-learning/supercharge-your-ai-team-with-amazon-sagemaker-studio-a-comprehensive-view-of-deutsche-bahns-ai-platform-transformation/