この投稿は、Alida の Sherwin Chu との共同執筆です。

アリダ 世界最大のブランドが、より良い顧客体験と製品革新を促進するフィードバックを収集するための、非常に熱心な研究コミュニティを構築するのを支援します。

Alida の顧客は、1 回のアンケートに対して何万もの熱心な回答を受け取っているため、Alida チームは、顧客に大規模なサービスを提供するために機械学習 (ML) を活用することを選択しました。しかし、従来の自然言語処理 (NLP) モデルを使用した場合、これらのソリューションでは自由形式の調査回答に見られる微妙なフィードバックを完全に理解するのが難しいことがわかりました。多くの場合、モデルは表面レベルのトピックや感情のみを捉えており、より正確で意味のある洞察を可能にする重要なコンテキストを見逃していました。

この投稿では、Anthropic の Claude Instant がどのようにモデルを構築するかについて学びます。 アマゾンの岩盤 これにより、Alida チームは、複雑なアンケート回答内のトピックとセンチメントをより正確に判断する、スケーラブルなサービスを迅速に構築できるようになりました。新しいサービスは、数百のノイズの多い NLP キーワードではなく、数十の主要なトピックを密にクラスタ化することで、トピック アサーションの 4 ~ 6 倍の向上を達成しました。

Amazon Bedrock は、AI21 Labs、Anthropic、Cohere、Meta、Stability AI、Amazon などの大手 AI 企業の高性能基盤モデル (FM) を単一の API 経由で提供するフルマネージド サービスです。セキュリティ、プライバシー、責任ある AI を備えた生成 AI アプリケーションを構築するために必要な一連の機能。

Amazon Bedrock を使用することで、Alida は他の機械学習 (ML) プロバイダーやベンダーを使用した場合よりも早くサービスを市場に投入することができました。

課題

多肢選択式の質問と自由回答式の質問を組み合わせた調査により、市場調査員は定量的データ ポイントと定性的データ ポイントの両方を取得することで、より全体的な視点を得ることができます。

多肢選択式の質問は大規模な分析が容易ですが、ニュアンスや深みが欠けています。応答オプションを設定すると、参加者の応答が偏ったり刺激されたりする可能性もあります。

自由回答型のアンケート質問により、回答者はコンテキストや予期せぬフィードバックを提供できます。これらの質的データ ポイントは、多肢選択式の質問だけで把握できる以上に、研究者の理解を深めます。自由形式のテキストの課題は、従来の NLP では完全に理解することが難しい、複雑で微妙な答えが得られる可能性があることです。例えば:

「私は最近、人生の困難をいくつか経験し、本当に落ち込んで失望しました。中に入るとスタッフの方はいつもとても親切に対応してくださいました。大変な時期を乗り越えるのに役立ちました!」

従来の NLP 手法では、トピックを「困難」、「失望」、「親切なスタッフ」、「困難な時期の乗り越え」として特定します。回答者の現在の全体的な否定的な人生経験と、特定の肯定的な店舗での経験を区別することはできません。

Alida の既存のソリューションは、大量の自由回答を自動的に処理しますが、顧客がより良い文脈の理解と高度なトピック推論を獲得できるようにしたいと考えていました。

アマゾンの岩盤

LLM の導入前、Alida が既存の単一モデル ソリューションを改善するための今後の方法は、業界の専門家と緊密に連携し、Alida の顧客が事業を展開している各業界向けに特別に新しいモデルを開発、トレーニング、改良することでした。これは時間もコストもかかる取り組みでした。

LLM を非常に強力にする画期的な点の 1 つは、アテンション メカニズムの使用です。 LLM は、特定のプロンプト内の単語間の関係を分析するセルフアテンション メカニズムを使用します。これにより、LLM は前の例のトピックと感情をより適切に処理できるようになり、課題に対処するために使用できるエキサイティングな新しいテクノロジが提供されます。

Amazon Bedrock を使用すると、チームや個人は、インフラストラクチャのプロビジョニングや ML フレームワークのセットアップと構成について心配することなく、すぐに基盤モデルの使用を開始できます。次の手順で開始できます。

- ユーザーまたはロールに Amazon Bedrock リソースを作成または変更する権限があることを確認してください。詳細については、を参照してください。 Amazon Bedrock の ID ベースのポリシーの例

- にログインします アマゾンの岩盤 コンソール。

- ソフトウェア設定ページで、下図のように モデルアクセス ページで EULA を確認し、アカウントで必要な FM を有効にします。

- 次の方法で FM との対話を開始します。

Alida の経営幹部チームは、Amazon Bedrock がチームの新しい生成 AI を活用したソリューションをより迅速に市場に投入できることを認識していたので、Amazon Bedrock の早期採用に熱心でした。

Alida のエンジニアリング担当シニア ディレクターで、トピックとセンチメント分析サービスの構築を担当するチームを率いるヴィンシー ウィリアム氏は次のように述べています。

「LLM は定性分析に大きな飛躍をもたらし、人間には(不可能な規模で)できることを実現します。 Amazon Bedrock はゲームチェンジャーであり、複雑なことをせずに LLM を活用できるようになります。」

エンジニアリングチームは、Amazon Bedrock をすぐに使い始めることができることを体験しました。彼らは、モデルを実行するためのリソースの適切なサイジング、プロビジョニング、デプロイ、構成に時間を費やす代わりに、さまざまな基盤モデルから選択して、迅速なエンジニアリングに集中し始めることができます。

ソリューションの概要

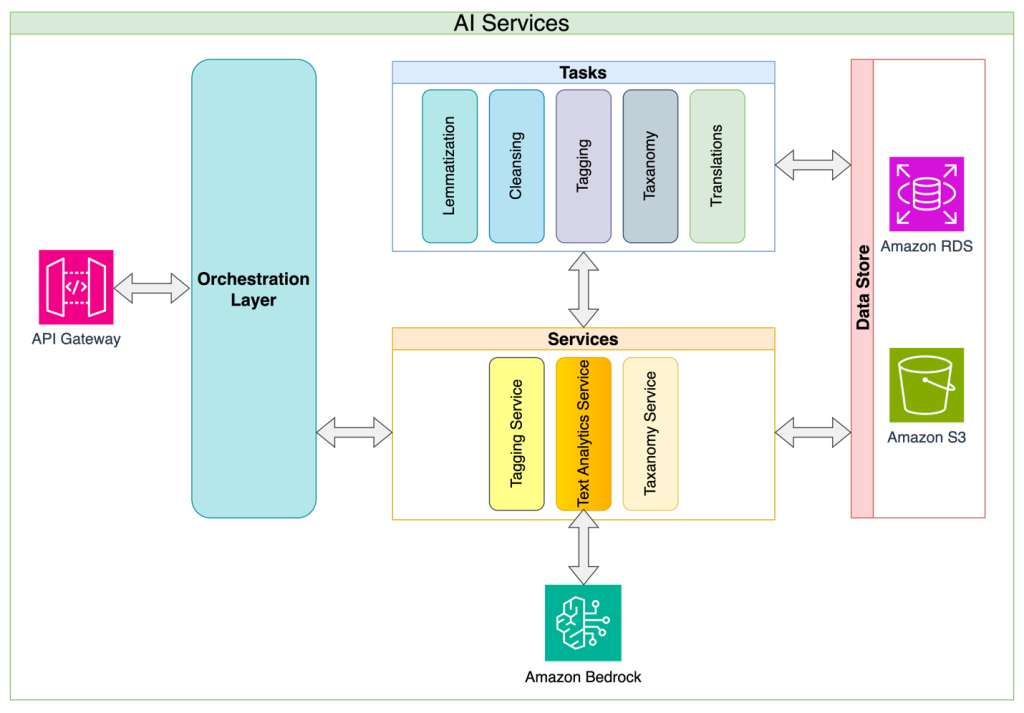

Alida のチーフ アーキテクトである Sherwin Chu 氏は、Alida のマイクロサービス アーキテクチャのアプローチを共有しました。 Alida は、最初のアプリケーションとしてアンケート回答分析を使用して、トピックとセンチメントの分類をサービスとして構築しました。このアプローチにより、プロンプト管理の複雑さ、トークン制限、リクエストの制約、再試行などの一般的な LLM 実装の課題が抽象化され、このソリューションにより、使用するアプリケーションがシンプルで安定した API を使用できるようになります。この抽象化レイヤーのアプローチにより、サービス所有者は内部実装の詳細を継続的に改善し、API を破壊する変更を最小限に抑えることもできます。最後に、サービス アプローチにより、組織内の AI ガバナンスが成熟するにつれて進化するデータ ガバナンスとセキュリティ ポリシーを 1 か所で実装できるようになります。

次の図は、ソリューションのアーキテクチャとフローを示しています。

Alida はさまざまなプロバイダーの LLM を評価し、Anthropic の Claude Instant がコストとパフォーマンスの適切なバランスであることを発見しました。 Chu 氏は、プロンプト エンジニアリング チームと緊密に連携して、単一のモノリス プロンプト アプローチではなく、プロンプト チェーン戦略を実装することを提唱しました。

プロンプト チェーンを使用すると、次のことが可能になります。

- 目標をより小さな論理的なステップに分割する

- 各ステップのプロンプトを作成する

- LLM にプロンプトを順番に入力します。

これにより追加の検査ポイントが作成され、次のような利点があります。

- 入力プロンプトに加えた変更を体系的に評価するのは簡単です

- 各ステップでの精度とパフォーマンスのより詳細な追跡と監視を実装できます。

この戦略での主な考慮事項には、LLM に対して行われるリクエストの数が増加し、その結果、目標を完了するまでにかかる全体の時間が増加することが含まれます。 Alida のユースケースでは、これらの影響を相殺するために、LLM への単一のプロンプトで自由回答のコレクションをバッチ処理することを選択しました。

NLP 対 LLM

Alida の既存の NLP ソリューションは、クラスタリング アルゴリズムと統計的分類に依存して、自由形式の調査回答を分析します。コーヒー ショップのモバイル アプリのサンプル フィードバックに適用すると、単語のパターンに基づいてトピックが抽出されましたが、真の理解には欠けていました。次の表には、NLP 応答と LLM 応答を比較する例がいくつか含まれています。

| 調査回答 | 既存の従来型 NLP | クロード・インスタントによる Amazon Bedrock | |

| ご用件 | ご用件 | 感情 | |

| 私はほとんどもっぱら便利なアプリ BC を通じて飲み物を注文していますが、スーパーカスタマイズされた飲み物を注文することはそれほど恥ずかしくありません(笑)。そして報酬を得るのが大好きです! | ['アプリBCの利便性'、'ドリンク'、'ご褒美'] | モバイル注文の利便性 | 正の |

| このアプリはかなりうまく機能しますが、唯一の不満は、ギフトカードに好きな金額を追加できないことです。なぜわざわざ詰め替えに10ドルしなければならないのでしょうか? | ['苦情'、'アプリ'、'ギフトカード'、'ナンバーマネー'] | モバイル注文の履行速度 | 負 |

結果の例は、既存のソリューションが関連キーワードを抽出できたものの、より一般化されたトピック グループの割り当てを実現できなかったことを示しています。

対照的に、Amazon Bedrock と Anthropic Claude Instant を使用すると、コンテキスト内トレーニングを備えた LLM は、事前定義されたトピックに応答を割り当て、センチメントを割り当てることができます。

この特定のユースケースでは、Alida の顧客により良い回答を提供できるだけでなく、従来の NLP 手法ではなく LLM を使用したソリューションを追求することで、適切なモデルのトレーニングと維持にかかる膨大な時間と労力を節約できました。次の表では、従来の NLP モデルのトレーニングと LLM のコンテキスト内トレーニングを比較しています。

| . | データ要件 | トレーニングプロセス | モデルの適応性 |

| 従来の NLP モデルのトレーニング | 人間がラベルを付けた数千の例 |

自動化された特徴量エンジニアリングと手動の特徴量エンジニアリングの組み合わせ。 反復的なトレーニングと評価サイクル。 |

モデルを再トレーニングする必要があるため、ターンアラウンドが遅くなる |

| LLM のコンテキストに沿ったトレーニング | いくつかの例 |

プロンプト内でその場でトレーニングされます。 コンテキスト ウィンドウのサイズによって制限されます。 |

プロンプトを変更することで反復を高速化します。 コンテキスト ウィンドウのサイズにより保持期間が制限されます。 |

まとめ

Alida が Amazon Bedrock で Anthropic の Claude Instant モデルを使用したことは、自由形式の調査回答を分析するための LLM の強力な機能を示しています。 Alida は、NLP を利用したサービスと比較して、トピック分析において 4 ~ 6 倍正確な優れたサービスを構築することができました。さらに、LLM にインコンテキスト プロンプト エンジニアリングを使用すると、従来の NLP モデルをトレーニングするために人間がラベル付けした何千ものデータ ポイントを管理する必要がなくなったため、開発時間が大幅に短縮されました。これにより、最終的に、Alida は顧客により豊富な洞察をより早く提供できるようになります。

Amazon Bedrock を使用して独自の基盤モデルのイノベーションの構築を開始する準備ができている場合は、このリンクをチェックしてください。 Amazon Bedrock をセットアップする。他の興味深い Amazon Bedrock アプリケーションについて知りたい場合は、以下を参照してください。 Amazon Bedrock 固有のセクション AWS 機械学習ブログの。

著者について

キンマン・ラム AWS の ISV/DNB ソリューション アーキテクトです。彼は、スマートフォン、地理位置情報、IoT、オープンソース ソフトウェアの分野でテクノロジー企業の構築と成長に 17 年の経験があります。 AWS では、その経験を活かして、企業が成長するビジネスの増大する需要に対応するための堅牢なインフラストラクチャを構築し、新しい製品やサービスを発売し、新しい市場に参入し、顧客を満足させるのを支援しています。

キンマン・ラム AWS の ISV/DNB ソリューション アーキテクトです。彼は、スマートフォン、地理位置情報、IoT、オープンソース ソフトウェアの分野でテクノロジー企業の構築と成長に 17 年の経験があります。 AWS では、その経験を活かして、企業が成長するビジネスの増大する需要に対応するための堅牢なインフラストラクチャを構築し、新しい製品やサービスを発売し、新しい市場に参入し、顧客を満足させるのを支援しています。

シャーウィン・チュー Alida のチーフ アーキテクトであり、アーキテクチャの方向性、テクノロジーの選択、複雑な問題解決に関して製品チームを支援しています。彼は、さまざまな業界の SaaS 分野で 20 年以上の経験を持つ、経験豊富なソフトウェア エンジニア、アーキテクト、リーダーです。彼は、AWS と GCP 上で多数の B2B および B2C システムを構築、管理してきました。

シャーウィン・チュー Alida のチーフ アーキテクトであり、アーキテクチャの方向性、テクノロジーの選択、複雑な問題解決に関して製品チームを支援しています。彼は、さまざまな業界の SaaS 分野で 20 年以上の経験を持つ、経験豊富なソフトウェア エンジニア、アーキテクト、リーダーです。彼は、AWS と GCP 上で多数の B2B および B2C システムを構築、管理してきました。

マークロイ AWS のプリンシパル機械学習アーキテクトとして、顧客の AI/ML および生成 AI ソリューションの設計と構築を支援しています。 2023 年初頭以来、彼は、AWS の主力のビルダー向け生成 AI 製品である Amazon Bedrock の立ち上げに向けたソリューション アーキテクチャの取り組みを主導してきました。 Mark の仕事は幅広いユースケースをカバーしており、主な関心は生成 AI、エージェント、企業全体にわたる ML のスケーリングです。彼は、保険、金融サービス、メディアとエンターテイメント、ヘルスケア、公益事業、製造の企業を支援してきました。 AWS に入社する前、Mark は 25 年以上にわたってアーキテクト、開発者、テクノロジーのリーダーとして活躍し、その中には金融サービスでの 19 年間の勤務も含まれます。 Mark は、ML スペシャリティ認定を含む XNUMX つの AWS 認定を取得しています。

マークロイ AWS のプリンシパル機械学習アーキテクトとして、顧客の AI/ML および生成 AI ソリューションの設計と構築を支援しています。 2023 年初頭以来、彼は、AWS の主力のビルダー向け生成 AI 製品である Amazon Bedrock の立ち上げに向けたソリューション アーキテクチャの取り組みを主導してきました。 Mark の仕事は幅広いユースケースをカバーしており、主な関心は生成 AI、エージェント、企業全体にわたる ML のスケーリングです。彼は、保険、金融サービス、メディアとエンターテイメント、ヘルスケア、公益事業、製造の企業を支援してきました。 AWS に入社する前、Mark は 25 年以上にわたってアーキテクト、開発者、テクノロジーのリーダーとして活躍し、その中には金融サービスでの 19 年間の勤務も含まれます。 Mark は、ML スペシャリティ認定を含む XNUMX つの AWS 認定を取得しています。

- SEO を活用したコンテンツと PR 配信。 今日増幅されます。

- PlatoData.Network 垂直生成 Ai。 自分自身に力を与えましょう。 こちらからアクセスしてください。

- プラトアイストリーム。 Web3 インテリジェンス。 知識増幅。 こちらからアクセスしてください。

- プラトンESG。 カーボン、 クリーンテック、 エネルギー、 環境、 太陽、 廃棄物管理。 こちらからアクセスしてください。

- プラトンヘルス。 バイオテクノロジーと臨床試験のインテリジェンス。 こちらからアクセスしてください。

- 情報源: https://aws.amazon.com/blogs/machine-learning/alida-gains-deeper-understanding-of-customer-feedback-with-amazon-bedrock/