Để chống lại sự lây lan của tài liệu lạm dụng tình dục trẻ em (CSAM), một liên minh gồm các nhà phát triển AI hàng đầu—bao gồm Google, Meta và OpenAI—đã cam kết thực thi các biện pháp bảo vệ xung quanh công nghệ mới nổi.

Nhóm được tập hợp bởi hai tổ chức phi lợi nhuận: nhóm công nghệ dành cho trẻ em Thorn và All Tech is Human có trụ sở tại New York. Trước đây được gọi là Quỹ DNA, Thorn được thành lập vào năm 2012 bởi các diễn viên Demi Moore và Ashton Kutcher.

Cam kết tập thể đã được công bố hôm thứ ba cùng với một cam kết mới Báo cáo gai ủng hộ nguyên tắc “An toàn theo thiết kế” trong quá trình phát triển AI tổng quát nhằm ngăn chặn việc tạo ra tài liệu lạm dụng tình dục trẻ em (CSAM) trong toàn bộ vòng đời của mô hình AI.

“Chúng tôi kêu gọi tất cả các công ty đang phát triển, triển khai, duy trì và sử dụng các sản phẩm và công nghệ AI tiên tiến cam kết áp dụng các nguyên tắc An toàn theo Thiết kế này và thể hiện sự cống hiến của họ trong việc ngăn chặn việc tạo ra và lan truyền CSAM, AIG-CSAM cũng như các hành vi xâm hại tình dục trẻ em khác.” lạm dụng và bóc lột” gai cho biết trong một tuyên bố.

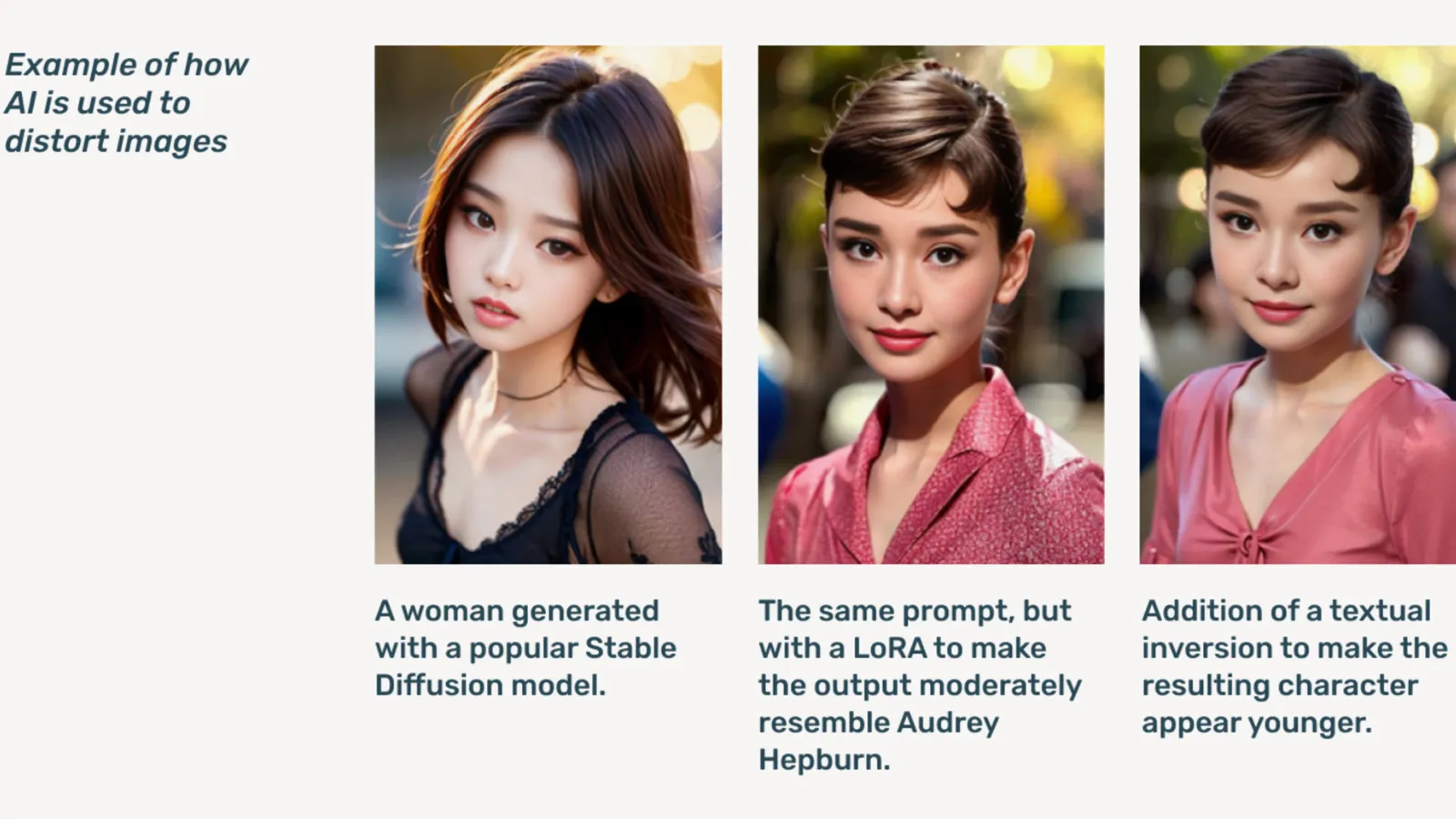

AIG-CSAM là CSAM do AI tạo ra mà báo cáo minh họa có thể tương đối dễ tạo.

Gai phát triển công cụ và các nguồn lực tập trung vào việc bảo vệ trẻ em khỏi bị lạm dụng và bóc lột tình dục. Trong báo cáo tác động năm 2022, tổ chức này cho biết hơn 824,466 tệp chứa tài liệu lạm dụng trẻ em đã được tìm thấy. Năm ngoái, Thorn đã báo cáo rằng chỉ riêng ở Mỹ đã có hơn 104 triệu tệp nghi ngờ chứa nội dung CSAM.

Vốn đã là một vấn đề trực tuyến, nội dung khiêu dâm trẻ em deepfake đã tăng vọt sau khi các mô hình AI tổng quát được phổ biến rộng rãi, với các mô hình AI độc lập không cần dịch vụ đám mây được lưu hành trên đó. mạng tối diễn đàn.

Thorn cho biết AI sáng tạo giúp việc tạo khối lượng nội dung trở nên dễ dàng hơn bao giờ hết. Một kẻ săn mồi trẻ em có khả năng tạo ra khối lượng lớn tài liệu lạm dụng tình dục trẻ em (CSAM), bao gồm cả việc điều chỉnh các hình ảnh và video gốc thành nội dung mới.

Thorn lưu ý: “Một dòng AIG-CSAM gây ra rủi ro đáng kể cho hệ sinh thái an toàn cho trẻ em vốn đã bị đánh thuế, làm trầm trọng thêm những thách thức mà cơ quan thực thi pháp luật phải đối mặt trong việc xác định và giải cứu các nạn nhân bị lạm dụng hiện tại cũng như mở rộng quy mô nạn nhân mới của nhiều trẻ em hơn”.

Báo cáo của Thorn nêu ra một loạt nguyên tắc mà các nhà phát triển AI sáng tạo sẽ tuân theo để ngăn chặn công nghệ của họ bị sử dụng để tạo ra nội dung khiêu dâm trẻ em, bao gồm cả việc đào tạo nguồn cung ứng có trách nhiệm bộ dữ liệu, kết hợp các vòng phản hồi và chiến lược kiểm tra sức chịu đựng, sử dụng lịch sử nội dung hoặc “nguồn gốc” có lưu ý đến việc sử dụng sai mục đích đối nghịch và lưu trữ các mô hình AI tương ứng của chúng một cách có trách nhiệm.

Những người khác ký vào cam kết bao gồm microsoft, nhân loại, trí tuệ nhân tạo, đàn bà gan dạ, AI ổn định, AI dân sựvà Siêu hình học, mỗi người đưa ra các tuyên bố riêng biệt vào ngày hôm nay.

“Một phần đặc tính của chúng tôi tại Siêu hình học là phát triển có trách nhiệm trong thế giới AI, đúng vậy, đó là trao quyền, nhưng đó là về trách nhiệm,” Giám đốc tiếp thị của Siêu hình học, Alejandro Lopez nói. Giải mã. “Chúng tôi nhanh chóng nhận ra rằng để bắt đầu và phát triển điều đó có nghĩa là bảo vệ những người dễ bị tổn thương nhất trong xã hội của chúng ta, đó là trẻ em, và thật không may, kết cục đen tối nhất của công nghệ này, vốn đang được sử dụng cho tài liệu lạm dụng tình dục trẻ em dưới các hình thức nội dung khiêu dâm giả mạo sâu sắc. , điều đó đã xảy ra.”

Ra mắt vào 2021, Siêu hình học đã trở nên nổi tiếng vào năm ngoái sau khi có thông tin tiết lộ rằng một số ngôi sao Hollywood, bao gồm Tom Hanks, Octavia Spencer và Anne Hathaway, đang sử dụng công nghệ Metaphysical Pro để số hóa các đặc điểm giống của họ nhằm duy trì quyền sở hữu các đặc điểm cần thiết để đào tạo một mô hình AI .

OpenAI từ chối bình luận thêm về sáng kiến này, thay vào đó cung cấp Giải mã một tuyên bố công khai từ người đứng đầu bộ phận an toàn trẻ em Chelsea Carlson.

Carlson cho biết: “Chúng tôi quan tâm sâu sắc đến sự an toàn và việc sử dụng có trách nhiệm các công cụ của mình, đó là lý do tại sao chúng tôi đã xây dựng các rào chắn và biện pháp an toàn mạnh mẽ cho ChatGPT và DALL-E”. tuyên bố. “Chúng tôi cam kết hợp tác cùng Thorn, All Tech is Human và cộng đồng công nghệ rộng lớn hơn để duy trì các nguyên tắc An toàn theo Thiết kế và tiếp tục công việc của chúng tôi trong việc giảm thiểu những tác hại tiềm ẩn đối với trẻ em.”

Giải mã đã liên hệ với các thành viên khác của Liên minh nhưng không nhận được phản hồi ngay lập tức.

“Tại Meta, chúng tôi đã dành hơn một thập kỷ nỗ lực để đảm bảo an toàn cho mọi người khi trực tuyến. Trong thời gian đó, chúng tôi đã phát triển nhiều công cụ và tính năng giúp ngăn ngừa và chống lại tác hại tiềm ẩn—và khi những kẻ săn mồi đã thích nghi để cố gắng trốn tránh sự bảo vệ của chúng tôi, chúng tôi cũng tiếp tục thích nghi.” Siêu dữ liệu cho biết trong một tuyên bố chuẩn bị.

“Trên các sản phẩm của mình, chúng tôi chủ động phát hiện và loại bỏ tài liệu CSAE thông qua sự kết hợp giữa công nghệ đối sánh hàm băm, bộ phân loại trí tuệ nhân tạo và đánh giá của con người,” GooglePhó chủ tịch phụ trách các giải pháp tin cậy và an toàn của Susan Jasper đã viết trong một bài đăng. “Các chính sách và biện pháp bảo vệ của chúng tôi được thiết kế để phát hiện tất cả các loại CSAE, bao gồm cả CSAM do AI tạo ra. Khi xác định được nội dung mang tính bóc lột, chúng tôi sẽ xóa nội dung đó và thực hiện hành động thích hợp, có thể bao gồm việc báo cáo nội dung đó cho NCMEC.”

Vào tháng 10, nhóm giám sát của Vương quốc Anh, Tổ chức Internet Watch, cảnh báo rằng tài liệu lạm dụng trẻ em do AI tạo ra có thể 'áp đảo' internet.

Sửa bởi Ryan Ozawa.

Luôn cập nhật tin tức về tiền điện tử, cập nhật hàng ngày trong hộp thư đến của bạn.

- Phân phối nội dung và PR được hỗ trợ bởi SEO. Được khuếch đại ngay hôm nay.

- PlatoData.Network Vertical Generative Ai. Trao quyền cho chính mình. Truy cập Tại đây.

- PlatoAiStream. Thông minh Web3. Kiến thức khuếch đại. Truy cập Tại đây.

- Trung tâmESG. Than đá, công nghệ sạch, Năng lượng, Môi trường Hệ mặt trời, Quản lý chất thải. Truy cập Tại đây.

- PlatoSức khỏe. Tình báo thử nghiệm lâm sàng và công nghệ sinh học. Truy cập Tại đây.

- nguồn: https://decrypt.co/227731/aig-csam-google-meta-openai-fight-ai-child-sexual-abuse-material