Hạt giống của sự thay đổi mô hình máy học (ML) đã tồn tại trong nhiều thập kỷ, nhưng với khả năng tính toán có thể mở rộng sẵn có, sự phổ biến rộng rãi của dữ liệu và sự tiến bộ nhanh chóng của công nghệ ML, khách hàng trong các ngành đang chuyển đổi doanh nghiệp của họ. Mới gần đây, các ứng dụng AI sáng tạo như ChatGPT đã thu hút được sự chú ý và trí tưởng tượng rộng rãi. Chúng tôi thực sự đang ở một điểm uốn thú vị trong việc áp dụng rộng rãi ML và chúng tôi tin rằng hầu hết các ứng dụng và trải nghiệm của khách hàng sẽ được phát minh lại bằng AI tổng quát.

AI và ML đã trở thành trọng tâm của Amazon trong hơn 20 năm và nhiều khả năng mà khách hàng sử dụng với Amazon được thúc đẩy bởi ML. Công cụ đề xuất thương mại điện tử của chúng tôi được thúc đẩy bởi ML; các đường dẫn tối ưu hóa các tuyến lấy hàng bằng robot trong các trung tâm thực hiện của chúng tôi được điều khiển bởi ML; và chuỗi cung ứng, dự báo và lập kế hoạch năng lực của chúng tôi đều được ML cung cấp thông tin. Prime Air (máy bay không người lái của chúng tôi) và công nghệ thị giác máy tính trong Amazon Go (trải nghiệm bán lẻ thực của chúng tôi cho phép người tiêu dùng chọn các mặt hàng trên kệ và rời khỏi cửa hàng mà không cần phải thanh toán chính thức) sử dụng học sâu. Alexa, được cung cấp bởi hơn 30 hệ thống ML khác nhau, giúp khách hàng quản lý nhà thông minh, mua sắm, nhận thông tin và giải trí, v.v. hàng tỷ lần mỗi tuần. Chúng tôi có hàng nghìn kỹ sư tại Amazon cam kết với ML và đó là một phần quan trọng trong di sản, đặc tính hiện tại và tương lai của chúng tôi.

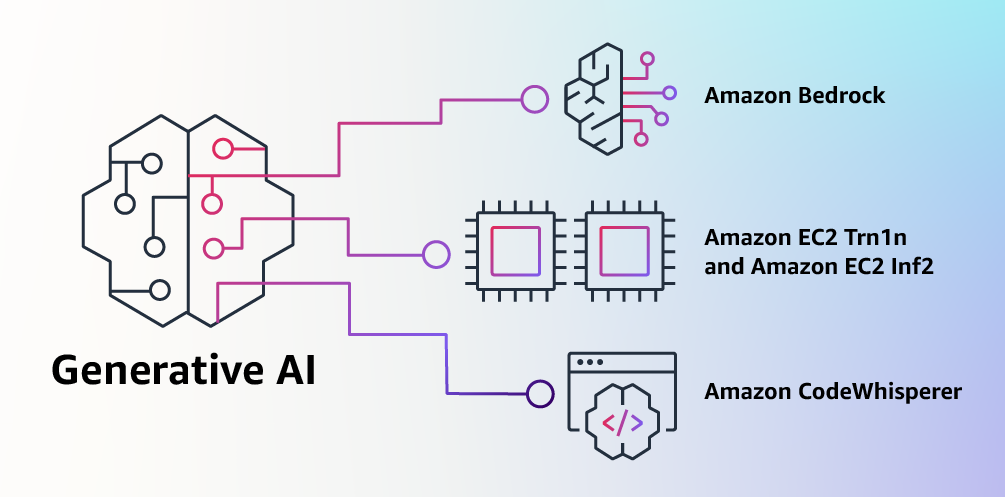

Tại AWS, chúng tôi đã đóng một vai trò quan trọng trong việc dân chủ hóa ML và giúp bất kỳ ai muốn sử dụng đều có thể tiếp cận được công nghệ này, bao gồm hơn 100,000 khách hàng thuộc mọi quy mô và ngành. AWS có danh mục dịch vụ AI và ML rộng nhất và sâu nhất ở cả ba lớp của ngăn xếp. Chúng tôi đã đầu tư và đổi mới để cung cấp cơ sở hạ tầng hiệu quả nhất, có thể mở rộng để đào tạo và suy luận ML hiệu quả về chi phí; đã phát triển Amazon SageMaker, đây là cách dễ dàng nhất để tất cả các nhà phát triển xây dựng, đào tạo và triển khai các mô hình; và ra mắt nhiều loại dịch vụ cho phép khách hàng thêm các khả năng của AI như nhận dạng hình ảnh, dự báo và tìm kiếm thông minh vào các ứng dụng chỉ bằng một lệnh gọi API đơn giản. Đây là lý do tại sao các khách hàng như Intuit, Thomson Reuters, AstraZeneca, Ferrari, Bundesliga, 3M và BMW, cũng như hàng nghìn công ty khởi nghiệp và cơ quan chính phủ trên khắp thế giới, đang chuyển đổi bản thân, ngành và sứ mệnh của họ với ML. Chúng tôi áp dụng cách tiếp cận dân chủ hóa tương tự đối với AI tổng quát: chúng tôi nỗ lực đưa những công nghệ này ra khỏi lĩnh vực nghiên cứu và thử nghiệm, đồng thời mở rộng khả năng cung cấp của chúng vượt xa một số công ty khởi nghiệp và công ty công nghệ lớn được tài trợ tốt. Đó là lý do tại sao hôm nay tôi rất vui mừng được công bố một số cải tiến mới sẽ giúp khách hàng của chúng tôi sử dụng AI sáng tạo trong doanh nghiệp của họ một cách dễ dàng và thiết thực.

Xây dựng với AI sáng tạo trên AWS

AI sáng tạo và các mô hình nền tảng

AI sáng tạo là một loại AI có thể tạo ra nội dung và ý tưởng mới, bao gồm các cuộc hội thoại, câu chuyện, hình ảnh, video và âm nhạc. Giống như tất cả AI, AI tổng quát được cung cấp bởi các mô hình ML—các mô hình rất lớn được đào tạo trước trên lượng dữ liệu khổng lồ và thường được gọi là Mô hình Nền tảng (FM). Những tiến bộ gần đây trong ML (cụ thể là việc phát minh ra kiến trúc mạng thần kinh dựa trên máy biến áp) đã dẫn đến sự gia tăng của các mô hình chứa hàng tỷ tham số hoặc biến. Để hiểu được sự thay đổi về quy mô, mô hình được đào tạo trước lớn nhất vào năm 2019 là 330 triệu tham số. Giờ đây, các mô hình lớn nhất có hơn 500B thông số—kích thước tăng 1,600 lần chỉ sau vài năm. Các FM ngày nay, chẳng hạn như các mô hình ngôn ngữ lớn (LLM) GPT3.5 hoặc BLOOM và mô hình chuyển văn bản thành hình ảnh Khuếch tán ổn định từ Ổn định AI, có thể thực hiện nhiều tác vụ trải rộng trên nhiều miền, chẳng hạn như viết bài đăng trên blog, tạo hình ảnh, giải toán, tham gia đối thoại và trả lời câu hỏi dựa trên tài liệu. Kích thước và bản chất mục đích chung của FM làm cho chúng khác với các mô hình ML truyền thống, vốn thường thực hiện các tác vụ cụ thể, như phân tích văn bản để tìm cảm tính, phân loại hình ảnh và dự báo xu hướng.

FM có thể thực hiện nhiều nhiệm vụ hơn vì chúng chứa một số lượng lớn các tham số giúp chúng có khả năng học các khái niệm phức tạp. Và thông qua việc tiếp xúc trước khi đào tạo với dữ liệu quy mô internet ở tất cả các dạng khác nhau và vô số mẫu, các FM học cách áp dụng kiến thức của họ trong nhiều ngữ cảnh khác nhau. Mặc dù các khả năng và khả năng kết quả của một FM được đào tạo trước là đáng kinh ngạc, nhưng khách hàng thực sự hào hứng vì các mô hình có khả năng chung này cũng có thể được tùy chỉnh để thực hiện các chức năng dành riêng cho miền giúp phân biệt doanh nghiệp của họ, chỉ sử dụng một phần nhỏ dữ liệu và tính toán cần thiết để đào tạo một mô hình từ đầu. Các FM tùy chỉnh có thể tạo ra trải nghiệm khách hàng độc đáo, thể hiện tiếng nói, phong cách và dịch vụ của công ty trên nhiều ngành tiêu dùng khác nhau, như ngân hàng, du lịch và chăm sóc sức khỏe. Chẳng hạn, một công ty tài chính cần tự động tạo báo cáo hoạt động hàng ngày để lưu hành nội bộ bằng cách sử dụng tất cả các giao dịch có liên quan có thể tùy chỉnh mô hình với dữ liệu độc quyền, bao gồm các báo cáo trước đây, để FM tìm hiểu cách đọc các báo cáo này và những gì dữ liệu đã được sử dụng để tạo ra chúng.

Tiềm năng của FM là vô cùng thú vị. Nhưng, chúng tôi vẫn còn trong những ngày đầu. Mặc dù ChatGPT là trải nghiệm AI tổng quát rộng rãi đầu tiên thu hút sự chú ý của khách hàng, nhưng hầu hết những người nghiên cứu về AI tổng quát đã nhanh chóng nhận ra rằng một số công ty đã làm việc trên FM trong nhiều năm và có sẵn một số FM khác nhau—mỗi loại có những điểm mạnh và đặc điểm riêng. đặc trưng. Như chúng ta đã thấy trong nhiều năm qua với các công nghệ phát triển nhanh và trong quá trình phát triển của ML, mọi thứ thay đổi nhanh chóng. Chúng tôi hy vọng các kiến trúc mới sẽ xuất hiện trong tương lai và sự đa dạng của các FM này sẽ tạo ra một làn sóng đổi mới. Chúng tôi đã thấy những trải nghiệm ứng dụng mới chưa từng thấy trước đây. Khách hàng của AWS đã hỏi chúng tôi về cách họ có thể nhanh chóng tận dụng những gì hiện có (và những gì có khả năng sẽ ra mắt vào ngày mai) cũng như nhanh chóng bắt đầu sử dụng FM và AI thế hệ mới trong các doanh nghiệp và tổ chức của họ để nâng cao năng suất và chuyển đổi các dịch vụ của họ.

Công bố các mẫu Amazon Bedrock và Amazon Titan, cách dễ dàng nhất để xây dựng và thay đổi quy mô các ứng dụng AI tổng quát bằng FM

Khách hàng đã nói với chúng tôi rằng có một vài điều lớn đang cản trở họ ngày hôm nay. Đầu tiên, họ cần một cách đơn giản để tìm và truy cập các FM hiệu suất cao mang lại kết quả nổi bật và phù hợp nhất cho mục đích của họ. Thứ hai, khách hàng muốn tích hợp vào các ứng dụng một cách liền mạch mà không phải quản lý các cụm cơ sở hạ tầng khổng lồ hoặc chịu chi phí lớn. Cuối cùng, khách hàng muốn dễ dàng sử dụng FM cơ bản và xây dựng các ứng dụng khác biệt bằng cách sử dụng dữ liệu của riêng họ (ít hoặc nhiều dữ liệu). Vì dữ liệu mà khách hàng muốn sử dụng để tùy chỉnh là IP vô cùng quý giá nên họ cần dữ liệu đó luôn được bảo vệ hoàn toàn, bảo mật và riêng tư trong suốt quá trình đó, đồng thời họ muốn kiểm soát cách chia sẻ và sử dụng dữ liệu của mình.

Chúng tôi đã lấy tất cả phản hồi đó từ khách hàng và hôm nay chúng tôi rất vui mừng thông báo nền tảng Amazon, một dịch vụ mới giúp các FM từ AI21 Labs, Anthropic, Stability AI và Amazon có thể truy cập được thông qua API. Bedrock là cách dễ dàng nhất để khách hàng xây dựng và mở rộng quy mô các ứng dụng dựa trên AI tổng quát bằng cách sử dụng FM, dân chủ hóa quyền truy cập cho tất cả các nhà xây dựng. Bedrock sẽ cung cấp khả năng truy cập nhiều loại FM mạnh mẽ cho văn bản và hình ảnh—bao gồm Đài FM Titan của Amazon, bao gồm hai LLM mới mà chúng tôi cũng sẽ công bố hôm nay—thông qua dịch vụ được quản lý AWS có thể mở rộng, đáng tin cậy và an toàn. Với trải nghiệm serverless của Bedrock, khách hàng có thể dễ dàng tìm thấy mô hình phù hợp cho những gì họ đang cố gắng hoàn thành, bắt đầu nhanh chóng, tùy chỉnh FM một cách riêng tư bằng dữ liệu của riêng họ, đồng thời dễ dàng tích hợp và triển khai chúng vào các ứng dụng của họ bằng cách sử dụng các công cụ và khả năng của AWS mà họ có. đã quen thuộc (bao gồm tích hợp với các tính năng ML của Amazon SageMaker như Thử nghiệm để kiểm tra các mô hình khác nhau và Đường ống để quản lý FM của họ trên quy mô lớn) mà không phải quản lý bất kỳ cơ sở hạ tầng nào.

Khách hàng của Bedrock có thể chọn từ một số FM tiên tiến nhất hiện nay. Điều này bao gồm dòng LLM đa ngôn ngữ Jurassic-2 từ AI21 Labs, tuân theo hướng dẫn ngôn ngữ tự nhiên để tạo văn bản bằng tiếng Tây Ban Nha, Pháp, Đức, Bồ Đào Nha, Ý và Hà Lan. Claude, LLM của Anthropic, có thể thực hiện nhiều tác vụ xử lý văn bản và hội thoại khác nhau và dựa trên nghiên cứu sâu rộng của Anthropic về đào tạo các hệ thống AI trung thực và có trách nhiệm. Bedrock cũng giúp bạn dễ dàng truy cập vào bộ mô hình nền tảng chuyển văn bản thành hình ảnh của Stability AI, bao gồm cả Stable Diffusion (phổ biến nhất thuộc loại này), có khả năng tạo ra hình ảnh, tác phẩm nghệ thuật, biểu trưng và các tác phẩm nghệ thuật độc đáo, chân thực, chất lượng cao. thiết kế.

Một trong những khả năng quan trọng nhất của Bedrock là việc tùy chỉnh mô hình dễ dàng như thế nào. Khách hàng chỉ cần trỏ Bedrock vào một vài ví dụ được gắn nhãn trong Amazon S3 và dịch vụ có thể tinh chỉnh mô hình cho một tác vụ cụ thể mà không cần phải chú thích khối lượng dữ liệu lớn (chỉ cần 20 ví dụ là đủ). Hãy tưởng tượng một người quản lý tiếp thị nội dung làm việc tại một nhà bán lẻ thời trang hàng đầu và cần phát triển bản sao quảng cáo và chiến dịch mới, được nhắm mục tiêu cho một dòng túi xách mới sắp ra mắt. Để làm điều này, họ cung cấp cho Bedrock một vài ví dụ được gắn nhãn về các khẩu hiệu hoạt động tốt nhất của họ từ các chiến dịch trước đây, cùng với các mô tả sản phẩm được liên kết và Bedrock sẽ tự động bắt đầu tạo phương tiện truyền thông xã hội, quảng cáo hiển thị hình ảnh và nội dung trang web hiệu quả cho túi xách mới. Không có dữ liệu nào của khách hàng được sử dụng để đào tạo các mô hình cơ bản và vì tất cả dữ liệu được mã hóa và không rời khỏi Đám mây riêng ảo (VPC) của khách hàng nên khách hàng có thể tin tưởng rằng dữ liệu của họ sẽ được giữ riêng tư và bí mật.

Bedrock hiện đang ở dạng xem trước có giới hạn và khách hàng thích Đoạn chót rất vui mừng về việc các nhóm phát triển của họ đã bắt đầu và chạy nhanh như thế nào. Shishir Mehrotra, Đồng sáng lập kiêm Giám đốc điều hành của Coda, cho biết: “Là một khách hàng hài lòng lâu năm của AWS, chúng tôi rất vui mừng về cách Amazon Bedrock có thể mang lại chất lượng, khả năng mở rộng và hiệu suất cho Coda AI. Vì tất cả dữ liệu của chúng tôi đã có trên AWS nên chúng tôi có thể nhanh chóng kết hợp AI tổng quát bằng Bedrock, với tất cả tính năng bảo mật và quyền riêng tư mà chúng tôi cần để bảo vệ dữ liệu của mình được tích hợp sẵn. Với hơn hàng chục nghìn đội đang chạy trên Coda, bao gồm cả những đội lớn như Uber, New York Times và Square, độ tin cậy và khả năng mở rộng thực sự quan trọng.”

Chúng tôi đã xem trước các Titan FM mới của Amazon với một số khách hàng trước khi cung cấp chúng rộng rãi hơn trong những tháng tới. Ban đầu chúng tôi sẽ có hai mẫu Titan. Đầu tiên là LLM tổng quát cho các tác vụ như tóm tắt, tạo văn bản (ví dụ: tạo bài đăng trên blog), phân loại, Hỏi & Đáp mở và trích xuất thông tin. Thứ hai là một LLM nhúng dịch các đầu vào văn bản (từ, cụm từ hoặc có thể là đơn vị văn bản lớn) thành các biểu diễn số (được gọi là nhúng) chứa ý nghĩa ngữ nghĩa của văn bản. Mặc dù LLM này sẽ không tạo văn bản, nhưng nó rất hữu ích cho các ứng dụng như cá nhân hóa và tìm kiếm vì bằng cách so sánh các phần nhúng, mô hình sẽ tạo ra các phản hồi phù hợp và theo ngữ cảnh hơn so với khớp từ. Trên thực tế, khả năng tìm kiếm sản phẩm của Amazon.com sử dụng mô hình nhúng tương tự giữa các mô hình khác để giúp khách hàng tìm thấy sản phẩm mà họ đang tìm kiếm. Để tiếp tục hỗ trợ các phương pháp hay nhất trong việc sử dụng AI có trách nhiệm, Titan FM được xây dựng để phát hiện và xóa nội dung có hại trong dữ liệu, từ chối nội dung không phù hợp trong đầu vào của người dùng và lọc đầu ra của mô hình có chứa nội dung không phù hợp (chẳng hạn như ngôn từ kích động thù địch, tục tĩu và bạo lực).

Bedrock giúp các công ty thuộc mọi quy mô có thể tiếp cận sức mạnh của FM để họ có thể đẩy nhanh việc sử dụng ML trong các tổ chức của mình và xây dựng các ứng dụng AI tổng quát của riêng họ vì điều này sẽ dễ dàng cho tất cả các nhà phát triển. Chúng tôi nghĩ rằng Bedrock sẽ là một bước tiến lớn trong việc dân chủ hóa FM và các đối tác của chúng tôi như Accenture, Deloitte, Infosys và Slalom đang xây dựng các phương pháp để giúp các doanh nghiệp phát triển nhanh hơn với AI tổng quát. Nhà cung cấp phần mềm độc lập (ISV) như C3 AI và Pega rất vui khi tận dụng Bedrock để dễ dàng truy cập vào tuyển chọn FM tuyệt vời với tất cả tính bảo mật, quyền riêng tư và độ tin cậy mà họ mong đợi từ AWS.

Thông báo về khả năng sử dụng rộng rãi của các phiên bản Amazon EC2 Trn1n do AWS Trainium cung cấp và các phiên bản Amazon EC2 Inf2 do AWS Inferentia2 cung cấp, cơ sở hạ tầng đám mây tiết kiệm chi phí nhất dành cho AI tổng hợp

Bất kể khách hàng đang cố gắng làm gì với FM—chạy chúng, xây dựng chúng, tùy chỉnh chúng—họ đều cần cơ sở hạ tầng hiệu quả nhất, tiết kiệm chi phí được xây dựng có mục đích cho ML. Trong 21 năm qua, AWS đã đầu tư vào silicon của riêng mình để đẩy mạnh hiệu suất và hiệu suất giá cho các khối lượng công việc đòi hỏi khắt khe như đào tạo ML và suy luận, đồng thời chip AWS Trainium và AWS Inferentia của chúng tôi mang lại chi phí thấp nhất cho các mô hình đào tạo và chạy suy luận trong đám mây. Khả năng tối đa hóa hiệu suất và kiểm soát chi phí bằng cách chọn cơ sở hạ tầng ML tối ưu là lý do khiến các công ty khởi nghiệp AI hàng đầu như AIXNUMX Labs, Anthropic, Cohere, Grammarly, Hugging Face, Runway và Stability AI chạy trên AWS.

Các phiên bản Trn1, do Trainium cung cấp, có thể tiết kiệm tới 50% chi phí đào tạo so với bất kỳ phiên bản EC2 nào khác, đồng thời được tối ưu hóa để phân phối hoạt động đào tạo trên nhiều máy chủ được kết nối với mạng Bộ điều hợp vải đàn hồi (EFA) thế hệ thứ hai 800 Gbps. Khách hàng có thể triển khai các phiên bản Trn1 trong UltraCluster có quy mô lên tới 30,000 chip Trainium (hơn 6 exaflop điện toán) nằm trong cùng Vùng sẵn sàng AWS với kết nối mạng quy mô petabit. Nhiều khách hàng AWS, bao gồm cả Helixon, Money Forward và nhóm Amazon Search, sử dụng các phiên bản Trn1 để giúp giảm thời gian cần thiết để đào tạo các mô hình deep learning quy mô lớn nhất từ vài tháng xuống vài tuần hoặc thậm chí vài ngày đồng thời giảm chi phí. 800 Gbps là rất nhiều băng thông, nhưng chúng tôi đã tiếp tục đổi mới để cung cấp nhiều hơn và hôm nay chúng tôi xin thông báo tính khả dụng chung của mạng mới, được tối ưu hóa trn1n trường hợp, cung cấp băng thông mạng 1600 Gbps và được thiết kế để mang lại hiệu suất cao hơn 20% so với Trn1 cho các mô hình lớn, sử dụng nhiều mạng.

Ngày nay, hầu hết thời gian và tiền bạc dành cho các FM đều dành cho việc đào tạo họ. Điều này là do nhiều khách hàng chỉ mới bắt đầu triển khai FM vào sản xuất. Tuy nhiên, trong tương lai, khi các FM được triển khai trên quy mô lớn, hầu hết các chi phí sẽ liên quan đến việc chạy các mô hình và thực hiện suy luận. Mặc dù bạn thường đào tạo một mô hình theo định kỳ, một ứng dụng sản xuất có thể liên tục tạo ra các dự đoán, được gọi là suy luận, có khả năng tạo ra hàng triệu mỗi giờ. Và những dự đoán này cần phải xảy ra trong thời gian thực, đòi hỏi kết nối mạng có độ trễ rất thấp và thông lượng cao. Alexa là một ví dụ tuyệt vời với hàng triệu yêu cầu đến mỗi phút, chiếm 40% tổng chi phí điện toán.

Bởi vì chúng tôi biết rằng phần lớn chi phí ML trong tương lai sẽ đến từ việc chạy suy luận, nên chúng tôi đã ưu tiên silicon được tối ưu hóa cho suy luận khi bắt đầu đầu tư vào chip mới cách đây vài năm. Vào năm 2018, chúng tôi đã công bố Inferentia, con chip được xây dựng có mục đích đầu tiên dành cho suy luận. Hàng năm, Inferentia giúp Amazon thực hiện hàng nghìn tỷ suy luận và đã tiết kiệm cho các công ty như Amazon hơn một trăm triệu đô la chi phí vốn. Kết quả rất ấn tượng và chúng tôi nhận thấy nhiều cơ hội để tiếp tục đổi mới vì khối lượng công việc sẽ chỉ tăng về quy mô và độ phức tạp khi có nhiều khách hàng tích hợp AI tổng quát vào ứng dụng của họ.

Đó là lý do tại sao chúng tôi thông báo hôm nay sẵn có chung của thông tin2 phiên bản được cung cấp bởi AWS Inferentia2, được tối ưu hóa đặc biệt cho các ứng dụng AI tổng hợp quy mô lớn với các mô hình chứa hàng trăm tỷ tham số. Các phiên bản Inf2 mang lại thông lượng cao hơn tới 4 lần và độ trễ thấp hơn tới 10 lần so với các phiên bản dựa trên Inferentia thế hệ trước. Chúng cũng có kết nối tốc độ cực cao giữa các máy gia tốc để hỗ trợ suy luận phân tán quy mô lớn. Những khả năng này thúc đẩy hiệu suất giá suy luận tốt hơn tới 40% so với các phiên bản Amazon EC2 tương đương khác và chi phí suy luận thấp nhất trên đám mây. Những khách hàng như Runway đang thấy thông lượng với Inf2 cao hơn tới 2 lần so với các phiên bản Amazon EC2 tương đương đối với một số kiểu máy của họ. Suy luận hiệu suất cao, chi phí thấp này sẽ cho phép Runway giới thiệu nhiều tính năng hơn, triển khai các mô hình phức tạp hơn và cuối cùng mang lại trải nghiệm tốt hơn cho hàng triệu người sáng tạo sử dụng Runway.

Thông báo về tính khả dụng rộng rãi của Amazon CodeWhisperer, miễn phí cho các nhà phát triển cá nhân

Chúng tôi biết rằng việc xây dựng với các FM phù hợp và chạy các ứng dụng AI Sáng tạo trên quy mô lớn trên cơ sở hạ tầng đám mây hiệu quả nhất sẽ mang lại sự chuyển đổi cho khách hàng. Làn sóng trải nghiệm mới cũng sẽ mang tính biến đổi cho người dùng. Với AI tổng quát được tích hợp sẵn, người dùng sẽ có thể tương tác tự nhiên và liền mạch hơn với các ứng dụng và hệ thống. Hãy nghĩ về cách chúng ta có thể mở khóa điện thoại di động của mình chỉ bằng cách nhìn vào chúng mà không cần biết bất kỳ điều gì về các mẫu ML mạnh mẽ giúp thực hiện tính năng này.

Một lĩnh vực mà chúng tôi thấy trước việc sử dụng AI tổng quát đang phát triển nhanh chóng là mã hóa. Các nhà phát triển phần mềm ngày nay dành một lượng thời gian đáng kể để viết mã khá đơn giản và không phân biệt. Họ cũng dành nhiều thời gian để cố gắng theo kịp bối cảnh công nghệ và công cụ phức tạp và luôn thay đổi. Tất cả những điều này khiến các nhà phát triển có ít thời gian hơn để phát triển các khả năng và dịch vụ mới, sáng tạo. Các nhà phát triển cố gắng khắc phục điều này bằng cách sao chép và sửa đổi các đoạn mã từ web, điều này có thể dẫn đến việc vô tình sao chép mã không hoạt động, chứa các lỗ hổng bảo mật hoặc không theo dõi việc sử dụng phần mềm nguồn mở. Và cuối cùng, việc tìm kiếm và sao chép vẫn làm mất thời gian của những thứ tốt.

AI sáng tạo có thể loại bỏ gánh nặng này ra khỏi phương trình bằng cách “viết” phần lớn mã không phân biệt, cho phép các nhà phát triển xây dựng nhanh hơn trong khi giải phóng họ để tập trung vào các khía cạnh sáng tạo hơn của mã hóa. Đây là lý do tại sao, năm ngoái, chúng tôi đã công bố bản xem trước của Mã Amazon, một người bạn đồng hành mã hóa AI sử dụng FM ẩn bên trong để cải thiện triệt để năng suất của nhà phát triển bằng cách tạo các đề xuất mã trong thời gian thực dựa trên nhận xét của nhà phát triển bằng ngôn ngữ tự nhiên và mã trước đó trong Môi trường phát triển tích hợp (IDE) của họ. Các nhà phát triển có thể chỉ cần yêu cầu CodeWhisperer thực hiện một tác vụ, chẳng hạn như “phân tích chuỗi bài hát CSV” và yêu cầu nó trả về một danh sách có cấu trúc dựa trên các giá trị như nghệ sĩ, tiêu đề và thứ hạng cao nhất trên bảng xếp hạng. CodeWhisperer cung cấp khả năng tăng năng suất bằng cách tạo toàn bộ hàm phân tích cú pháp chuỗi và trả về danh sách như đã chỉ định. Phản hồi của nhà phát triển đối với bản xem trước cực kỳ tích cực và chúng tôi tiếp tục tin rằng việc giúp các nhà phát triển viết mã cuối cùng có thể trở thành một trong những ứng dụng mạnh mẽ nhất của AI tổng quát mà chúng tôi sẽ thấy trong những năm tới. Trong quá trình xem trước, chúng tôi đã thực hiện một thử thách về năng suất và những người tham gia sử dụng CodeWhisperer đã hoàn thành nhiệm vụ trung bình nhanh hơn 57% và có nhiều khả năng hoàn thành thành công hơn 27% so với những người không sử dụng CodeWhisperer. Đây là một bước tiến vượt bậc về năng suất của nhà phát triển và chúng tôi tin rằng đây mới chỉ là bước khởi đầu.

Hôm nay, chúng tôi vui mừng thông báo về tính khả dụng chung của Amazon CodeWhisperer cho Python, Java, JavaScript, TypeScript và C#—cùng với mười ngôn ngữ mới, bao gồm Go, Kotlin, Rust, PHP và SQL. Có thể truy cập CodeWhisperer từ các IDE như VS Code, IntelliJ IDEA, AWS Cloud9, v.v. thông qua các tiện ích mở rộng AWS Toolkit IDE. CodeWhisperer cũng có sẵn trong bảng điều khiển AWS Lambda. Ngoài việc học hỏi từ hàng tỷ dòng mã có sẵn công khai, CodeWhisperer đã được đào tạo về mã Amazon. Chúng tôi tin rằng CodeWhisperer hiện là cách chính xác nhất, nhanh nhất và an toàn nhất để tạo mã cho các dịch vụ AWS, bao gồm Amazon EC2, AWS Lambda và Amazon S3.

Các nhà phát triển sẽ không thực sự làm việc hiệu quả hơn nếu mã do công cụ AI tổng quát của họ đề xuất chứa các lỗ hổng bảo mật tiềm ẩn hoặc không xử lý nguồn mở một cách có trách nhiệm. CodeWhisperer là người bạn đồng hành mã hóa AI duy nhất có tính năng quét bảo mật tích hợp (được cung cấp bởi suy luận tự động) để tìm và đề xuất các biện pháp khắc phục cho các lỗ hổng khó phát hiện, chẳng hạn như các lỗ hổng trong mười Dự án bảo mật ứng dụng toàn cầu mở (OWASP) hàng đầu, những lỗ hổng đó không đáp ứng các phương pháp hay nhất của thư viện tiền điện tử và các phương pháp khác. Để giúp các nhà phát triển viết mã một cách có trách nhiệm, CodeWhisperer lọc ra các đề xuất mã có thể bị coi là thiên vị hoặc không công bằng và CodeWhisperer là người bạn đồng hành viết mã duy nhất có thể lọc và gắn cờ các đề xuất mã giống với mã nguồn mở mà khách hàng có thể muốn tham khảo hoặc cấp phép sử dụng.

Chúng tôi biết AI tổng quát sẽ thay đổi cuộc chơi dành cho các nhà phát triển và chúng tôi muốn nó hữu ích cho càng nhiều người càng tốt. Đây là lý do tại sao CodeWhisperer miễn phí cho tất cả người dùng cá nhân mà không có trình độ hoặc giới hạn thời gian để tạo mã! Bất kỳ ai cũng có thể đăng ký CodeWhisperer chỉ bằng một tài khoản email và trở nên hiệu quả hơn trong vòng vài phút. Bạn thậm chí không cần phải có tài khoản AWS. Đối với người dùng doanh nghiệp, chúng tôi đang cung cấp Bậc chuyên nghiệp CodeWhisperer bao gồm các tính năng quản trị như đăng nhập một lần (SSO) với tích hợp AWS Identity and Access Management (IAM), cũng như các giới hạn cao hơn đối với quét bảo mật.

Việc xây dựng các ứng dụng mạnh mẽ như CodeWhisperer mang tính chuyển đổi đối với các nhà phát triển và tất cả khách hàng của chúng tôi. Chúng tôi còn nhiều điều nữa sắp tới và chúng tôi rất vui mừng về những gì bạn sẽ xây dựng với trí tuệ nhân tạo tổng quát trên AWS. Nhiệm vụ của chúng tôi là giúp các nhà phát triển thuộc mọi cấp độ kỹ năng và các tổ chức thuộc mọi quy mô có thể đổi mới bằng cách sử dụng AI tổng quát. Đây chỉ là khởi đầu của những gì chúng tôi tin rằng sẽ là làn sóng ML tiếp theo cung cấp khả năng mới cho bạn.

Thông tin

Hãy xem các tài nguyên sau để tìm hiểu thêm về AI tổng quát trên AWS và những thông báo sau:

Giới thiệu về tác giả

Swami Sivasubramanian là Phó chủ tịch về Dữ liệu và Máy học tại AWS. Với vai trò này, Swami giám sát tất cả các dịch vụ Cơ sở dữ liệu AWS, Phân tích và AI & Học máy. Nhiệm vụ của nhóm của anh ấy là giúp các tổ chức đưa dữ liệu của họ hoạt động với một giải pháp dữ liệu đầu cuối, hoàn chỉnh để lưu trữ, truy cập, phân tích và trực quan hóa cũng như dự đoán.

Swami Sivasubramanian là Phó chủ tịch về Dữ liệu và Máy học tại AWS. Với vai trò này, Swami giám sát tất cả các dịch vụ Cơ sở dữ liệu AWS, Phân tích và AI & Học máy. Nhiệm vụ của nhóm của anh ấy là giúp các tổ chức đưa dữ liệu của họ hoạt động với một giải pháp dữ liệu đầu cuối, hoàn chỉnh để lưu trữ, truy cập, phân tích và trực quan hóa cũng như dự đoán.

- Phân phối nội dung và PR được hỗ trợ bởi SEO. Được khuếch đại ngay hôm nay.

- Platoblockchain. Web3 Metaverse Intelligence. Khuếch đại kiến thức. Truy cập Tại đây.

- nguồn: https://aws.amazon.com/blogs/machine-learning/announcing-new-tools-for-building-with-generative-ai-on-aws/