مصنوعی ذہانت (AI) ایک تیزی سے ترقی کرتا ہوا شعبہ ہے جس میں معاشرے کے بہت سے پہلوؤں کو بہتر اور تبدیل کرنے کی صلاحیت ہے۔ 2023 میں، طاقتور فاؤنڈیشن ماڈلز (FMs) کی ترقی اور AI کی تخلیقی صلاحیتوں کے نتیجے میں ترقی کے ساتھ AI ٹیکنالوجیز کو اپنانے کی رفتار مزید تیز ہو گئی ہے۔

Amazon میں، ہم نے متعدد جنریٹو AI خدمات شروع کی ہیں، جیسے ایمیزون بیڈرک اور ایمیزون کوڈ وِسپرر، اور اس کے ذریعے انتہائی قابل جنریٹو ماڈلز کی ایک رینج دستیاب کرائی ہے۔ ایمیزون سیج میکر جمپ اسٹارٹ. یہ خدمات تخلیقی AI کی ابھرتی ہوئی صلاحیتوں کو کھولنے میں ہمارے صارفین کی مدد کرنے کے لیے بنائی گئی ہیں، بشمول بہتر تخلیقی، ذاتی نوعیت اور متحرک مواد کی تخلیق، اور اختراعی ڈیزائن۔ وہ AI پریکٹیشنرز کو دنیا کا احساس دلانے کے قابل بھی بنا سکتے ہیں جیسا کہ پہلے کبھی نہیں تھا — زبان کی رکاوٹوں، موسمیاتی تبدیلیوں، سائنسی دریافتوں کو تیز کرنا، اور مزید بہت کچھ۔

تاہم، تخلیقی AI کی مکمل صلاحیت کا ادراک کرنے کے لیے، کسی بھی ممکنہ خطرات پر غور سے غور کرنا ضروری ہے۔ سب سے پہلے اور سب سے اہم، یہ ذمہ دارانہ اور محفوظ ترقی اور تعیناتی کو فروغ دے کر، اور ممکنہ اثرات سے نمٹنے کے لیے فعال اقدامات کو اپنانے کی حوصلہ افزائی کرکے AI نظام کے اسٹیک ہولڈرز کو فائدہ پہنچاتا ہے۔ نتیجتاً، خطرے کا اندازہ لگانے اور ان کا انتظام کرنے کے لیے میکانزم کا قیام AI پریکٹیشنرز کے لیے ایک اہم عمل ہے جس پر غور کرنا چاہیے اور یہ بہت سے ابھرتے ہوئے AI صنعت کے معیارات کا بنیادی جزو بن گیا ہے (مثال کے طور پر، ISO 42001, ISO 23894، اور NIST RMF) اور قانون سازی (جیسے EU AI ایکٹ).

اس پوسٹ میں، ہم آپ کے AI سسٹم کے ممکنہ خطرے کا اندازہ لگانے کے طریقے پر تبادلہ خیال کرتے ہیں۔

خطرے کی مختلف سطحیں کیا ہیں؟

اگرچہ انفرادی مشین لرننگ (ML) ماڈل اور اس سے منسلک خطرات کو تنہائی میں دیکھنا شروع کرنا آسان ہو سکتا ہے، لیکن یہ ضروری ہے کہ اس طرح کے ماڈل کی مخصوص ایپلی کیشن کی تفصیلات اور اس سے متعلقہ استعمال کیس کو ایک مکمل AI سسٹم کے حصے کے طور پر غور کیا جائے۔ . درحقیقت، ایک عام AI نظام ایک ساتھ کام کرنے والے متعدد مختلف ML ماڈلز پر مبنی ہونے کا امکان ہے، اور ایک تنظیم متعدد مختلف AI سسٹمز بنانے کی کوشش کر سکتی ہے۔ نتیجتاً، ہر استعمال کے معاملے اور مختلف سطحوں پر خطرات کا اندازہ لگایا جا سکتا ہے، یعنی ماڈل رسک، AI سسٹم کا خطرہ، اور انٹرپرائز رسک۔

انٹرپرائز رسک ان خطرات کے وسیع میدان کو گھیرے ہوئے ہے جن کا سامنا کسی تنظیم کو ہو سکتا ہے، بشمول مالی، آپریشنل اور اسٹریٹجک خطرات۔ AI سسٹم کا خطرہ AI سسٹمز کے نفاذ اور آپریشن سے وابستہ اثرات پر مرکوز ہے، جبکہ ML ماڈل کا خطرہ خاص طور پر ML ماڈلز میں موجود کمزوریوں اور غیر یقینی صورتحال سے متعلق ہے۔

اس پوسٹ میں، ہم بنیادی طور پر AI سسٹم کے خطرے پر توجہ مرکوز کرتے ہیں۔ تاہم، یہ نوٹ کرنا ضروری ہے کہ کسی تنظیم کے اندر خطرے کے انتظام کی تمام مختلف سطحوں پر غور کیا جانا چاہیے اور ان کی ہم آہنگی کی جانی چاہیے۔

AI سسٹم کے خطرے کی وضاحت کیسے کی جاتی ہے؟

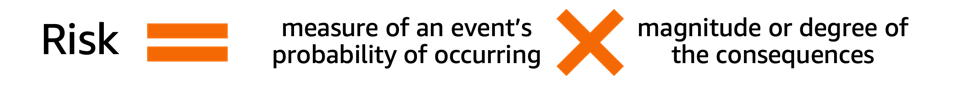

AI نظام کے تناظر میں رسک مینجمنٹ غیر یقینی صورتحال یا ممکنہ منفی اثرات کے اثر کو کم کرنے کا راستہ ہو سکتا ہے، جبکہ مثبت اثرات کو زیادہ سے زیادہ کرنے کے مواقع بھی فراہم کرتا ہے۔ خطرہ بذات خود کوئی ممکنہ نقصان نہیں ہے بلکہ مقاصد پر غیر یقینی صورتحال کا اثر ہے۔ کے مطابق NIST رسک مینجمنٹ فریم ورک (NIST RMF)، خطرے کا تخمینہ متعلقہ واقعہ کے نتائج کی وسعتوں کے مطابق وقت پر ہونے کے واقعہ کے امکان کے ضربی پیمانہ کے طور پر لگایا جا سکتا ہے۔

خطرے کے دو پہلو ہیں: موروثی خطرہ اور بقایا خطرہ۔ موروثی خطرہ اس خطرے کی مقدار کی نمائندگی کرتا ہے جو AI نظام تخفیف یا کنٹرول کی عدم موجودگی میں ظاہر کرتا ہے۔ بقایا خطرہ تخفیف کی حکمت عملیوں میں فیکٹرنگ کے بعد باقی خطرات کو حاصل کرتا ہے۔

ہمیشہ اس بات کو ذہن میں رکھیں کہ خطرے کی تشخیص ایک انسانی توجہ کی سرگرمی ہے جس کے لیے تنظیم کی وسیع کوششوں کی ضرورت ہوتی ہے۔ ان کوششوں میں تمام متعلقہ اسٹیک ہولڈرز کو تشخیصی عمل (جیسے پروڈکٹ، انجینئرنگ، سائنس، سیلز، اور سیکیورٹی ٹیموں) میں شامل کرنے کو یقینی بنانے سے لے کر اس بات کا اندازہ لگانے تک ہے کہ سماجی نقطہ نظر اور اصول بعض واقعات کے ممکنہ امکانات اور نتائج کو کس طرح متاثر کرتے ہیں۔

آپ کی تنظیم کو خطرے کی تشخیص کا خیال کیوں رکھنا چاہیے؟

AI سسٹمز کے لیے رسک مینجمنٹ فریم ورک کا قیام AI سسٹمز کے محفوظ اور ذمہ دار ڈیزائن، ترقی اور آپریشن کو فروغ دے کر معاشرے کو بڑے پیمانے پر فائدہ پہنچا سکتا ہے۔ رسک مینجمنٹ فریم ورک درج ذیل کے ذریعے تنظیموں کو بھی فائدہ پہنچا سکتا ہے:

- بہتر فیصلہ سازی۔ - AI سسٹمز سے وابستہ خطرات کو سمجھ کر، تنظیمیں ان خطرات کو کم کرنے اور AI سسٹمز کو محفوظ اور ذمہ دارانہ انداز میں استعمال کرنے کے بارے میں بہتر فیصلے کر سکتی ہیں۔

- تعمیل کی منصوبہ بندی میں اضافہ - خطرے کی تشخیص کا فریم ورک متعلقہ قوانین اور ضوابط میں خطرے کی تشخیص کے تقاضوں کی تیاری میں تنظیموں کی مدد کر سکتا ہے۔

- اعتماد سازی - یہ ظاہر کرتے ہوئے کہ وہ AI سسٹمز کے خطرات کو کم کرنے کے لیے اقدامات کر رہے ہیں، تنظیمیں اپنے صارفین اور اسٹیک ہولڈرز کو دکھا سکتی ہیں کہ وہ AI کو محفوظ اور ذمہ دارانہ انداز میں استعمال کرنے کے لیے پرعزم ہیں۔

خطرے کا اندازہ کیسے لگایا جائے؟

پہلے قدم کے طور پر، ایک تنظیم کو AI کے استعمال کے معاملے کو بیان کرنے پر غور کرنا چاہیے جس کا جائزہ لینے اور تمام متعلقہ اسٹیک ہولڈرز کی شناخت کرنے کی ضرورت ہے۔ استعمال کا معاملہ ایک مخصوص منظر یا صورت حال ہے جو یہ بتاتا ہے کہ صارف کسی خاص مقصد کو حاصل کرنے کے لیے AI سسٹم کے ساتھ کس طرح تعامل کرتے ہیں۔ استعمال کے کیس کی تفصیل بناتے وقت، یہ بتانے میں مددگار ثابت ہو سکتا ہے کہ کاروباری مسئلے کو حل کیا جا رہا ہے، اس میں شامل اسٹیک ہولڈرز کی فہرست بنانا، ورک فلو کی خصوصیات بنانا، اور سسٹم کے کلیدی ان پٹ اور آؤٹ پٹس کے بارے میں تفصیلات فراہم کرنا۔

جب بات اسٹیک ہولڈرز کی ہو، تو کچھ کو نظر انداز کرنا آسان ہے۔ مندرجہ ذیل اعداد و شمار AI اسٹیک ہولڈر کے کرداروں کو نقشہ کرنے کے لیے ایک اچھا نقطہ آغاز ہے۔

ماخذ: "انفارمیشن ٹیکنالوجی - مصنوعی ذہانت - مصنوعی ذہانت کے تصورات اور اصطلاحات"۔

AI سسٹم کے خطرے کی تشخیص کا ایک اہم اگلا مرحلہ استعمال کے معاملے سے وابستہ ممکنہ طور پر نقصان دہ واقعات کی نشاندہی کرنا ہے۔ ان واقعات پر غور کرتے ہوئے، مثال کے طور پر، ذمہ دار AI کے مختلف جہتوں پر غور کرنا مددگار ہو سکتا ہے، جیسے کہ انصاف پسندی اور مضبوطی۔ مختلف اسٹیک ہولڈرز مختلف جہتوں کے ساتھ مختلف ڈگریوں سے متاثر ہو سکتے ہیں۔ مثال کے طور پر، ایک اختتامی صارف کے لیے کم مضبوطی کا خطرہ AI نظام کا نتیجہ ہو سکتا ہے جو معمولی رکاوٹوں کو ظاہر کرتا ہے، جب کہ ایک AI نظام کی وجہ سے مختلف آبادیاتی گروہوں کے لیے نہ ہونے کے برابر مختلف نتائج پیدا کرنے کی وجہ سے کم انصافی کا خطرہ ہو سکتا ہے۔

کسی واقعہ کے خطرے کا اندازہ لگانے کے لیے، آپ امکانی پیمانے کا استعمال شدت کے پیمانے کے ساتھ مل کر وقوع پذیر ہونے کے امکان کے ساتھ ساتھ نتائج کی ڈگری کی پیمائش کر سکتے ہیں۔ ان ترازو کو تیار کرتے وقت ایک مددگار نقطہ آغاز NIST RMF ہو سکتا ہے، جو بہت کم سے لے کر بہت زیادہ خطرے یا نیم مقداری تشخیص کے اصولوں، جیسے ترازو (جیسے 1-10)، ڈبے، یا دوسری صورت میں معیاری غیر عددی زمرے استعمال کرنے کا مشورہ دیتا ہے۔ نمائندہ نمبر تمام متعلقہ جہتوں کے لیے امکان اور شدت کے پیمانوں کی وضاحت کرنے کے بعد، آپ ہر متعلقہ جہت کے ساتھ فی اسٹیک ہولڈرز کے مجموعی خطرے کی مقدار درست کرنے کے لیے رسک میٹرکس اسکیم کا استعمال کر سکتے ہیں۔ مندرجہ ذیل اعداد و شمار ایک مثال رسک میٹرکس کو ظاہر کرتا ہے۔

اس رسک میٹرکس کا استعمال کرتے ہوئے، ہم کم شدت والے واقعے پر غور کر سکتے ہیں اور اس کے پیش آنے کا بہت کم خطرہ ہے۔ ذہن میں رکھیں کہ ابتدائی تشخیص موروثی خطرے کا تخمینہ ہو گا، اور خطرے کو کم کرنے کی حکمت عملی خطرے کی سطح کو مزید کم کرنے میں مدد کر سکتی ہے۔ اس کے بعد عمل کو دہرایا جا سکتا ہے تاکہ فی ایونٹ کے کسی بھی باقی ماندہ خطرے کے لیے درجہ بندی پیدا کی جا سکے۔ اگر ایک ہی جہت کے ساتھ متعدد واقعات کی نشاندہی کی گئی ہے، تو حتمی تشخیص کا خلاصہ بنانے کے لیے یہ سب کے درمیان سب سے زیادہ خطرے کی سطح کو منتخب کرنے میں مددگار ثابت ہو سکتا ہے۔

حتمی تشخیص کے خلاصے کا استعمال کرتے ہوئے، تنظیموں کو اس بات کی وضاحت کرنی ہوگی کہ ان کے AI سسٹمز کے لیے کون سے خطرے کی سطح قابل قبول ہیں اور ساتھ ہی متعلقہ ضوابط اور پالیسیوں پر بھی غور کریں۔

AWS عزم

کے ساتھ مصروفیات کے ذریعے وائٹ ہاؤس اور UNدوسروں کے علاوہ، ہم AI کے ذمہ دارانہ اور محفوظ استعمال کو آگے بڑھانے کے لیے اپنے علم اور مہارت کا اشتراک کرنے کے لیے پرعزم ہیں۔ ان خطوط کے ساتھ، ایمیزون کے ایڈم سیلپسکی نے حال ہی میں AWS کی نمائندگی کی۔ اے آئی سیفٹی سمٹ ریاست کے سربراہان اور صنعت کے رہنماؤں کے ساتھ، مصنوعی ذہانت کی ذمہ دارانہ ترقی پر تعاون کرنے کے لیے ہماری لگن کو مزید ظاہر کرتے ہوئے۔

نتیجہ

جیسے جیسے AI آگے بڑھتا جا رہا ہے، خطرے کی تشخیص ان تنظیموں کے لیے تیزی سے اہم اور مفید ہوتی جا رہی ہے جو AI کو ذمہ داری کے ساتھ بنانے اور تعینات کرنے کے خواہاں ہیں۔ رسک اسسمنٹ فریم ورک اور خطرے کو کم کرنے کا منصوبہ قائم کرکے، تنظیمیں ممکنہ AI سے متعلقہ واقعات کے خطرے کو کم کر سکتی ہیں اور اپنے صارفین کے ساتھ اعتماد حاصل کر سکتی ہیں، اور ساتھ ہی بہتر وشوسنییتا، مختلف ڈیموگرافکس کے لیے بہتر انصاف پسندی، اور بہت کچھ حاصل کر سکتی ہیں۔

آگے بڑھیں اور اپنی تنظیم میں خطرے کی تشخیص کا فریم ورک تیار کرنے کے اپنے سفر کا آغاز کریں اور تبصروں میں اپنے خیالات کا اشتراک کریں۔

ایمیزون سائنس پر شائع ہونے والے تخلیقی AI خطرات کا ایک جائزہ بھی دیکھیں: تخلیقی دور میں ذمہ دار AI، اور AWS خدمات کی رینج کو دریافت کریں جو آپ کے خطرے کی تشخیص اور تخفیف کے سفر میں آپ کی مدد کر سکتی ہیں: ایمیزون سیج میکر واضح کریں۔, ایمیزون سیج میکر ماڈل مانیٹر, AWS CloudTrail، کے طور پر بھی ماڈل گورننس فریم ورک.

مصنفین کے بارے میں

میا سی مائر AWS مشین لرننگ یونیورسٹی میں ایک اپلائیڈ سائنٹسٹ اور ML معلم ہے۔ جہاں وہ مشین لرننگ اور اے آئی سسٹمز کی حفاظت، وضاحت اور انصاف پر تحقیق کرتی ہے اور سکھاتی ہے۔ اپنے پورے کیریئر کے دوران، میا نے یونیورسٹی کے کئی آؤٹ ریچ پروگرامز قائم کیے، بطور مہمان لیکچرار اور کلیدی مقرر کے طور پر کام کیا، اور متعدد بڑی سیکھنے کی کانفرنسوں میں پیش کیا۔ وہ اندرونی ٹیموں اور AWS صارفین کو ان کے ذمہ دار AI سفر شروع کرنے میں بھی مدد کرتی ہے۔

میا سی مائر AWS مشین لرننگ یونیورسٹی میں ایک اپلائیڈ سائنٹسٹ اور ML معلم ہے۔ جہاں وہ مشین لرننگ اور اے آئی سسٹمز کی حفاظت، وضاحت اور انصاف پر تحقیق کرتی ہے اور سکھاتی ہے۔ اپنے پورے کیریئر کے دوران، میا نے یونیورسٹی کے کئی آؤٹ ریچ پروگرامز قائم کیے، بطور مہمان لیکچرار اور کلیدی مقرر کے طور پر کام کیا، اور متعدد بڑی سیکھنے کی کانفرنسوں میں پیش کیا۔ وہ اندرونی ٹیموں اور AWS صارفین کو ان کے ذمہ دار AI سفر شروع کرنے میں بھی مدد کرتی ہے۔

ڈینس وی باتالوف ایمیزون کے 17 سالہ تجربہ کار ہیں اور مشین لرننگ میں پی ایچ ڈی ہیں، ڈینس نے کتاب کے اندر سرچ، ایمیزون موبائل ایپس اور کنڈل ڈائریکٹ پبلشنگ جیسے دلچسپ پروجیکٹس پر کام کیا۔ 2013 سے اس نے AWS صارفین کو AI/ML ٹیکنالوجی کو بطور سولیوشن آرکیٹیکٹ اپنانے میں مدد کی ہے۔ فی الحال، ڈینس AI/ML کے لیے عالمی سطح پر ٹیک لیڈر ہیں جو عالمی سطح پر AWS ML سپیشلسٹ سلوشنز آرکیٹیکٹس کے کام کے لیے ذمہ دار ہیں۔ ڈینس اکثر عوامی اسپیکر ہیں، آپ اسے ٹویٹر @dbatalov پر فالو کر سکتے ہیں۔

ڈینس وی باتالوف ایمیزون کے 17 سالہ تجربہ کار ہیں اور مشین لرننگ میں پی ایچ ڈی ہیں، ڈینس نے کتاب کے اندر سرچ، ایمیزون موبائل ایپس اور کنڈل ڈائریکٹ پبلشنگ جیسے دلچسپ پروجیکٹس پر کام کیا۔ 2013 سے اس نے AWS صارفین کو AI/ML ٹیکنالوجی کو بطور سولیوشن آرکیٹیکٹ اپنانے میں مدد کی ہے۔ فی الحال، ڈینس AI/ML کے لیے عالمی سطح پر ٹیک لیڈر ہیں جو عالمی سطح پر AWS ML سپیشلسٹ سلوشنز آرکیٹیکٹس کے کام کے لیے ذمہ دار ہیں۔ ڈینس اکثر عوامی اسپیکر ہیں، آپ اسے ٹویٹر @dbatalov پر فالو کر سکتے ہیں۔

ڈاکٹر سارہ لیو AWS ذمہ دار AI ٹیم کے ساتھ ایک سینئر ٹیکنیکل پروگرام مینیجر ہے۔ وہ AWS AI سروسز میں ذمہ دار AI بار کو بڑھانے کے لیے سائنسدانوں، ڈیٹا سیٹ لیڈز، ML انجینئرز، محققین کے ساتھ ساتھ دیگر کراس فنکشنل ٹیموں کے ساتھ کام کرتی ہے۔ اس کے موجودہ پروجیکٹس میں AI سروس کارڈز تیار کرنا، ذمہ دار AI کے لیے خطرے کی تشخیص کرنا، اعلیٰ معیار کے تشخیصی ڈیٹا سیٹس بنانا، اور معیاری پروگراموں کو نافذ کرنا شامل ہے۔ وہ اندرونی ٹیموں اور صارفین کو AI صنعت کے بدلتے ہوئے معیارات پر پورا اترنے میں بھی مدد کرتی ہے۔

ڈاکٹر سارہ لیو AWS ذمہ دار AI ٹیم کے ساتھ ایک سینئر ٹیکنیکل پروگرام مینیجر ہے۔ وہ AWS AI سروسز میں ذمہ دار AI بار کو بڑھانے کے لیے سائنسدانوں، ڈیٹا سیٹ لیڈز، ML انجینئرز، محققین کے ساتھ ساتھ دیگر کراس فنکشنل ٹیموں کے ساتھ کام کرتی ہے۔ اس کے موجودہ پروجیکٹس میں AI سروس کارڈز تیار کرنا، ذمہ دار AI کے لیے خطرے کی تشخیص کرنا، اعلیٰ معیار کے تشخیصی ڈیٹا سیٹس بنانا، اور معیاری پروگراموں کو نافذ کرنا شامل ہے۔ وہ اندرونی ٹیموں اور صارفین کو AI صنعت کے بدلتے ہوئے معیارات پر پورا اترنے میں بھی مدد کرتی ہے۔

- SEO سے چلنے والا مواد اور PR کی تقسیم۔ آج ہی بڑھا دیں۔

- پلیٹو ڈیٹا ڈاٹ نیٹ ورک ورٹیکل جنریٹو اے آئی۔ اپنے آپ کو بااختیار بنائیں۔ یہاں تک رسائی حاصل کریں۔

- پلیٹوآئ اسٹریم۔ ویب 3 انٹیلی جنس۔ علم میں اضافہ۔ یہاں تک رسائی حاصل کریں۔

- پلیٹو ای ایس جی۔ کاربن، کلین ٹیک، توانائی ، ماحولیات، شمسی، ویسٹ مینجمنٹ یہاں تک رسائی حاصل کریں۔

- پلیٹو ہیلتھ۔ بائیوٹیک اینڈ کلینیکل ٹرائلز انٹیلی جنس۔ یہاں تک رسائی حاصل کریں۔

- ماخذ: https://aws.amazon.com/blogs/machine-learning/learn-how-to-assess-risk-of-ai-systems/