ایمیزون ویژن کے لئے تلاش مشین لرننگ (ML) پر مبنی بے ضابطگی کا پتہ لگانے کی خدمت فراہم کرتا ہے تاکہ عام تصاویر کی شناخت کی جا سکے (یعنی اشیاء کی تصاویر بغیر نقائص) بمقابلہ غیر معمولی تصاویر (یعنی اشیاء کی تصاویر ساتھ نقائص)، بے ضابطگیوں کی اقسام (مثال کے طور پر، گمشدہ ٹکڑا)، اور ان بے ضابطگیوں کا مقام۔ لہٰذا، Lookout for Vision ان صارفین میں مقبول ہے جو صنعتی معیار کے معائنہ کے لیے خودکار حل تلاش کرتے ہیں (مثلاً، غیر معمولی مصنوعات کا پتہ لگانا)۔ تاہم، صارفین کے ڈیٹاسیٹس کو عام طور پر دو مسائل کا سامنا کرنا پڑتا ہے:

- بے ضابطگیوں والی تصویروں کی تعداد بہت کم ہو سکتی ہے اور ہو سکتا ہے کہ Lookout for Vision (~20) کے ذریعے عائد کردہ بے ضابطگیوں/عیب کی قسم تک نہ پہنچیں۔

- عام تصاویر میں کافی تنوع نہیں ہو سکتا ہے اور اس کے نتیجے میں ماڈل ناکام ہو سکتا ہے جب ماحولیاتی حالات جیسے روشنی کی پیداوار میں تبدیلی

ان مسائل پر قابو پانے کے لیے، یہ پوسٹ ایک امیج بڑھانے والی پائپ لائن متعارف کراتی ہے جو دونوں مسائل کو نشانہ بناتی ہے: یہ تصاویر میں موجود اشیاء کو ہٹا کر مصنوعی بے ضابطگی والی تصاویر بنانے کا ایک طریقہ فراہم کرتی ہے اور کنٹرول شدہ اضافہ جیسے گاوسی شور، رنگت، سنترپتی، پکسل کو متعارف کروا کر اضافی عام تصاویر تیار کرتی ہے۔ ویلیو اسکیلنگ وغیرہ ہم استعمال کرتے ہیں۔ imgaug لائبریری دوسرے مسئلے کے لیے اضافی بے قاعدہ اور عام تصاویر بنانے کے لیے اضافہ متعارف کرائے گی۔ ہم استعمال کرتے ہیں ایمیزون سیج میکر گراؤنڈ ٹروتھ آبجیکٹ ہٹانے کے ماسک بنانے کے لیے اور لاما تصویر میں پینٹنگ (آبجیکٹ ہٹانے) کی تکنیک کا استعمال کرتے ہوئے پہلے مسئلے کے لیے اشیاء کو ہٹانے کے لیے الگورتھم۔

باقی پوسٹ کو حسب ذیل ترتیب دیا گیا ہے۔ سیکشن 3 میں، ہم عام تصویروں کے لیے امیج کو بڑھانے والی پائپ لائن پیش کرتے ہیں۔ سیکشن 4 میں، ہم غیر معمولی امیجز (عرف مصنوعی عیب جنریشن) کے لیے امیج کو بڑھانے والی پائپ لائن پیش کرتے ہیں۔ سیکشن 5 بڑھے ہوئے ڈیٹاسیٹ کا استعمال کرتے ہوئے وژن ٹریننگ کے نتائج کی تلاش کو واضح کرتا ہے۔ سیکشن 6 یہ ظاہر کرتا ہے کہ مصنوعی ڈیٹا پر تربیت یافتہ ویژن ماڈل کس طرح حقیقی نقائص کے خلاف کارکردگی کا مظاہرہ کرتا ہے۔ سیکشن 7 میں، ہم اس حل کے لیے لاگت کے تخمینہ کے بارے میں بات کرتے ہیں۔ اس پوسٹ کے لیے ہم نے جو کوڈ استعمال کیے ہیں ان تک رسائی حاصل کی جا سکتی ہے۔ یہاں.

1. حل کا جائزہ

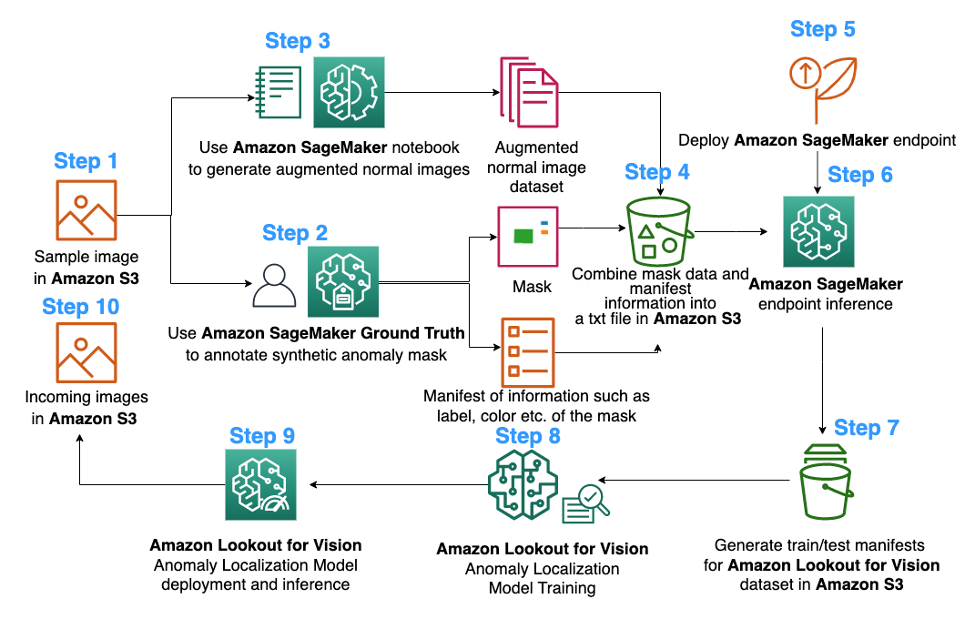

ایم ایل ڈایاگرام

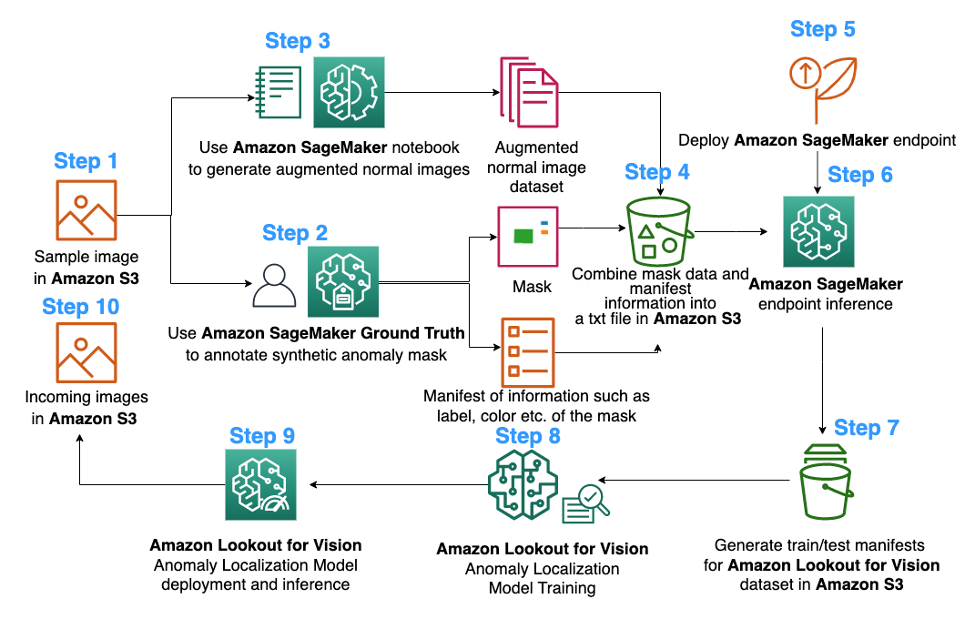

Lookout for Vision anomaly لوکلائزیشن ماڈل ٹریننگ کے لیے مجوزہ امیج اگمینٹیشن پائپ لائن کا خاکہ درج ذیل ہے:

اوپر کا خاکہ تصاویر کی ایک سیریز کو جمع کرنے سے شروع ہوتا ہے (مرحلہ 1)۔ ہم عام تصاویر (مرحلہ 3) کو بڑھا کر اور آبجیکٹ ہٹانے کے الگورتھم (مرحلہ 2، 5-6) کا استعمال کرکے ڈیٹاسیٹ کو بڑھاتے ہیں۔ اس کے بعد ہم ڈیٹا کو ایک فارمیٹ میں پیک کرتے ہیں جسے Amazon Lookout for Vision (مرحلے 7-8) کے ذریعے استعمال کیا جا سکتا ہے۔ آخر میں، مرحلہ 9 میں، ہم وژن لوکلائزیشن کے ماڈل کو تلاش کرنے کے لیے پیکڈ ڈیٹا کا استعمال کرتے ہیں۔

یہ امیج بڑھانے والی پائپ لائن صارفین کو محدود نمونہ ڈیٹاسیٹ میں مصنوعی نقائص پیدا کرنے کے ساتھ ساتھ عام تصویروں میں مزید مقدار اور مختلف قسم کا اضافہ کرنے کی لچک فراہم کرتی ہے۔ یہ Lookout for Vision سروس کی کارکردگی کو فروغ دے گا، کسٹمر ڈیٹا کی کمی کو حل کرے گا اور خودکار معیار کے معائنہ کے عمل کو ہموار بنائے گا۔

2. ڈیٹا کی تیاری

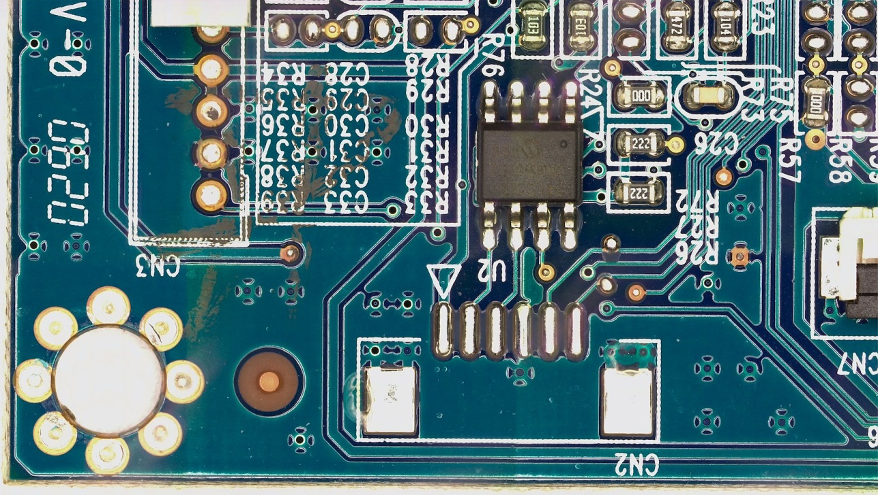

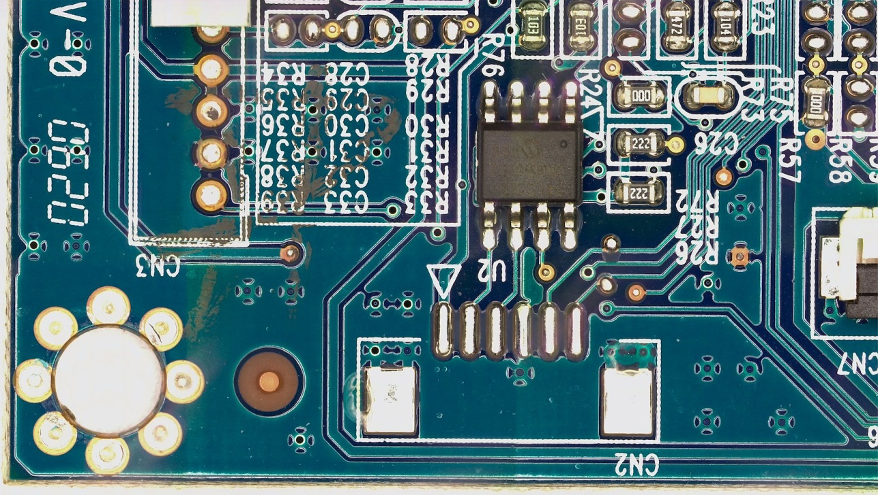

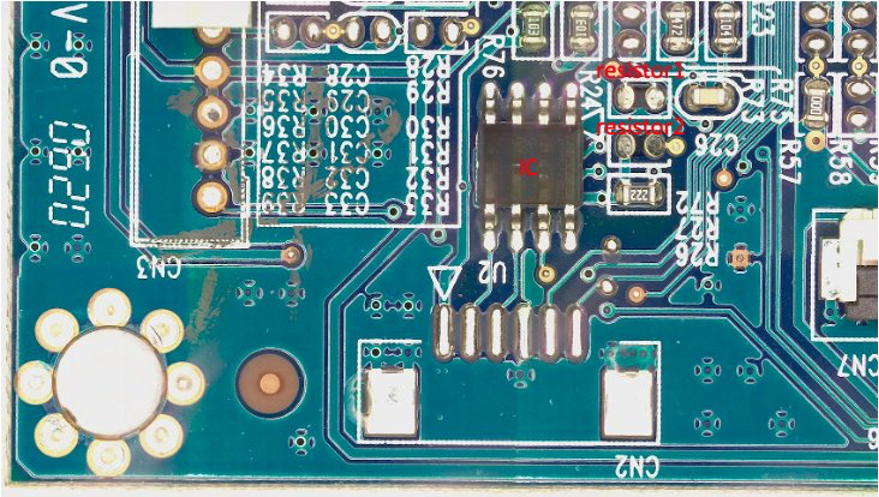

یہاں سے پوسٹ کے آخر تک ہم عوام کو استعمال کرتے ہیں۔ FICS-PCB: خودکار پرنٹ شدہ سرکٹ بورڈ بصری معائنہ کے لیے ایک ملٹی ماڈل امیج ڈیٹا سیٹ ایک کے تحت لائسنس یافتہ ڈیٹا سیٹ Creative Commons Attribution 4.0 International (CC BY 4.0) لائسنس تصویر بڑھانے والی پائپ لائن اور اس کے نتیجے میں وژن کی تربیت اور جانچ کے لیے تلاش کرنے کے لیے۔ یہ ڈیٹاسیٹ خودکار پی سی بی بصری معائنہ کے نظام کی تشخیص میں مدد کے لیے ڈیزائن کیا گیا ہے۔ اسے فلوریڈا یونیورسٹی کی سیکیورٹی اینڈ ایشورنس (SCAN) لیب میں جمع کیا گیا تھا۔ اس تک رسائی حاصل کی جاسکتی ہے۔ یہاں.

ہم اس مفروضے کے ساتھ شروع کرتے ہیں کہ صارف ڈیٹاسیٹ کے طور پر صرف ایک PCB بورڈ (ایک s10 PCB نمونہ) کی ایک عام تصویر فراہم کرتا ہے۔ اسے اس طرح دیکھا جا سکتا ہے:

3. عام تصویروں کے لیے تصویری اضافہ

Lookout for Vision سروس کے لیے کم از کم 20 عام تصاویر اور 20 بے ضابطگیوں کی فی عیب قسم کی ضرورت ہوتی ہے۔ چونکہ نمونے کے اعداد و شمار سے صرف ایک عام تصویر ہے، اس لیے ہمیں امیج بڑھانے کی تکنیکوں کا استعمال کرتے ہوئے مزید نارمل امیجز بنانا چاہیے۔ ایم ایل کے نقطہ نظر سے، مختلف افزودگی تکنیکوں کا استعمال کرتے ہوئے متعدد تصویری تبدیلیوں کو کھانا کھلانا ماڈل کی درستگی اور مضبوطی کو بہتر بنا سکتا ہے۔

ہم استعمال کریں گے imgaug عام تصویروں کی امیج بڑھانے کے لیے۔ Imgaug ایک اوپن سورس python پیکیج ہے جو آپ کو ML تجربات میں تصاویر کو بڑھانے دیتا ہے۔

سب سے پہلے، ہم انسٹال کریں گے imgaug ایک میں لائبریری ایمیزون سیج میکر کاپی.

اگلا، ہم 'IPyPlot' نامی python پیکیج انسٹال کر سکتے ہیں۔

اس کے بعد، ہم بشمول تبدیلیوں کا استعمال کرتے ہوئے اصل تصویر کی امیج کو بڑھاتے ہیں۔ GammaContrast, SigmoidContrast، اور LinearContrast، اور تصویر پر گاوسی شور شامل کرنا۔

import imageio

import imgaug as ia

import imgaug.augmenters as iaa

import ipyplot

input_img = imageio.imread('s10.png')

noise=iaa.AdditiveGaussianNoise(10,40)

input_noise=noise.augment_image(input_img)

contrast=iaa.GammaContrast((0.5, 2.0))

contrast_sig = iaa.SigmoidContrast(gain=(5, 10), cutoff=(0.4, 0.6))

contrast_lin = iaa.LinearContrast((0.6, 0.4))

input_contrast = contrast.augment_image(input_img)

sigmoid_contrast = contrast_sig.augment_image(input_img)

linear_contrast = contrast_lin.augment_image(input_img)

images_list=[input_img, input_contrast,sigmoid_contrast,linear_contrast,input_noise]

labels = ['Original', 'Gamma Contrast','SigmoidContrast','LinearContrast','Gaussian Noise Image']

ipyplot.plot_images(images_list,labels=labels,img_width=180)

چونکہ ہمیں کم از کم 20 عام تصاویر کی ضرورت ہے، اور جتنی زیادہ بہتر، ہم نے اوپر دکھائے گئے 10 تبدیلیوں میں سے ہر ایک کے لیے اپنے عام تصویری ڈیٹاسیٹ کے طور پر 4 بڑھی ہوئی تصاویر تیار کیں۔ مستقبل میں، ہم مختلف جگہوں اور مختلف فرشتوں پر رکھی جانے والی تصاویر کو بھی تبدیل کرنے کا ارادہ رکھتے ہیں تاکہ تربیت یافتہ ماڈل فکسڈ کیمرے کی نسبت آبجیکٹ کی جگہ کے حوالے سے کم حساس ہو سکے۔

4. غیر معمولی تصویروں کو بڑھانے کے لیے مصنوعی خرابی پیدا کرنا

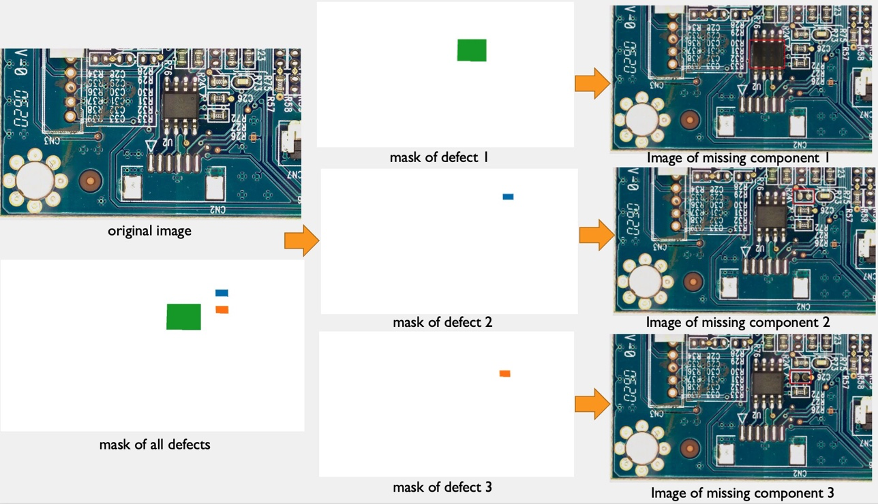

اس سیکشن میں، ہم ڈیٹاسیٹ میں بے ضابطگیوں والی تصاویر کی تعداد کو بڑھانے کے لیے مصنوعی خرابی پیدا کرنے والی پائپ لائن پیش کرتے ہیں۔ نوٹ کریں کہ پچھلے حصے کے برعکس جہاں ہم موجودہ عام نمونوں سے نئے عام نمونے بناتے ہیں، یہاں، ہم عام نمونوں سے نئی بے ضابطگی والی تصاویر بناتے ہیں۔ یہ ان صارفین کے لیے ایک پرکشش خصوصیت ہے جن کے ڈیٹا سیٹس میں اس قسم کی تصاویر کی مکمل کمی ہے، جیسے کہ عام پی سی بی بورڈ کے کسی جزو کو ہٹانا۔ اس مصنوعی خرابی پیدا کرنے والی پائپ لائن کے تین مراحل ہیں: پہلا، ہم Amazon SageMaker Ground Truth کا استعمال کرتے ہوئے ماخذ (عام) تصاویر سے مصنوعی ماسک تیار کرتے ہیں۔ اس پوسٹ میں، ہم ایک مخصوص خرابی کی قسم کو نشانہ بناتے ہیں: غائب جزو۔ یہ ماسک جنریشن ایک ماسک امیج اور مینی فیسٹ فائل فراہم کرتی ہے۔ دوسرا، مینی فیسٹ فائل میں ترمیم کی جانی چاہیے اور SageMaker اینڈ پوائنٹ کے لیے ایک ان پٹ فائل میں تبدیل ہونا چاہیے۔ اور تیسرا، ان پٹ فائل ایک آبجیکٹ ریموول سیج میکر اینڈ پوائنٹ پر ان پٹ ہوتی ہے جو ماسک کے ذریعہ ظاہر کردہ عام تصویر کے حصوں کو ہٹانے کا ذمہ دار ہے۔ یہ اختتامی نقطہ نتیجے میں غیر معمولی تصویر فراہم کرتا ہے۔

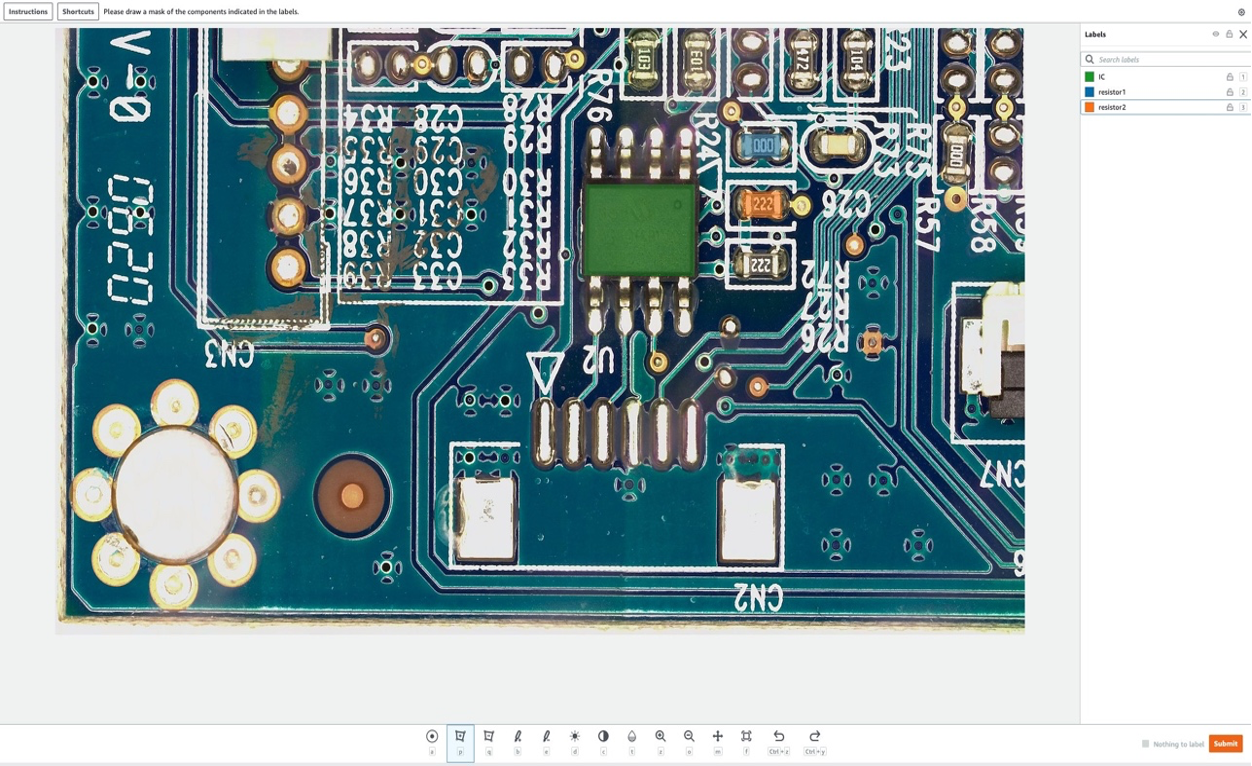

4.1 ایمیزون سیج میکر گراؤنڈ ٹروتھ کا استعمال کرتے ہوئے مصنوعی خرابی کے ماسک تیار کریں۔

ڈیٹا لیبلنگ کے لیے ایمیزون سیج میکر گراؤنڈ ٹروتھ

ایمیزون سیج میکر گراؤنڈ ٹروتھ ایک ڈیٹا لیبلنگ سروس ہے جو ڈیٹا کو لیبل کرنا آسان بناتی ہے اور آپ کو اس کے ذریعے انسانی تشریحی استعمال کرنے کا اختیار دیتی ہے۔ ایمیزون میکانی ترک، فریق ثالث فروش، یا آپ کی اپنی نجی افرادی قوت۔ آپ پیروی کر سکتے ہیں۔ یہ سبق ایک لیبلنگ کام قائم کرنے کے لئے.

اس سیکشن میں، ہم دکھائیں گے کہ ہم کس طرح استعمال کرتے ہیں۔ ایمیزون سیج میکر گراؤنڈ ٹروتھ عام تصویروں میں مخصوص "اجزاء" کو نشان زد کرنے کے لیے جنہیں اگلے مرحلے میں ہٹایا جانا ہے۔ نوٹ کریں کہ اس پوسٹ کی ایک اہم شراکت یہ ہے کہ ہم Amazon SageMaker Ground Truth کو اس کے روایتی انداز میں استعمال نہیں کرتے ہیں (یعنی تربیتی تصاویر کو لیبل کرنے کے لیے)۔ یہاں، ہم اسے عام تصاویر میں مستقبل میں ہٹانے کے لیے ماسک بنانے کے لیے استعمال کرتے ہیں۔ عام تصاویر میں یہ ہٹانے سے مصنوعی نقائص پیدا ہوں گے۔

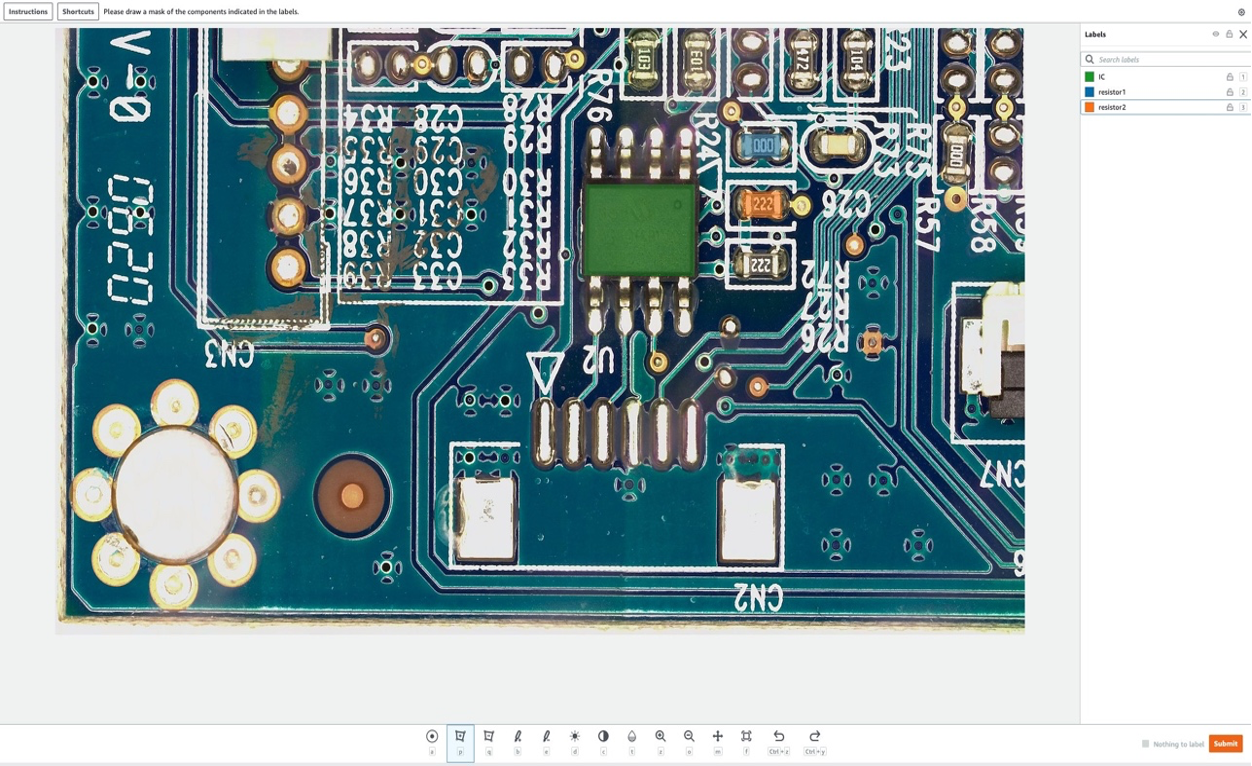

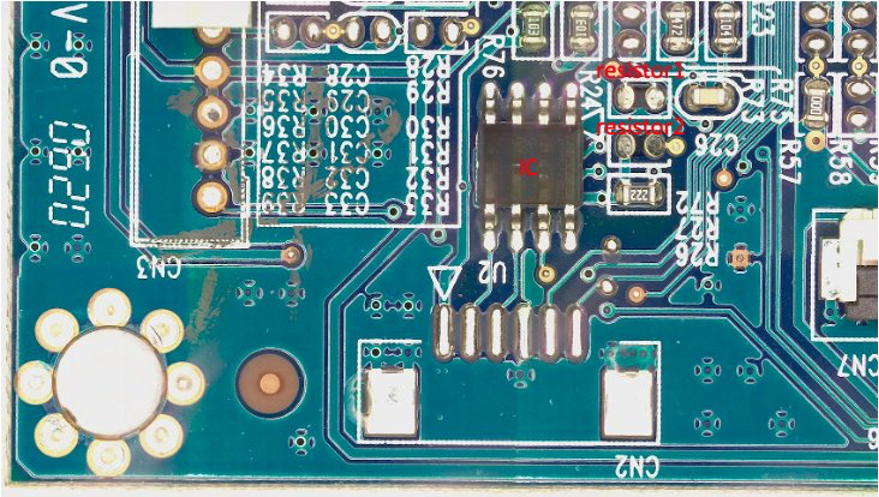

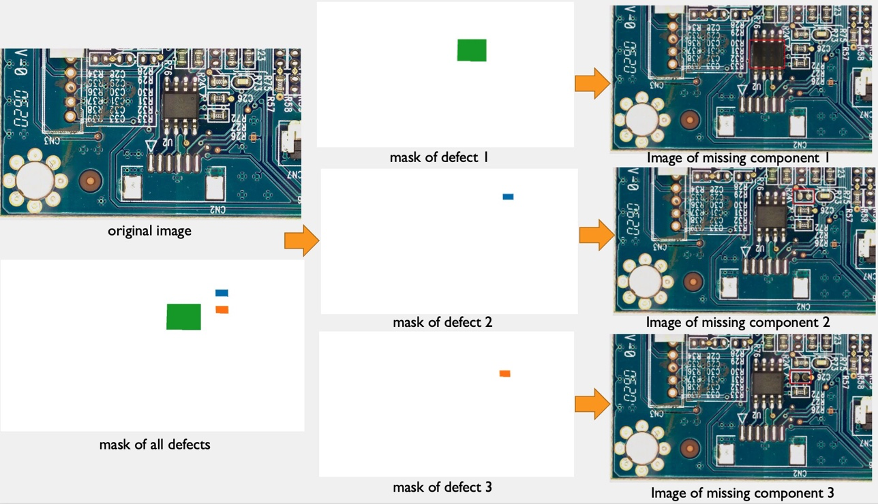

اس پوسٹ کے مقصد کے لیے، ہماری لیبلنگ جاب میں ہم پی سی بی بورڈ سے مصنوعی طور پر تین اجزاء کو ہٹا دیں گے: IC، Resistor1، اور Resistor2۔ لیبلنگ کے کام میں بطور لیبل داخل کرنے کے بعد، آپ لیبل کا نام منتخب کر سکتے ہیں اور اس جزو کے گرد کسی بھی شکل کا ماسک بنا سکتے ہیں جسے آپ تصویر سے مصنوعی عیب کے طور پر ہٹانا چاہتے ہیں۔ نوٹ کریں کہ آپ اس تجربے کے لیبل کے نام میں '_' شامل نہیں کر سکتے ہیں، کیونکہ ہم بعد میں کوڈ میں خرابی کے نام میں مختلف میٹا ڈیٹا کو الگ کرنے کے لیے '_' استعمال کرتے ہیں۔

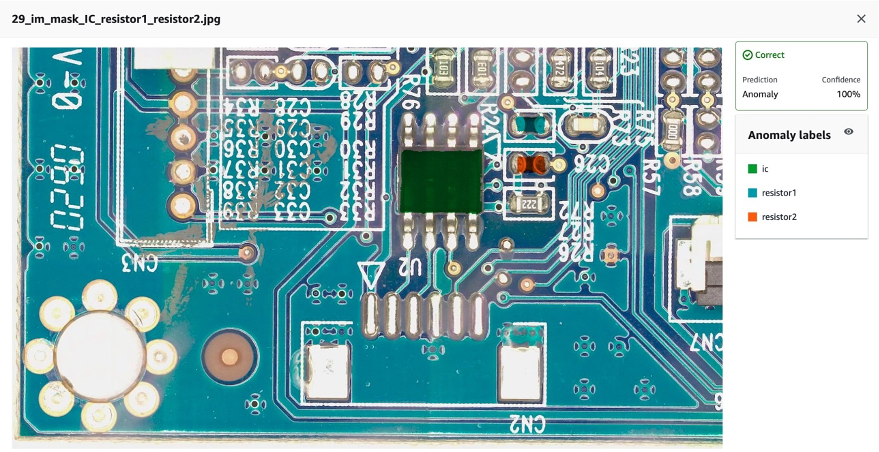

مندرجہ ذیل تصویر میں، ہم IC (انٹیگریٹڈ سرکٹ) کے ارد گرد ایک سبز ماسک، ریزسٹر 1 کے ارد گرد نیلے رنگ کا ماسک اور ریزسٹر 2 کے ارد گرد ایک نارنجی ماسک کھینچتے ہیں۔

ہم منتخب کرنے کے بعد جمع بٹن، ایمیزون سیج میکر گراؤنڈ ٹروتھ سفید پس منظر کے ساتھ ایک آؤٹ پٹ ماسک اور ایک مینی فیسٹ فائل مندرجہ ذیل بنائے گا:

{"source-ref":"s3://pcbtest22/label/s10.png","s10-label-ref":"s3://pcbtest22/label/s10-label/annotations/consolidated-annotation/output/0_2022-09-08T18:01:51.334016.png","s10-label-ref-metadata":{"internal-color-map":{"0":{"class-name":"BACKGROUND","hex-color":"#ffffff","confidence":0},"1":{"class-name":"IC","hex-color":"#2ca02c","confidence":0},"2":{"class-name":"resistor_1","hex-color":"#1f77b4","confidence":0},"3":{"class-name":"resistor_2","hex-color":"#ff7f0e","confidence":0}},"type":"groundtruth/semantic-segmentation","human-annotated":"yes","creation-date":"2022-09-08T18:01:51.498525","job-name":"labeling-job/s10-label"}}

نوٹ کریں کہ اب تک ہم نے کوئی غیر معمولی تصویر نہیں بنائی ہے۔ ہم نے ابھی ان تین اجزاء کو نشان زد کیا ہے جنہیں مصنوعی طور پر ہٹا دیا جائے گا اور جن کے ہٹانے سے غیر معمولی تصاویر بنیں گی۔ بعد میں، ہم دونوں (1) اوپر دی گئی ماسک امیج، اور (2) مینی فیسٹ فائل سے معلومات کو غیر معمولی امیج جنریشن پائپ لائن کے لیے ان پٹ کے طور پر استعمال کریں گے۔ اگلا حصہ دکھاتا ہے کہ سیج میکر اینڈ پوائنٹ کے لیے ان پٹ کیسے تیار کیا جائے۔

4.2 سیج میکر اینڈ پوائنٹ کے لیے ان پٹ تیار کریں۔

ٹرانسفارم ایمیزون سیج میکر گراؤنڈ ٹروتھ کو سیج میکر اینڈ پوائنٹ ان پٹ فائل کے طور پر ظاہر کرتا ہے۔

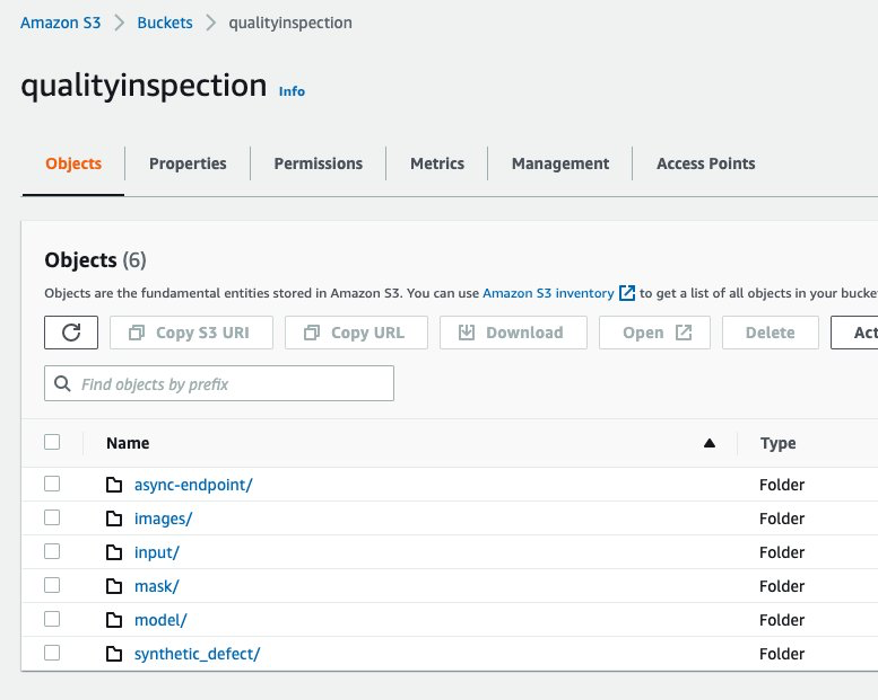

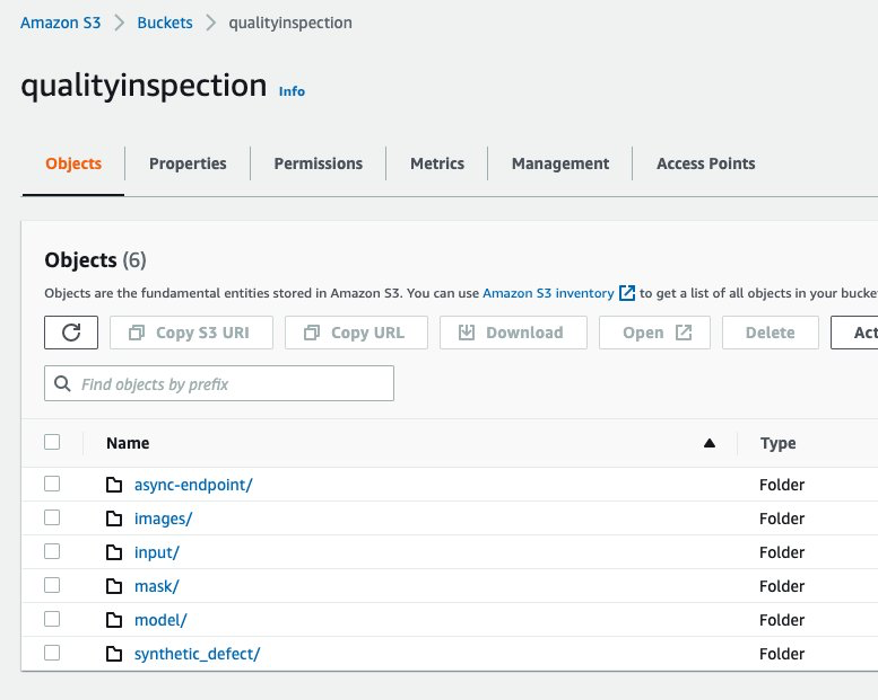

سب سے پہلے، ہم نے ایک سیٹ اپ کیا۔ ایمیزون سادہ اسٹوریج سروس (ایمیزون S3) تصویر بڑھانے والی پائپ لائن کے لیے تمام ان پٹ اور آؤٹ پٹ کو ذخیرہ کرنے کے لیے بالٹی۔ پوسٹ میں، ہم نام کی ایک S3 بالٹی استعمال کرتے ہیں۔ qualityinspection. پھر ہم تمام بڑھی ہوئی نارمل تصاویر تیار کرتے ہیں اور انہیں اس S3 بالٹی میں اپ لوڈ کرتے ہیں۔

from PIL import Image import os import shutil import boto3 s3=boto3.client('s3') # make the image directory

dir_im="images"

if not os.path.isdir(dir_im):

os.makedirs(dir_im)

# create augmented images from original image

input_img = imageio.imread('s10.png') for i in range(10):

noise=iaa.AdditiveGaussianNoise(scale=0.2*255)

contrast=iaa.GammaContrast((0.5,2))

contrast_sig = iaa.SigmoidContrast(gain=(5,20), cutoff=(0.25, 0.75))

contrast_lin = iaa.LinearContrast((0.4,1.6))

input_noise=noise.augment_image(input_img)

input_contrast = contrast.augment_image(input_img)

sigmoid_contrast = contrast_sig.augment_image(input_img)

linear_contrast = contrast_lin.augment_image(input_img)

im_noise = Image.fromarray(input_noise)

im_noise.save(f'{dir_im}/input_noise_{i}.png') im_input_contrast = Image.fromarray(input_contrast)

im_input_contrast.save(f'{dir_im}/contrast_sig_{i}.png') im_sigmoid_contrast = Image.fromarray(sigmoid_contrast)

im_sigmoid_contrast.save(f'{dir_im}/sigmoid_contrast_{i}.png') im_linear_contrast = Image.fromarray(linear_contrast)

im_linear_contrast.save(f'{dir_im}/linear_contrast_{i}.png')

# move original image to image augmentation folder

shutil.move('s10.png','images/s10.png')

# list all the images in the image directory

imlist = [file for file in os.listdir(dir_im) if file.endswith('.png')] # upload augmented images to an s3 bucket

s3_bucket='qualityinspection'

for i in range(len(imlist)):

with open('images/'+imlist[i], 'rb') as data:

s3.upload_fileobj(data, s3_bucket, 'images/'+imlist[i]) # get the image s3 locations

im_s3_list=[]

for i in range(len(imlist)):

image_s3='s3://qualityinspection/images/'+imlist[i]

im_s3_list.append(image_s3)

اس کے بعد، ہم Amazon SageMaker Ground Truth سے ماسک ڈاؤن لوڈ کرتے ہیں اور اسے اس S3 بالٹی میں 'ماسک' نامی فولڈر میں اپ لوڈ کرتے ہیں۔

# download Ground Truth annotation mask image to local from the Ground Truth s3 folder

s3.download_file('pcbtest22', 'label/S10-label3/annotations/consolidated-annotation/output/0_2022-09-09T17:25:31.918770.png', 'mask.png')

# upload mask to mask folder

s3.upload_file('mask.png', 'qualityinspection', 'mask/mask.png')

اس کے بعد، ہم ایمیزون سیج میکر گراؤنڈ ٹروتھ لیبلنگ جاب سے مینی فیسٹ فائل ڈاؤن لوڈ کرتے ہیں اور اسے json لائنوں کے طور پر پڑھتے ہیں۔

import json

#download output manifest to local

s3.download_file('pcbtest22', 'label/S10-label3/manifests/output/output.manifest', 'output.manifest')

# read the manifest file

with open('output.manifest','rt') as the_new_file:

lines=the_new_file.readlines()

for line in lines:

json_line = json.loads(line)

آخر میں، ہم ایک ان پٹ ڈکشنری تیار کرتے ہیں جو ان پٹ امیج کے S3 لوکیشن، ماسک لوکیشن، ماسک کی معلومات وغیرہ کو ریکارڈ کرتی ہے، اسے txt فائل کے طور پر محفوظ کرتی ہے، اور پھر اسے ٹارگٹ S3 بالٹی 'ان پٹ' فولڈر میں اپ لوڈ کرتی ہے۔

# create input dictionary

input_dat=dict()

input_dat['input-image-location']=im_s3_list

input_dat['mask-location']='s3://qualityinspection/mask/mask.png'

input_dat['mask-info']=json_line['S10-label3-ref-metadata']['internal-color-map']

input_dat['output-bucket']='qualityinspection'

input_dat['output-project']='synthetic_defect' # Write the input as a txt file and upload it to s3 location

input_name='input.txt'

with open(input_name, 'w') as the_new_file:

the_new_file.write(json.dumps(input_dat))

s3.upload_file('input.txt', 'qualityinspection', 'input/input.txt')

درج ذیل ایک نمونہ ان پٹ فائل ہے:

{"input-image-location": ["s3://qualityinspection/images/s10.png", ... "s3://qualityinspection/images/contrast_sig_1.png"], "mask-location": "s3://qualityinspection/mask/mask.png", "mask-info": {"0": {"class-name": "BACKGROUND", "hex-color": "#ffffff", "confidence": 0}, "1": {"class-name": "IC", "hex-color": "#2ca02c", "confidence": 0}, "2": {"class-name": "resistor1", "hex-color": "#1f77b4", "confidence": 0}, "3": {"class-name": "resistor2", "hex-color": "#ff7f0e", "confidence": 0}}, "output-bucket": "qualityinspection", "output-project": "synthetic_defect"}

4.3 گمشدہ اجزاء کے ساتھ مصنوعی نقائص پیدا کرنے کے لیے اسینکرونس سیج میکر اینڈ پوائنٹ بنائیں

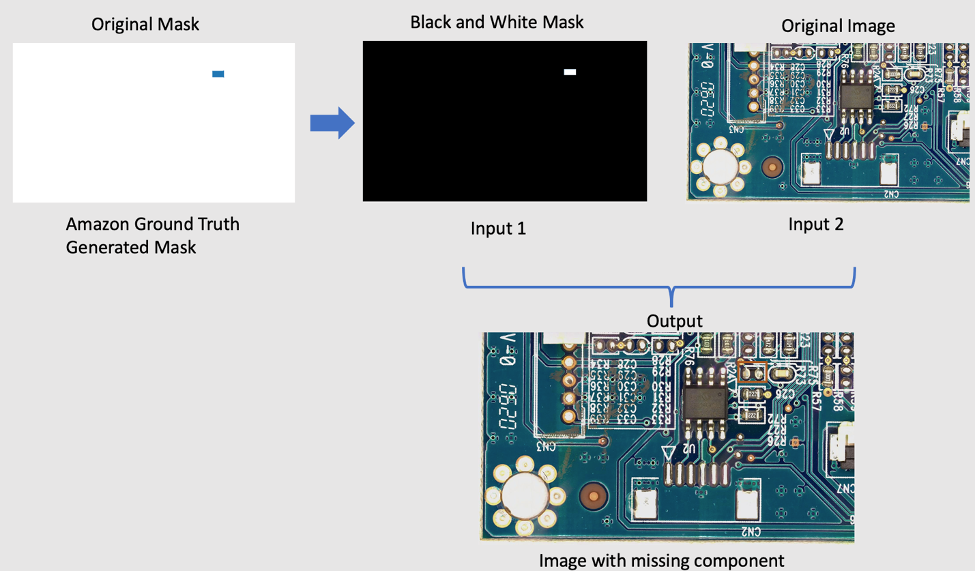

4.3.1 لاما ماڈل

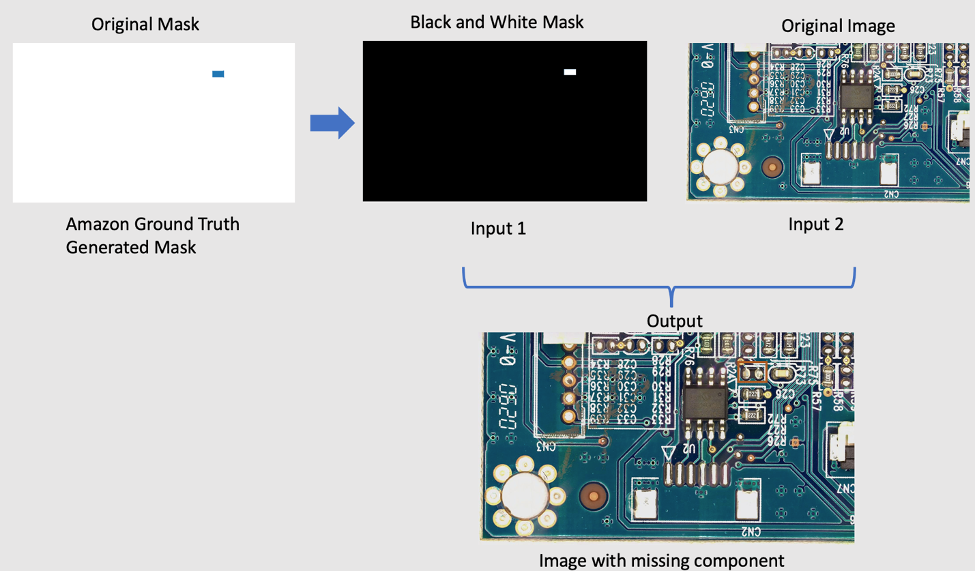

اصل تصویر سے اجزاء کو ہٹانے کے لیے، ہم ایک اوپن سورس PyTorch ماڈل استعمال کر رہے ہیں جسے LaMa کہا جاتا ہے۔ لاما: ریزولیوشن سے بھرپور بڑا ماسک ان پینٹنگ کے ساتھ فوئیر کنولوشنز. یہ ریزولیوشن کے لحاظ سے مضبوط بڑے ماسک ان پینٹنگ ماڈل ہے جو سام سنگ اے آئی کے ذریعہ تیار کردہ فوئیر کنولوشنز کے ساتھ ہے۔ ماڈل کے ان پٹ ایک تصویر اور ایک سیاہ اور سفید ماسک ہیں اور آؤٹ پٹ ایک تصویر ہے جس میں ماسک کے اندر موجود اشیاء کو ہٹا دیا گیا ہے۔ ہم اصلی ماسک بنانے کے لیے Amazon SageMaker Ground Truth کا استعمال کرتے ہیں، اور پھر ضرورت کے مطابق اسے سیاہ اور سفید ماسک میں تبدیل کرتے ہیں۔ لاما ماڈل ایپلی کیشن کو مندرجہ ذیل طور پر دکھایا گیا ہے:

4.3.2 پیش کر رہا ہے Amazon SageMaker Asynchronous inference

ایمیزون سیج میکر اسینکرونس انفرنس میں ایک نیا قیاس آپشن ہے۔ ایمیزون سیج میکر جو آنے والی درخواستوں کو قطار میں کھڑا کرتا ہے اور ان پر متضاد طور پر کارروائی کرتا ہے۔ غیر مطابقت پذیر اندازہ صارفین کو لاگت کو بچانے کے قابل بناتا ہے جب کارروائی کی کوئی درخواست نہیں ہوتی ہے تو مثال کی گنتی کو صفر کر کے خودکار طریقے سے اسکیل کر سکتے ہیں۔ اس کا مطلب ہے کہ آپ صرف اس وقت ادائیگی کرتے ہیں جب آپ کا اینڈ پوائنٹ درخواستوں پر کارروائی کر رہا ہو۔ نیا غیر مطابقت پذیر انفرنس آپشن کام کے بوجھ کے لیے مثالی ہے جہاں درخواست کے سائز بڑے ہیں (1GB تک) اور انفرنس پروسیسنگ کے اوقات منٹ کی ترتیب میں ہیں۔ اختتامی نقطۂٔٔٔٔٔٔٔٔٔ کو تعینات کرنے اور درخواست کرنے کا کوڈ ہے یہاں.

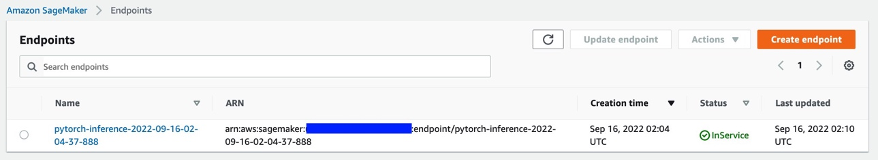

4.3.3 اختتامی نقطہ کی تعیناتی۔

غیر مطابقت پذیر اختتامی نقطہ کو تعینات کرنے کے لیے، پہلے ہمیں حاصل کرنا ہوگا۔ IAM کا کردار اور کچھ ماحولیاتی متغیرات مرتب کریں۔

from sagemaker import get_execution_role

from sagemaker.pytorch import PyTorchModel

import boto3 role = get_execution_role()

env = dict()

env['TS_MAX_REQUEST_SIZE'] = '1000000000'

env['TS_MAX_RESPONSE_SIZE'] = '1000000000'

env['TS_DEFAULT_RESPONSE_TIMEOUT'] = '1000000'

env['DEFAULT_WORKERS_PER_MODEL'] = '1'

جیسا کہ ہم نے پہلے ذکر کیا ہے، ہم اوپن سورس PyTorch ماڈل استعمال کر رہے ہیں۔ لاما: ریزولیوشن سے بھرپور بڑا ماسک ان پینٹنگ کے ساتھ فوئیر کنولوشنز اور پہلے سے تربیت یافتہ ماڈل کو اپ لوڈ کر دیا گیا ہے۔ s3://qualityinspection/model/big-lama.tar.gz. image_uri مطلوبہ فریم ورک اور ازگر کے ورژن والے ڈوکر کنٹینر کی طرف اشارہ کرتا ہے۔

model = PyTorchModel(

entry_point="./inference_defect_gen.py",

role=role,

source_dir = './',

model_data='s3://qualityinspection/model/big-lama.tar.gz',

image_uri = '763104351884.dkr.ecr.us-west-2.amazonaws.com/pytorch-inference:1.11.0-gpu-py38-cu113-ubuntu20.04-sagemaker',

framework_version="1.7.1",

py_version="py3",

env = env,

model_server_workers=1

)

پھر، ہمیں اینڈ پوائنٹ کنفیگریشن بناتے وقت اضافی غیر مطابقت پذیر انفرنس مخصوص کنفیگریشن پیرامیٹرز کی وضاحت کرنی چاہیے۔

from sagemaker.async_inference.async_inference_config import AsyncInferenceConfig

bucket = 'qualityinspection'

prefix = 'async-endpoint'

async_config = AsyncInferenceConfig(output_path=f"s3://{bucket}/{prefix}/output",max_concurrent_invocations_per_instance=10)

اگلا، ہم درج ذیل کوڈ کو چلا کر اختتامی نقطہ کو ml.g4dn.xlarge مثال پر تعینات کرتے ہیں:

predictor = model.deploy(

initial_instance_count=1,

instance_type='ml.g4dn.xlarge',

model_server_workers=1,

async_inference_config=async_config

)

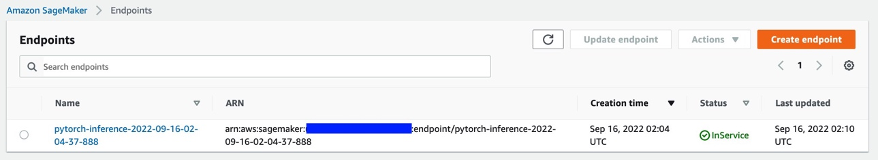

تقریباً 6-8 منٹ کے بعد، اختتامی نقطہ کامیابی کے ساتھ بن جاتا ہے، اور یہ سیج میکر کنسول میں ظاہر ہوگا۔

4.3.4 اختتامی نقطہ کی درخواست کریں۔

اس کے بعد، ہم ان پٹ txt فائل کا استعمال کرتے ہیں جو ہم نے پہلے تیار کی تھی اینڈ پوائنٹ کے ان پٹ کے طور پر اور درج ذیل کوڈ کا استعمال کرتے ہوئے اینڈ پوائنٹ کی درخواست کرتے ہیں:

import boto3

runtime= boto3.client('runtime.sagemaker')

response = runtime.invoke_endpoint_async(EndpointName='pytorch-inference-2022-09-16-02-04-37-888',

InputLocation='s3://qualityinspection/input/input.txt')

مندرجہ بالا کمانڈ پر عمل درآمد فوری طور پر ختم ہو جائے گا۔ تاہم، اندازہ کئی منٹ تک جاری رہے گا جب تک کہ یہ تمام کاموں کو مکمل نہیں کر لیتا اور S3 بالٹی میں موجود تمام آؤٹ پٹ واپس نہیں کر دیتا۔

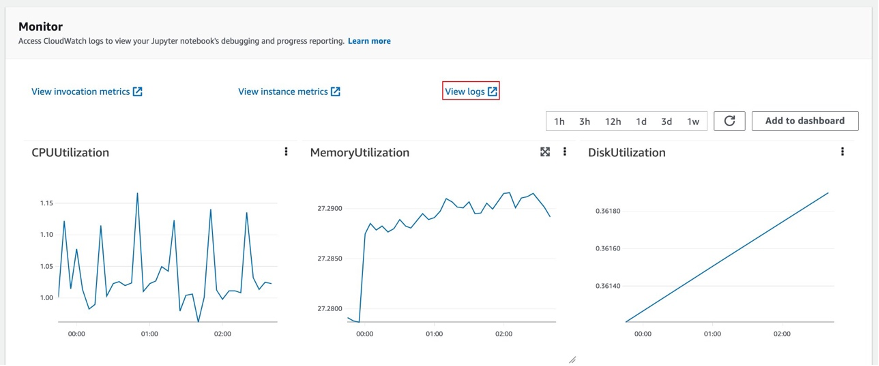

4.3.5 اختتامی نقطہ کے تخمینے کا نتیجہ چیک کریں۔

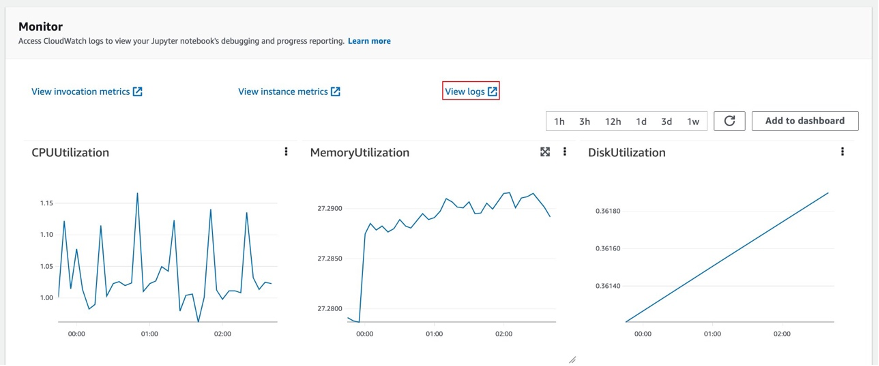

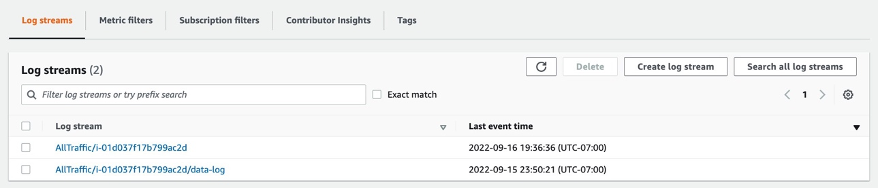

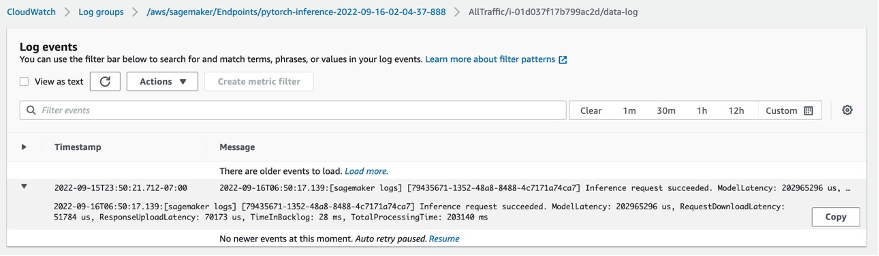

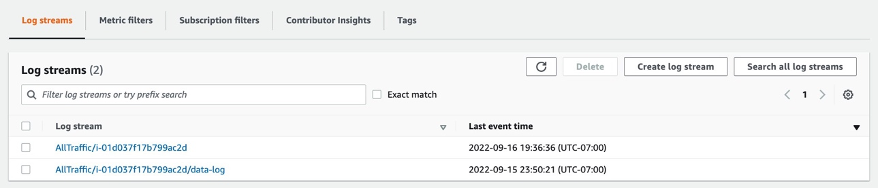

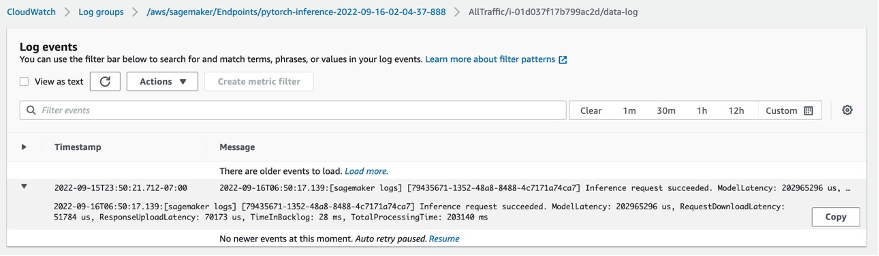

اختتامی نقطہ کو منتخب کرنے کے بعد، آپ کو مانیٹر سیشن نظر آئے گا۔ کنسول میں تخمینہ کے نتائج کو چیک کرنے کے لیے 'دیکھیں لاگز' کو منتخب کریں۔

لاگ اسٹریمز میں دو لاگ ریکارڈز نظر آئیں گے۔ جس کا نام ہے۔ data-log حتمی تخمینہ نتیجہ دکھائے گا، جبکہ دوسرا لاگ ریکارڈ تخمینہ کی تفصیلات دکھائے گا، جو عام طور پر ڈیبگ مقاصد کے لیے استعمال ہوتا ہے۔

اگر استنباط کی درخواست کامیاب ہو جاتی ہے، تو آپ کو یہ پیغام نظر آئے گا: Inference request succeeded.ڈیٹا لاگ میں اور میسج میں کل ماڈل لیٹنسی، کل پروسیس ٹائم وغیرہ کی معلومات بھی حاصل کریں۔ اگر اندازہ ناکام ہوجاتا ہے، تو ڈیبگ کرنے کے لیے دوسرے لاگ کو چیک کریں۔ آپ تخمینہ کی درخواست کی حیثیت کو پول کر کے نتیجہ بھی چیک کر سکتے ہیں۔ Amazon SageMaker Asynchronous inference کے بارے میں مزید جانیں۔ یہاں.

4.3.6 اختتامی نقطہ کا استعمال کرتے ہوئے گمشدہ اجزاء کے ساتھ مصنوعی نقائص پیدا کرنا

ہم اختتامی نقطہ میں چار کام مکمل کریں گے:

- Lookout for Vision anomaly لوکلائزیشن سروس کو ماڈل کی کارکردگی کو بہتر بنانے کے لیے ٹریننگ ڈیٹاسیٹ میں فی تصویر ایک نقص درکار ہے۔ لہذا، ہمیں کلر فلٹرنگ کے ذریعے اختتامی نقطہ میں مختلف نقائص کے لیے ماسک کو الگ کرنا چاہیے۔

- درج ذیل ضرورت کو پورا کرنے کے لیے ٹرین/ٹیسٹ ڈیٹا سیٹ کو تقسیم کریں:

- ٹرین ڈیٹاسیٹ کے لیے کم از کم 10 عام تصاویر اور 10 بے ضابطگیاں

- ٹرین ڈیٹاسیٹ میں ایک نقص/تصویر

- ٹیسٹ ڈیٹاسیٹ کے لیے کم از کم 10 عام تصاویر اور 10 بے ضابطگیاں

- ٹیسٹ ڈیٹاسیٹ کے لیے فی تصویر متعدد نقائص کی اجازت ہے۔

- مصنوعی نقائص پیدا کریں اور انہیں ہدف S3 مقامات پر اپ لوڈ کریں۔

ہم ٹرین ڈیٹاسیٹ کے لیے فی امیج ایک نقص اور فی کلاس 20 سے زیادہ نقائص پیدا کرتے ہیں، نیز ٹیسٹ ڈیٹاسیٹ کے لیے فی تصویر 1-3 نقائص اور فی کلاس 20 سے زیادہ نقائص پیدا کرتے ہیں۔

ذیل میں سورس امیج اور اس کے مصنوعی نقائص کی ایک مثال ہے جس میں تین اجزاء ہیں: IC، Resistor1، اور Resistor 2 غائب۔

اصل تصویر

40_im_mask_IC_resistor1_resistor2.jpg (عیب کا نام غائب اجزاء کی نشاندہی کرتا ہے)

- مندرجہ بالا تمام معلومات کو ریکارڈ کرنے والے ٹرین/ٹیسٹ ڈیٹاسیٹ کے لیے مینی فیسٹ فائلیں بنائیں۔

آخر میں، ہم معلومات کو ریکارڈ کرنے کے لیے ٹرین/ٹیسٹ مینی فیسٹ تیار کریں گے، جیسے مصنوعی عیب S3 لوکیشن، ماسک S3 لوکیشن، ڈیفیکٹ کلاس، ماسک کا رنگ، وغیرہ۔

مینی فیسٹ میں بے ضابطگی اور عام تصویر کے لیے نمونہ json لائنیں درج ذیل ہیں۔

بے ضابطگی کے لیے:

{"source-ref": "s3://qualityinspection/synthetic_defect/anomaly/train/6_im_mask_IC.jpg", "auto-label": 11, "auto-label-metadata": {"class-name": "anomaly", "type": "groundtruth/image-classification"}, "anomaly-mask-ref": "s3://qualityinspection/synthetic_defect/mask/MixMask/mask_IC.png", "anomaly-mask-ref-metadata": {"internal-color-map": {"0": {"class-name": "IC", "hex-color": "#2ca02c", "confidence": 0}}, "type": "groundtruth/semantic-segmentation"}}

عام تصویر کے لیے:

{"source-ref": "s3://qualityinspection/synthetic_defect/normal/train/25_im.jpg", "auto-label": 12, "auto-label-metadata": {"class-name": "normal", "type": "groundtruth/image-classification"}}

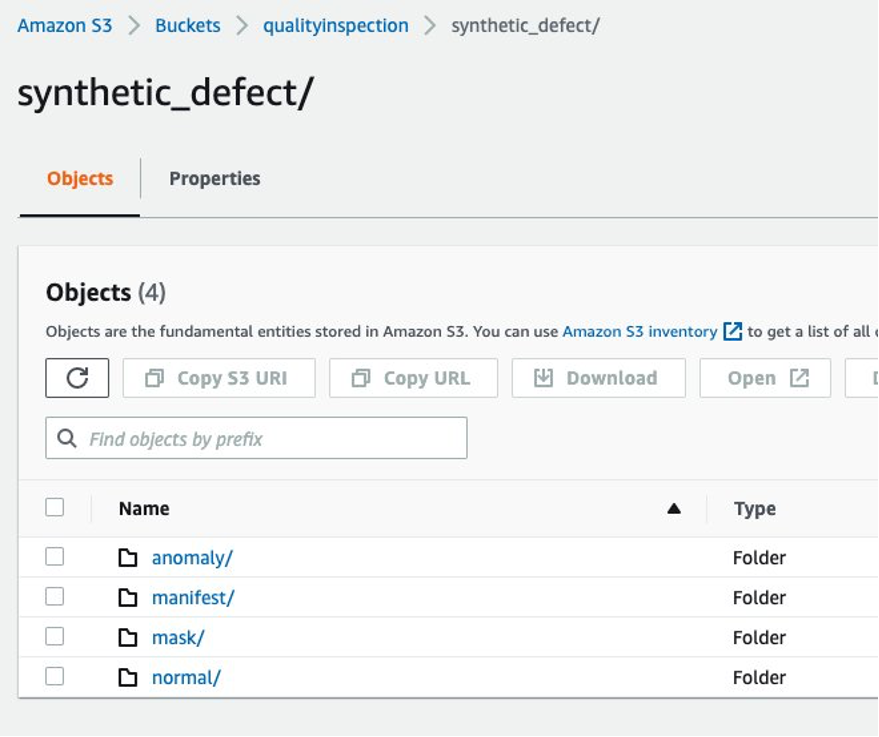

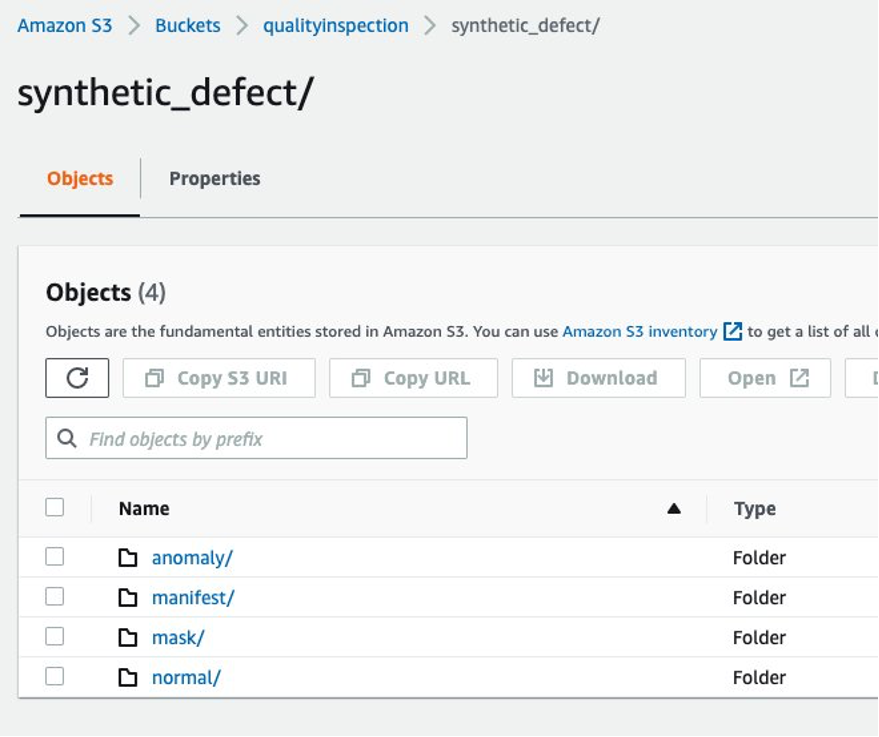

4.3.7 Amazon S3 فولڈر کا ڈھانچہ

اختتامی نقطہ کے ان پٹ اور آؤٹ پٹ کو درج ذیل ڈھانچے میں ہدف S3 بالٹی میں محفوظ کیا جاتا ہے:

5 ویژن ماڈل کی تربیت اور نتیجہ تلاش کریں۔

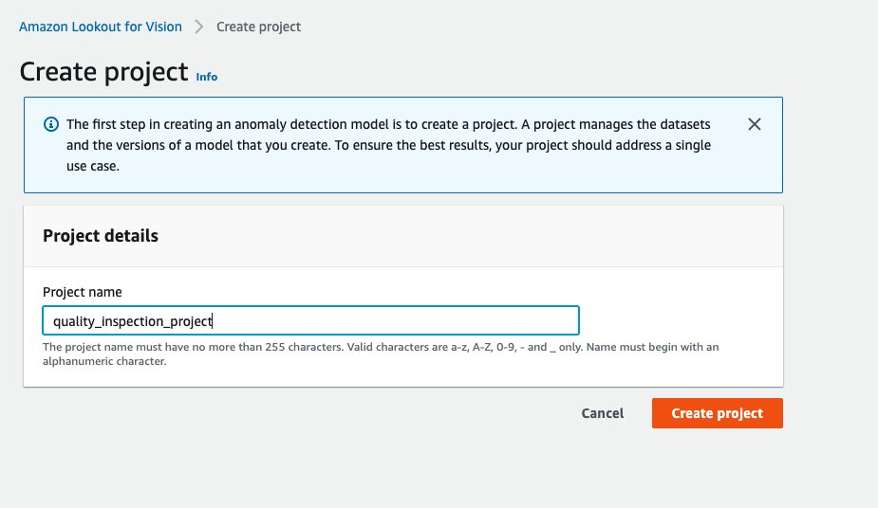

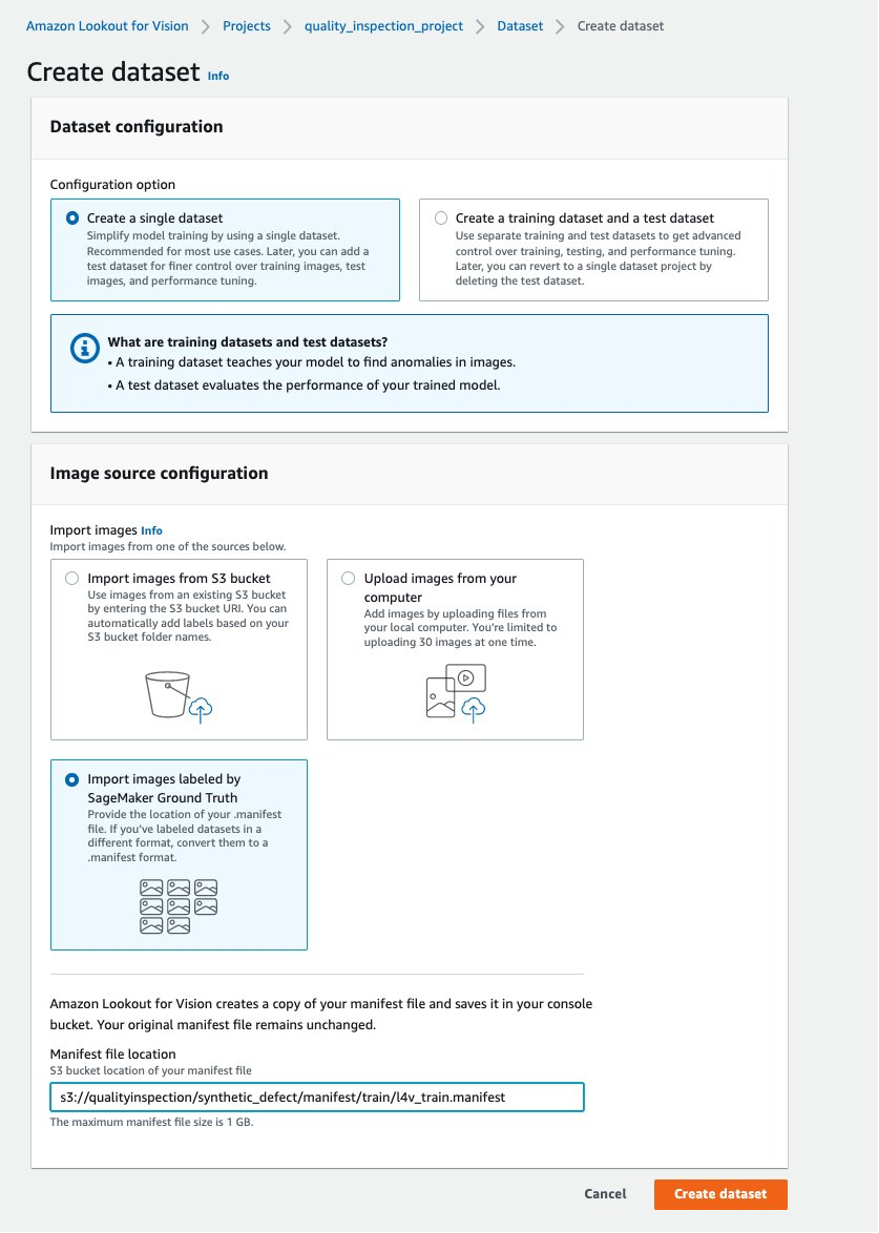

5.1 ایک پروجیکٹ مرتب کریں، ڈیٹاسیٹ اپ لوڈ کریں، اور ماڈل ٹریننگ شروع کریں۔

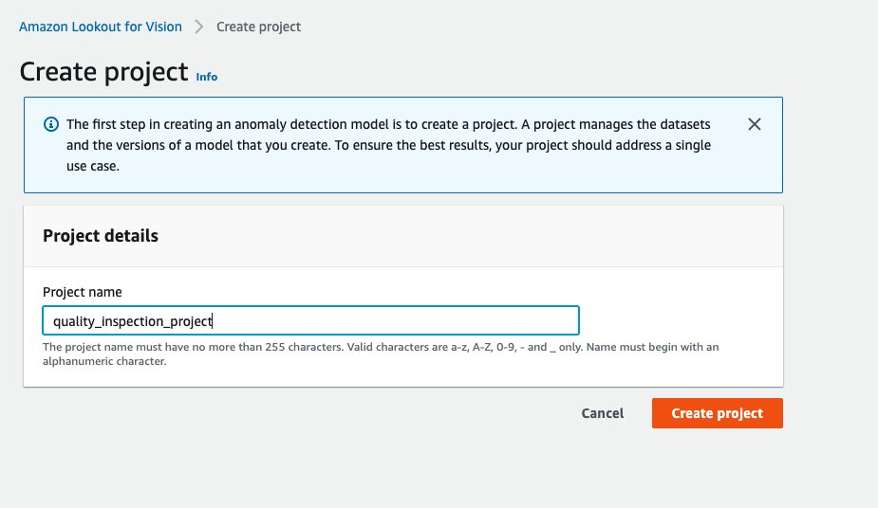

- سب سے پہلے، آپ سے وژن کے لیے Lookout پر جا سکتے ہیں۔ AWS کنسول اور ایک پروجیکٹ بنائیں۔

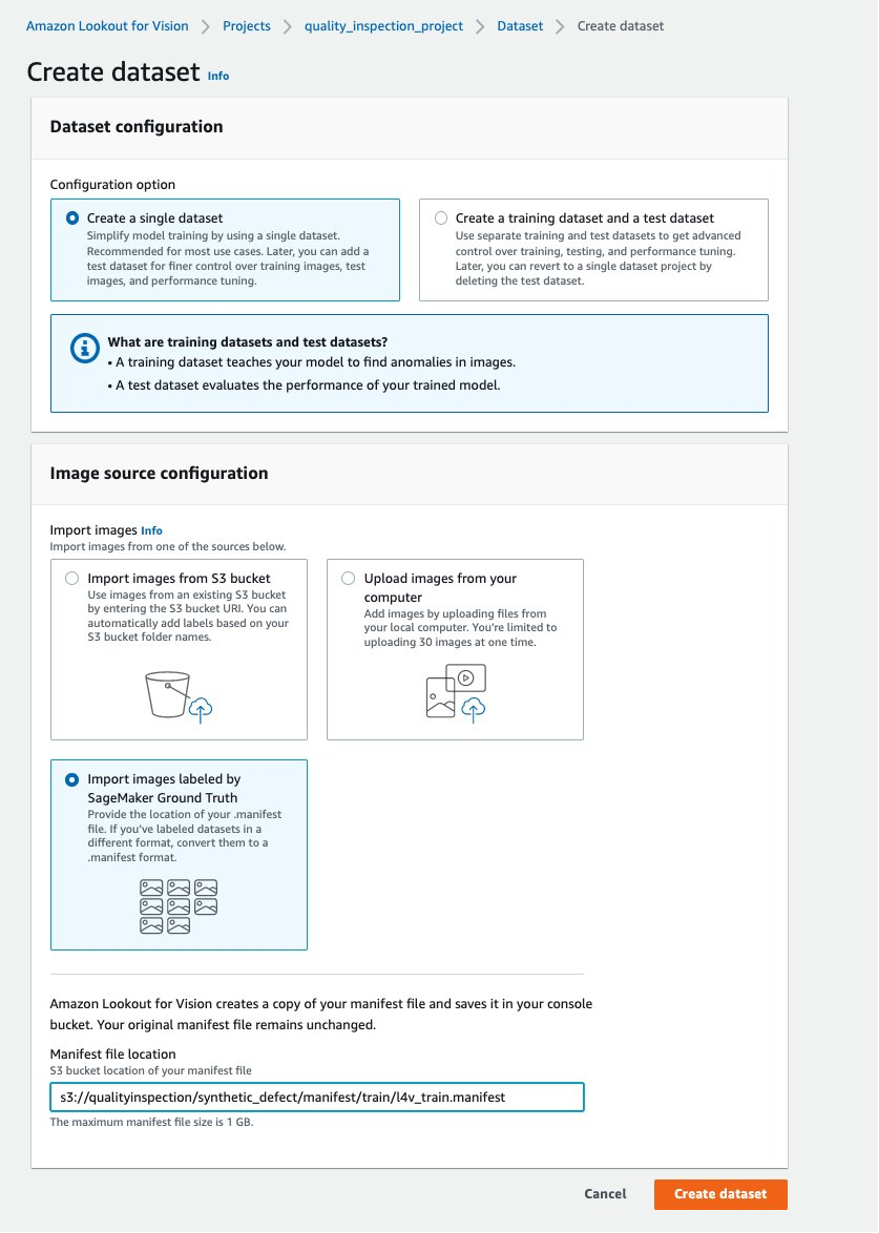

- پھر، آپ انتخاب کر کے تربیتی ڈیٹاسیٹ بنا سکتے ہیں۔ سیج میکر گراؤنڈ ٹروتھ کے لیبل والی تصاویر درآمد کریں۔ اور سیج میکر اینڈ پوائنٹ کے ذریعہ تیار کردہ ٹرین ڈیٹاسیٹ مینی فیسٹ کا Amazon S3 مقام دیں۔

- اگلا، آپ انتخاب کر کے ٹیسٹ ڈیٹاسیٹ بنا سکتے ہیں۔ سیج میکر گراؤنڈ ٹروتھ کے لیبل والی تصاویر درآمد کریں۔ دوبارہ، اور SageMaker اینڈ پوائنٹ کے ذریعہ تیار کردہ ٹیسٹ ڈیٹاسیٹ کا Amazon S3 مقام دیں۔

.......

....

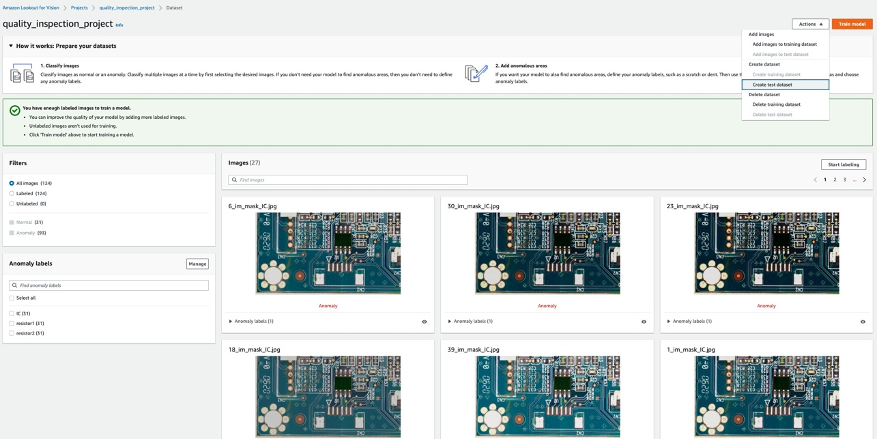

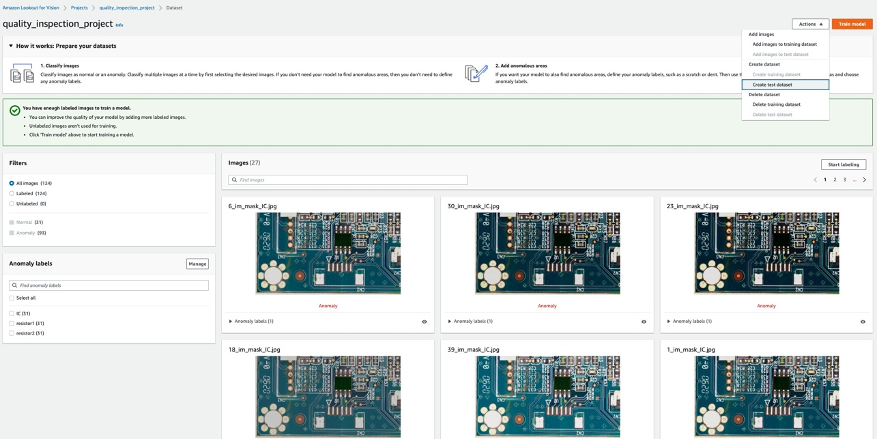

- ٹرین اور ٹیسٹ ڈیٹا سیٹس کے کامیابی سے اپ لوڈ ہونے کے بعد، آپ کو منتخب کر سکتے ہیں۔ ٹرین ماڈل بے ترتیب لوکلائزیشن ماڈل ٹریننگ کو متحرک کرنے کے لیے اوپر دائیں کونے میں بٹن۔

......

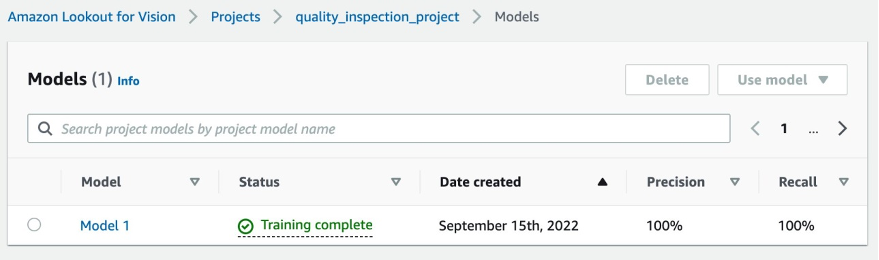

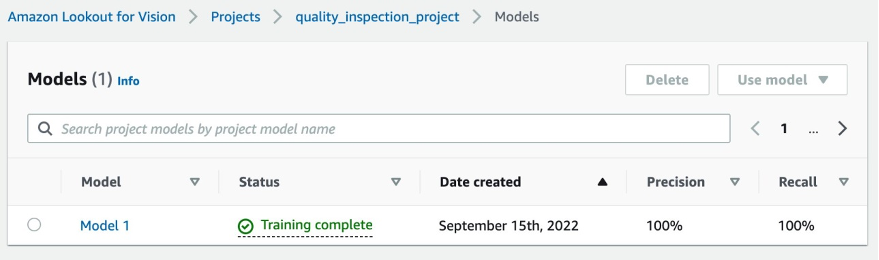

- ہمارے تجربے میں، ماڈل نے تربیت مکمل کرنے میں ایک گھنٹے سے تھوڑا زیادہ وقت لیا۔ جب اسٹیٹس ٹریننگ مکمل دکھاتا ہے، تو آپ نتیجہ چیک کرنے کے لیے ماڈل کا لنک منتخب کر سکتے ہیں۔

....

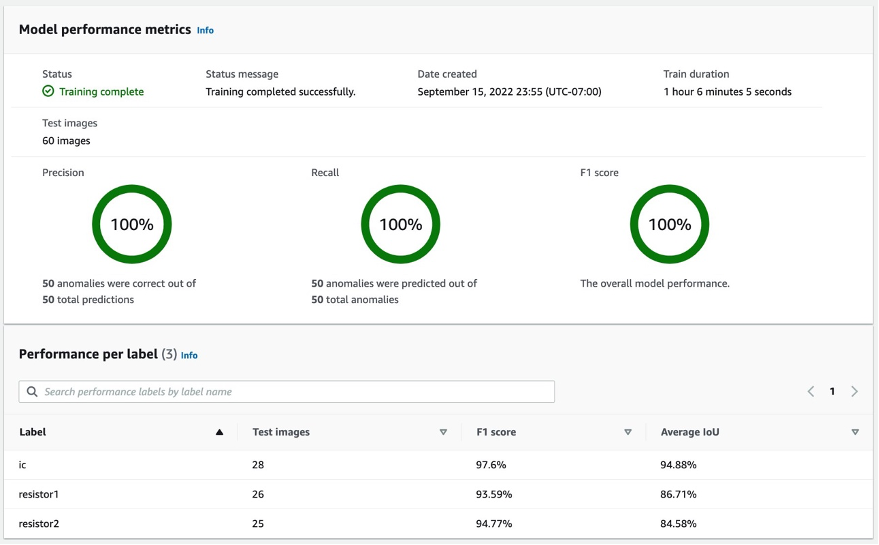

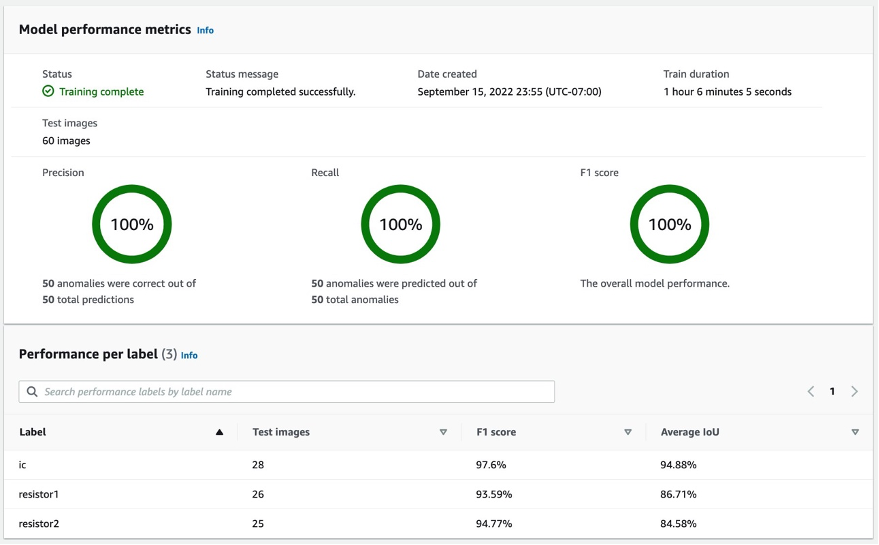

5.2 ماڈل ٹریننگ کا نتیجہ

5.2.1 ماڈل پرفارمنس میٹرکس

پر منتخب کرنے کے بعد ماڈل 1 جیسا کہ اوپر دکھایا گیا ہے، ہم 100% Precision، 100% Recall، اور 100% F1 سکور سے دیکھ سکتے ہیں کہ ماڈل کی کارکردگی کافی اچھی ہے۔ ہم فی لیبل پرفارمنس بھی چیک کر سکتے ہیں (گمشدہ جزو)، اور ہمیں یہ جان کر خوشی ہو گی کہ تینوں لیبلز کے F1 سکور 93% سے اوپر ہیں، اور اوسط IoUs 85% سے اوپر ہیں۔ یہ نتیجہ اس چھوٹے ڈیٹا سیٹ کے لیے اطمینان بخش ہے جس کا مظاہرہ ہم نے پوسٹ میں کیا ہے۔

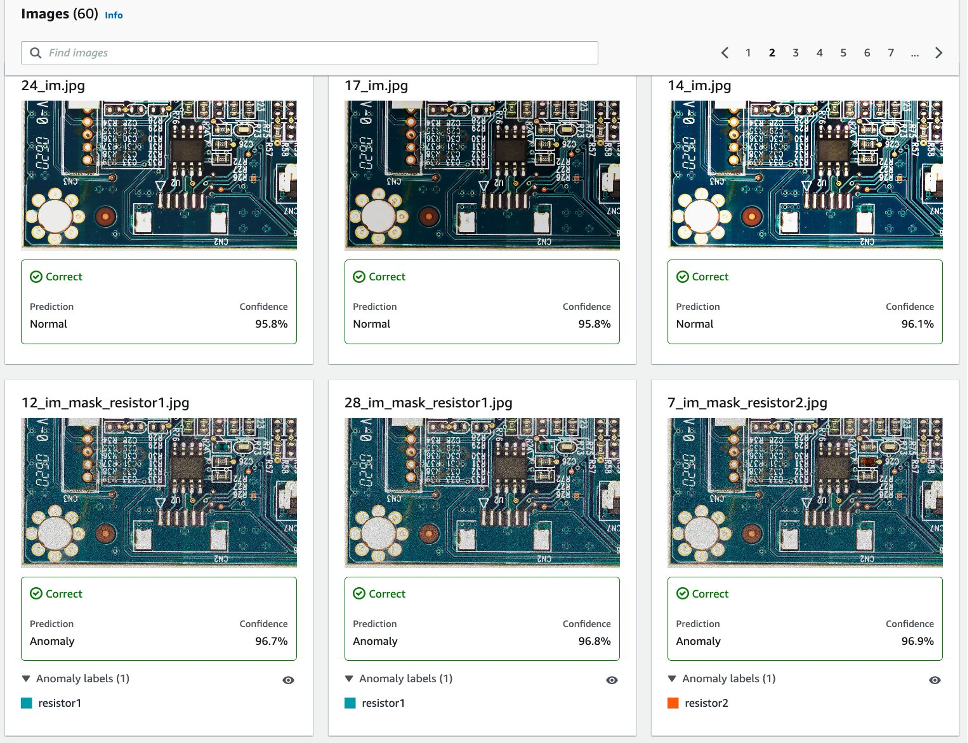

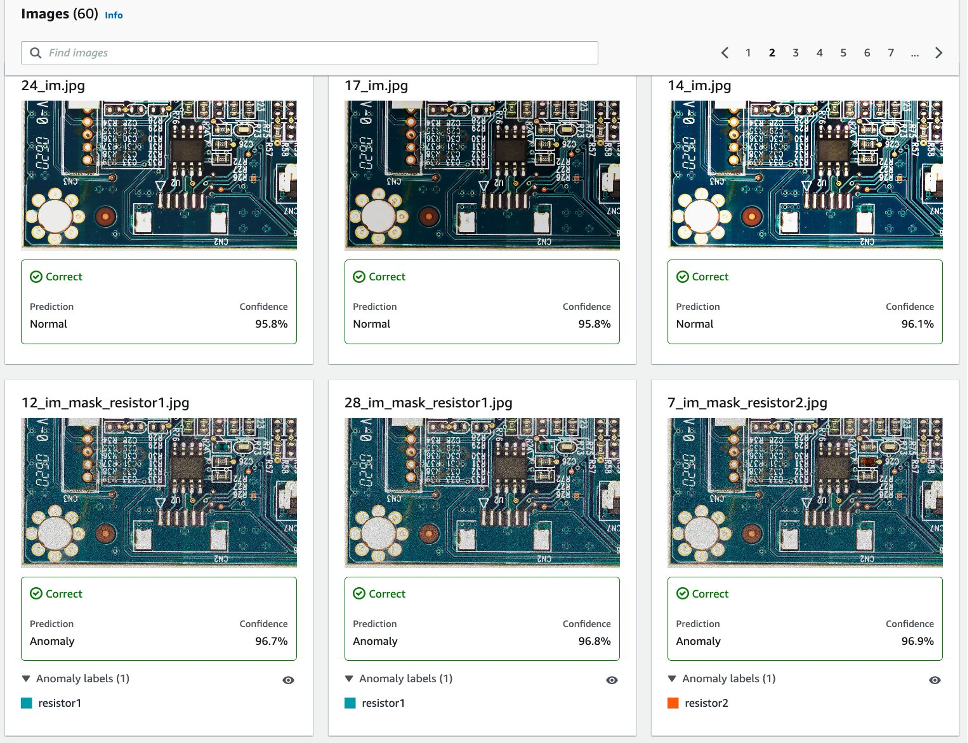

5.2.2 ٹیسٹ ڈیٹاسیٹ میں مصنوعی نقائص کا پتہ لگانے کا تصور۔

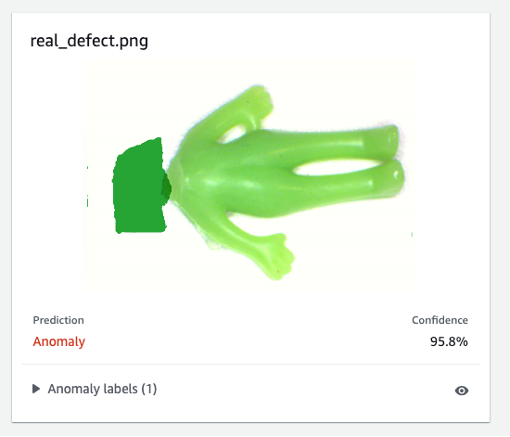

جیسا کہ مندرجہ ذیل تصویر سے ظاہر ہوتا ہے، ہر تصویر کو بطور ڈیفیکٹ کیا جائے گا۔ normal or anomaly اعتماد کے اسکور کے ساتھ لیبل لگائیں۔ اگر یہ ایک بے ضابطگی ہے، تو یہ ہر نقص کی قسم کے لیے مختلف رنگ کے ساتھ تصویر کے غیر معمولی حصے پر ایک ماسک دکھائے گا۔

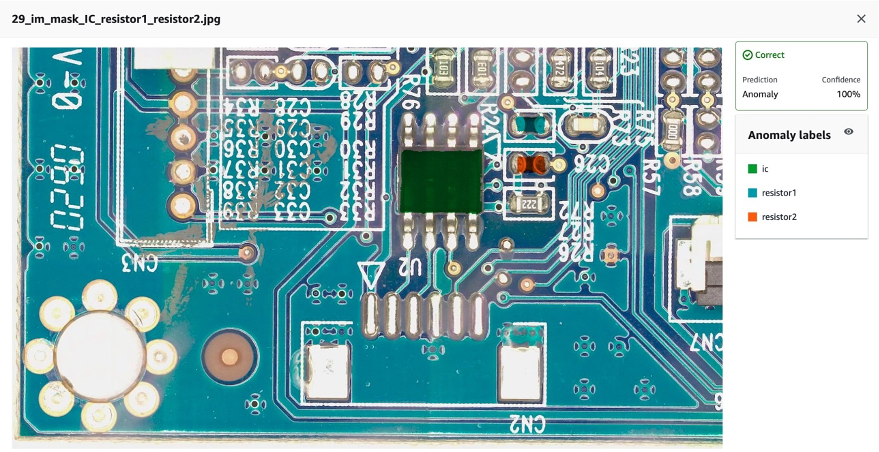

مندرجہ ذیل ٹیسٹ ڈیٹاسیٹ میں مشترکہ گمشدہ اجزاء (اس معاملے میں تین نقائص) کی ایک مثال ہے۔

اس کے بعد آپ ماڈل کو بطور کمپائل اور پیک کر سکتے ہیں۔ AWS IoT گرین گراس اس پوسٹ میں دی گئی ہدایات پر عمل کریں GPU استعمال کیے بغیر کنارے پر Amazon Lookout for Vision کا استعمال کرتے ہوئے بے ضابطگیوں کے مقام کی شناخت کریں۔، اور ماڈل پر انفرنسز چلائیں۔

6. حقیقی نقائص کے خلاف مصنوعی اعداد و شمار پر تربیت یافتہ ویژن ماڈل کے لیے تلاش کریں۔

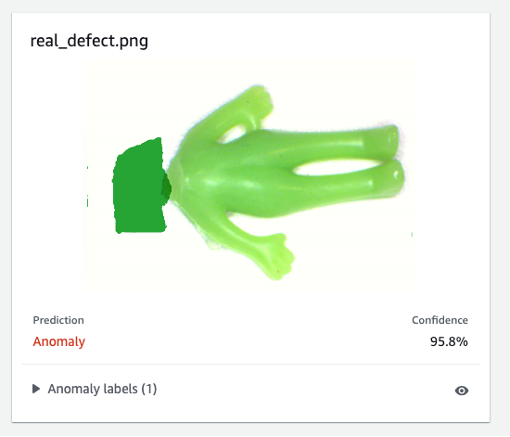

یہ جانچنے کے لیے کہ آیا مصنوعی عیب پر تربیت یافتہ ماڈل حقیقی نقائص کے خلاف اچھی کارکردگی کا مظاہرہ کر سکتا ہے، ہم نے ایک ڈیٹاسیٹ (ایلین-ڈیٹا سیٹ) سے انتخاب کیا۔ یہاں ایک تجربہ چلانے کے لیے۔

سب سے پہلے، ہم پیدا شدہ مصنوعی عیب اور حقیقی عیب کا موازنہ کرتے ہیں۔ بائیں تصویر گمشدہ سر کے ساتھ ایک حقیقی عیب ہے، اور دائیں تصویر ایک ML ماڈل کا استعمال کرتے ہوئے ہٹائے جانے والے سر کے ساتھ پیدا کردہ خرابی ہے۔

اصلی خرابی۔

|

مصنوعی خرابی۔

|

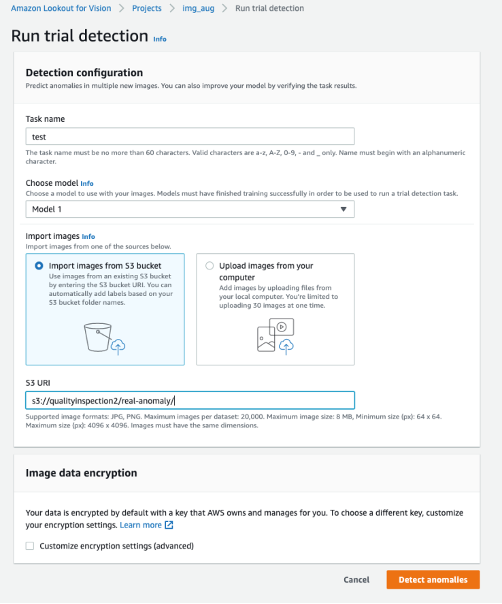

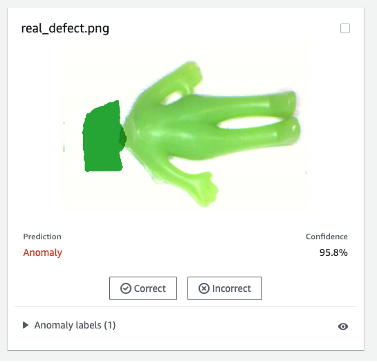

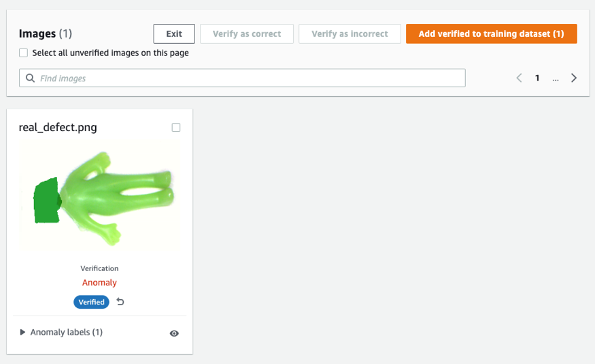

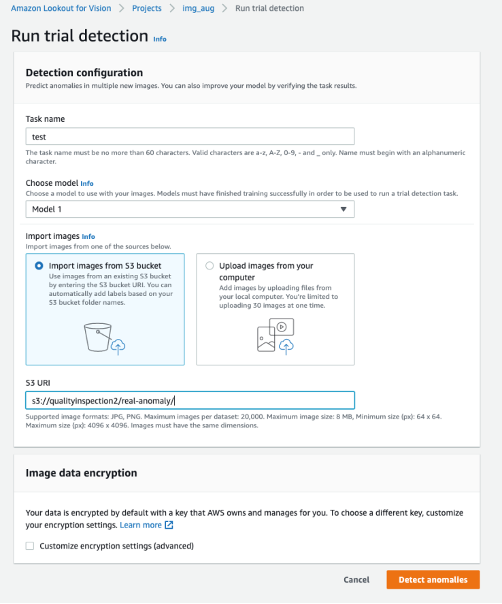

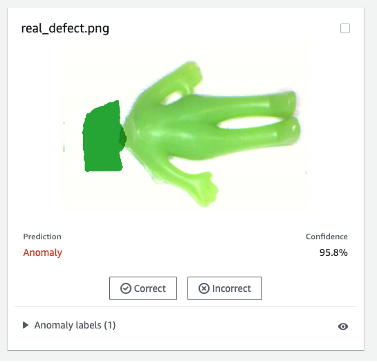

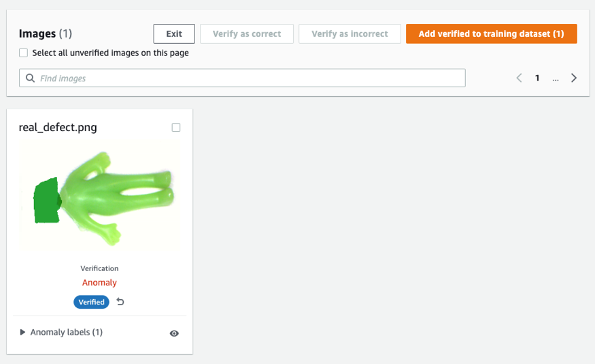

دوسرا، ہم ماڈل کو حقیقی خرابی کے خلاف جانچنے کے لیے Lookout for Vision میں آزمائشی پتہ لگانے کا استعمال کرتے ہیں۔ آپ یا تو ٹیسٹ امیجز کو S3 بالٹی میں محفوظ کر سکتے ہیں اور انہیں Amazon S3 سے امپورٹ کر سکتے ہیں یا اپنے کمپیوٹر سے تصاویر اپ لوڈ کر سکتے ہیں۔ پھر، منتخب کریں بے ضابطگیوں کا پتہ لگائیں۔ پتہ چلانے کے لیے۔

آخر میں، آپ حقیقی عیب کی پیشین گوئی کا نتیجہ دیکھ سکتے ہیں۔ مصنوعی نقائص پر تربیت یافتہ ماڈل اس تجربے میں حقیقی عیب کو درست طریقے سے نکال سکتا ہے۔

مصنوعی نقائص پر تربیت یافتہ ماڈل حقیقی نقائص پر ہمیشہ اچھی کارکردگی کا مظاہرہ نہیں کر سکتا، خاص طور پر سرکٹ بورڈ جو اس نمونہ ڈیٹاسیٹ سے کہیں زیادہ پیچیدہ ہیں۔ اگر آپ اصلی نقائص کے ساتھ ماڈل کو دوبارہ تربیت دینا چاہتے ہیں، تو آپ اورنج بٹن کا لیبل لگا کر منتخب کر سکتے ہیں۔ مشین کی پیشین گوئیوں کی تصدیق کریں۔ پیشن گوئی کے نتیجے کے اوپری دائیں کونے میں، اور پھر اسے بطور چیک کریں۔ درست or غلط.

اس کے بعد آپ ماڈل کی کارکردگی کو بڑھانے کے لیے اوپری دائیں کونے میں نارنجی بٹن کو منتخب کر کے تربیتی ڈیٹاسیٹ میں تصدیق شدہ تصویر اور لیبل شامل کر سکتے ہیں۔

7. لاگت کا تخمینہ

Lookout for Vision کے لیے یہ امیج بڑھانے والی پائپ لائن بہت سستی ہے۔ اوپر دکھائی گئی مثال میں، ایمیزون سیج میکر گراؤنڈ ٹروتھ لیبلنگ، ایمیزون سیج میکر نوٹ بک، اور سیج میکر غیر مطابقت پذیر اختتامی نقطہ کی تعیناتی اور تخمینہ کی قیمت صرف چند ڈالر ہے۔ Lookout for Vision سروس کے لیے، آپ صرف وہی ادائیگی کرتے ہیں جو آپ استعمال کرتے ہیں۔ تین اجزاء ہیں جو آپ کے بل کا تعین کرتے ہیں: ماڈل کی تربیت کے لیے چارجز (تربیت کے اوقات)، کلاؤڈ پر بے ضابطگیوں کا پتہ لگانے کے لیے چارجز (کلاؤڈ انفرنس اوقات)، اور/یا کنارے پر بے ضابطگیوں کا پتہ لگانے کے لیے چارجز (ایج انفرنس یونٹس)۔ ہمارے تجربے میں، Lookout for Vision ماڈل نے تربیت مکمل کرنے میں ایک گھنٹے سے تھوڑا زیادہ وقت لیا، اور اس کی لاگت فی تربیتی گھنٹہ $2.00 ہے۔ مزید برآں، آپ کلاؤڈ یا کنارے پر درج قیمت کے ساتھ اندازہ لگانے کے لیے تربیت یافتہ ماڈل استعمال کر سکتے ہیں۔ یہاں.

8. صاف کریں

غیر ضروری چارجز سے بچنے کے لیے، پوسٹ میں مشقیں چلاتے ہوئے آپ نے جو اینڈ پوائنٹس اور وسائل بنائے تھے ان کو حذف کرنے کے لیے کنسول کا استعمال کریں۔

- سیج میکر کنسول کھولیں اور درج ذیل وسائل کو حذف کریں:

- اختتامی نقطہ۔ اختتامی نقطہ کو حذف کرنے سے ایم ایل کمپیوٹ مثال یا اس کی حمایت کرنے والی مثالیں بھی حذف ہوجاتی ہیں۔

- کے تحت ارادہمنتخب کریں اختتامی نکات.

- اس اختتامی نقطہ کو منتخب کریں جو آپ نے مثال میں بنایا ہے، منتخب کریں۔ عوامل، اور پھر منتخب کریں خارج کر دیں.

- اختتامی نقطہ کی ترتیب۔

- کے تحت ارادہمنتخب کریں اختتامی نقطہ کی تشکیلات.

- اختتامی نقطہ کی ترتیب کو منتخب کریں جو آپ نے مثال میں بنائی ہے، منتخب کریں۔ عوامل، اور پھر منتخب کریں خارج کر دیں.

- نمونہ.

- کے تحت ارادہمنتخب کریں ماڈل.

- اس ماڈل کو منتخب کریں جو آپ نے مثال میں بنایا ہے، منتخب کریں۔ عوامل، اور پھر منتخب کریں خارج کر دیں.

- نوٹ بک کی مثال۔ نوٹ بک مثال کو حذف کرنے سے پہلے، اسے روک دیں۔

- کے تحت نوٹ بکمنتخب کریں نوٹ بک کی مثالیں۔.

- نوٹ بک مثال کا انتخاب کریں جسے آپ نے مثال میں بنایا ہے، منتخب کریں۔ عوامل، اور پھر منتخب کریں بند کرو. نوٹ بک مثال کو رکنے میں کئی منٹ لگتے ہیں۔ جب درجہ میں تبدیلیاں روک دیا، اگلے مرحلے پر آگے بڑھیں۔

- میں سے انتخاب کریں عوامل، اور پھر منتخب کریں خارج کر دیں.

- کھولو ایمیزون S3 کنسول، اور پھر اس بالٹی کو حذف کریں جو آپ نے ماڈل نمونے اور تربیتی ڈیٹاسیٹ کو ذخیرہ کرنے کے لیے بنایا تھا۔

- کھولو ایمیزون کلاؤڈ واچ کنسول، اور پھر ان تمام لاگ گروپس کو حذف کریں جن کے نام سے شروع ہوتے ہیں۔

/aws/sagemaker/.

آپ درج ذیل کوڈ کو چلا کر SageMaker نوٹ بک سے اینڈ پوائنٹ کو بھی حذف کر سکتے ہیں۔

import boto3

sm_boto3 = boto3.client("sagemaker")

sm_boto3.delete_endpoint(EndpointName='endpoint name')

9. نتیجہ

اس پوسٹ میں، ہم نے دکھایا کہ ایمیزون سیج میکر گراؤنڈ ٹروتھ کا استعمال کرتے ہوئے مصنوعی نقائص کے ماسک کی تشریح کیسے کی جاتی ہے، ایک عام تصویر کو مطلوبہ تعداد میں نارمل امیجز میں تبدیل کرنے کے لیے مختلف امیج بڑھانے کی تکنیکوں کا استعمال کیسے کیا جاتا ہے، ایک غیر مطابقت پذیر سیج میکر اینڈ پوائنٹ بنایا جاتا ہے اور اس کے لیے ان پٹ فائل تیار کی جاتی ہے۔ اختتامی نقطہ کے ساتھ ساتھ اختتامی نقطہ کو بھی طلب کریں۔ آخر میں، ہم نے ظاہر کیا کہ کس طرح ٹرین/ٹیسٹ مینی فیسٹ کو استعمال کرنے کے لیے ایک Lookout for Vision anomaly لوکلائزیشن ماڈل کو تربیت دی جائے۔ مصنوعی نقائص پیدا کرنے کے لیے اس مجوزہ پائپ لائن کو دوسرے ML ماڈلز تک بڑھایا جا سکتا ہے، اور آپ کو صرف SageMaker اینڈ پوائنٹ میں ماڈل اور انفرنس کوڈ کو اپنی مرضی کے مطابق کرنے کی ضرورت ہے۔

خودکار معیار کے معائنے کے لیے Lookout for Vision کو دریافت کرکے شروع کریں۔ یہاں.

مصنفین کے بارے میں

کارا یانگ AWS پروفیشنل سروسز میں ڈیٹا سائنٹسٹ ہے۔ وہ AWS کلاؤڈ سروسز کے ساتھ صارفین کو ان کے کاروباری اہداف حاصل کرنے میں مدد کرنے کے بارے میں پرجوش ہے اور اس نے تنظیموں کو متعدد صنعتوں جیسے مینوفیکچرنگ، آٹوموٹیو، ماحولیاتی پائیداری اور ایرو اسپیس میں اینڈ ٹو اینڈ AI/ML حل تیار کرنے میں مدد کی ہے۔

کارا یانگ AWS پروفیشنل سروسز میں ڈیٹا سائنٹسٹ ہے۔ وہ AWS کلاؤڈ سروسز کے ساتھ صارفین کو ان کے کاروباری اہداف حاصل کرنے میں مدد کرنے کے بارے میں پرجوش ہے اور اس نے تنظیموں کو متعدد صنعتوں جیسے مینوفیکچرنگ، آٹوموٹیو، ماحولیاتی پائیداری اور ایرو اسپیس میں اینڈ ٹو اینڈ AI/ML حل تیار کرنے میں مدد کی ہے۔

اوکٹاوی اوبیولز سیلز ایک کمپیوٹیشنل سائنسدان ہے جو ڈیپ لرننگ (DL) اور مشین لرننگ میں مہارت رکھتا ہے جسے ایسوسی ایٹ سلوشنز آرکیٹیکٹ کے طور پر سند یافتہ ہے۔ کلاؤڈ اور ایج دونوں میں وسیع علم کے ساتھ، وہ اینڈ ٹو اینڈ AI سلوشنز بنانے کے ذریعے کاروباری نتائج کو تیز کرنے میں مدد کرتا ہے۔ Octavi نے کیلیفورنیا یونیورسٹی، Irvine میں کمپیوٹیشنل سائنس میں پی ایچ ڈی کی ڈگری حاصل کی، جہاں اس نے DL+HPC الگورتھم میں جدید ترین مہارت کو آگے بڑھایا۔

اوکٹاوی اوبیولز سیلز ایک کمپیوٹیشنل سائنسدان ہے جو ڈیپ لرننگ (DL) اور مشین لرننگ میں مہارت رکھتا ہے جسے ایسوسی ایٹ سلوشنز آرکیٹیکٹ کے طور پر سند یافتہ ہے۔ کلاؤڈ اور ایج دونوں میں وسیع علم کے ساتھ، وہ اینڈ ٹو اینڈ AI سلوشنز بنانے کے ذریعے کاروباری نتائج کو تیز کرنے میں مدد کرتا ہے۔ Octavi نے کیلیفورنیا یونیورسٹی، Irvine میں کمپیوٹیشنل سائنس میں پی ایچ ڈی کی ڈگری حاصل کی، جہاں اس نے DL+HPC الگورتھم میں جدید ترین مہارت کو آگے بڑھایا۔

Fabian Benitez-Quiroz AWS پروفیشنل سروسز میں IoT Edge ڈیٹا سائنٹسٹ ہے۔ انہوں نے اوہائیو اسٹیٹ یونیورسٹی سے کمپیوٹر وژن اور پیٹرن ریکگنیشن میں پی ایچ ڈی کی ڈگری حاصل کی۔ Fabian صارفین کو IoT آلات اور کلاؤڈ میں کم تاخیر کے ساتھ اپنے مشین لرننگ ماڈل چلانے میں مدد کرنے میں شامل ہے۔

Fabian Benitez-Quiroz AWS پروفیشنل سروسز میں IoT Edge ڈیٹا سائنٹسٹ ہے۔ انہوں نے اوہائیو اسٹیٹ یونیورسٹی سے کمپیوٹر وژن اور پیٹرن ریکگنیشن میں پی ایچ ڈی کی ڈگری حاصل کی۔ Fabian صارفین کو IoT آلات اور کلاؤڈ میں کم تاخیر کے ساتھ اپنے مشین لرننگ ماڈل چلانے میں مدد کرنے میں شامل ہے۔

منیش تلریجا AWS میں IoT سلوشنز کے لیے پرنسپل پروڈکٹ مینیجر ہیں۔ وہ کلاؤڈ میں اور کنارے پر AWS IoT اور ML سروسز کا استعمال کرتے ہوئے جدید حل تیار کرنے میں صارفین کی مدد کرنے کا پرجوش ہے۔

منیش تلریجا AWS میں IoT سلوشنز کے لیے پرنسپل پروڈکٹ مینیجر ہیں۔ وہ کلاؤڈ میں اور کنارے پر AWS IoT اور ML سروسز کا استعمال کرتے ہوئے جدید حل تیار کرنے میں صارفین کی مدد کرنے کا پرجوش ہے۔

یوکسین یانگ AWS میں ایک AI/ML معمار ہے، جو AWS مشین لرننگ اسپیشلٹی میں تصدیق شدہ ہے۔ وہ صارفین کو اس قابل بناتی ہے کہ وہ اینڈ ٹو اینڈ AI/ML حل تیار کر کے اپنے نتائج کو تیز کر سکیں، بشمول پیشین گوئی کی دیکھ بھال، کمپیوٹر ویژن اور کمک سیکھنے۔ Yuxin نے اسٹینفورڈ یونیورسٹی سے اپنا MS حاصل کیا، جہاں اس نے گہری سیکھنے اور ڈیٹا کے بڑے تجزیات پر توجہ مرکوز کی۔

یوکسین یانگ AWS میں ایک AI/ML معمار ہے، جو AWS مشین لرننگ اسپیشلٹی میں تصدیق شدہ ہے۔ وہ صارفین کو اس قابل بناتی ہے کہ وہ اینڈ ٹو اینڈ AI/ML حل تیار کر کے اپنے نتائج کو تیز کر سکیں، بشمول پیشین گوئی کی دیکھ بھال، کمپیوٹر ویژن اور کمک سیکھنے۔ Yuxin نے اسٹینفورڈ یونیورسٹی سے اپنا MS حاصل کیا، جہاں اس نے گہری سیکھنے اور ڈیٹا کے بڑے تجزیات پر توجہ مرکوز کی۔

ینگ ماو ٹموتھی لی AWS کے ساتھ ڈیٹا سائنٹسٹ ہے۔ اس نے 11 ماہ قبل AWS میں شمولیت اختیار کی ہے اور وہ صارفین کے متنوع سیٹ کے لیے حل تیار کرنے کے لیے خدمات اور مشین لرننگ ٹیکنالوجیز کی ایک وسیع رینج کے ساتھ کام کرتا ہے۔ انہوں نے الیکٹریکل انجینئرنگ میں پی ایچ ڈی کی ہے۔ اپنے فارغ وقت میں، وہ آؤٹ ڈور گیمز، کار ریسنگ، تیراکی، اور ایک پائپر کب اڑانے سے ملک کو پار کرنے اور آسمان کی سیر کرنے سے لطف اندوز ہوتا ہے۔

ینگ ماو ٹموتھی لی AWS کے ساتھ ڈیٹا سائنٹسٹ ہے۔ اس نے 11 ماہ قبل AWS میں شمولیت اختیار کی ہے اور وہ صارفین کے متنوع سیٹ کے لیے حل تیار کرنے کے لیے خدمات اور مشین لرننگ ٹیکنالوجیز کی ایک وسیع رینج کے ساتھ کام کرتا ہے۔ انہوں نے الیکٹریکل انجینئرنگ میں پی ایچ ڈی کی ہے۔ اپنے فارغ وقت میں، وہ آؤٹ ڈور گیمز، کار ریسنگ، تیراکی، اور ایک پائپر کب اڑانے سے ملک کو پار کرنے اور آسمان کی سیر کرنے سے لطف اندوز ہوتا ہے۔

کارا یانگ AWS پروفیشنل سروسز میں ڈیٹا سائنٹسٹ ہے۔ وہ AWS کلاؤڈ سروسز کے ساتھ صارفین کو ان کے کاروباری اہداف حاصل کرنے میں مدد کرنے کے بارے میں پرجوش ہے اور اس نے تنظیموں کو متعدد صنعتوں جیسے مینوفیکچرنگ، آٹوموٹیو، ماحولیاتی پائیداری اور ایرو اسپیس میں اینڈ ٹو اینڈ AI/ML حل تیار کرنے میں مدد کی ہے۔

کارا یانگ AWS پروفیشنل سروسز میں ڈیٹا سائنٹسٹ ہے۔ وہ AWS کلاؤڈ سروسز کے ساتھ صارفین کو ان کے کاروباری اہداف حاصل کرنے میں مدد کرنے کے بارے میں پرجوش ہے اور اس نے تنظیموں کو متعدد صنعتوں جیسے مینوفیکچرنگ، آٹوموٹیو، ماحولیاتی پائیداری اور ایرو اسپیس میں اینڈ ٹو اینڈ AI/ML حل تیار کرنے میں مدد کی ہے۔ اوکٹاوی اوبیولز سیلز ایک کمپیوٹیشنل سائنسدان ہے جو ڈیپ لرننگ (DL) اور مشین لرننگ میں مہارت رکھتا ہے جسے ایسوسی ایٹ سلوشنز آرکیٹیکٹ کے طور پر سند یافتہ ہے۔ کلاؤڈ اور ایج دونوں میں وسیع علم کے ساتھ، وہ اینڈ ٹو اینڈ AI سلوشنز بنانے کے ذریعے کاروباری نتائج کو تیز کرنے میں مدد کرتا ہے۔ Octavi نے کیلیفورنیا یونیورسٹی، Irvine میں کمپیوٹیشنل سائنس میں پی ایچ ڈی کی ڈگری حاصل کی، جہاں اس نے DL+HPC الگورتھم میں جدید ترین مہارت کو آگے بڑھایا۔

اوکٹاوی اوبیولز سیلز ایک کمپیوٹیشنل سائنسدان ہے جو ڈیپ لرننگ (DL) اور مشین لرننگ میں مہارت رکھتا ہے جسے ایسوسی ایٹ سلوشنز آرکیٹیکٹ کے طور پر سند یافتہ ہے۔ کلاؤڈ اور ایج دونوں میں وسیع علم کے ساتھ، وہ اینڈ ٹو اینڈ AI سلوشنز بنانے کے ذریعے کاروباری نتائج کو تیز کرنے میں مدد کرتا ہے۔ Octavi نے کیلیفورنیا یونیورسٹی، Irvine میں کمپیوٹیشنل سائنس میں پی ایچ ڈی کی ڈگری حاصل کی، جہاں اس نے DL+HPC الگورتھم میں جدید ترین مہارت کو آگے بڑھایا۔ Fabian Benitez-Quiroz AWS پروفیشنل سروسز میں IoT Edge ڈیٹا سائنٹسٹ ہے۔ انہوں نے اوہائیو اسٹیٹ یونیورسٹی سے کمپیوٹر وژن اور پیٹرن ریکگنیشن میں پی ایچ ڈی کی ڈگری حاصل کی۔ Fabian صارفین کو IoT آلات اور کلاؤڈ میں کم تاخیر کے ساتھ اپنے مشین لرننگ ماڈل چلانے میں مدد کرنے میں شامل ہے۔

Fabian Benitez-Quiroz AWS پروفیشنل سروسز میں IoT Edge ڈیٹا سائنٹسٹ ہے۔ انہوں نے اوہائیو اسٹیٹ یونیورسٹی سے کمپیوٹر وژن اور پیٹرن ریکگنیشن میں پی ایچ ڈی کی ڈگری حاصل کی۔ Fabian صارفین کو IoT آلات اور کلاؤڈ میں کم تاخیر کے ساتھ اپنے مشین لرننگ ماڈل چلانے میں مدد کرنے میں شامل ہے۔

یوکسین یانگ AWS میں ایک AI/ML معمار ہے، جو AWS مشین لرننگ اسپیشلٹی میں تصدیق شدہ ہے۔ وہ صارفین کو اس قابل بناتی ہے کہ وہ اینڈ ٹو اینڈ AI/ML حل تیار کر کے اپنے نتائج کو تیز کر سکیں، بشمول پیشین گوئی کی دیکھ بھال، کمپیوٹر ویژن اور کمک سیکھنے۔ Yuxin نے اسٹینفورڈ یونیورسٹی سے اپنا MS حاصل کیا، جہاں اس نے گہری سیکھنے اور ڈیٹا کے بڑے تجزیات پر توجہ مرکوز کی۔

یوکسین یانگ AWS میں ایک AI/ML معمار ہے، جو AWS مشین لرننگ اسپیشلٹی میں تصدیق شدہ ہے۔ وہ صارفین کو اس قابل بناتی ہے کہ وہ اینڈ ٹو اینڈ AI/ML حل تیار کر کے اپنے نتائج کو تیز کر سکیں، بشمول پیشین گوئی کی دیکھ بھال، کمپیوٹر ویژن اور کمک سیکھنے۔ Yuxin نے اسٹینفورڈ یونیورسٹی سے اپنا MS حاصل کیا، جہاں اس نے گہری سیکھنے اور ڈیٹا کے بڑے تجزیات پر توجہ مرکوز کی۔ ینگ ماو ٹموتھی لی AWS کے ساتھ ڈیٹا سائنٹسٹ ہے۔ اس نے 11 ماہ قبل AWS میں شمولیت اختیار کی ہے اور وہ صارفین کے متنوع سیٹ کے لیے حل تیار کرنے کے لیے خدمات اور مشین لرننگ ٹیکنالوجیز کی ایک وسیع رینج کے ساتھ کام کرتا ہے۔ انہوں نے الیکٹریکل انجینئرنگ میں پی ایچ ڈی کی ہے۔ اپنے فارغ وقت میں، وہ آؤٹ ڈور گیمز، کار ریسنگ، تیراکی، اور ایک پائپر کب اڑانے سے ملک کو پار کرنے اور آسمان کی سیر کرنے سے لطف اندوز ہوتا ہے۔

ینگ ماو ٹموتھی لی AWS کے ساتھ ڈیٹا سائنٹسٹ ہے۔ اس نے 11 ماہ قبل AWS میں شمولیت اختیار کی ہے اور وہ صارفین کے متنوع سیٹ کے لیے حل تیار کرنے کے لیے خدمات اور مشین لرننگ ٹیکنالوجیز کی ایک وسیع رینج کے ساتھ کام کرتا ہے۔ انہوں نے الیکٹریکل انجینئرنگ میں پی ایچ ڈی کی ہے۔ اپنے فارغ وقت میں، وہ آؤٹ ڈور گیمز، کار ریسنگ، تیراکی، اور ایک پائپر کب اڑانے سے ملک کو پار کرنے اور آسمان کی سیر کرنے سے لطف اندوز ہوتا ہے۔