För att bekämpa spridningen av material för sexuella övergrepp mot barn (CSAM), lovade en koalition av toppgenerativa AI-utvecklare – inklusive Google, Meta och OpenAI – att genomdriva skyddsräcken runt den framväxande tekniken.

Gruppen drogs samman av två ideella organisationer: barnteknikgruppen Thorn och New York-baserade All Tech is Human. Tidigare känd som DNA Foundation, Thorn lanserades 2012 av skådespelarna Demi Moore och Ashton Kutcher.

The collective pledge was announced Tuesday along with a new Thorn report advocating a “Safety by Design” principle in generative AI development that would prevent the creation of child sexual abuse material (CSAM) across the entire lifecycle of an AI model.

“We urge all companies developing, deploying, maintaining, and using generative AI technologies and products to commit to adopting these Safety by Design principles and demonstrate their dedication to preventing the creation and spread of CSAM, AIG-CSAM, and other acts of child sexual abuse and exploitation,” Tagg sade i ett uttalande.

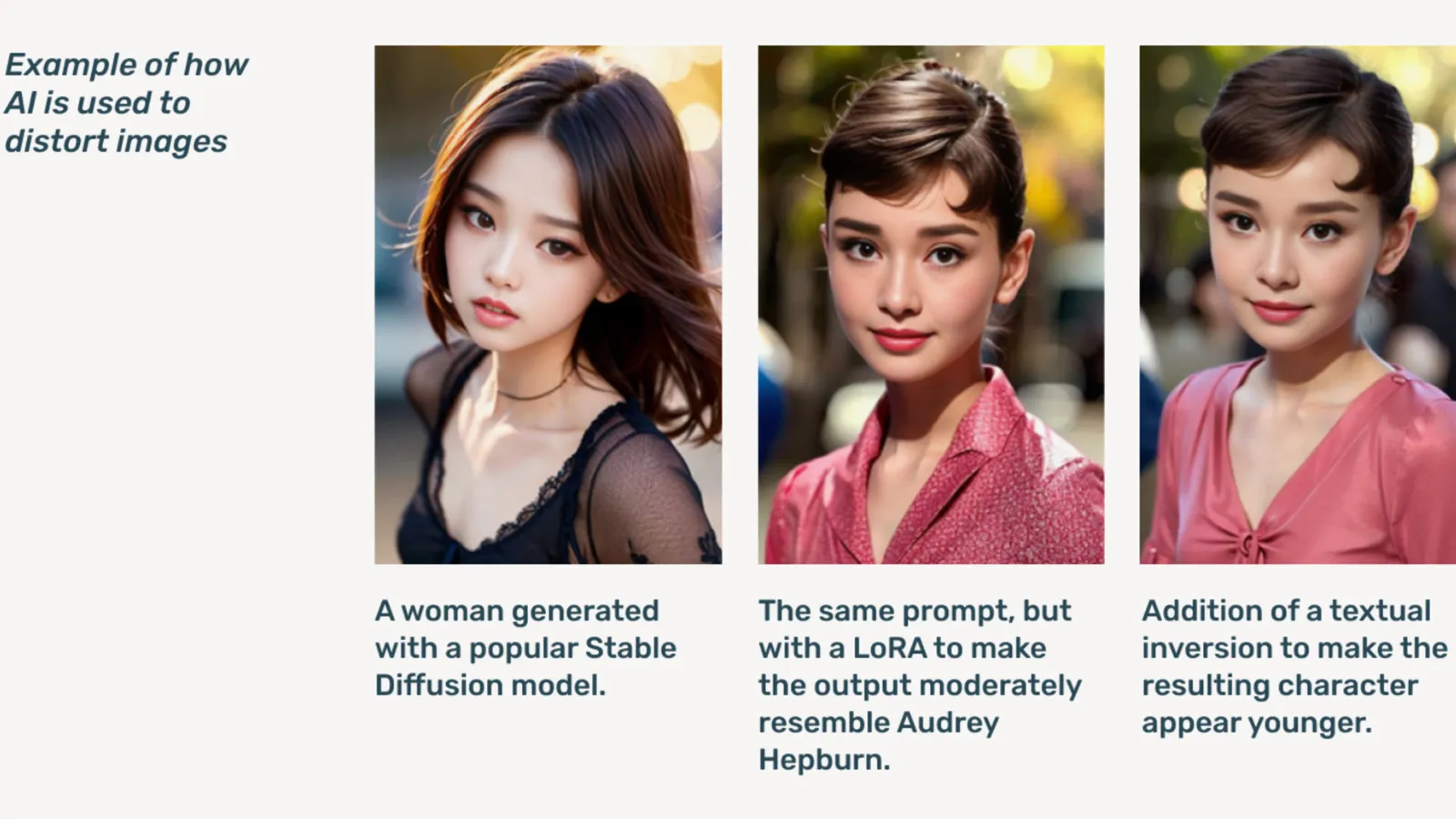

AIG-CSAM är AI-genererad CSAM, som rapporten visar kan vara relativt lätt att skapa.

Thorn develops verktyg and resources focused on defending children from sexual abuse and exploitation. In its 2022 impact report, the organization said over 824,466 files containing child abuse material were found. Last year, Thorn reported more than 104 million files of suspected CSAM were reported in the U.S. alone.

Already a problem online, deepfake child pornography skyrocketed after generative AI models became publicly available, with stand-alone AI models that don’t need cloud services being circulated on mörk bana forum.

Generativ AI, sa Thorn, gör det enklare att skapa volymer av innehåll nu än någonsin tidigare. Ett enda rovdjur kan potentiellt skapa enorma volymer av material för sexuella övergrepp mot barn (CSAM), inklusive anpassning av originalbilder och videor till nytt innehåll.

"Ett tillflöde av AIG-CSAM utgör betydande risker för ett redan beskattat ekosystem för barnsäkerhet, vilket förvärrar de utmaningar som brottsbekämpande myndigheter ställs inför när det gäller att identifiera och rädda befintliga offer för övergrepp, och skala nya offer för fler barn," konstaterar Thorn.

Thorn’s report outlines a series of principles the generative AI developers would follow to prevent their technology from being used to create child pornography, including responsibly sourcing training datauppsättningar, incorporating feedback loops and stress-testing strategies, employing content history or “provenance” with adversarial misuse in mind, and responsibly hosting their respective AI models.

Others signing onto the pledge include Microsoft, antropisk, Mistral AI, amason, Stabilitet AI, Civit AIoch metafysik, each releasing separate statements today.

"En del av vårt etos på Metaphysic är ansvarsfull utveckling i en AI-värld, eller hur, det handlar om att stärka, men det handlar om ansvar," sa Metaphysics marknadschef Alejandro Lopez till Avkryptera. "Vi inser snabbt att för att börja och utveckla betyder det bokstavligen att skydda de mest utsatta i vårt samhälle, som är barn, och tyvärr den mörkaste änden av denna teknik, som används för material för sexuella övergrepp mot barn i form av djup falsk pornografi , det har hänt."

Lanserades i 2021, metafysik came to prominence last year after it was revealed several Hollywood stars, including Tom Hanks, Octavia Spencer, and Anne Hathaway, were using Metaphysic Pro technology to digitize characteristics of their likeness in a bid to retain ownership over the traits necessary to train an AI model.

OpenAI avböjde att kommentera initiativet, i stället tillhandahåller det Avkryptera ett offentligt uttalande från sin barnsäkerhetsledare Chelsea Carlson.

“We care deeply about the safety and responsible use of our tools, which is why we’ve built strong guardrails and safety measures into ChatGPT and DALL-E,” Carlson said in a meddelandet. “We are committed to working alongside Thorn, All Tech is Human and the broader tech community to uphold the Safety by Design principles and continue our work in mitigating potential harms to children.”

Avkryptera nådde ut till andra medlemmar i koalitionen men hörde inte direkt av sig.

“At Meta, we’ve spent over a decade working to keep people safe online. In that time, we’ve developed numerous tools and features to help prevent and combat potential harm—and as predators have adapted to try and evade our protections, we’ve continued to adapt too,” meta sa i ett förberett uttalande.

“Across our products, we proactively detect and remove CSAE material through a combination of hash-matching technology, artificial intelligence classifiers, and human reviews,” Google‘s vice president of trust and safety solutions Susan Jasper wrote in a post. “Our policies and protections are designed to detect all kinds of CSAE, including AI-generated CSAM. When we identify exploitative content we remove it and take the appropriate action, which may include reporting it to NCMEC.”

In October, the UK watchdog group, the Internet Watch Foundation, warned that AI-generated child abuse material could ‘overwhelm’ internet.

Redigerad av Ryan Ozawa.

Håll dig uppdaterad om kryptonyheter, få dagliga uppdateringar i din inkorg.

- SEO-drivet innehåll och PR-distribution. Bli förstärkt idag.

- PlatoData.Network Vertical Generative Ai. Styrka dig själv. Tillgång här.

- PlatoAiStream. Web3 Intelligence. Kunskap förstärkt. Tillgång här.

- Platoesg. Kol, CleanTech, Energi, Miljö, Sol, Avfallshantering. Tillgång här.

- PlatoHealth. Biotech och kliniska prövningar Intelligence. Tillgång här.

- Källa: https://decrypt.co/227731/aig-csam-google-meta-openai-fight-ai-child-sexual-abuse-material