Чтобы бороться с распространением материалов о сексуальном насилии над детьми (CSAM), коалиция ведущих разработчиков генеративного искусственного интеллекта, в том числе Google, Meta и OpenAI, пообещала усилить барьеры вокруг новой технологии.

Группу объединили две некоммерческие организации: детская техническая группа Thorn и базирующаяся в Нью-Йорке All Tech is Human. Ранее известный как Фонд ДНК, Thorn был основан в 2012 году актерами Деми Мур и Эштоном Катчером.

Коллективное обещание было объявлено во вторник вместе с новым Отчет Торна пропаганда принципа «Безопасность за счет дизайна» при разработке генеративного ИИ, который предотвратит создание материалов о сексуальном насилии над детьми (CSAM) на протяжении всего жизненного цикла модели ИИ.

«Мы призываем все компании, разрабатывающие, внедряющие, поддерживающие и использующие генеративные технологии и продукты искусственного интеллекта, взять на себя обязательство принять эти принципы «Безопасность за счет дизайна» и продемонстрировать свою приверженность предотвращению создания и распространения CSAM, AIG-CSAM и других актов сексуального насилия над детьми. злоупотребления и эксплуатация», колючка говорится в заявлении.

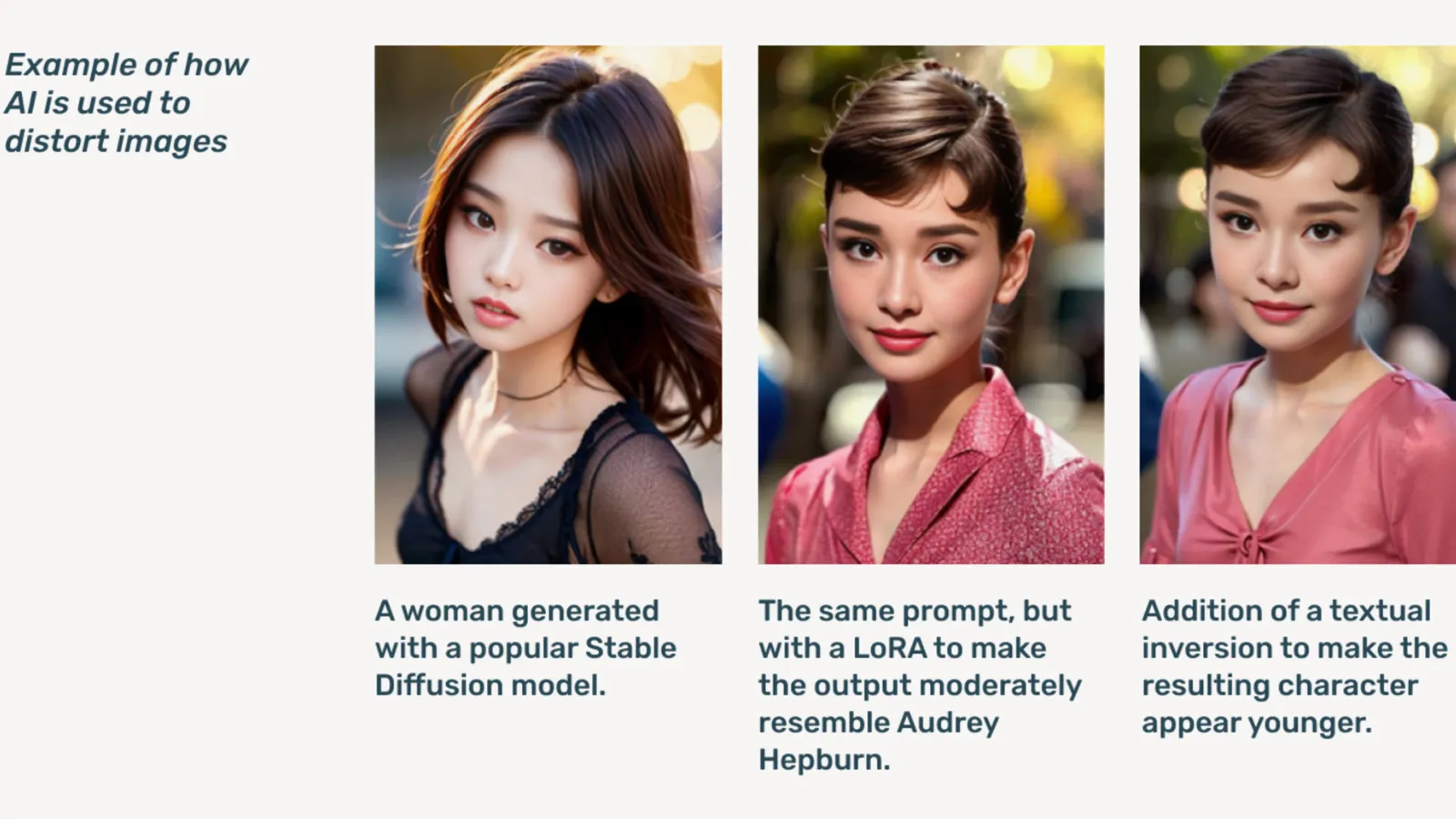

AIG-CSAM — это CSAM, сгенерированный искусственным интеллектом, который, как показано в отчете, создать относительно легко.

Торн разрабатывает инструменты и ресурсы, направленные на защиту детей от сексуального насилия и эксплуатации. В своем отчете о последствиях за 2022 год организация сообщила, что было обнаружено более 824,466 104 файлов, содержащих материалы о жестоком обращении с детьми. В прошлом году Торн сообщил, что только в США было зарегистрировано более XNUMX миллионов файлов с подозрением на CSAM.

Дипфейковая детская порнография, уже ставшая проблемой в Интернете, резко возросла после того, как генеративные модели ИИ стали общедоступными, а автономные модели ИИ, не нуждающиеся в распространении облачных сервисов, стали общедоступными. Темная паутина форумах.

По словам Торна, генеративный искусственный интеллект сегодня делает создание больших объемов контента проще, чем когда-либо прежде. Один-единственный детский хищник потенциально может создать огромные объемы материалов о сексуальном насилии над детьми (CSAM), включая адаптацию оригинальных изображений и видео в новый контент.

«Приток AIG-CSAM создает значительные риски для и без того обремененной налогами экосистемы безопасности детей, усугубляя проблемы, с которыми сталкиваются правоохранительные органы при выявлении и спасении существующих жертв насилия, а также масштабируя новые виктимизации большего числа детей», — отмечает Торн.

В отчете Торна изложен ряд принципов, которым будут следовать разработчики генеративного ИИ, чтобы предотвратить использование их технологий для создания детской порнографии, включая ответственный подход к подбору обучения. Наборы данных, включая петли обратной связи и стратегии стресс-тестирования, используя историю контента или «происхождение» с учетом состязательного злоупотребления, и ответственно размещая соответствующие модели ИИ.

Другие, подписавшиеся под залог, включают Microsoft, антропный, Мистраль ИИ, Amazon, Стабильность ИИ, Гражданский ИИи Метафизика, каждый из которых сегодня опубликовал отдельные заявления.

«Частью нашего идеала в Metaphysic является ответственное развитие в мире искусственного интеллекта, да, речь идет о расширении прав и возможностей, но речь идет и об ответственности», — сказал директор по маркетингу Metaphys Алехандро Лопес. Decrypt. «Мы быстро осознаем, что начинать и развивать это означает буквально защищать наиболее уязвимых членов нашего общества, то есть детей, и, к сожалению, самый темный конец этой технологии, которая используется для материалов о сексуальном насилии над детьми в форме глубокой фейковой порнографии. , это произошло».

Основанный в 2021 году, Метафизика приобрел известность в прошлом году после того, как выяснилось, что несколько голливудских звезд, в том числе Том Хэнкс, Октавия Спенсер и Энн Хэтэуэй, использовали технологию Metaphyc Pro для оцифровки характеристик своего сходства в попытке сохранить право собственности на черты, необходимые для обучения модели ИИ. .

OpenAI отказалась от дальнейших комментариев по поводу этой инициативы, вместо этого предоставив Decrypt публичное заявление руководителя отдела безопасности детей Челси Карлсон.

«Мы глубоко заботимся о безопасности и ответственном использовании наших инструментов, поэтому мы встроили в ChatGPT и DALL-E надежные ограждения и меры безопасности», — сказал Карлсон в своем сообщении. заявление. «Мы стремимся работать вместе с Thorn, All Tech is Human и более широким технологическим сообществом, чтобы поддерживать принципы «Безопасность благодаря дизайну» и продолжать нашу работу по снижению потенциального вреда для детей».

Decrypt обратился к другим членам Коалиции, но не сразу получил ответ.

«В Meta мы более десяти лет работали над обеспечением безопасности людей в Интернете. За это время мы разработали множество инструментов и функций, помогающих предотвращать потенциальный вред и бороться с ним, и по мере того, как хищники адаптировались, пытаясь обойти нашу защиту, мы тоже продолжали адаптироваться». Мета говорится в подготовленном заявлении.

«Во всех наших продуктах мы активно обнаруживаем и удаляем материалы CSAE с помощью комбинации технологии хеш-сопоставления, классификаторов искусственного интеллекта и отзывов людей». Googleнаписала в своем сообщении вице-президент по решениям доверия и безопасности Сьюзан Джаспер. «Наши политики и средства защиты предназначены для обнаружения всех видов CSAE, включая CSAM, созданный искусственным интеллектом. Когда мы выявляем эксплуататорский контент, мы удаляем его и предпринимаем соответствующие действия, которые могут включать в себя сообщение о нем в NCMEC».

В октябре британская наблюдательная группа The Фонд "Интернет-часы", предупредил, что созданные ИИ материалы о жестоком обращении с детьми могутподавлять' интернет.

Под редакцией Райан Одзава.

Будьте в курсе крипто-новостей, получайте ежедневные обновления на свой почтовый ящик.

- SEO-контент и PR-распределение. Получите усиление сегодня.

- PlatoData.Network Вертикальный генеративный ИИ. Расширьте возможности себя. Доступ здесь.

- ПлатонАйСтрим. Интеллект Web3. Расширение знаний. Доступ здесь.

- ПлатонЭСГ. Углерод, чистые технологии, Энергия, Окружающая среда, Солнечная, Управление отходами. Доступ здесь.

- ПлатонЗдоровье. Биотехнологии и клинические исследования. Доступ здесь.

- Источник: https://decrypt.co/227731/aig-csam-google-meta-openai-fight-ai-child-sexual-abuse-material