Pentru a lupta împotriva răspândirii materialelor de abuz sexual asupra copiilor (CSAM), o coaliție de dezvoltatori de inteligență artificială generativă de top, inclusiv Google, Meta și OpenAI, a promis să impună balustrade în jurul tehnologiei emergente.

Grupul a fost reunit de două organizații non-profit: grupul de tehnologie pentru copii Thorn și All Tech is Human, cu sediul în New York. Cunoscută anterior ca Fundația DNA, Thorn a fost lansată în 2012 de actorii Demi Moore și Ashton Kutcher.

Angajamentul colectiv a fost anunțat marți împreună cu un nou Raportul Thorn susținând un principiu „Siguranță prin proiectare” în dezvoltarea generativă a IA, care ar preveni crearea de material de abuz sexual asupra copiilor (CSAM) pe întregul ciclu de viață al unui model de IA.

„Îndemnăm toate companiile care dezvoltă, desfășoară, întrețin și utilizează tehnologii și produse AI generative să se angajeze să adopte aceste principii Safety by Design și să-și demonstreze dedicarea pentru prevenirea creării și răspândirii CSAM, AIG-CSAM și a altor acte sexuale cu copii. abuz și exploatare” Ghimpe a spus într-o declarație.

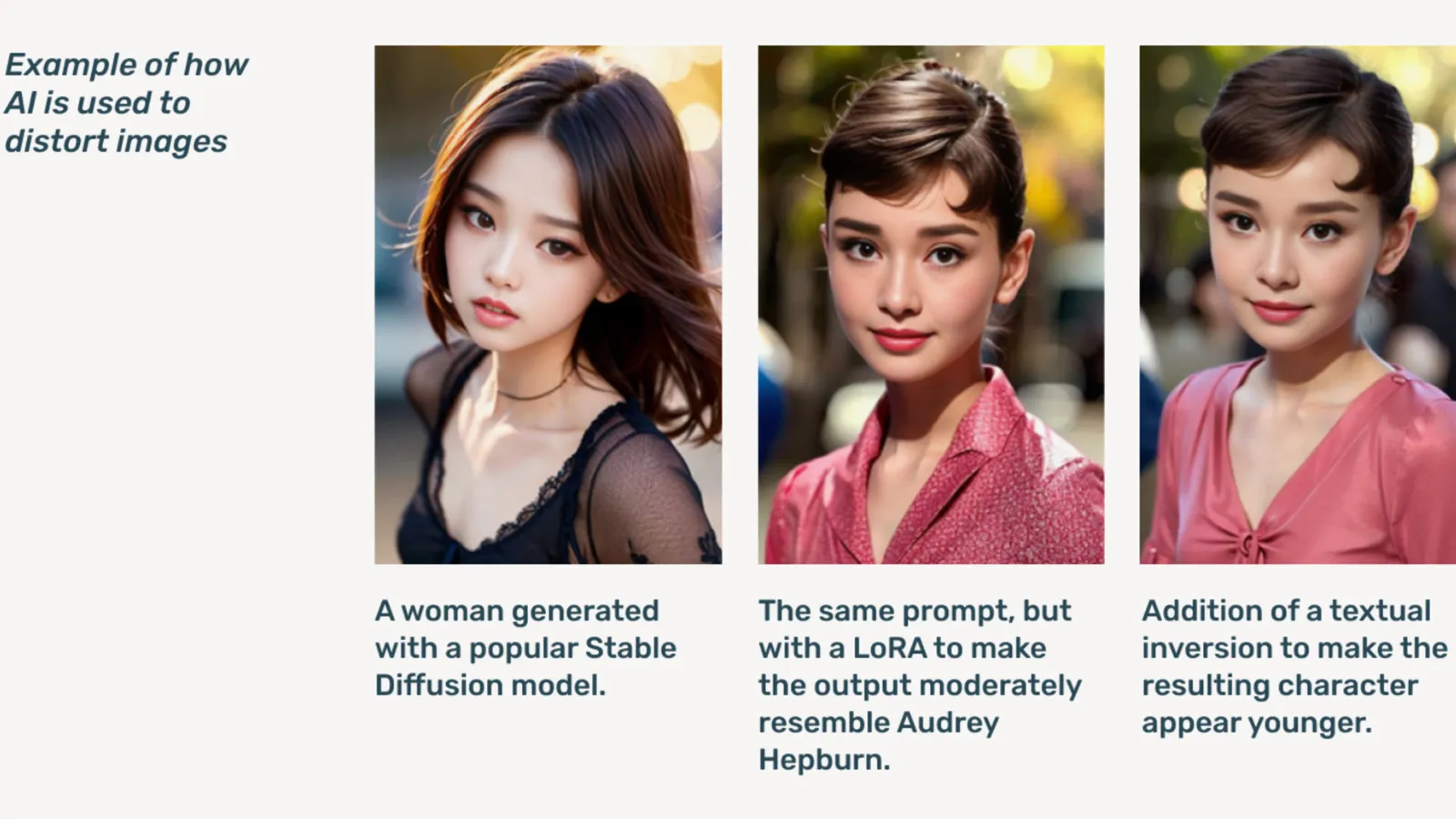

AIG-CSAM este CSAM generat de AI, despre care raportul ilustrează că poate fi relativ ușor de creat.

Thorn se dezvoltă Unelte și resurse concentrate pe apărarea copiilor împotriva abuzului și exploatării sexuale. În raportul său de impact din 2022, organizația a spus că au fost găsite peste 824,466 de fișiere care conțin materiale de abuz asupra copiilor. Anul trecut, Thorn a raportat că peste 104 milioane de fișiere cu suspecte de CSAM au fost raportate numai în SUA.

Deja o problemă online, pornografia infantilă deepfake a crescut vertiginos după ce modelele AI generative au devenit disponibile public, cu modele AI de sine stătătoare care nu au nevoie de servicii cloud fiind vehiculate. pânza întunecată forumuri.

Inteligența artificială generativă, a spus Thorn, face crearea unor volume de conținut mai ușoară acum decât oricând. Un singur copil prădător ar putea crea volume masive de material de abuz sexual asupra copiilor (CSAM), inclusiv adaptarea imaginilor și videoclipurilor originale în conținut nou.

„Un aflux de AIG-CSAM prezintă riscuri semnificative pentru un ecosistem deja taxat pentru siguranța copiilor, exacerbarea provocărilor cu care se confruntă forțele de ordine în identificarea și salvarea victimelor existente ale abuzului și extinzând o nouă victimizare a mai multor copii”, notează Thorn.

Raportul lui Thorn subliniază o serie de principii pe care dezvoltatorii de IA generativă le-ar urma pentru a preveni utilizarea tehnologiei lor pentru a crea pornografie infantilă, inclusiv formarea de aprovizionare responsabilă. seturi de date, încorporând bucle de feedback și strategii de testare a stresului, utilizând istoricul conținutului sau „proveniența” având în vedere utilizarea greșită a adversarilor și găzduind în mod responsabil modelele AI respective.

Alții care semnează angajamentul includ Microsoft, antropic, Mistral AI, Amazon, Stabilitate AI, Civit AI, și Metafizică, fiecare lansând astăzi declarații separate.

„O parte din etosul nostru la Metaphysic este dezvoltarea responsabilă într-o lume AI, corect, este vorba despre împuternicire, dar este despre responsabilitate”, a spus directorul de marketing al Metaphysic, Alejandro Lopez. decriptaţi. „Recunoaștem rapid că a începe și a dezvolta asta înseamnă literalmente protejarea celor mai vulnerabili din societatea noastră, care sunt copiii și, din păcate, cel mai întunecat capăt al acestei tehnologii, care este folosită pentru materiale de abuz sexual asupra copiilor sub formă de pornografie falsă profundă. , asta s-a întâmplat.”

Lansat în 2021, Metafizică a devenit proeminentă anul trecut, după ce s-a dezvăluit că mai multe vedete de la Hollywood, inclusiv Tom Hanks, Octavia Spencer și Anne Hathaway, foloseau tehnologia Metaphysic Pro pentru a digitiza caracteristicile asemănării lor, în încercarea de a păstra proprietatea asupra trăsăturilor necesare antrenării unui model AI. .

OpenAI a refuzat să comenteze în continuare inițiativa, oferind în schimb decriptaţi o declarație publică a conducerii sale pentru siguranța copiilor, Chelsea Carlson.

„Ne pasă profund de siguranța și utilizarea responsabilă a instrumentelor noastre, motiv pentru care am construit balustrade puternice și măsuri de siguranță în ChatGPT și DALL-E”, a spus Carlson într-un declaraţie. „Ne angajăm să lucrăm alături de Thorn, All Tech is Human și comunitatea tehnologică mai largă pentru a susține principiile Safety by Design și pentru a ne continua munca de atenuare a potențialelor daune aduse copiilor.”

decriptaţi a contactat alți membri ai Coaliției, dar nu a primit răspuns imediat.

„La Meta, am petrecut peste un deceniu lucrând pentru a menține oamenii în siguranță online. În acea perioadă, am dezvoltat numeroase instrumente și funcții pentru a ajuta la prevenirea și combaterea potențialelor daune - și, pe măsură ce prădătorii s-au adaptat pentru a încerca să susțină protecția noastră, am continuat să ne adaptăm și noi. meta a spus într-o declarație pregătită.

„În produsele noastre, detectăm și eliminăm în mod proactiv materialul CSAE printr-o combinație de tehnologie de potrivire hash, clasificatoare de inteligență artificială și recenzii umane.” GoogleVicepreședintele pentru soluții de încredere și siguranță a lui Susan Jasper a scris într-o postare. „Politicile și protecțiile noastre sunt concepute pentru a detecta toate tipurile de CSAE, inclusiv CSAM generat de AI. Când identificăm conținut care exploatează, îl eliminăm și luăm măsurile corespunzătoare, care pot include raportarea acestuia către NCMEC.”

În octombrie, grupul de supraveghere din Marea Britanie, the Fundația Internet Watch, a avertizat că materialul de abuz asupra copiilor generat de IA ar putea „coplesesc' internetul.

Editat de Ryan Ozawa.

Fiți la curent cu știrile cripto, primiți actualizări zilnice în căsuța dvs. de e-mail.

- Distribuție de conținut bazat pe SEO și PR. Amplifică-te astăzi.

- PlatoData.Network Vertical Generative Ai. Împuterniciți-vă. Accesați Aici.

- PlatoAiStream. Web3 Intelligence. Cunoștințe amplificate. Accesați Aici.

- PlatoESG. carbon, CleanTech, Energie, Mediu inconjurator, Solar, Managementul deșeurilor. Accesați Aici.

- PlatoHealth. Biotehnologie și Inteligență pentru studii clinice. Accesați Aici.

- Sursa: https://decrypt.co/227731/aig-csam-google-meta-openai-fight-ai-child-sexual-abuse-material