As sementes de uma mudança de paradigma de aprendizado de máquina (ML) existem há décadas, mas com a disponibilidade imediata de capacidade de computação escalável, uma proliferação massiva de dados e o rápido avanço das tecnologias de ML, clientes de todos os setores estão transformando seus negócios. Recentemente, aplicativos generativos de IA, como o ChatGPT, capturaram a atenção e a imaginação generalizadas. Estamos realmente em um ponto de inflexão empolgante na adoção generalizada de ML e acreditamos que a maioria das experiências e aplicativos do cliente serão reinventados com IA generativa.

IA e ML têm sido o foco da Amazon há mais de 20 anos, e muitos dos recursos que os clientes usam com a Amazon são impulsionados pelo ML. Nosso mecanismo de recomendações de comércio eletrônico é conduzido por ML; os caminhos que otimizam as rotas robóticas de separação em nossos centros de atendimento são conduzidos pelo ML; e nossa cadeia de suprimentos, previsão e planejamento de capacidade são informados pelo ML. O Prime Air (nossos drones) e a tecnologia de visão computacional no Amazon Go (nossa experiência de varejo físico que permite aos consumidores selecionar itens de uma prateleira e sair da loja sem ter que fazer o check-out formal) usam aprendizado profundo. O Alexa, alimentado por mais de 30 sistemas ML diferentes, ajuda os clientes bilhões de vezes por semana a gerenciar casas inteligentes, fazer compras, obter informações e entretenimento e muito mais. Temos milhares de engenheiros na Amazon comprometidos com ML, e isso é uma grande parte de nossa herança, ética atual e futura.

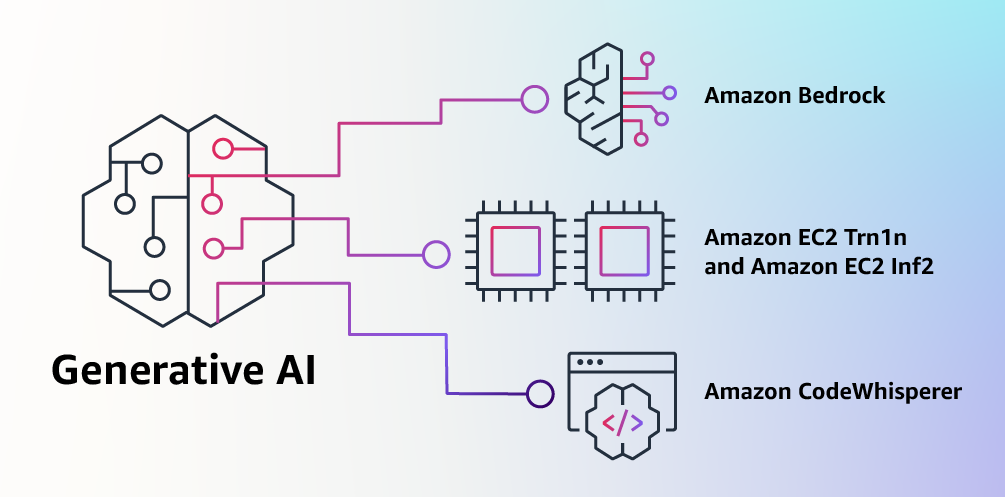

Na AWS, desempenhamos um papel fundamental na democratização do ML e em torná-lo acessível a qualquer pessoa que queira usá-lo, incluindo mais de 100,000 clientes de todos os tamanhos e setores. A AWS tem o portfólio mais amplo e profundo de serviços de IA e ML em todas as três camadas da pilha. Investimos e inovamos para oferecer a infraestrutura escalável e de melhor desempenho para treinamento e inferência de ML de baixo custo; desenvolveu o Amazon SageMaker, que é a maneira mais fácil para todos os desenvolvedores criarem, treinarem e implantarem modelos; e lançou uma ampla gama de serviços que permitem aos clientes adicionar recursos de IA, como reconhecimento de imagem, previsão e pesquisa inteligente a aplicativos com uma simples chamada de API. É por isso que clientes como Intuit, Thomson Reuters, AstraZeneca, Ferrari, Bundesliga, 3M e BMW, bem como milhares de startups e agências governamentais em todo o mundo, estão transformando a si mesmos, suas indústrias e suas missões com ML. Adotamos a mesma abordagem democratizante para a IA generativa: trabalhamos para tirar essas tecnologias do campo de pesquisa e experimentos e estender sua disponibilidade muito além de um punhado de startups e grandes empresas de tecnologia bem financiadas. É por isso que hoje estou animado para anunciar várias inovações que tornarão fácil e prático para nossos clientes usar IA generativa em seus negócios.

Construindo com IA generativa na AWS

IA generativa e modelos de fundação

IA generativa é um tipo de IA que pode criar novos conteúdos e ideias, incluindo conversas, histórias, imagens, vídeos e música. Como toda IA, a IA generativa é alimentada por modelos de ML – modelos muito grandes que são pré-treinados em grandes quantidades de dados e comumente chamados de Foundation Models (FMs). Avanços recentes em ML (especificamente a invenção da arquitetura de rede neural baseada em transformador) levaram ao surgimento de modelos que contêm bilhões de parâmetros ou variáveis. Para dar uma noção da mudança de escala, o maior modelo pré-treinado em 2019 foi de 330 milhões de parâmetros. Agora, os maiores modelos têm mais de 500 bilhões de parâmetros - um aumento de tamanho de 1,600 vezes em apenas alguns anos. Os FMs de hoje, como os modelos de linguagem grande (LLMs) GPT3.5 ou BLOOM, e o modelo de texto para imagem Stable Diffusion da Stability AI, podem executar uma ampla gama de tarefas que abrangem vários domínios, como escrever postagens de blog, gerar imagens, resolvendo problemas de matemática, participando de diálogos e respondendo a perguntas com base em um documento. O tamanho e a natureza de finalidade geral dos FMs os tornam diferentes dos modelos tradicionais de ML, que normalmente executam tarefas específicas, como análise de texto para sentimento, classificação de imagens e previsão de tendências.

Os FMs podem executar muito mais tarefas porque contêm um número tão grande de parâmetros que os tornam capazes de aprender conceitos complexos. E por meio de sua exposição pré-treinamento a dados em escala de internet em todas as suas várias formas e miríades de padrões, os FMs aprendem a aplicar seus conhecimentos em uma ampla gama de contextos. Embora os recursos e as possibilidades resultantes de um FM pré-treinado sejam incríveis, os clientes ficam realmente empolgados porque esses modelos de capacidade geral também podem ser personalizados para executar funções específicas de domínio que diferenciam seus negócios, usando apenas uma pequena fração dos dados e computação necessária para treinar um modelo do zero. Os FMs personalizados podem criar uma experiência única para o cliente, incorporando a voz, o estilo e os serviços da empresa em uma ampla variedade de setores de consumo, como bancos, viagens e saúde. Por exemplo, uma empresa financeira que precisa gerar automaticamente um relatório diário de atividades para circulação interna usando todas as transações relevantes pode personalizar o modelo com dados proprietários, que incluirão relatórios anteriores, para que o FM aprenda como esses relatórios devem ser lidos e quais dados foram usados para gerá-los.

O potencial dos FMs é incrivelmente empolgante. Mas, ainda estamos nos primeiros dias. Embora o ChatGPT tenha sido a primeira experiência ampla de IA generativa a chamar a atenção dos clientes, a maioria das pessoas que estuda IA generativa rapidamente percebeu que várias empresas trabalham em FMs há anos e existem vários FMs diferentes disponíveis - cada um com pontos fortes e características. Como vimos ao longo dos anos com tecnologias em rápida evolução e na evolução do ML, as coisas mudam rapidamente. Esperamos que novas arquiteturas surjam no futuro, e essa diversidade de FMs irá desencadear uma onda de inovação. Já estamos vendo novas experiências de aplicativos nunca antes vistas. Os clientes da AWS nos perguntaram como podem aproveitar rapidamente o que existe hoje (e o que provavelmente virá amanhã) e começar rapidamente a usar FMs e IA generativa em seus negócios e organizações para impulsionar novos níveis de produtividade e transformar suas ofertas.

Anunciando os modelos Amazon Bedrock e Amazon Titan, a maneira mais fácil de criar e dimensionar aplicativos de IA generativos com FMs

Os clientes nos disseram que há algumas coisas importantes em seu caminho hoje. Primeiro, eles precisam de uma maneira direta de encontrar e acessar FMs de alto desempenho que forneçam resultados excelentes e sejam os mais adequados para seus propósitos. Em segundo lugar, os clientes desejam que a integração com os aplicativos seja perfeita, sem precisar gerenciar grandes clusters de infraestrutura ou incorrer em grandes custos. Por fim, os clientes querem que seja fácil pegar o FM básico e criar aplicativos diferenciados usando seus próprios dados (poucos dados ou muitos). Como os dados que os clientes desejam usar para personalização são IPs incrivelmente valiosos, eles precisam que eles permaneçam completamente protegidos, seguros e privados durante esse processo e desejam controlar como seus dados são compartilhados e usados.

Recebemos todo esse feedback dos clientes e hoje temos o prazer de anunciar Rocha Amazônica, um novo serviço que torna os FMs do AI21 Labs, Anthropic, Stability AI e Amazon acessíveis por meio de uma API. A Bedrock é a maneira mais fácil para os clientes criarem e dimensionarem aplicativos generativos baseados em IA usando FMs, democratizando o acesso para todos os construtores. A Bedrock oferecerá a capacidade de acessar uma variedade de FMs poderosos para texto e imagens - incluindo FMs Titan da Amazon, que consistem em dois novos LLMs que também estamos anunciando hoje— por meio de um serviço gerenciado da AWS escalonável, confiável e seguro. Com a experiência sem servidor da Bedrock, os clientes podem encontrar facilmente o modelo certo para o que estão tentando fazer, começar rapidamente, personalizar FMs de forma privada com seus próprios dados e integrá-los e implantá-los facilmente em seus aplicativos usando as ferramentas e os recursos da AWS que eles estão familiarizados (incluindo integrações com recursos do Amazon SageMaker ML, como experimentos para testar diferentes modelos e pipelines para gerenciar seus FMs em escala) sem precisar gerenciar nenhuma infraestrutura.

Os clientes da Bedrock podem escolher entre alguns dos FMs mais avançados disponíveis atualmente. Isso inclui a família Jurassic-2 de LLMs multilíngues do AI21 Labs, que seguem instruções de linguagem natural para gerar texto em espanhol, francês, alemão, português, italiano e holandês. Claude, LLM da Anthropic, pode executar uma ampla variedade de tarefas de processamento de texto e conversação e é baseado na extensa pesquisa da Anthropic sobre o treinamento de sistemas de IA honestos e responsáveis. A Bedrock também facilita o acesso ao conjunto de modelos de fundação de texto para imagem da Stability AI, incluindo Stable Diffusion (o mais popular de seu tipo), que é capaz de gerar imagens, arte, logotipos e imagens únicas, realistas e de alta qualidade projetos.

Um dos recursos mais importantes do Bedrock é a facilidade de personalizar um modelo. Os clientes simplesmente apontam para Bedrock alguns exemplos rotulados no Amazon S3, e o serviço pode ajustar o modelo para uma tarefa específica sem precisar anotar grandes volumes de dados (apenas 20 exemplos são suficientes). Imagine um gerente de marketing de conteúdo que trabalha em uma importante varejista de moda e precisa desenvolver um anúncio novo e direcionado e uma cópia de campanha para uma nova linha de bolsas. Para fazer isso, eles fornecem à Bedrock alguns exemplos rotulados de seus slogans de melhor desempenho de campanhas anteriores, juntamente com as descrições dos produtos associados, e a Bedrock começará automaticamente a gerar mídia social eficaz, anúncio gráfico e cópia da web para as novas bolsas. Nenhum dos dados do cliente é usado para treinar os modelos subjacentes e, como todos os dados são criptografados e não saem da Virtual Private Cloud (VPC) do cliente, os clientes podem confiar que seus dados permanecerão privados e confidenciais.

Bedrock está agora em pré-visualização limitada e clientes como Coda estão entusiasmados com a rapidez com que suas equipes de desenvolvimento começaram a funcionar. Shishir Mehrotra, cofundador e CEO da Coda, diz: “Como um cliente de longa data da AWS, estamos entusiasmados com a forma como o Amazon Bedrock pode trazer qualidade, escalabilidade e desempenho para a Coda AI. Como todos os nossos dados já estão na AWS, podemos incorporar rapidamente a IA generativa usando o Bedrock, com toda a segurança e privacidade de que precisamos para proteger nossos dados integrados. Com mais de dezenas de milhares de equipes rodando no Coda, incluindo grandes equipes como Uber, New York Times e Square, confiabilidade e escalabilidade são realmente importantes.”

Temos visto os novos Titan FMs da Amazon com alguns clientes antes de disponibilizá-los de forma mais ampla nos próximos meses. Teremos inicialmente dois modelos Titan. O primeiro é um LLM generativo para tarefas como resumo, geração de texto (por exemplo, criação de uma postagem de blog), classificação, perguntas e respostas abertas e extração de informações. O segundo é um LLM de incorporações que traduz entradas de texto (palavras, frases ou possivelmente grandes unidades de texto) em representações numéricas (conhecidas como incorporações) que contêm o significado semântico do texto. Embora este LLM não gere texto, ele é útil para aplicativos como personalização e pesquisa porque, ao comparar as incorporações, o modelo produzirá respostas mais relevantes e contextuais do que a correspondência de palavras. Na verdade, o recurso de pesquisa de produtos da Amazon.com usa um modelo de incorporação semelhante entre outros para ajudar os clientes a encontrar os produtos que procuram. Para continuar apoiando as melhores práticas no uso responsável da IA, os Titan FMs são construídos para detectar e remover conteúdo nocivo nos dados, rejeitar conteúdo impróprio na entrada do usuário e filtrar as saídas dos modelos que contêm conteúdo impróprio (como discurso de ódio, palavrões e violência).

A Bedrock torna o poder dos FMs acessível a empresas de todos os tamanhos, para que possam acelerar o uso de ML em suas organizações e criar seus próprios aplicativos generativos de IA porque será fácil para todos os desenvolvedores. Achamos que a Bedrock será um grande passo à frente na democratização dos FMs, e nossos parceiros como Accenture, Deloitte, Infosys e Slalom estão criando práticas para ajudar as empresas a ir mais rápido com IA generativa. Fornecedores independentes de software (ISVs) como C3 IA e a Pega estão entusiasmados em aproveitar a Bedrock para facilitar o acesso à sua grande seleção de FMs com toda a segurança, privacidade e confiabilidade que esperam da AWS.

Anunciando a disponibilidade geral das instâncias Amazon EC2 Trn1n com AWS Trainium e Amazon EC2 Inf2 com AWS Inferentia2, a infraestrutura de nuvem mais econômica para IA generativa

O que quer que os clientes estejam tentando fazer com os FMs - executando-os, construindo-os, personalizando-os - eles precisam da infraestrutura mais eficiente e econômica criada especificamente para ML. Nos últimos cinco anos, a AWS tem investido em nosso próprio silício para ampliar o desempenho e o preço para cargas de trabalho exigentes, como treinamento e inferência de ML, e nossos chips AWS Trainium e AWS Inferentia oferecem o menor custo para modelos de treinamento e execução de inferência na nuvem. Essa capacidade de maximizar o desempenho e controlar os custos escolhendo a infraestrutura de ML ideal é o motivo pelo qual as principais startups de IA, como AI21 Labs, Anthropic, Cohere, Grammarly, Hugging Face, Runway e Stability AI são executadas na AWS.

As instâncias Trn1, com tecnologia Trainium, podem oferecer até 50% de economia nos custos de treinamento em relação a qualquer outra instância EC2 e são otimizadas para distribuir o treinamento em vários servidores conectados com 800 Gbps de rede Elastic Fabric Adapter (EFA) de segunda geração. Os clientes podem implantar instâncias Trn1 em UltraClusters que podem escalar até 30,000 chips Trainium (mais de 6 exaflops de computação) localizados na mesma zona de disponibilidade da AWS com rede em escala de petabit. Muitos clientes da AWS, incluindo Helixon, Money Forward e a equipe de pesquisa da Amazon, usam instâncias Trn1 para ajudar a reduzir o tempo necessário para treinar os modelos de aprendizado profundo de maior escala de meses para semanas ou até dias, reduzindo seus custos. 800 Gbps é muita largura de banda, mas continuamos inovando para oferecer mais e hoje estamos anunciando o disponibilidade geral de novos aplicativos otimizados para rede Trn1n instâncias, que oferecem 1600 Gbps de largura de banda de rede e são projetados para oferecer desempenho 20% maior em relação ao Trn1 para modelos grandes e com uso intensivo de rede.

Hoje, a maior parte do tempo e do dinheiro gastos em FMs são gastos em seu treinamento. Isso ocorre porque muitos clientes estão apenas começando a implantar FMs na produção. No entanto, no futuro, quando os FMs forem implantados em escala, a maioria dos custos estará associada à execução dos modelos e à inferência. Embora você normalmente treine um modelo periodicamente, um aplicativo de produção pode estar constantemente gerando previsões, conhecidas como inferências, potencialmente gerando milhões por hora. E essas previsões precisam acontecer em tempo real, o que requer uma rede de latência muito baixa e alto rendimento. Alexa é um ótimo exemplo com milhões de solicitações chegando a cada minuto, o que representa 40% de todos os custos de computação.

Como sabíamos que a maior parte dos custos futuros de ML viria da execução de inferências, priorizamos o silício otimizado para inferência quando começamos a investir em novos chips alguns anos atrás. Em 2018, anunciamos o Inferentia, o primeiro chip desenvolvido especificamente para inferência. Todos os anos, a Inferentia ajuda a Amazon a executar trilhões de inferências e já economizou para empresas como a Amazon mais de cem milhões de dólares em despesas de capital. Os resultados são impressionantes e vemos muitas oportunidades para continuar inovando, pois as cargas de trabalho só aumentarão em tamanho e complexidade à medida que mais clientes integrarem IA generativa em seus aplicativos.

É por isso que estamos anunciando hoje o disponibilidade geral de Inf2 instâncias com tecnologia AWS Inferentia2, que são otimizados especificamente para aplicativos de IA generativos em larga escala com modelos contendo centenas de bilhões de parâmetros. As instâncias Inf2 oferecem taxa de transferência até 4 vezes maior e latência até 10 vezes menor em comparação com as instâncias baseadas em Inferentia da geração anterior. Eles também têm conectividade de ultra-alta velocidade entre aceleradores para suportar inferência distribuída em larga escala. Esses recursos geram desempenho de preço de inferência até 40% melhor do que outras instâncias do Amazon EC2 comparáveis e o menor custo de inferência na nuvem. Clientes como o Runway estão obtendo uma taxa de transferência até 2 vezes maior com Inf2 do que instâncias comparáveis do Amazon EC2 para alguns de seus modelos. Essa inferência de alto desempenho e baixo custo permitirá que o Runway introduza mais recursos, implemente modelos mais complexos e, finalmente, ofereça uma experiência melhor para os milhões de criadores que usam o Runway.

Anunciando a disponibilidade geral do Amazon CodeWhisperer, gratuito para desenvolvedores individuais

Sabemos que construir com os FMs certos e executar aplicativos de IA generativa em escala na infraestrutura de nuvem de melhor desempenho será transformador para os clientes. A nova onda de experiências também será transformadora para os usuários. Com a IA generativa incorporada, os usuários poderão ter interações mais naturais e contínuas com aplicativos e sistemas. Pense em como podemos desbloquear nossos celulares apenas olhando para eles, sem precisar saber nada sobre os poderosos modelos de ML que tornam esse recurso possível.

Uma área em que prevemos o crescimento rápido do uso de IA generativa é a codificação. Os desenvolvedores de software hoje gastam uma quantidade significativa de seu tempo escrevendo código que é bastante direto e indiferenciado. Eles também gastam muito tempo tentando acompanhar uma ferramenta complexa e em constante mudança e um cenário tecnológico. Tudo isso deixa os desenvolvedores com menos tempo para desenvolver recursos e serviços novos e inovadores. Os desenvolvedores tentam superar isso copiando e modificando trechos de código da web, o que pode resultar na cópia inadvertida de código que não funciona, contém vulnerabilidades de segurança ou não rastreia o uso de software de código aberto. E, em última análise, pesquisar e copiar ainda leva tempo para as coisas boas.

A IA generativa pode tirar esse peso da equação “escrevendo” grande parte do código indiferenciado, permitindo que os desenvolvedores criem mais rapidamente e, ao mesmo tempo, liberando-os para se concentrar nos aspectos mais criativos da codificação. Por isso, no ano passado, anunciamos a prévia de Sussurrador de Código da Amazon, um companheiro de codificação AI que usa um FM sob o capô para melhorar radicalmente a produtividade do desenvolvedor, gerando sugestões de código em tempo real com base nos comentários dos desenvolvedores em linguagem natural e código anterior em seu Ambiente de Desenvolvimento Integrado (IDE). Os desenvolvedores podem simplesmente dizer ao CodeWhisperer para realizar uma tarefa, como “analisar uma sequência de músicas CSV” e pedir que ele retorne uma lista estruturada com base em valores como artista, título e classificação mais alta no gráfico. O CodeWhisperer fornece um aumento de produtividade ao gerar uma função inteira que analisa a string e retorna a lista conforme especificado. A resposta do desenvolvedor à prévia foi extremamente positiva e continuamos a acreditar que ajudar os desenvolvedores a codificar pode acabar sendo um dos usos mais poderosos da IA generativa que veremos nos próximos anos. Durante a prévia, realizamos um desafio de produtividade e os participantes que usaram o CodeWhisperer concluíram as tarefas 57% mais rápido, em média, e tiveram 27% mais chances de concluí-las com sucesso do que aqueles que não usaram o CodeWhisperer. Este é um salto gigantesco na produtividade do desenvolvedor e acreditamos que seja apenas o começo.

Hoje, temos o prazer de anunciar o disponibilidade geral do Amazon CodeWhisperer para Python, Java, JavaScript, TypeScript e C#—mais dez novas linguagens, incluindo Go, Kotlin, Rust, PHP e SQL. O CodeWhisperer pode ser acessado de IDEs como VS Code, IntelliJ IDEA, AWS Cloud9 e muitos outros por meio das extensões IDE do AWS Toolkit. O CodeWhisperer também está disponível no console do AWS Lambda. Além de aprender com os bilhões de linhas de código disponíveis publicamente, o CodeWhisperer foi treinado no código da Amazon. Acreditamos que o CodeWhisperer é agora a maneira mais precisa, rápida e segura de gerar código para serviços da AWS, incluindo Amazon EC2, AWS Lambda e Amazon S3.

Os desenvolvedores não serão realmente mais produtivos se o código sugerido por sua ferramenta de IA generativa contiver vulnerabilidades de segurança ocultas ou não lidar com o código aberto de forma responsável. O CodeWhisperer é o único companheiro de codificação de IA com varredura de segurança integrada (alimentada por raciocínio automatizado) para encontrar e sugerir remediações para vulnerabilidades difíceis de detectar, como as dos dez principais Projetos de Segurança de Aplicativos Mundiais Abertos (OWASP), aquelas que não atendem às práticas recomendadas da biblioteca de criptografia e outras. Para ajudar os desenvolvedores a codificar com responsabilidade, o CodeWhisperer filtra as sugestões de código que podem ser consideradas tendenciosas ou injustas, e o CodeWhisperer é o único companheiro de codificação que pode filtrar e sinalizar as sugestões de código que se assemelham ao código-fonte aberto que os clientes podem querer referenciar ou licenciar para uso.

Sabemos que a IA generativa vai mudar o jogo para os desenvolvedores e queremos que seja útil para o maior número possível. É por isso que o CodeWhisperer é gratuito para todos os usuários individuais, sem qualificações ou limites de tempo para gerar código! Qualquer um pode se inscrever no CodeWhisperer com apenas uma conta de e-mail e se tornar mais produtivo em minutos. Você nem precisa ter uma conta da AWS. Para usuários corporativos, estamos oferecendo um CodeWhisperer Professional Tier que inclui recursos de administração como logon único (SSO) com integração do AWS Identity and Access Management (IAM), bem como limites mais altos para verificação de segurança.

Construir aplicativos poderosos como o CodeWhisperer é transformador para desenvolvedores e todos os nossos clientes. Temos muito mais por vir e estamos entusiasmados com o que você criará com IA generativa na AWS. Nossa missão é possibilitar que desenvolvedores de todos os níveis de habilidade e organizações de todos os tamanhos inovem usando IA generativa. Este é apenas o começo do que acreditamos ser a próxima onda de ML, gerando novas possibilidades para você.

Recursos

Confira os seguintes recursos para saber mais sobre IA generativa na AWS e estes anúncios:

Sobre o autor

Swami Sivasubramanian é vice-presidente de dados e aprendizado de máquina da AWS. Nessa função, Swami supervisiona todos os serviços de banco de dados, análise e IA e machine learning da AWS. A missão de sua equipe é ajudar as organizações a colocar seus dados para funcionar com uma solução de dados completa e de ponta a ponta para armazenar, acessar, analisar, visualizar e prever.

Swami Sivasubramanian é vice-presidente de dados e aprendizado de máquina da AWS. Nessa função, Swami supervisiona todos os serviços de banco de dados, análise e IA e machine learning da AWS. A missão de sua equipe é ajudar as organizações a colocar seus dados para funcionar com uma solução de dados completa e de ponta a ponta para armazenar, acessar, analisar, visualizar e prever.

- Conteúdo com tecnologia de SEO e distribuição de relações públicas. Seja amplificado hoje.

- Platoblockchain. Inteligência Metaverso Web3. Conhecimento Ampliado. Acesse aqui.

- Fonte: https://aws.amazon.com/blogs/machine-learning/announcing-new-tools-for-building-with-generative-ai-on-aws/