W miarę jak świat spieszy się z wykorzystaniem najnowszej fali technologii sztucznej inteligencji, jeden element zaawansowanego technologicznie sprzętu stał się zaskakująco popularnym towarem: procesor graficzny, czyli procesor graficzny.

Najwyższej klasy procesor graficzny można sprzedać za dziesiątki tysięcy dolarów, a wiodący producent Nvidia zapoznał się z jego rynkową wyceną przekroczyć 2 biliony dolarów wraz ze wzrostem popytu na jej produkty.

Procesory graficzne to nie tylko wysokiej klasy produkty AI. W telefonach, laptopach i konsolach do gier znajdują się również słabsze procesory graficzne.

Pewnie zastanawiasz się teraz: czym tak naprawdę jest procesor graficzny? A co czyni je tak wyjątkowymi?

Co to jest GPU?

Procesory graficzne zostały pierwotnie zaprojektowane głównie do szybkiego generowania i wyświetlania złożonych scen i obiektów 3D, takich jak te używane w grach wideo i projektowanie wspomagane komputerowo oprogramowanie. Nowoczesne procesory graficzne radzą sobie również z zadaniami takimi jak dekompresujący strumienie wideo.

„Mózgiem” większości komputerów jest chip zwany jednostką centralną (CPU). Procesory mogą być używane do generowania scen graficznych i dekompresji wideo, ale zazwyczaj są one znacznie wolniejsze i mniej wydajne w przypadku tych zadań w porównaniu z procesorami graficznymi. Procesory lepiej nadają się do ogólnych zadań obliczeniowych, takich jak przetwarzanie tekstu i przeglądanie stron internetowych.

Czym procesory graficzne różnią się od procesorów?

Typowy nowoczesny procesor składa się z 8 do 16”rdzenie”, z których każdy może przetwarzać złożone zadania w sposób sekwencyjny.

Z drugiej strony procesory graficzne mają tysiące stosunkowo małych rdzeni, które zaprojektowano tak, aby wszystkie działały w tym samym czasie („równolegle”), aby zapewnić szybkie ogólne przetwarzanie. Dzięki temu doskonale nadają się do zadań wymagających dużej liczby prostych operacji, które można wykonać jednocześnie, a nie jedna po drugiej.

Tradycyjne procesory graficzne są dostępne w dwóch głównych wersjach.

Po pierwsze, istnieją samodzielne chipy, które często są dołączane do kart dodatkowych do dużych komputerów stacjonarnych. Drugie to procesory graficzne połączone z procesorem w tym samym pakiecie chipów, które często można znaleźć w laptopach i konsolach do gier, takich jak PlayStation 5. W obu przypadkach procesor kontroluje to, co robi procesor graficzny.

Dlaczego procesory graficzne są tak przydatne dla sztucznej inteligencji?

Okazuje się, że procesory graficzne można wykorzystać do czegoś więcej niż tylko generowania scen graficznych.

Wiele technik uczenia maszynowego sztuczna inteligencja, Takie jak głębokie sieci neuronowe, w dużym stopniu opierają się na różnych formach mnożenia macierzy.

Jest to operacja matematyczna polegająca na mnożeniu i sumowaniu bardzo dużych zbiorów liczb. Operacje te dobrze nadają się do przetwarzania równoległego i dlatego mogą być wykonywane bardzo szybko przez procesory graficzne.

Co dalej z procesorami graficznymi?

Wydajność procesorów graficznych w zakresie przetwarzania liczb stale rośnie ze względu na wzrost liczby rdzeni i ich prędkości roboczych. Ulepszenia te wynikają przede wszystkim z ulepszeń w produkcji chipów przez takie firmy jak TSMC w Tajwanie.

Rozmiar poszczególnych tranzystorów – podstawowych elementów każdego układu komputerowego – zmniejsza się, co pozwala na umieszczenie większej liczby tranzystorów w tej samej przestrzeni fizycznej.

Jednak to nie cała historia. Chociaż tradycyjne procesory graficzne są przydatne do zadań obliczeniowych związanych ze sztuczną inteligencją, nie są one optymalne.

Tak jak pierwotnie procesory graficzne zostały zaprojektowane w celu przyspieszania komputerów poprzez zapewnianie specjalistycznego przetwarzania grafiki, istnieją akceleratory zaprojektowane w celu przyspieszenia zadań uczenia maszynowego. Akceleratory te są często określane jako procesory graficzne dla centrów danych.

Niektóre z najpopularniejszych akceleratorów, produkowanych przez takie firmy jak AMD i Nvidia, zaczynały jako tradycyjne procesory graficzne. Z biegiem czasu ich projekty ewoluowały, aby lepiej radzić sobie z różnymi zadaniami uczenia maszynowego, na przykład poprzez obsługę bardziej wydajnych „pływak mózgowy" format liczbowy.

Inne akceleratory, takie jak Google jednostki przetwarzania tensorowego i Tenstorrent Rdzenie Tensix, zostały zaprojektowane od podstaw w celu przyspieszenia głębokich sieci neuronowych.

Procesory graficzne dla centrów danych i inne akceleratory sztucznej inteligencji są zazwyczaj wyposażone w znacznie więcej pamięci niż tradycyjne karty dodatkowe GPU, co ma kluczowe znaczenie przy szkoleniu dużych modeli sztucznej inteligencji. Im większy model AI, tym jest on bardziej wydajny i dokładny.

Aby jeszcze bardziej przyspieszyć szkolenie i obsługiwać jeszcze większe modele sztucznej inteligencji, takie jak ChatGPT, wiele procesorów graficznych dla centrów danych można połączyć w jeden superkomputer. Wymaga to bardziej złożonego oprogramowania, aby właściwie wykorzystać dostępną moc przetwarzania liczb. Inne podejście polega na stworzyć jeden bardzo duży akcelerator, tak jak "procesor w skali waflowejwyprodukowany przez Cerebras.

Czy wyspecjalizowane chipy są przyszłością?

Procesory również nie stoją w miejscu. Najnowsze procesory AMD i Intel mają wbudowane instrukcje niskiego poziomu, które przyspieszają przetwarzanie liczb wymagane przez głębokie sieci neuronowe. Ta dodatkowa funkcjonalność pomaga głównie w zadaniach „wnioskowania”, czyli korzystaniu z modeli sztucznej inteligencji, które zostały już opracowane gdzie indziej.

Aby w ogóle wytrenować modele AI, nadal potrzebne są duże akceleratory typu GPU.

Możliwe jest tworzenie coraz bardziej wyspecjalizowanych akceleratorów dla konkretnych algorytmów uczenia maszynowego. Ostatnio na przykład firma Groq wyprodukowała „jednostka przetwarzająca język” (LPU) specjalnie zaprojektowany do uruchamiania dużych modeli językowych na wzór ChatGPT.

Jednak stworzenie tych wyspecjalizowanych procesorów wymaga znacznych zasobów inżynieryjnych. Historia pokazuje, że wykorzystanie i popularność dowolnego algorytmu uczenia maszynowego zwykle osiąga szczyt, a następnie maleje, dlatego drogi, specjalistyczny sprzęt może szybko stać się przestarzały.

Jednak dla przeciętnego konsumenta nie stanowi to problemu. Procesory graficzne i inne układy scalone w produktach, których używasz, prawdopodobnie będą po cichu przyspieszać.

Artykuł został opublikowany ponownie Konwersacje na licencji Creative Commons. Przeczytać oryginalny artykuł.

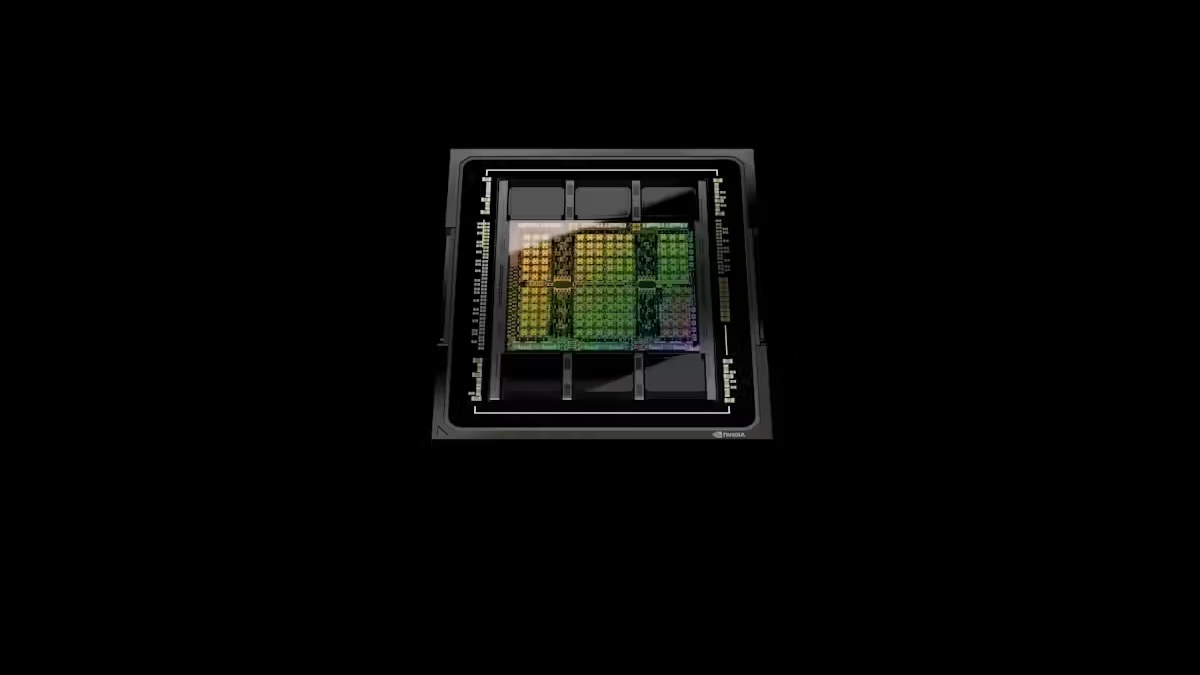

Kredytowych Image: Nvidia

- Dystrybucja treści i PR oparta na SEO. Uzyskaj wzmocnienie już dziś.

- PlatoData.Network Pionowe generatywne AI. Wzmocnij się. Dostęp tutaj.

- PlatoAiStream. Inteligencja Web3. Wiedza wzmocniona. Dostęp tutaj.

- PlatonESG. Węgiel Czysta technologia, Energia, Środowisko, Słoneczny, Gospodarowanie odpadami. Dostęp tutaj.

- Platon Zdrowie. Inteligencja w zakresie biotechnologii i badań klinicznych. Dostęp tutaj.

- Źródło: https://singularityhub.com/2024/03/13/what-is-a-gpu-the-chips-powering-the-ai-boom-and-why-theyre-worth-trillions/