ਸਪੀਕਰ ਡਾਇਰਾਈਜ਼ੇਸ਼ਨ, ਆਡੀਓ ਵਿਸ਼ਲੇਸ਼ਣ ਵਿੱਚ ਇੱਕ ਜ਼ਰੂਰੀ ਪ੍ਰਕਿਰਿਆ, ਸਪੀਕਰ ਪਛਾਣ ਦੇ ਅਧਾਰ 'ਤੇ ਇੱਕ ਆਡੀਓ ਫਾਈਲ ਨੂੰ ਵੰਡਦੀ ਹੈ। ਇਹ ਪੋਸਟ ਸਪੀਕਰ ਡਾਇਰਾਈਜ਼ੇਸ਼ਨ ਲਈ ਹੱਗਿੰਗ ਫੇਸ ਦੇ ਪਾਈਐਨੋਟ ਨੂੰ ਏਕੀਕ੍ਰਿਤ ਕਰਨ ਬਾਰੇ ਸੋਚਦੀ ਹੈ ਐਮਾਜ਼ਾਨ ਸੇਜਮੇਕਰ ਅਸਿੰਕਰੋਨਸ ਅੰਤ ਬਿੰਦੂ।

ਅਸੀਂ AWS Cloud 'ਤੇ SageMaker ਦੀ ਵਰਤੋਂ ਕਰਦੇ ਹੋਏ ਸਪੀਕਰ ਸੈਗਮੈਂਟੇਸ਼ਨ ਅਤੇ ਕਲੱਸਟਰਿੰਗ ਹੱਲਾਂ ਨੂੰ ਕਿਵੇਂ ਲਾਗੂ ਕਰਨਾ ਹੈ ਇਸ ਬਾਰੇ ਇੱਕ ਵਿਆਪਕ ਗਾਈਡ ਪ੍ਰਦਾਨ ਕਰਦੇ ਹਾਂ। ਤੁਸੀਂ ਇਸ ਹੱਲ ਦੀ ਵਰਤੋਂ ਮਲਟੀ-ਸਪੀਕਰ (100 ਤੋਂ ਵੱਧ) ਆਡੀਓ ਰਿਕਾਰਡਿੰਗਾਂ ਨਾਲ ਕੰਮ ਕਰਨ ਵਾਲੀਆਂ ਐਪਲੀਕੇਸ਼ਨਾਂ ਲਈ ਕਰ ਸਕਦੇ ਹੋ।

ਹੱਲ ਸੰਖੇਪ ਜਾਣਕਾਰੀ

ਐਮਾਜ਼ਾਨ ਟ੍ਰਾਂਸਕ੍ਰਾਈਬ AWS ਵਿੱਚ ਸਪੀਕਰ ਡਾਇਰਾਈਜ਼ੇਸ਼ਨ ਲਈ ਜਾਣ ਵਾਲੀ ਸੇਵਾ ਹੈ। ਹਾਲਾਂਕਿ, ਗੈਰ-ਸਮਰਥਿਤ ਭਾਸ਼ਾਵਾਂ ਲਈ, ਤੁਸੀਂ ਹੋਰ ਮਾਡਲਾਂ (ਸਾਡੇ ਕੇਸ ਵਿੱਚ, PyAnote) ਦੀ ਵਰਤੋਂ ਕਰ ਸਕਦੇ ਹੋ ਜੋ ਅਨੁਮਾਨ ਲਈ ਸੇਜਮੇਕਰ ਵਿੱਚ ਤਾਇਨਾਤ ਕੀਤੇ ਜਾਣਗੇ। ਛੋਟੀਆਂ ਆਡੀਓ ਫਾਈਲਾਂ ਲਈ ਜਿੱਥੇ ਅਨੁਮਾਨ ਨੂੰ 60 ਸਕਿੰਟਾਂ ਤੱਕ ਦਾ ਸਮਾਂ ਲੱਗਦਾ ਹੈ, ਤੁਸੀਂ ਵਰਤ ਸਕਦੇ ਹੋ ਅਸਲ-ਸਮੇਂ ਦਾ ਅਨੁਮਾਨ . 60 ਸਕਿੰਟਾਂ ਤੋਂ ਵੱਧ ਸਮੇਂ ਲਈ, ਅਸਿੰਕਰੋਨਸ ਅਨੁਮਾਨ ਵਰਤਿਆ ਜਾਣਾ ਚਾਹੀਦਾ ਹੈ. ਅਸਿੰਕ੍ਰੋਨਸ ਇਨਫਰੈਂਸ ਦਾ ਵਾਧੂ ਫਾਇਦਾ ਜਦੋਂ ਪ੍ਰਕਿਰਿਆ ਕਰਨ ਲਈ ਕੋਈ ਬੇਨਤੀਆਂ ਨਹੀਂ ਹੁੰਦੀਆਂ ਹਨ ਤਾਂ ਉਦਾਹਰਣ ਦੀ ਗਿਣਤੀ ਨੂੰ ਸਵੈਚਲਿਤ ਤੌਰ 'ਤੇ ਜ਼ੀਰੋ ਤੱਕ ਸਕੇਲ ਕਰਕੇ ਲਾਗਤ ਦੀ ਬਚਤ ਹੁੰਦੀ ਹੈ।

ਜੱਫੀ ਪਾਉਣ ਵਾਲਾ ਚਿਹਰਾ ਮਸ਼ੀਨ ਲਰਨਿੰਗ (ML) ਮਾਡਲਾਂ ਲਈ ਇੱਕ ਪ੍ਰਸਿੱਧ ਓਪਨ ਸੋਰਸ ਹੱਬ ਹੈ। AWS ਅਤੇ ਹੱਗਿੰਗ ਫੇਸ ਕੋਲ ਏ ਭਾਈਵਾਲੀ ਜੋ PyTorch ਜਾਂ TensorFlow ਵਿੱਚ ਸਿਖਲਾਈ ਅਤੇ ਅਨੁਮਾਨ ਲਈ AWS ਡੀਪ ਲਰਨਿੰਗ ਕੰਟੇਨਰਾਂ (DLCs) ਦੇ ਇੱਕ ਸੈੱਟ ਦੇ ਨਾਲ ਸੇਜਮੇਕਰ ਦੁਆਰਾ ਇੱਕ ਸਹਿਜ ਏਕੀਕਰਣ ਦੀ ਆਗਿਆ ਦਿੰਦਾ ਹੈ, ਅਤੇ ਸੇਜਮੇਕਰ ਪਾਈਥਨ SDK ਲਈ ਹੱਗਿੰਗ ਫੇਸ ਐਸਟੀਮੇਟਰ ਅਤੇ ਭਵਿੱਖਬਾਣੀ ਕਰਦਾ ਹੈ। ਸੇਜਮੇਕਰ ਵਿਸ਼ੇਸ਼ਤਾਵਾਂ ਅਤੇ ਸਮਰੱਥਾਵਾਂ ਡਿਵੈਲਪਰਾਂ ਅਤੇ ਡਾਟਾ ਵਿਗਿਆਨੀਆਂ ਨੂੰ AWS 'ਤੇ ਕੁਦਰਤੀ ਭਾਸ਼ਾ ਪ੍ਰੋਸੈਸਿੰਗ (NLP) ਨਾਲ ਆਸਾਨੀ ਨਾਲ ਸ਼ੁਰੂਆਤ ਕਰਨ ਵਿੱਚ ਮਦਦ ਕਰਦੀਆਂ ਹਨ।

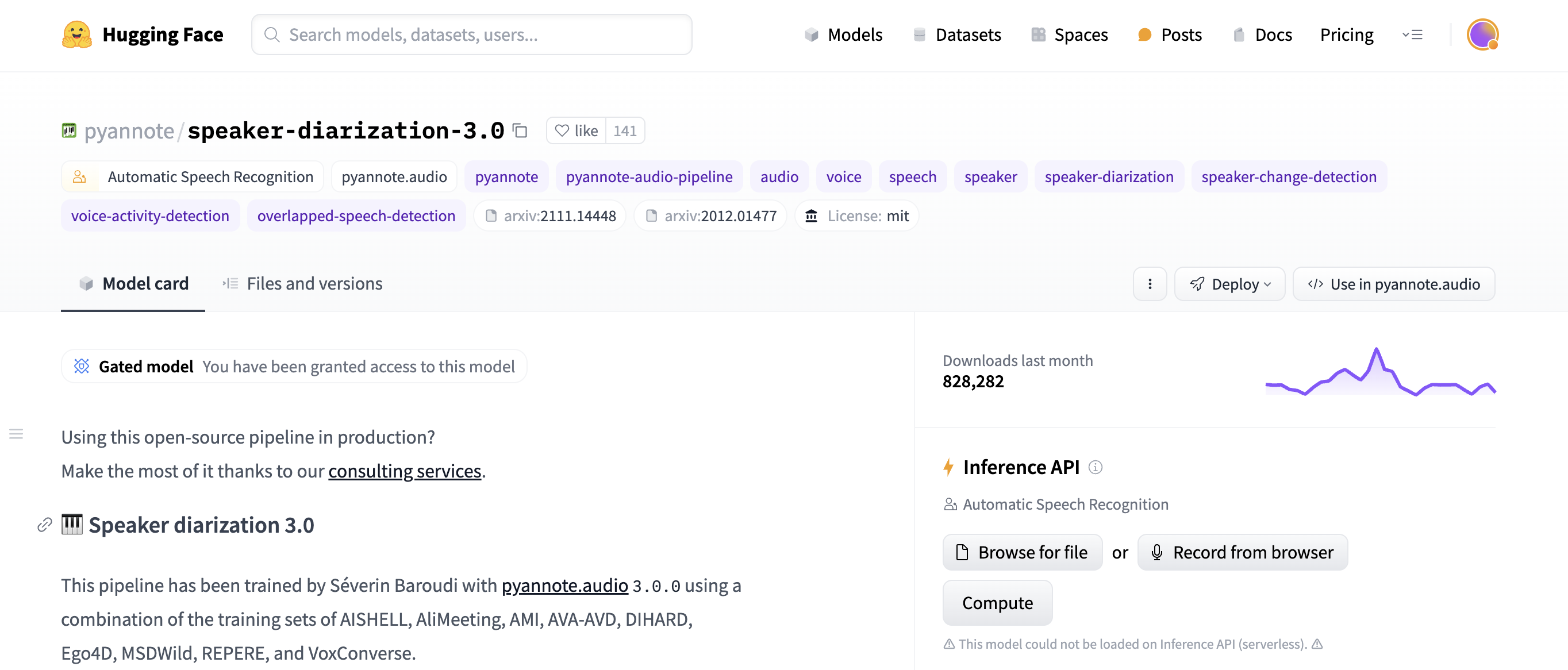

ਇਸ ਹੱਲ ਲਈ ਏਕੀਕਰਣ ਵਿੱਚ ਹੱਗਿੰਗ ਫੇਸ ਦੇ ਪ੍ਰੀ-ਟ੍ਰੇਂਡ ਸਪੀਕਰ ਡਾਇਰਾਈਜ਼ੇਸ਼ਨ ਮਾਡਲ ਦੀ ਵਰਤੋਂ ਕਰਨਾ ਸ਼ਾਮਲ ਹੈ PyAnote ਲਾਇਬ੍ਰੇਰੀ . PyAnnote ਸਪੀਕਰ ਡਾਇਰਾਈਜ਼ੇਸ਼ਨ ਲਈ ਪਾਈਥਨ ਵਿੱਚ ਲਿਖੀ ਇੱਕ ਓਪਨ ਸੋਰਸ ਟੂਲਕਿੱਟ ਹੈ। ਇਹ ਮਾਡਲ, ਨਮੂਨਾ ਆਡੀਓ ਡੇਟਾਸੇਟ 'ਤੇ ਸਿਖਲਾਈ ਪ੍ਰਾਪਤ, ਆਡੀਓ ਫਾਈਲਾਂ ਵਿੱਚ ਪ੍ਰਭਾਵਸ਼ਾਲੀ ਸਪੀਕਰ ਵਿਭਾਜਨ ਨੂੰ ਸਮਰੱਥ ਬਣਾਉਂਦਾ ਹੈ। ਮਾਡਲ ਨੂੰ ਸੇਜਮੇਕਰ 'ਤੇ ਅਸਿੰਕ੍ਰੋਨਸ ਐਂਡਪੁਆਇੰਟ ਸੈੱਟਅੱਪ ਦੇ ਤੌਰ 'ਤੇ ਤੈਨਾਤ ਕੀਤਾ ਗਿਆ ਹੈ, ਡਾਇਰਾਈਜ਼ੇਸ਼ਨ ਕਾਰਜਾਂ ਦੀ ਕੁਸ਼ਲ ਅਤੇ ਸਕੇਲੇਬਲ ਪ੍ਰੋਸੈਸਿੰਗ ਪ੍ਰਦਾਨ ਕਰਦਾ ਹੈ।

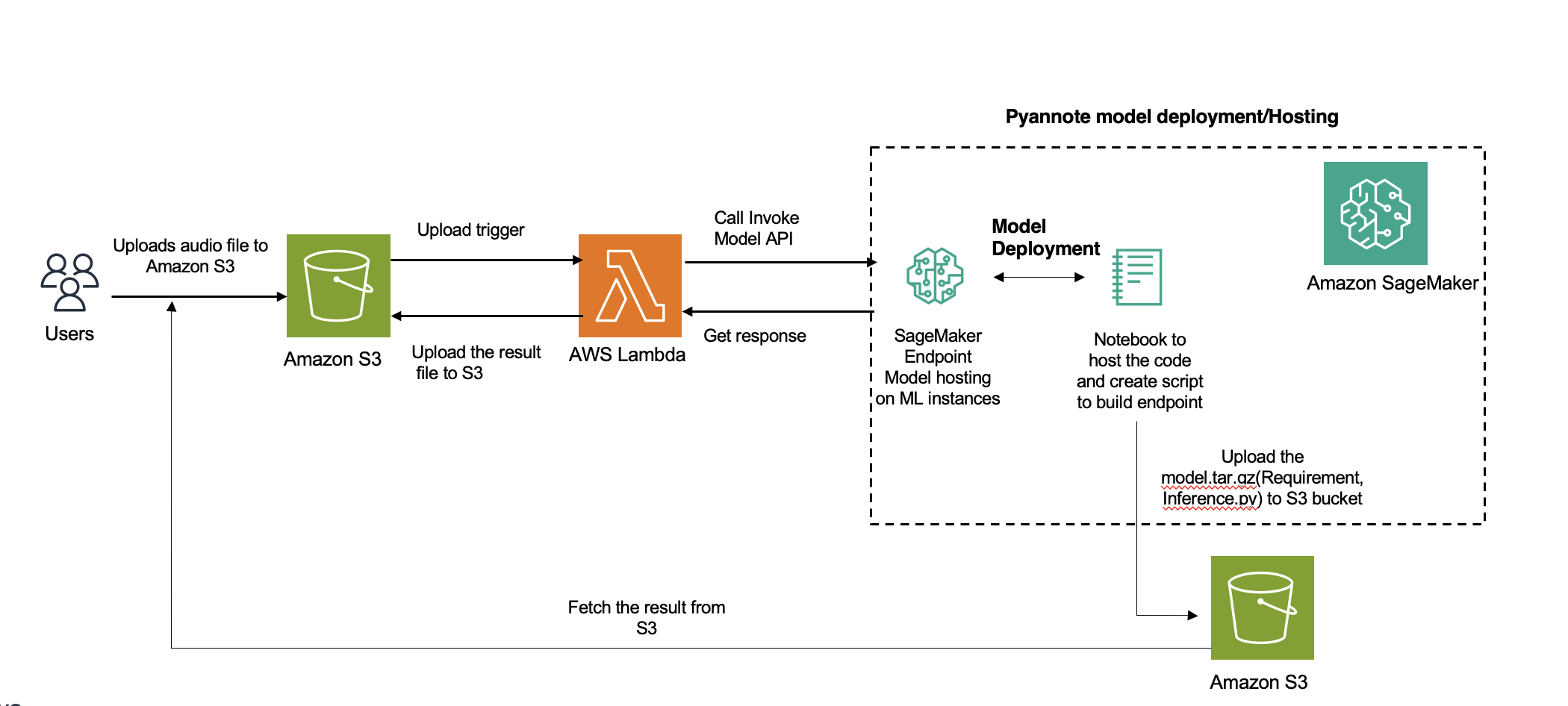

ਹੇਠਾਂ ਦਿੱਤਾ ਚਿੱਤਰ ਹੱਲ ਆਰਕੀਟੈਕਚਰ ਨੂੰ ਦਰਸਾਉਂਦਾ ਹੈ।

ਇਸ ਪੋਸਟ ਲਈ, ਅਸੀਂ ਹੇਠਾਂ ਦਿੱਤੀ ਆਡੀਓ ਫਾਈਲ ਦੀ ਵਰਤੋਂ ਕਰਦੇ ਹਾਂ.

ਸਟੀਰੀਓ ਜਾਂ ਮਲਟੀ-ਚੈਨਲ ਆਡੀਓ ਫਾਈਲਾਂ ਨੂੰ ਆਪਣੇ ਆਪ ਹੀ ਚੈਨਲਾਂ ਦੀ ਔਸਤ ਦੁਆਰਾ ਮੋਨੋ ਵਿੱਚ ਮਿਕਸ ਕੀਤਾ ਜਾਂਦਾ ਹੈ। ਇੱਕ ਵੱਖਰੀ ਦਰ 'ਤੇ ਨਮੂਨਾ ਲਈ ਗਈ ਆਡੀਓ ਫਾਈਲਾਂ ਨੂੰ ਲੋਡ ਹੋਣ 'ਤੇ ਆਪਣੇ ਆਪ 16kHz ਵਿੱਚ ਮੁੜ ਨਮੂਨਾ ਦਿੱਤਾ ਜਾਂਦਾ ਹੈ।

ਪੂਰਿ-ਲੋੜਾਂ

ਹੇਠ ਲਿਖੀਆਂ ਸ਼ਰਤਾਂ ਪੂਰੀਆਂ ਕਰੋ:

ਇੱਕ ਸੇਜਮੇਕਰ ਡੋਮੇਨ ਬਣਾਓ .ਯਕੀਨੀ ਬਣਾਓ ਕਿ ਤੁਹਾਡੀ AWS ਪਛਾਣ ਅਤੇ ਪਹੁੰਚ ਪ੍ਰਬੰਧਨ (IAM) ਉਪਭੋਗਤਾ ਕੋਲ ਇੱਕ ਬਣਾਉਣ ਲਈ ਜ਼ਰੂਰੀ ਪਹੁੰਚ ਅਨੁਮਤੀਆਂ ਹਨ ਸੇਜਮੇਕਰ ਦੀ ਭੂਮਿਕਾ .

ਯਕੀਨੀ ਬਣਾਓ ਕਿ AWS ਖਾਤੇ ਵਿੱਚ ਇੱਕ ml.g5.2x ਵੱਡੀ ਉਦਾਹਰਨ ਲਈ ਸੇਜਮੇਕਰ ਐਂਡਪੁਆਇੰਟ ਦੀ ਮੇਜ਼ਬਾਨੀ ਕਰਨ ਲਈ ਇੱਕ ਸੇਵਾ ਕੋਟਾ ਹੈ।

ਹੱਗਿੰਗ ਫੇਸ ਤੋਂ PyAnnote ਸਪੀਕਰ ਡਾਇਰਾਈਜ਼ੇਸ਼ਨ ਨੂੰ ਐਕਸੈਸ ਕਰਨ ਲਈ ਇੱਕ ਮਾਡਲ ਫੰਕਸ਼ਨ ਬਣਾਓ

ਤੁਸੀਂ ਲੋੜੀਂਦੇ ਪ੍ਰੀ-ਟ੍ਰੇਂਡ ਤੱਕ ਪਹੁੰਚ ਕਰਨ ਲਈ ਹੱਗਿੰਗ ਫੇਸ ਹੱਬ ਦੀ ਵਰਤੋਂ ਕਰ ਸਕਦੇ ਹੋ PyAnote ਸਪੀਕਰ ਡਾਇਰਾਈਜ਼ੇਸ਼ਨ ਮਾਡਲ . ਸੇਜਮੇਕਰ ਐਂਡਪੁਆਇੰਟ ਬਣਾਉਣ ਵੇਲੇ ਤੁਸੀਂ ਮਾਡਲ ਫਾਈਲ ਨੂੰ ਡਾਉਨਲੋਡ ਕਰਨ ਲਈ ਉਹੀ ਸਕ੍ਰਿਪਟ ਵਰਤਦੇ ਹੋ।

ਹੇਠ ਦਿੱਤੇ ਕੋਡ ਨੂੰ ਵੇਖੋ:

from PyAnnote.audio import Pipeline

def model_fn(model_dir):

# Load the model from the specified model directory

model = Pipeline.from_pretrained(

"PyAnnote/speaker-diarization-3.1",

use_auth_token="Replace-with-the-Hugging-face-auth-token")

return model

ਮਾਡਲ ਕੋਡ ਨੂੰ ਪੈਕੇਜ ਕਰੋ

inference.py ਵਰਗੀਆਂ ਜ਼ਰੂਰੀ ਫਾਈਲਾਂ ਤਿਆਰ ਕਰੋ, ਜਿਸ ਵਿੱਚ ਇਨਫਰੈਂਸ ਕੋਡ ਹੁੰਦਾ ਹੈ:

%%writefile model/code/inference.py

from PyAnnote.audio import Pipeline

import subprocess

import boto3

from urllib.parse import urlparse

import pandas as pd

from io import StringIO

import os

import torch

def model_fn(model_dir):

# Load the model from the specified model directory

model = Pipeline.from_pretrained(

"PyAnnote/speaker-diarization-3.1",

use_auth_token="hf_oBxxxxxxxxxxxx)

return model

def diarization_from_s3(model, s3_file, language=None):

s3 = boto3.client("s3")

o = urlparse(s3_file, allow_fragments=False)

bucket = o.netloc

key = o.path.lstrip("/")

s3.download_file(bucket, key, "tmp.wav")

result = model("tmp.wav")

data = {}

for turn, _, speaker in result.itertracks(yield_label=True):

data[turn] = (turn.start, turn.end, speaker)

data_df = pd.DataFrame(data.values(), columns=["start", "end", "speaker"])

print(data_df.shape)

result = data_df.to_json(orient="split")

return result

def predict_fn(data, model):

s3_file = data.pop("s3_file")

language = data.pop("language", None)

result = diarization_from_s3(model, s3_file, language)

return {

"diarization_from_s3": result

}

ਤਿਆਰ ਕਰੋ ਏ requirements.txt ਫਾਈਲ, ਜਿਸ ਵਿੱਚ ਅਨੁਮਾਨ ਨੂੰ ਚਲਾਉਣ ਲਈ ਲੋੜੀਂਦੀਆਂ ਪਾਈਥਨ ਲਾਇਬ੍ਰੇਰੀਆਂ ਸ਼ਾਮਲ ਹਨ:

with open("model/code/requirements.txt", "w") as f:

f.write("transformers==4.25.1n")

f.write("boto3n")

f.write("PyAnnote.audion")

f.write("soundfilen")

f.write("librosan")

f.write("onnxruntimen")

f.write("wgetn")

f.write("pandas")

ਅੰਤ ਵਿੱਚ, ਸੰਕੁਚਿਤ ਕਰੋ inference.py ਅਤੇ requirements.txt ਫਾਈਲਾਂ ਅਤੇ ਇਸ ਨੂੰ ਇਸ ਤਰ੍ਹਾਂ ਸੁਰੱਖਿਅਤ ਕਰੋ model.tar.gz:

ਸੇਜਮੇਕਰ ਮਾਡਲ ਨੂੰ ਕੌਂਫਿਗਰ ਕਰੋ

ਵਿੱਚ ਚਿੱਤਰ URI, ਮਾਡਲ ਡੇਟਾ ਸਥਾਨ ਨਿਰਧਾਰਿਤ ਕਰਕੇ ਇੱਕ ਸੇਜਮੇਕਰ ਮਾਡਲ ਸਰੋਤ ਨੂੰ ਪਰਿਭਾਸ਼ਿਤ ਕਰੋ ਐਮਾਜ਼ਾਨ ਸਧਾਰਨ ਸਟੋਰੇਜ ਸੇਵਾ (S3), ਅਤੇ ਸੇਜਮੇਕਰ ਦੀ ਭੂਮਿਕਾ:

import sagemaker

import boto3

sess = sagemaker.Session()

sagemaker_session_bucket = None

if sagemaker_session_bucket is None and sess is not None:

sagemaker_session_bucket = sess.default_bucket()

try:

role = sagemaker.get_execution_role()

except ValueError:

iam = boto3.client("iam")

role = iam.get_role(RoleName="sagemaker_execution_role")["Role"]["Arn"]

sess = sagemaker.Session(default_bucket=sagemaker_session_bucket)

print(f"sagemaker role arn: {role}")

print(f"sagemaker bucket: {sess.default_bucket()}")

print(f"sagemaker session region: {sess.boto_region_name}")

ਮਾਡਲ ਨੂੰ ਐਮਾਜ਼ਾਨ S3 'ਤੇ ਅੱਪਲੋਡ ਕਰੋ

ਜ਼ਿਪ ਕੀਤੇ PyAnnote ਹੱਗਿੰਗ ਫੇਸ ਮਾਡਲ ਫਾਈਲ ਨੂੰ ਇੱਕ S3 ਬਾਲਟੀ ਵਿੱਚ ਅੱਪਲੋਡ ਕਰੋ:

s3_location = f"s3://{sagemaker_session_bucket}/whisper/model/model.tar.gz"

!aws s3 cp model.tar.gz $s3_location

ਇੱਕ ਸੇਜਮੇਕਰ ਅਸਿੰਕ੍ਰੋਨਸ ਐਂਡਪੁਆਇੰਟ ਬਣਾਓ

ਪ੍ਰਦਾਨ ਕੀਤੀ ਅਸਿੰਕ੍ਰੋਨਸ ਇਨਫਰੈਂਸ ਕੌਂਫਿਗਰੇਸ਼ਨ ਦੀ ਵਰਤੋਂ ਕਰਦੇ ਹੋਏ ਸੇਜਮੇਕਰ 'ਤੇ ਮਾਡਲ ਨੂੰ ਤੈਨਾਤ ਕਰਨ ਲਈ ਇੱਕ ਅਸਿੰਕ੍ਰੋਨਸ ਐਂਡਪੁਆਇੰਟ ਕੌਂਫਿਗਰ ਕਰੋ:

from sagemaker.huggingface.model import HuggingFaceModel

from sagemaker.async_inference.async_inference_config import AsyncInferenceConfig

from sagemaker.s3 import s3_path_join

from sagemaker.utils import name_from_base

async_endpoint_name = name_from_base("custom-asyc")

# create Hugging Face Model Class

huggingface_model = HuggingFaceModel(

model_data=s3_location, # path to your model and script

role=role, # iam role with permissions to create an Endpoint

transformers_version="4.17", # transformers version used

pytorch_version="1.10", # pytorch version used

py_version="py38", # python version used

)

# create async endpoint configuration

async_config = AsyncInferenceConfig(

output_path=s3_path_join(

"s3://", sagemaker_session_bucket, "async_inference/output"

), # Where our results will be stored

# Add nofitication SNS if needed

notification_config={

# "SuccessTopic": "PUT YOUR SUCCESS SNS TOPIC ARN",

# "ErrorTopic": "PUT YOUR ERROR SNS TOPIC ARN",

}, # Notification configuration

)

env = {"MODEL_SERVER_WORKERS": "2"}

# deploy the endpoint endpoint

async_predictor = huggingface_model.deploy(

initial_instance_count=1,

instance_type="ml.xx",

async_inference_config=async_config,

endpoint_name=async_endpoint_name,

env=env,

)

ਅੰਤਮ ਬਿੰਦੂ ਦੀ ਜਾਂਚ ਕਰੋ

ਡਾਇਰਾਈਜ਼ੇਸ਼ਨ ਲਈ ਇੱਕ ਆਡੀਓ ਫਾਈਲ ਭੇਜ ਕੇ ਅਤੇ ਨਿਰਧਾਰਤ S3 ਆਉਟਪੁੱਟ ਮਾਰਗ ਵਿੱਚ ਸਟੋਰ ਕੀਤੇ JSON ਆਉਟਪੁੱਟ ਨੂੰ ਮੁੜ ਪ੍ਰਾਪਤ ਕਰਕੇ ਅੰਤਮ ਬਿੰਦੂ ਕਾਰਜਕੁਸ਼ਲਤਾ ਦਾ ਮੁਲਾਂਕਣ ਕਰੋ:

# Replace with a path to audio object in S3

from sagemaker.async_inference import WaiterConfig

res = async_predictor.predict_async(data=data)

print(f"Response output path: {res.output_path}")

print("Start Polling to get response:")

config = WaiterConfig(

max_attempts=10, # number of attempts

delay=10# time in seconds to wait between attempts

)

res.get_result(config)

#import waiterconfig

ਪੈਮਾਨੇ 'ਤੇ ਇਸ ਹੱਲ ਨੂੰ ਤੈਨਾਤ ਕਰਨ ਲਈ, ਅਸੀਂ ਵਰਤਣ ਦਾ ਸੁਝਾਅ ਦਿੰਦੇ ਹਾਂ AWS Lambda , ਐਮਾਜ਼ਾਨ ਸਧਾਰਨ ਸੂਚਨਾ ਸੇਵਾ (ਐਮਾਜ਼ਾਨ SNS), ਜਾਂ ਐਮਾਜ਼ਾਨ ਸਧਾਰਨ ਕਤਾਰ ਸੇਵਾ (Amazon SQS)। ਇਹ ਸੇਵਾਵਾਂ ਮਾਪਯੋਗਤਾ, ਘਟਨਾ-ਸੰਚਾਲਿਤ ਆਰਕੀਟੈਕਚਰ, ਅਤੇ ਕੁਸ਼ਲ ਸਰੋਤ ਉਪਯੋਗਤਾ ਲਈ ਤਿਆਰ ਕੀਤੀਆਂ ਗਈਆਂ ਹਨ। ਉਹ ਨਤੀਜਾ ਪ੍ਰੋਸੈਸਿੰਗ ਤੋਂ ਅਸਿੰਕਰੋਨਸ ਇਨਫਰੈਂਸ ਪ੍ਰਕਿਰਿਆ ਨੂੰ ਡੀਕਪਲ ਕਰਨ ਵਿੱਚ ਮਦਦ ਕਰ ਸਕਦੇ ਹਨ, ਜਿਸ ਨਾਲ ਤੁਸੀਂ ਹਰੇਕ ਹਿੱਸੇ ਨੂੰ ਸੁਤੰਤਰ ਤੌਰ 'ਤੇ ਸਕੇਲ ਕਰ ਸਕਦੇ ਹੋ ਅਤੇ ਅਨੁਮਾਨਾਂ ਦੀਆਂ ਬੇਨਤੀਆਂ ਨੂੰ ਵਧੇਰੇ ਪ੍ਰਭਾਵਸ਼ਾਲੀ ਢੰਗ ਨਾਲ ਸੰਭਾਲ ਸਕਦੇ ਹੋ।

ਨਤੀਜੇ

ਮਾਡਲ ਆਉਟਪੁੱਟ 'ਤੇ ਸਟੋਰ ਕੀਤਾ ਜਾਂਦਾ ਹੈ s3://sagemaker-xxxx /async_inference/output/. ਆਉਟਪੁੱਟ ਦਿਖਾਉਂਦਾ ਹੈ ਕਿ ਆਡੀਓ ਰਿਕਾਰਡਿੰਗ ਨੂੰ ਤਿੰਨ ਕਾਲਮਾਂ ਵਿੱਚ ਵੰਡਿਆ ਗਿਆ ਹੈ:

ਸ਼ੁਰੂ ਕਰੋ (ਸ਼ੁਰੂ ਕਰਨ ਦਾ ਸਮਾਂ ਸਕਿੰਟਾਂ ਵਿੱਚ)

ਅੰਤ (ਸਕਿੰਟ ਵਿੱਚ ਅੰਤ ਸਮਾਂ)

ਸਪੀਕਰ (ਸਪੀਕਰ ਲੇਬਲ)

ਹੇਠਾਂ ਦਿੱਤਾ ਕੋਡ ਸਾਡੇ ਨਤੀਜਿਆਂ ਦੀ ਇੱਕ ਉਦਾਹਰਨ ਦਿਖਾਉਂਦਾ ਹੈ:

[0.9762308998, 8.9049235993, "SPEAKER_01"]

[9.533106961, 12.1646859083, "SPEAKER_01"]

[13.1324278438, 13.9303904924, "SPEAKER_00"]

[14.3548387097, 26.1884550085, "SPEAKER_00"]

[27.2410865874, 28.2258064516, "SPEAKER_01"]

[28.3446519525, 31.298811545, "SPEAKER_01"]

ਸਾਫ਼ ਕਰੋ

ਤੁਸੀਂ MinCapacity ਨੂੰ 0 'ਤੇ ਸੈੱਟ ਕਰਕੇ ਇੱਕ ਸਕੇਲਿੰਗ ਨੀਤੀ ਨੂੰ ਜ਼ੀਰੋ 'ਤੇ ਸੈੱਟ ਕਰ ਸਕਦੇ ਹੋ; ਅਸਿੰਕਰੋਨਸ ਅਨੁਮਾਨ ਤੁਹਾਨੂੰ ਬਿਨਾਂ ਕਿਸੇ ਬੇਨਤੀ ਦੇ ਜ਼ੀਰੋ ਤੱਕ ਆਟੋ ਸਕੇਲ ਕਰਨ ਦਿੰਦਾ ਹੈ। ਤੁਹਾਨੂੰ ਅੰਤਮ ਬਿੰਦੂ ਨੂੰ ਮਿਟਾਉਣ ਦੀ ਲੋੜ ਨਹੀਂ ਹੈ, ਇਹ ਸਕੇਲ ਦੁਬਾਰਾ ਲੋੜ ਪੈਣ 'ਤੇ ਜ਼ੀਰੋ ਤੋਂ, ਵਰਤੋਂ ਵਿੱਚ ਨਾ ਹੋਣ 'ਤੇ ਲਾਗਤਾਂ ਨੂੰ ਘਟਾਉਣਾ। ਹੇਠ ਦਿੱਤੇ ਕੋਡ ਨੂੰ ਵੇਖੋ:

# Common class representing application autoscaling for SageMaker

client = boto3.client('application-autoscaling')

# This is the format in which application autoscaling references the endpoint

resource_id='endpoint/' + <endpoint_name> + '/variant/' + <'variant1'>

# Define and register your endpoint variant

response = client.register_scalable_target(

ServiceNamespace='sagemaker',

ResourceId=resource_id,

ScalableDimension='sagemaker:variant:DesiredInstanceCount', # The number of EC2 instances for your Amazon SageMaker model endpoint variant.

MinCapacity=0,

MaxCapacity=5

)

ਜੇਕਰ ਤੁਸੀਂ ਅੰਤਮ ਬਿੰਦੂ ਨੂੰ ਮਿਟਾਉਣਾ ਚਾਹੁੰਦੇ ਹੋ, ਤਾਂ ਹੇਠਾਂ ਦਿੱਤੇ ਕੋਡ ਦੀ ਵਰਤੋਂ ਕਰੋ:

async_predictor.delete_endpoint(async_endpoint_name)

ਅਸਿੰਕ੍ਰੋਨਸ ਐਂਡਪੁਆਇੰਟ ਡਿਪਲਾਇਮੈਂਟ ਦੇ ਲਾਭ

ਇਹ ਹੱਲ ਹੇਠਾਂ ਦਿੱਤੇ ਲਾਭਾਂ ਦੀ ਪੇਸ਼ਕਸ਼ ਕਰਦਾ ਹੈ:

ਹੱਲ ਕੁਸ਼ਲਤਾ ਨਾਲ ਮਲਟੀਪਲ ਜਾਂ ਵੱਡੀ ਆਡੀਓ ਫਾਈਲਾਂ ਨੂੰ ਸੰਭਾਲ ਸਕਦਾ ਹੈ.

ਇਹ ਉਦਾਹਰਨ ਪ੍ਰਦਰਸ਼ਨ ਲਈ ਇੱਕ ਉਦਾਹਰਨ ਦੀ ਵਰਤੋਂ ਕਰਦੀ ਹੈ। ਜੇਕਰ ਤੁਸੀਂ ਸੈਂਕੜੇ ਜਾਂ ਹਜ਼ਾਰਾਂ ਵੀਡੀਓਜ਼ ਲਈ ਇਸ ਹੱਲ ਦੀ ਵਰਤੋਂ ਕਰਨਾ ਚਾਹੁੰਦੇ ਹੋ ਅਤੇ ਕਈ ਵਾਰ ਪ੍ਰਕਿਰਿਆ ਕਰਨ ਲਈ ਇੱਕ ਅਸਿੰਕ੍ਰੋਨਸ ਐਂਡਪੁਆਇੰਟ ਦੀ ਵਰਤੋਂ ਕਰਨਾ ਚਾਹੁੰਦੇ ਹੋ, ਤਾਂ ਤੁਸੀਂ ਇੱਕ ਦੀ ਵਰਤੋਂ ਕਰ ਸਕਦੇ ਹੋ ਆਟੋ ਸਕੇਲਿੰਗ ਨੀਤੀ , ਜੋ ਕਿ ਬਹੁਤ ਸਾਰੇ ਸਰੋਤ ਦਸਤਾਵੇਜ਼ਾਂ ਲਈ ਤਿਆਰ ਕੀਤਾ ਗਿਆ ਹੈ। ਆਟੋ ਸਕੇਲਿੰਗ ਤੁਹਾਡੇ ਵਰਕਲੋਡ ਵਿੱਚ ਤਬਦੀਲੀਆਂ ਦੇ ਜਵਾਬ ਵਿੱਚ ਇੱਕ ਮਾਡਲ ਲਈ ਪ੍ਰਬੰਧਿਤ ਉਦਾਹਰਨਾਂ ਦੀ ਸੰਖਿਆ ਨੂੰ ਗਤੀਸ਼ੀਲ ਰੂਪ ਵਿੱਚ ਵਿਵਸਥਿਤ ਕਰਦੀ ਹੈ।

ਹੱਲ ਸਰੋਤਾਂ ਨੂੰ ਅਨੁਕੂਲ ਬਣਾਉਂਦਾ ਹੈ ਅਤੇ ਲੰਬੇ ਸਮੇਂ ਤੋਂ ਚੱਲ ਰਹੇ ਕੰਮਾਂ ਨੂੰ ਰੀਅਲ-ਟਾਈਮ ਇਨਫਰੈਂਸ ਤੋਂ ਵੱਖ ਕਰਕੇ ਸਿਸਟਮ ਲੋਡ ਨੂੰ ਘਟਾਉਂਦਾ ਹੈ।

ਸਿੱਟਾ

ਇਸ ਪੋਸਟ ਵਿੱਚ, ਅਸੀਂ ਪਾਈਥਨ ਸਕ੍ਰਿਪਟਾਂ ਦੀ ਵਰਤੋਂ ਕਰਦੇ ਹੋਏ ਸੇਜਮੇਕਰ 'ਤੇ ਹੱਗਿੰਗ ਫੇਸ ਦੇ ਸਪੀਕਰ ਡਾਇਰਾਈਜ਼ੇਸ਼ਨ ਮਾਡਲ ਨੂੰ ਲਾਗੂ ਕਰਨ ਲਈ ਇੱਕ ਸਿੱਧੀ ਪਹੁੰਚ ਪ੍ਰਦਾਨ ਕੀਤੀ ਹੈ। ਇੱਕ ਅਸਿੰਕ੍ਰੋਨਸ ਐਂਡਪੁਆਇੰਟ ਦੀ ਵਰਤੋਂ ਕਰਨਾ ਇੱਕ ਸੇਵਾ ਦੇ ਤੌਰ 'ਤੇ ਡਾਇਰਾਈਜ਼ੇਸ਼ਨ ਪੂਰਵ-ਅਨੁਮਾਨਾਂ ਨੂੰ ਪ੍ਰਦਾਨ ਕਰਨ ਲਈ ਇੱਕ ਕੁਸ਼ਲ ਅਤੇ ਮਾਪਯੋਗ ਸਾਧਨ ਪ੍ਰਦਾਨ ਕਰਦਾ ਹੈ, ਸਮਕਾਲੀ ਬੇਨਤੀਆਂ ਨੂੰ ਸਹਿਜੇ ਹੀ ਅਨੁਕੂਲਿਤ ਕਰਦਾ ਹੈ।

ਆਪਣੇ ਆਡੀਓ ਪ੍ਰੋਜੈਕਟਾਂ ਲਈ ਅਸਿੰਕ੍ਰੋਨਸ ਸਪੀਕਰ ਡਾਇਰਾਈਜ਼ੇਸ਼ਨ ਦੇ ਨਾਲ ਅੱਜ ਹੀ ਸ਼ੁਰੂਆਤ ਕਰੋ। ਟਿੱਪਣੀਆਂ ਵਿੱਚ ਸੰਪਰਕ ਕਰੋ ਜੇਕਰ ਤੁਹਾਡੇ ਆਪਣੇ ਅਸਿੰਕ੍ਰੋਨਸ ਡਾਇਰਾਈਜ਼ੇਸ਼ਨ ਐਂਡਪੁਆਇੰਟ ਨੂੰ ਚਾਲੂ ਕਰਨ ਅਤੇ ਚਲਾਉਣ ਬਾਰੇ ਕੋਈ ਸਵਾਲ ਹਨ।

ਲੇਖਕਾਂ ਬਾਰੇ

ਸੰਜੇ ਤਿਵਾਰੀ ਇੱਕ ਸਪੈਸ਼ਲਿਸਟ ਸੋਲਿਊਸ਼ਨ ਆਰਕੀਟੈਕਟ AI/ML ਹੈ ਜੋ ਵਪਾਰਕ ਲੋੜਾਂ ਨੂੰ ਪਰਿਭਾਸ਼ਿਤ ਕਰਨ, ਖਾਸ ਵਰਤੋਂ ਦੇ ਮਾਮਲਿਆਂ ਦੇ ਆਲੇ-ਦੁਆਲੇ L300 ਸੈਸ਼ਨ ਪ੍ਰਦਾਨ ਕਰਨ, ਅਤੇ AI/ML ਐਪਲੀਕੇਸ਼ਨਾਂ ਅਤੇ ਸੇਵਾਵਾਂ ਨੂੰ ਡਿਜ਼ਾਈਨ ਕਰਨ ਲਈ ਰਣਨੀਤਕ ਗਾਹਕਾਂ ਨਾਲ ਕੰਮ ਕਰਨ ਵਿੱਚ ਆਪਣਾ ਸਮਾਂ ਬਿਤਾਉਂਦਾ ਹੈ ਜੋ ਸਕੇਲੇਬਲ, ਭਰੋਸੇਮੰਦ ਅਤੇ ਪ੍ਰਦਰਸ਼ਨਕਾਰੀ ਹਨ। ਉਸਨੇ AI/ML ਦੁਆਰਾ ਸੰਚਾਲਿਤ Amazon SageMaker ਸੇਵਾ ਨੂੰ ਲਾਂਚ ਕਰਨ ਅਤੇ ਸਕੇਲ ਕਰਨ ਵਿੱਚ ਮਦਦ ਕੀਤੀ ਹੈ ਅਤੇ Amazon AI ਸੇਵਾਵਾਂ ਦੀ ਵਰਤੋਂ ਕਰਕੇ ਸੰਕਲਪ ਦੇ ਕਈ ਸਬੂਤ ਲਾਗੂ ਕੀਤੇ ਹਨ। ਉਸਨੇ ਡਿਜੀਟਲ ਪਰਿਵਰਤਨ ਯਾਤਰਾ ਦੇ ਹਿੱਸੇ ਵਜੋਂ ਉੱਨਤ ਵਿਸ਼ਲੇਸ਼ਣ ਪਲੇਟਫਾਰਮ ਵੀ ਵਿਕਸਤ ਕੀਤਾ ਹੈ।

ਕਿਰਨ ਛੱਲਾਪੱਲੀ AWS ਜਨਤਕ ਖੇਤਰ ਦੇ ਨਾਲ ਇੱਕ ਡੂੰਘੀ ਤਕਨੀਕੀ ਕਾਰੋਬਾਰੀ ਵਿਕਾਸਕਾਰ ਹੈ। ਉਸ ਕੋਲ AI/ML ਵਿੱਚ 8 ਸਾਲਾਂ ਤੋਂ ਵੱਧ ਦਾ ਤਜਰਬਾ ਹੈ ਅਤੇ ਸਮੁੱਚੇ ਸਾਫਟਵੇਅਰ ਵਿਕਾਸ ਅਤੇ ਵਿਕਰੀ ਦਾ 23 ਸਾਲਾਂ ਦਾ ਤਜਰਬਾ ਹੈ। ਕਿਰਨ ਪੂਰੇ ਭਾਰਤ ਵਿੱਚ ਜਨਤਕ ਖੇਤਰ ਦੇ ਕਾਰੋਬਾਰਾਂ ਨੂੰ ਕਲਾਉਡ-ਆਧਾਰਿਤ ਹੱਲਾਂ ਦੀ ਪੜਚੋਲ ਕਰਨ ਅਤੇ ਸਹਿ-ਰਚਨਾ ਕਰਨ ਵਿੱਚ ਮਦਦ ਕਰਦੀ ਹੈ ਜੋ ਕਿ AI, ML, ਅਤੇ ਜਨਰੇਟਿਵ AI—ਵੱਡੇ ਭਾਸ਼ਾ ਮਾਡਲਾਂ ਸਮੇਤ—ਤਕਨਾਲੋਜੀ ਦੀ ਵਰਤੋਂ ਕਰਦੇ ਹਨ।

ਸੰਜੇ ਤਿਵਾਰੀ ਇੱਕ ਸਪੈਸ਼ਲਿਸਟ ਸੋਲਿਊਸ਼ਨ ਆਰਕੀਟੈਕਟ AI/ML ਹੈ ਜੋ ਵਪਾਰਕ ਲੋੜਾਂ ਨੂੰ ਪਰਿਭਾਸ਼ਿਤ ਕਰਨ, ਖਾਸ ਵਰਤੋਂ ਦੇ ਮਾਮਲਿਆਂ ਦੇ ਆਲੇ-ਦੁਆਲੇ L300 ਸੈਸ਼ਨ ਪ੍ਰਦਾਨ ਕਰਨ, ਅਤੇ AI/ML ਐਪਲੀਕੇਸ਼ਨਾਂ ਅਤੇ ਸੇਵਾਵਾਂ ਨੂੰ ਡਿਜ਼ਾਈਨ ਕਰਨ ਲਈ ਰਣਨੀਤਕ ਗਾਹਕਾਂ ਨਾਲ ਕੰਮ ਕਰਨ ਵਿੱਚ ਆਪਣਾ ਸਮਾਂ ਬਿਤਾਉਂਦਾ ਹੈ ਜੋ ਸਕੇਲੇਬਲ, ਭਰੋਸੇਮੰਦ ਅਤੇ ਪ੍ਰਦਰਸ਼ਨਕਾਰੀ ਹਨ। ਉਸਨੇ AI/ML ਦੁਆਰਾ ਸੰਚਾਲਿਤ Amazon SageMaker ਸੇਵਾ ਨੂੰ ਲਾਂਚ ਕਰਨ ਅਤੇ ਸਕੇਲ ਕਰਨ ਵਿੱਚ ਮਦਦ ਕੀਤੀ ਹੈ ਅਤੇ Amazon AI ਸੇਵਾਵਾਂ ਦੀ ਵਰਤੋਂ ਕਰਕੇ ਸੰਕਲਪ ਦੇ ਕਈ ਸਬੂਤ ਲਾਗੂ ਕੀਤੇ ਹਨ। ਉਸਨੇ ਡਿਜੀਟਲ ਪਰਿਵਰਤਨ ਯਾਤਰਾ ਦੇ ਹਿੱਸੇ ਵਜੋਂ ਉੱਨਤ ਵਿਸ਼ਲੇਸ਼ਣ ਪਲੇਟਫਾਰਮ ਵੀ ਵਿਕਸਤ ਕੀਤਾ ਹੈ।

ਸੰਜੇ ਤਿਵਾਰੀ ਇੱਕ ਸਪੈਸ਼ਲਿਸਟ ਸੋਲਿਊਸ਼ਨ ਆਰਕੀਟੈਕਟ AI/ML ਹੈ ਜੋ ਵਪਾਰਕ ਲੋੜਾਂ ਨੂੰ ਪਰਿਭਾਸ਼ਿਤ ਕਰਨ, ਖਾਸ ਵਰਤੋਂ ਦੇ ਮਾਮਲਿਆਂ ਦੇ ਆਲੇ-ਦੁਆਲੇ L300 ਸੈਸ਼ਨ ਪ੍ਰਦਾਨ ਕਰਨ, ਅਤੇ AI/ML ਐਪਲੀਕੇਸ਼ਨਾਂ ਅਤੇ ਸੇਵਾਵਾਂ ਨੂੰ ਡਿਜ਼ਾਈਨ ਕਰਨ ਲਈ ਰਣਨੀਤਕ ਗਾਹਕਾਂ ਨਾਲ ਕੰਮ ਕਰਨ ਵਿੱਚ ਆਪਣਾ ਸਮਾਂ ਬਿਤਾਉਂਦਾ ਹੈ ਜੋ ਸਕੇਲੇਬਲ, ਭਰੋਸੇਮੰਦ ਅਤੇ ਪ੍ਰਦਰਸ਼ਨਕਾਰੀ ਹਨ। ਉਸਨੇ AI/ML ਦੁਆਰਾ ਸੰਚਾਲਿਤ Amazon SageMaker ਸੇਵਾ ਨੂੰ ਲਾਂਚ ਕਰਨ ਅਤੇ ਸਕੇਲ ਕਰਨ ਵਿੱਚ ਮਦਦ ਕੀਤੀ ਹੈ ਅਤੇ Amazon AI ਸੇਵਾਵਾਂ ਦੀ ਵਰਤੋਂ ਕਰਕੇ ਸੰਕਲਪ ਦੇ ਕਈ ਸਬੂਤ ਲਾਗੂ ਕੀਤੇ ਹਨ। ਉਸਨੇ ਡਿਜੀਟਲ ਪਰਿਵਰਤਨ ਯਾਤਰਾ ਦੇ ਹਿੱਸੇ ਵਜੋਂ ਉੱਨਤ ਵਿਸ਼ਲੇਸ਼ਣ ਪਲੇਟਫਾਰਮ ਵੀ ਵਿਕਸਤ ਕੀਤਾ ਹੈ। ਕਿਰਨ ਛੱਲਾਪੱਲੀ AWS ਜਨਤਕ ਖੇਤਰ ਦੇ ਨਾਲ ਇੱਕ ਡੂੰਘੀ ਤਕਨੀਕੀ ਕਾਰੋਬਾਰੀ ਵਿਕਾਸਕਾਰ ਹੈ। ਉਸ ਕੋਲ AI/ML ਵਿੱਚ 8 ਸਾਲਾਂ ਤੋਂ ਵੱਧ ਦਾ ਤਜਰਬਾ ਹੈ ਅਤੇ ਸਮੁੱਚੇ ਸਾਫਟਵੇਅਰ ਵਿਕਾਸ ਅਤੇ ਵਿਕਰੀ ਦਾ 23 ਸਾਲਾਂ ਦਾ ਤਜਰਬਾ ਹੈ। ਕਿਰਨ ਪੂਰੇ ਭਾਰਤ ਵਿੱਚ ਜਨਤਕ ਖੇਤਰ ਦੇ ਕਾਰੋਬਾਰਾਂ ਨੂੰ ਕਲਾਉਡ-ਆਧਾਰਿਤ ਹੱਲਾਂ ਦੀ ਪੜਚੋਲ ਕਰਨ ਅਤੇ ਸਹਿ-ਰਚਨਾ ਕਰਨ ਵਿੱਚ ਮਦਦ ਕਰਦੀ ਹੈ ਜੋ ਕਿ AI, ML, ਅਤੇ ਜਨਰੇਟਿਵ AI—ਵੱਡੇ ਭਾਸ਼ਾ ਮਾਡਲਾਂ ਸਮੇਤ—ਤਕਨਾਲੋਜੀ ਦੀ ਵਰਤੋਂ ਕਰਦੇ ਹਨ।

ਕਿਰਨ ਛੱਲਾਪੱਲੀ AWS ਜਨਤਕ ਖੇਤਰ ਦੇ ਨਾਲ ਇੱਕ ਡੂੰਘੀ ਤਕਨੀਕੀ ਕਾਰੋਬਾਰੀ ਵਿਕਾਸਕਾਰ ਹੈ। ਉਸ ਕੋਲ AI/ML ਵਿੱਚ 8 ਸਾਲਾਂ ਤੋਂ ਵੱਧ ਦਾ ਤਜਰਬਾ ਹੈ ਅਤੇ ਸਮੁੱਚੇ ਸਾਫਟਵੇਅਰ ਵਿਕਾਸ ਅਤੇ ਵਿਕਰੀ ਦਾ 23 ਸਾਲਾਂ ਦਾ ਤਜਰਬਾ ਹੈ। ਕਿਰਨ ਪੂਰੇ ਭਾਰਤ ਵਿੱਚ ਜਨਤਕ ਖੇਤਰ ਦੇ ਕਾਰੋਬਾਰਾਂ ਨੂੰ ਕਲਾਉਡ-ਆਧਾਰਿਤ ਹੱਲਾਂ ਦੀ ਪੜਚੋਲ ਕਰਨ ਅਤੇ ਸਹਿ-ਰਚਨਾ ਕਰਨ ਵਿੱਚ ਮਦਦ ਕਰਦੀ ਹੈ ਜੋ ਕਿ AI, ML, ਅਤੇ ਜਨਰੇਟਿਵ AI—ਵੱਡੇ ਭਾਸ਼ਾ ਮਾਡਲਾਂ ਸਮੇਤ—ਤਕਨਾਲੋਜੀ ਦੀ ਵਰਤੋਂ ਕਰਦੇ ਹਨ।