Om de verspreiding van materiaal over seksueel misbruik van kinderen (CSAM) tegen te gaan, heeft een coalitie van generatieve top-AI-ontwikkelaars – waaronder Google, Meta en OpenAI – beloofd om vangrails rond de opkomende technologie af te dwingen.

De groep werd bijeengebracht door twee non-profitorganisaties: de kindertechnologiegroep Thorn en het in New York gevestigde All Tech is Human. Thorn, voorheen bekend als de DNA Foundation, werd in 2012 gelanceerd door acteurs Demi Moore en Ashton Kutcher.

De collectieve toezegging werd dinsdag aangekondigd, samen met een nieuwe Doorn rapport pleiten voor een ‘Safety by Design’-principe bij de ontwikkeling van generatieve AI, dat de creatie van materiaal over seksueel misbruik van kinderen (CSAM) gedurende de gehele levenscyclus van een AI-model zou voorkomen.

“We dringen er bij alle bedrijven op die generatieve AI-technologieën en -producten ontwikkelen, inzetten, onderhouden en gebruiken om zich ertoe te verbinden deze Safety by Design-principes over te nemen en hun toewijding te tonen aan het voorkomen van de creatie en verspreiding van CSAM, AIG-CSAM en andere vormen van seksueel misbruik van kinderen. misbruik en uitbuiting”, Doorn zei in een verklaring.

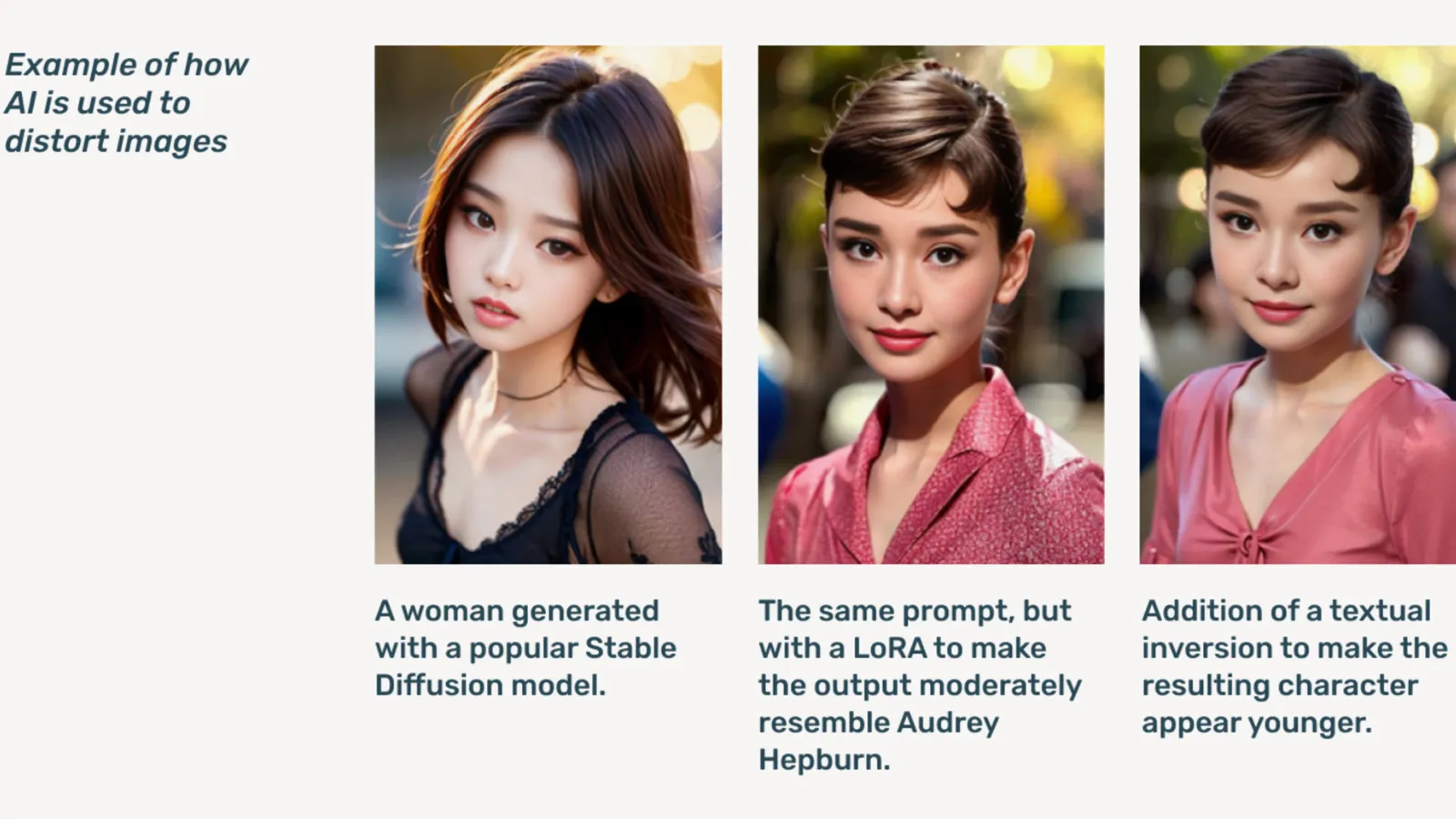

AIG-CSAM is door AI gegenereerde CSAM, waarvan het rapport illustreert dat het relatief eenvoudig te maken is.

Doorn ontwikkelt zich tools en middelen gericht op het beschermen van kinderen tegen seksueel misbruik en uitbuiting. In haar impactrapport van 2022 zei de organisatie dat er ruim 824,466 dossiers met kindermisbruikmateriaal waren gevonden. Vorig jaar meldde Thorn dat er alleen al in de VS ruim 104 miljoen dossiers van vermoedelijke CSAM waren gemeld.

Deepfake-kinderpornografie was al een probleem online en schoot omhoog nadat generatieve AI-modellen openbaar beschikbaar kwamen, waarbij op zichzelf staande AI-modellen die geen cloudservices nodig hebben, op de markt circuleerden. donker web forums.

Genatieve AI maakt het creëren van grote hoeveelheden content nu eenvoudiger dan ooit tevoren, zegt Thorn. Eén enkel kinderroofdier zou potentieel enorme hoeveelheden materiaal met seksueel misbruik van kinderen (CSAM) kunnen creëren, inclusief het aanpassen van originele afbeeldingen en video's in nieuwe inhoud.

“Een toestroom van AIG-CSAM brengt aanzienlijke risico’s met zich mee voor een toch al zwaar belast ecosysteem voor kinderveiligheid, waardoor de uitdagingen waarmee de wetshandhaving wordt geconfronteerd bij het identificeren en redden van bestaande slachtoffers van misbruik, en het opschalen van nieuwe slachtoffers van nog meer kinderen, worden verergerd”, merkt Thorn op.

Het rapport van Thorn schetst een reeks principes die generatieve AI-ontwikkelaars zouden volgen om te voorkomen dat hun technologie wordt gebruikt om kinderpornografie te maken, inclusief het verantwoord inkopen van trainingen datasets, door feedbackloops en stressteststrategieën te integreren, door gebruik te maken van de geschiedenis van de inhoud of ‘herkomst’ met het oog op vijandig misbruik, en door op verantwoorde wijze hun respectieve AI-modellen te hosten.

Anderen die de belofte ondertekenen, zijn onder meer Microsoft, antropisch, Mistral-AI, Amazone, Stabiliteit AI, Civit AI en metafysica, die vandaag elk afzonderlijke verklaringen vrijgeven.

“Een deel van ons ethos bij Metaphysic is verantwoorde ontwikkeling in een AI-wereld, juist, het gaat om empowerment, maar het gaat om verantwoordelijkheid”, vertelde Alejandro Lopez, hoofd marketing van Metaphysic. decoderen. “We erkennen al snel dat het starten en ontwikkelen ervan betekent dat we letterlijk de meest kwetsbaren in onze samenleving moeten beschermen, namelijk kinderen, en helaas het donkerste uiteinde van deze technologie, die wordt gebruikt voor materiaal over seksueel misbruik van kinderen in de vorm van deep fake pornografie. , dat is gebeurd.”

Gelanceerd in 2021, metafysica kwam vorig jaar op de voorgrond nadat werd onthuld dat verschillende Hollywood-sterren, waaronder Tom Hanks, Octavia Spencer en Anne Hathaway, Metaphysic Pro-technologie gebruikten om kenmerken van hun gelijkenis te digitaliseren in een poging eigenaar te blijven van de eigenschappen die nodig zijn om een AI-model te trainen .

OpenAI weigerde verder commentaar te geven op het initiatief, maar bood in plaats daarvan decoderen een openbare verklaring van Chelsea Carlson, leider op het gebied van kinderveiligheid.

"We hechten veel waarde aan de veiligheid en het verantwoorde gebruik van onze tools, en daarom hebben we sterke vangrails en veiligheidsmaatregelen ingebouwd in ChatGPT en DALL-E", zei Carlson in een verklaring. “We zijn vastbesloten om samen te werken met Thorn, All Tech is Human en de bredere technologiegemeenschap om de Safety by Design-principes te handhaven en ons werk voort te zetten in het beperken van mogelijke schade aan kinderen.”

decoderen nam contact op met andere leden van de coalitie, maar hoorde niet onmiddellijk iets terug.

“Bij Meta hebben we meer dan tien jaar gewerkt om mensen online veilig te houden. In die tijd hebben we talloze tools en functies ontwikkeld om potentiële schade te helpen voorkomen en bestrijden – en terwijl roofdieren zich hebben aangepast om onze bescherming te ontwijken, zijn wij ons blijven aanpassen,” meta zei in een voorbereide verklaring.

“In al onze producten detecteren en verwijderen we proactief CSAE-materiaal door een combinatie van hash-matching-technologie, kunstmatige intelligentie-classificatoren en menselijke beoordelingen,” Kopen Google Reviews's vice-president van vertrouwens- en veiligheidsoplossingen Susan Jasper schreef in een bericht. “Ons beleid en onze beschermingsmaatregelen zijn ontworpen om alle soorten CSAE te detecteren, inclusief door AI gegenereerde CSAM. Wanneer we uitbuitende inhoud identificeren, verwijderen we deze en ondernemen we de juiste actie, waaronder mogelijk het rapporteren ervan aan NCMEC.”

In oktober heeft de Britse waakhondgroep de Internet Watch Foundation, waarschuwde dat door AI gegenereerd materiaal over kindermisbruik 'zou kunnen'overweldigen' het internet.

Bewerkt door Ryan Ozawa.

Blijf op de hoogte van cryptonieuws, ontvang dagelijkse updates in je inbox.

- Door SEO aangedreven content en PR-distributie. Word vandaag nog versterkt.

- PlatoData.Network Verticale generatieve AI. Versterk jezelf. Toegang hier.

- PlatoAiStream. Web3-intelligentie. Kennis versterkt. Toegang hier.

- PlatoESG. carbon, CleanTech, Energie, Milieu, Zonne, Afvalbeheer. Toegang hier.

- Plato Gezondheid. Intelligentie op het gebied van biotech en klinische proeven. Toegang hier.

- Bron: https://decrypt.co/227731/aig-csam-google-meta-openai-fight-ai-child-sexual-abuse-material