ជំនួយការបញ្ញាសិប្បនិមិត្ត (AI) សម្រាប់ការសន្ទនាត្រូវបានបង្កើតឡើងដើម្បីផ្តល់នូវការឆ្លើយតបតាមពេលវេលាជាក់ស្តែង និងច្បាស់លាស់តាមរយៈការបញ្ជូនសំណួរឆ្លាតវៃទៅកាន់មុខងារ AI ដែលសមស្របបំផុត។ ជាមួយនឹងសេវាកម្ម AI បង្កើតរបស់ AWS ដូចជា ក្រុមហ៊ុន Amazon Bedrockអ្នកអភិវឌ្ឍន៍អាចបង្កើតប្រព័ន្ធដែលគ្រប់គ្រងដោយជំនាញ និងឆ្លើយតបទៅនឹងសំណើរបស់អ្នកប្រើប្រាស់។ Amazon Bedrock គឺជាសេវាកម្មគ្រប់គ្រងពេញលេញដែលផ្តល់នូវជម្រើសនៃគំរូគ្រឹះដែលដំណើរការខ្ពស់ (FMs) ពីក្រុមហ៊ុន AI ឈានមុខគេដូចជា AI21 Labs, Anthropic, Cohere, Meta, Stability AI និង Amazon ដោយប្រើ API តែមួយ រួមជាមួយនឹងសំណុំទូលំទូលាយនៃ សមត្ថភាពដែលអ្នកត្រូវការដើម្បីបង្កើតកម្មវិធី AI ជំនាន់ថ្មីជាមួយនឹងសុវត្ថិភាព ឯកជនភាព និង AI ដែលទទួលខុសត្រូវ។

ប្រកាសនេះវាយតម្លៃវិធីសាស្រ្តចម្បងពីរសម្រាប់ការអភិវឌ្ឍជំនួយការ AI៖ ការប្រើប្រាស់សេវាកម្មគ្រប់គ្រងដូចជា ភ្នាក់ងារសម្រាប់ Amazon Bedrockនិងប្រើប្រាស់បច្ចេកវិទ្យាប្រភពបើកចំហដូចជា LangChain. យើងស្វែងយល់ពីគុណសម្បត្តិ និងបញ្ហាប្រឈមនីមួយៗ ដូច្នេះអ្នកអាចជ្រើសរើសផ្លូវសមស្របបំផុតសម្រាប់តម្រូវការរបស់អ្នក។

តើជំនួយការ AI ជាអ្វី?

ជំនួយការ AI គឺជាប្រព័ន្ធឆ្លាតវៃដែលយល់ពីសំណួរភាសាធម្មជាតិ និងធ្វើអន្តរកម្មជាមួយឧបករណ៍ផ្សេងៗ ប្រភពទិន្នន័យ និង APIs ដើម្បីបំពេញភារកិច្ច ឬទាញយកព័ត៌មានជំនួសអ្នកប្រើប្រាស់។ ជំនួយការ AI ដែលមានប្រសិទ្ធភាពមានសមត្ថភាពសំខាន់ៗដូចខាងក្រោម៖

- ដំណើរការភាសាធម្មជាតិ (NLP) និងលំហូរសន្ទនា

- ការរួមបញ្ចូលមូលដ្ឋានចំណេះដឹង និងការស្វែងរកតាមន័យធៀប ដើម្បីយល់ និងទាញយកព័ត៌មានដែលពាក់ព័ន្ធដោយផ្អែកលើខ្លឹមសារនៃការសន្ទនា

- កំពុងដំណើរការភារកិច្ច ដូចជាសំណួរមូលដ្ឋានទិន្នន័យ និងផ្ទាល់ខ្លួន AWS Lambda មុខងារ

- ដោះស្រាយការសន្ទនាឯកទេស និងសំណើរបស់អ្នកប្រើប្រាស់

យើងបង្ហាញពីអត្ថប្រយោជន៍នៃជំនួយការ AI ដោយប្រើការគ្រប់គ្រងឧបករណ៍ Internet of Things (IoT) ជាឧទាហរណ៍។ នៅក្នុងករណីនៃការប្រើប្រាស់នេះ AI អាចជួយអ្នកបច្ចេកទេសគ្រប់គ្រងម៉ាស៊ីនប្រកបដោយប្រសិទ្ធភាពជាមួយនឹងពាក្យបញ្ជាដែលទាញយកទិន្នន័យ ឬធ្វើកិច្ចការដោយស្វ័យប្រវត្តិ សម្រួលប្រតិបត្តិការក្នុងការផលិត។

ភ្នាក់ងារសម្រាប់វិធីសាស្រ្ត Amazon Bedrock

ភ្នាក់ងារសម្រាប់ Amazon Bedrock អនុញ្ញាតឱ្យអ្នកបង្កើតកម្មវិធី AI ជំនាន់ថ្មីដែលអាចដំណើរការកិច្ចការច្រើនជំហាននៅទូទាំងប្រព័ន្ធ និងប្រភពទិន្នន័យរបស់ក្រុមហ៊ុន។ វាផ្តល់នូវសមត្ថភាពសំខាន់ៗដូចខាងក្រោមៈ

- ការបង្កើតប្រអប់បញ្ចូលដោយស្វ័យប្រវត្តិពីការណែនាំ ព័ត៌មានលម្អិត API និងព័ត៌មានប្រភពទិន្នន័យ រក្សាទុកសប្តាហ៍នៃការខិតខំប្រឹងប្រែងផ្នែកវិស្វកម្មភ្លាមៗ

- Retrieval Augmented Generation (RAG) ដើម្បីភ្ជាប់ភ្នាក់ងារដោយសុវត្ថិភាពទៅនឹងប្រភពទិន្នន័យរបស់ក្រុមហ៊ុន និងផ្តល់ការឆ្លើយតបដែលពាក់ព័ន្ធ

- ការរៀបចំ និងការដំណើរការកិច្ចការច្រើនជំហានដោយបំបែកសំណើទៅជាលំដាប់ឡូជីខល និងការហៅ APIs ចាំបាច់

- ភាពមើលឃើញចូលទៅក្នុងការវែកញែករបស់ភ្នាក់ងារតាមរយៈខ្សែសង្វាក់នៃការគិត (CoT) ដែលអនុញ្ញាតឱ្យដោះស្រាយបញ្ហា និងការដឹកនាំឥរិយាបថគំរូ

- ជម្រុញសមត្ថភាពវិស្វកម្មដើម្បីកែប្រែគំរូប្រអប់បញ្ចូលដែលបានបង្កើតដោយស្វ័យប្រវត្តិសម្រាប់ការគ្រប់គ្រងដែលប្រសើរឡើងលើភ្នាក់ងារ

អ្នកអាចប្រើភ្នាក់ងារសម្រាប់ Amazon Bedrock និង មូលដ្ឋានចំណេះដឹងសម្រាប់ Amazon Bedrock បង្កើត និងប្រើប្រាស់ជំនួយការ AI សម្រាប់ករណីប្រើប្រាស់ផ្លូវស្មុគស្មាញ។ ពួកគេផ្តល់អត្ថប្រយោជន៍ជាយុទ្ធសាស្រ្តសម្រាប់អ្នកអភិវឌ្ឍន៍ និងអង្គការនានា ដោយធ្វើឱ្យការគ្រប់គ្រងហេដ្ឋារចនាសម្ព័ន្ធងាយស្រួល បង្កើនទំហំ ធ្វើអោយប្រសើរឡើងនូវសុវត្ថិភាព និងកាត់បន្ថយការលើកទម្ងន់ធ្ងន់ដែលមិនមានលក្ខណៈខុសគ្នា។ ពួកគេក៏អនុញ្ញាតឱ្យមានកូដស្រទាប់កម្មវិធីសាមញ្ញជាងមុនផងដែរ ដោយសារតែតក្កកម្មផ្លូវ ការ វ៉ិចទ័រ និងអង្គចងចាំត្រូវបានគ្រប់គ្រងយ៉ាងពេញលេញ។

ទិដ្ឋភាពទូទៅនៃដំណោះស្រាយ

ដំណោះស្រាយនេះណែនាំជំនួយការ AI សម្រាប់ការសន្ទនាដែលត្រូវបានរចនាឡើងសម្រាប់ការគ្រប់គ្រង និងប្រតិបត្តិការឧបករណ៍ IoT នៅពេលប្រើ Claude v2.1 របស់ Anthropic នៅលើ Amazon Bedrock ។ មុខងារស្នូលរបស់ជំនួយការ AI ត្រូវបានគ្រប់គ្រងដោយសំណុំនៃការណែនាំដ៏ទូលំទូលាយ ដែលត្រូវបានគេស្គាល់ថាជា ការជម្រុញប្រព័ន្ធដែលកំណត់ពីសមត្ថភាព និងផ្នែកជំនាញរបស់ខ្លួន។ ការណែនាំនេះធ្វើឱ្យប្រាកដថា ជំនួយការ AI អាចដោះស្រាយកិច្ចការជាច្រើន ចាប់ពីការគ្រប់គ្រងព័ត៌មានឧបករណ៍ រហូតដល់ដំណើរការពាក្យបញ្ជាប្រតិបត្តិការ។

បំពាក់ដោយសមត្ថភាពទាំងនេះ ដូចដែលបានរៀបរាប់លម្អិតនៅក្នុងប្រអប់បញ្ចូលប្រព័ន្ធ ជំនួយការ AI ធ្វើតាមដំណើរការការងារដែលមានរចនាសម្ព័ន្ធដើម្បីដោះស្រាយសំណួរអ្នកប្រើប្រាស់។ រូបខាងក្រោមផ្តល់នូវតំណាងដែលមើលឃើញនៃលំហូរការងារនេះ ដោយបង្ហាញជំហាននីមួយៗពីអន្តរកម្មអ្នកប្រើប្រាស់ដំបូងរហូតដល់ការឆ្លើយតបចុងក្រោយ។

ដំណើរការការងារមានជំហានដូចខាងក្រោមៈ

- ដំណើរការចាប់ផ្តើមនៅពេលដែលអ្នកប្រើប្រាស់ស្នើសុំជំនួយការដើម្បីបំពេញភារកិច្ចមួយ។ ឧទាហរណ៍ ការស្នើសុំចំណុចទិន្នន័យអតិបរមាសម្រាប់ឧបករណ៍ IoT ជាក់លាក់មួយ។

device_xxx. ការបញ្ចូលអត្ថបទនេះត្រូវបានចាប់យក និងផ្ញើទៅកាន់ជំនួយការ AI ។ - ជំនួយការ AI បកស្រាយការបញ្ចូលអត្ថបទរបស់អ្នកប្រើប្រាស់។ វាប្រើប្រវត្តិនៃការសន្ទនា ក្រុមសកម្មភាព និងមូលដ្ឋានចំណេះដឹងដែលបានផ្តល់ ដើម្បីយល់ពីបរិបទ និងកំណត់កិច្ចការចាំបាច់។

- បន្ទាប់ពីចេតនារបស់អ្នកប្រើត្រូវបានញែក និងយល់ ជំនួយការ AI កំណត់ភារកិច្ច។ នេះគឺផ្អែកលើការណែនាំដែលត្រូវបានបកស្រាយដោយជំនួយការតាមប្រអប់បញ្ចូលរបស់ប្រព័ន្ធ និងការបញ្ចូលរបស់អ្នកប្រើប្រាស់។

- បន្ទាប់មកភារកិច្ចត្រូវបានដំណើរការតាមរយៈការហៅ API ជាបន្តបន្ទាប់។ នេះត្រូវបានធ្វើដោយប្រើ សកម្មភាពឡើងវិញ prompting ដែលបំបែកភារកិច្ចទៅជាស៊េរីនៃជំហានដែលត្រូវបានដំណើរការជាបន្តបន្ទាប់៖

- សម្រាប់ការត្រួតពិនិត្យឧបករណ៍វាស់ស្ទង់ យើងប្រើ

check-device-metricsក្រុមសកម្មភាពដែលពាក់ព័ន្ធនឹងការហៅ API ទៅកាន់មុខងារ Lambda ដែលបន្ទាប់មកសួរ អាម៉ាហ្សូនអាថេណា សម្រាប់ទិន្នន័យដែលបានស្នើសុំ។ - សម្រាប់សកម្មភាពផ្ទាល់របស់ឧបករណ៍ដូចជា ចាប់ផ្តើម បញ្ឈប់ ឬចាប់ផ្តើមឡើងវិញ យើងប្រើប៊ូតុង

action-on-deviceក្រុមសកម្មភាពដែលហៅមុខងារ Lambda ។ មុខងារនេះចាប់ផ្តើមដំណើរការដែលផ្ញើពាក្យបញ្ជាទៅកាន់ឧបករណ៍ IoT ។ សម្រាប់ការប្រកាសនេះ មុខងារ Lambda ផ្ញើការជូនដំណឹងដោយប្រើ សេវាកម្មអ៊ីមែលសាមញ្ញរបស់ក្រុមហ៊ុន Amazon (Amazon SES) ។ - យើងប្រើ Knowledge Bases សម្រាប់ Amazon Bedrock ដើម្បីទាញយកពីទិន្នន័យប្រវត្តិសាស្រ្តដែលបានរក្សាទុកជាការបង្កប់នៅក្នុង សេវាកម្ម Amazon OpenSearch មូលដ្ឋានទិន្នន័យវ៉ិចទ័រ។

- សម្រាប់ការត្រួតពិនិត្យឧបករណ៍វាស់ស្ទង់ យើងប្រើ

- បន្ទាប់ពីកិច្ចការត្រូវបានបញ្ចប់ ការឆ្លើយតបចុងក្រោយត្រូវបានបង្កើតឡើងដោយ Amazon Bedrock FM ហើយបញ្ជូនត្រឡប់ទៅអ្នកប្រើប្រាស់វិញ។

- ភ្នាក់ងារសម្រាប់ Amazon Bedrock រក្សាទុកព័ត៌មានដោយស្វ័យប្រវត្តិ ដោយប្រើវគ្គរដ្ឋ ដើម្បីរក្សាការសន្ទនាដដែល។ ស្ថានភាពត្រូវបានលុបបន្ទាប់ពីការអស់ពេលទំនេរដែលអាចកំណត់រចនាសម្ព័ន្ធបានកន្លងផុតទៅ។

ទិដ្ឋភាពបច្ចេកទេស

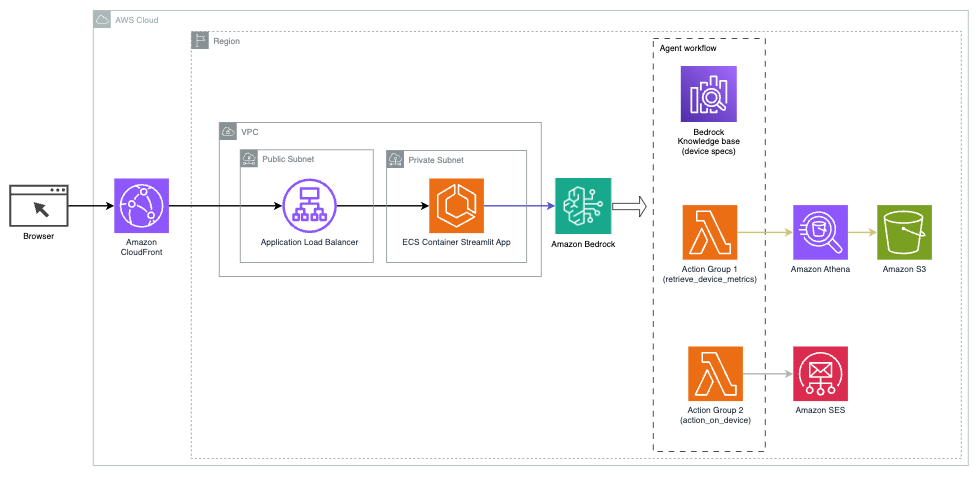

ដ្យាក្រាមខាងក្រោមបង្ហាញពីស្ថាបត្យកម្មដើម្បីដាក់ពង្រាយជំនួយការ AI ជាមួយភ្នាក់ងារសម្រាប់ Amazon Bedrock ។

វាមានសមាសធាតុសំខាន់ៗដូចខាងក្រោមៈ

- ចំណុចប្រទាក់សន្ទនា - ចំណុចប្រទាក់សន្ទនាប្រើ Streamlit ដែលជាបណ្ណាល័យ Python ប្រភពបើកចំហដែលជួយសម្រួលដល់ការបង្កើតកម្មវិធីគេហទំព័រផ្ទាល់ខ្លួន ទាក់ទាញដោយមើលឃើញសម្រាប់ការរៀនម៉ាស៊ីន (ML) និងវិទ្យាសាស្ត្រទិន្នន័យ។ វាត្រូវបានរៀបចំនៅលើ សេវាកម្មកុងតឺន័រអេល្យូមអេល (Amazon ECS) ជាមួយ អេសអេចហ្វាហ្គេតហើយវាត្រូវបានចូលប្រើដោយប្រើ Application Load Balancer។ អ្នកអាចប្រើ Fargate ជាមួយ Amazon ECS ដើម្បីដំណើរការ ធុង ដោយមិនចាំបាច់គ្រប់គ្រងម៉ាស៊ីនមេ ចង្កោម ឬម៉ាស៊ីននិម្មិត។

- ភ្នាក់ងារសម្រាប់ Amazon Bedrock - ភ្នាក់ងារសម្រាប់ Amazon Bedrock បំពេញសំណួរអ្នកប្រើប្រាស់តាមរយៈជំហាននៃហេតុផល និងសកម្មភាពដែលត្រូវគ្នាដោយផ្អែកលើ ការជំរុញឱ្យធ្វើសកម្មភាពឡើងវិញ:

- មូលដ្ឋានចំណេះដឹងសម្រាប់ Amazon Bedrock - មូលដ្ឋានចំណេះដឹងសម្រាប់ Amazon Bedrock ផ្តល់នូវការគ្រប់គ្រងយ៉ាងពេញលេញ រ៉ាក ដើម្បីផ្គត់ផ្គង់ជំនួយការ AI ជាមួយនឹងការចូលប្រើទិន្នន័យរបស់អ្នក។ ក្នុងករណីប្រើប្រាស់របស់យើង យើងបានផ្ទុកឡើងនូវលក្ខណៈពិសេសរបស់ឧបករណ៍ទៅក្នុង សេវាកម្មផ្ទុកសាមញ្ញរបស់ក្រុមហ៊ុន Amazon (Amazon S3) ដាក់ធុង។ វាបម្រើជាប្រភពទិន្នន័យដល់មូលដ្ឋានចំណេះដឹង។

- ក្រុមសកម្មភាព - ទាំងនេះគឺជាគ្រោងការណ៍ API ដែលបានកំណត់ដែលហៅមុខងារ Lambda ជាក់លាក់ដើម្បីធ្វើអន្តរកម្មជាមួយឧបករណ៍ IoT និងសេវាកម្ម AWS ផ្សេងទៀត។

- Anthropic Claude v2.1 នៅលើ Amazon Bedrock - គំរូនេះបកស្រាយសំណួររបស់អ្នកប្រើ និងរៀបចំលំហូរនៃកិច្ចការ។

- Amazon Titan បង្កប់ - គំរូនេះបម្រើជាគំរូបង្កប់អត្ថបទ បំប្លែងអត្ថបទភាសាធម្មជាតិ—ពីពាក្យតែមួយទៅឯកសារស្មុគស្មាញ—ទៅជាវ៉ិចទ័រជាលេខ។ វាបើកសមត្ថភាពស្វែងរកវ៉ិចទ័រ ដែលអនុញ្ញាតឱ្យប្រព័ន្ធផ្គូផ្គងសំណួររបស់អ្នកប្រើជាន័យធៀបជាមួយនឹងធាតុមូលដ្ឋានចំណេះដឹងដែលពាក់ព័ន្ធបំផុតសម្រាប់ការស្វែងរកប្រកបដោយប្រសិទ្ធភាព។

ដំណោះស្រាយត្រូវបានរួមបញ្ចូលជាមួយសេវាកម្ម AWS ដូចជា Lambda សម្រាប់ដំណើរការកូដក្នុងការឆ្លើយតបទៅនឹងការហៅ API, Athena សម្រាប់សំណួរសំណុំទិន្នន័យ, សេវា OpenSearch សម្រាប់ស្វែងរកតាមរយៈមូលដ្ឋានចំណេះដឹង និង Amazon S3 សម្រាប់ការផ្ទុក។ សេវាកម្មទាំងនេះធ្វើការរួមគ្នាដើម្បីផ្តល់នូវបទពិសោធន៍គ្មានថ្នេរសម្រាប់ការគ្រប់គ្រងប្រតិបត្តិការឧបករណ៍ IoT តាមរយៈពាក្យបញ្ជាភាសាធម្មជាតិ។

អត្ថប្រយោជន៍

ដំណោះស្រាយនេះផ្តល់អត្ថប្រយោជន៍ដូចខាងក្រោមៈ

- ភាពស្មុគស្មាញនៃការអនុវត្ត៖

- តម្រូវឱ្យមានបន្ទាត់កូដតិចជាងនេះ ព្រោះភ្នាក់ងារសម្រាប់ Amazon Bedrock ដកស្រង់ចេញពីភាពស្មុគស្មាញជាច្រើន ដែលកាត់បន្ថយការខិតខំប្រឹងប្រែងក្នុងការអភិវឌ្ឍ។

- ការគ្រប់គ្រងមូលដ្ឋានទិន្នន័យវ៉ិចទ័រដូចជា OpenSearch Service មានភាពសាមញ្ញ ពីព្រោះ Knowledge Bases សម្រាប់ Amazon Bedrock គ្រប់គ្រងវ៉ិចទ័រ និងការផ្ទុក

- ការរួមបញ្ចូលជាមួយសេវាកម្ម AWS ផ្សេងៗត្រូវបានសម្រួលជាងមុនតាមរយៈក្រុមសកម្មភាពដែលបានកំណត់ជាមុន

- បទពិសោធន៍អ្នកអភិវឌ្ឍន៍៖

- កុងសូល Amazon Bedrock ផ្តល់នូវចំណុចប្រទាក់ងាយស្រួលប្រើសម្រាប់ការអភិវឌ្ឍន៍ ការធ្វើតេស្ត និងការវិភាគមូលហេតុឫសគល់ (RCA) ដែលបង្កើនបទពិសោធន៍របស់អ្នកអភិវឌ្ឍន៍ទាំងមូល។

- ភាពរហ័សរហួននិងភាពបត់បែន៖

- ភ្នាក់ងារសម្រាប់ Amazon Bedrock អនុញ្ញាតឱ្យមានការអាប់ដេតយ៉ាងរលូនទៅកាន់ FMs ថ្មីជាងនេះ (ដូចជា Claude 3.0) នៅពេលដែលពួកវាមានស្រាប់ ដូច្នេះដំណោះស្រាយរបស់អ្នកនៅតែទាន់សម័យជាមួយនឹងភាពជឿនលឿនចុងក្រោយបំផុត។

- កូតាសេវាកម្ម និងដែនកំណត់ត្រូវបានគ្រប់គ្រងដោយ AWS កាត់បន្ថយការចំណាយលើការត្រួតពិនិត្យ និងធ្វើមាត្រដ្ឋានហេដ្ឋារចនាសម្ព័ន្ធ

- សុវត្ថិភាព:

- Amazon Bedrock គឺជាសេវាកម្មដែលគ្រប់គ្រងយ៉ាងពេញលេញ ដោយប្រកាន់ខ្ជាប់នូវស្តង់ដារសុវត្ថិភាព និងអនុលោមភាពដ៏តឹងរ៉ឹងរបស់ AWS ដែលអាចធ្វើអោយការពិនិត្យមើលសុវត្ថិភាពរបស់ស្ថាប័នមានភាពសាមញ្ញ។

ទោះបីជាភ្នាក់ងារសម្រាប់ Amazon Bedrock ផ្តល់នូវដំណោះស្រាយងាយស្រួល និងគ្រប់គ្រងសម្រាប់ការកសាងកម្មវិធី AI សន្ទនាក៏ដោយ អង្គការមួយចំនួនអាចចូលចិត្តវិធីសាស្រ្តប្រភពបើកចំហ។ ក្នុងករណីបែបនេះ អ្នកអាចប្រើក្របខ័ណ្ឌដូចជា LangChain ដែលយើងពិភាក្សានៅក្នុងផ្នែកបន្ទាប់។

វិធីសាស្រ្តកំណត់ទិសដៅថាមវន្ត LangChain

LangChain គឺជាក្របខ័ណ្ឌប្រភពបើកចំហដែលជួយសម្រួលដល់ការកសាង AI ការសន្ទនាដោយអនុញ្ញាតឱ្យមានការរួមបញ្ចូលនៃគំរូភាសាធំ (LLMs) និងសមត្ថភាពបញ្ជូនផ្លូវថាមវន្ត។ ជាមួយ LangChain Expression Language (LCEL) អ្នកអភិវឌ្ឍន៍អាចកំណត់ routingដែលអនុញ្ញាតឱ្យអ្នកបង្កើតខ្សែសង្វាក់មិនកំណត់ដែលលទ្ធផលនៃជំហានមុនកំណត់ជំហានបន្ទាប់។ ការកំណត់ផ្លូវជួយផ្តល់នូវរចនាសម្ព័ន្ធ និងភាពស៊ីសង្វាក់គ្នាក្នុងអន្តរកម្មជាមួយ LLMs ។

សម្រាប់ការប្រកាសនេះ យើងប្រើឧទាហរណ៍ដូចគ្នានឹងជំនួយការ AI សម្រាប់ការគ្រប់គ្រងឧបករណ៍ IoT ។ ទោះជាយ៉ាងណាក៏ដោយ ភាពខុសគ្នាចំបងគឺថាយើងត្រូវដោះស្រាយការជំរុញប្រព័ន្ធដោយឡែកពីគ្នា និងចាត់ទុកខ្សែសង្វាក់នីមួយៗជាអង្គភាពដាច់ដោយឡែកមួយ។ ខ្សែសង្វាក់នាំផ្លូវសម្រេចចិត្តខ្សែសង្វាក់ទិសដៅដោយផ្អែកលើការបញ្ចូលរបស់អ្នកប្រើប្រាស់។ ការសម្រេចចិត្តត្រូវបានធ្វើឡើងដោយមានការគាំទ្រពី LLM ដោយឆ្លងកាត់ប្រអប់បញ្ចូលប្រព័ន្ធ ប្រវត្តិជជែក និងសំណួររបស់អ្នកប្រើប្រាស់។

ទិដ្ឋភាពទូទៅនៃដំណោះស្រាយ

ដ្យាក្រាមខាងក្រោមបង្ហាញអំពីលំហូរការងារនៃដំណោះស្រាយផ្លូវថាមវន្ត។

ដំណើរការការងារមានជំហានដូចខាងក្រោមៈ

- អ្នកប្រើប្រាស់បង្ហាញសំណួរទៅកាន់ជំនួយការ AI ។ ឧទាហរណ៍ "តើអ្វីជាម៉ែត្រអតិបរមាសម្រាប់ឧបករណ៍ 1009?"

- LLM វាយតម្លៃសំណួរនីមួយៗ រួមជាមួយនឹងប្រវត្តិជជែកពីសម័យដូចគ្នា ដើម្បីកំណត់លក្ខណៈរបស់វា និងប្រធានបទណាដែលវាស្ថិតនៅក្រោម (ដូចជា SQL សកម្មភាព ស្វែងរក ឬ SME)។ LLM ចាត់ថ្នាក់ធាតុបញ្ចូល ហើយខ្សែសង្វាក់កំណត់ផ្លូវ LCEL យកធាតុបញ្ចូលនោះ។

- ខ្សែសង្វាក់រ៉ោតទ័រជ្រើសរើសខ្សែសង្វាក់ទិសដៅដោយផ្អែកលើការបញ្ចូល ហើយ LLM ត្រូវបានផ្តល់ជូនជាមួយនឹងប្រអប់បញ្ចូលប្រព័ន្ធដូចខាងក្រោមៈ

LLM វាយតម្លៃសំណួររបស់អ្នកប្រើ រួមជាមួយនឹងប្រវត្តិជជែក ដើម្បីកំណត់លក្ខណៈនៃសំណួរ និងប្រធានបទណាដែលវាស្ថិតនៅក្រោម។ បន្ទាប់មក LLM ចាត់ថ្នាក់ការបញ្ចូល និងបញ្ចេញការឆ្លើយតប JSON ក្នុងទម្រង់ខាងក្រោម៖

ខ្សែសង្វាក់រ៉ោតទ័រប្រើការឆ្លើយតប JSON នេះដើម្បីហៅខ្សែសង្វាក់ទិសដៅដែលត្រូវគ្នា។ មានខ្សែសង្វាក់ទិសដៅជាក់លាក់ចំនួនបួន ដែលនីមួយៗមានប្រព័ន្ធបញ្ចូលរបស់វា៖

- សំណួរដែលទាក់ទងនឹង SQL ត្រូវបានផ្ញើទៅកាន់ខ្សែសង្វាក់ទិសដៅ SQL សម្រាប់អន្តរកម្មមូលដ្ឋានទិន្នន័យ។ អ្នកអាចប្រើ LCEL ដើម្បីបង្កើត ខ្សែសង្វាក់ SQL ។

- សំណួរតម្រង់ទិសសកម្មភាពហៅខ្សែសង្វាក់ទិសដៅ Lambda ផ្ទាល់ខ្លួនសម្រាប់ប្រតិបត្តិការដែលកំពុងដំណើរការ។ ជាមួយនឹង LCEL អ្នកអាចកំណត់ដោយខ្លួនឯងបាន។ មុខងារផ្ទាល់ខ្លួន; ក្នុងករណីរបស់យើង វាជាមុខងារមួយដើម្បីដំណើរការមុខងារ Lambda ដែលបានកំណត់ជាមុន ដើម្បីផ្ញើអ៊ីមែលដែលមានលេខសម្គាល់ឧបករណ៍ដែលបានញែក។ ឧទាហរណ៍ការបញ្ចូលរបស់អ្នកប្រើអាចជា "បិទឧបករណ៍ 1009" ។

- ការស៊ើបអង្កេតដែលផ្តោតលើការស្វែងរកបន្តទៅ រ៉ាក ខ្សែសង្វាក់ទិសដៅសម្រាប់ការទាញយកព័ត៌មាន។

- សំណួរទាក់ទងនឹងសហគ្រាសធុនតូច និងមធ្យម សូមចូលទៅកាន់ខ្សែសង្វាក់គោលដៅ SME/អ្នកជំនាញ សម្រាប់ការយល់ដឹងពិសេស។

- ខ្សែសង្វាក់ទិសដៅនីមួយៗយកធាតុបញ្ចូល ហើយដំណើរការគំរូ ឬមុខងារចាំបាច់៖

- ខ្សែសង្វាក់ SQL ប្រើ Athena សម្រាប់ដំណើរការសំណួរ។

- ខ្សែសង្វាក់ RAG ប្រើប្រាស់សេវាកម្ម OpenSearch សម្រាប់ការស្វែងរកតាមន័យធៀប។

- ខ្សែសង្វាក់ Lambda ផ្ទាល់ខ្លួនដំណើរការមុខងារ Lambda សម្រាប់សកម្មភាព។

- ខ្សែសង្វាក់ SME / អ្នកជំនាញផ្តល់ការយល់ដឹងដោយប្រើគំរូ Amazon Bedrock ។

- ការឆ្លើយតបពីខ្សែសង្វាក់ទិសដៅនីមួយៗត្រូវបានបង្កើតទៅជាការយល់ដឹងស៊ីសង្វាក់គ្នាដោយ LLM ។ បន្ទាប់មក ការយល់ដឹងទាំងនេះត្រូវបានបញ្ជូនទៅអ្នកប្រើប្រាស់ ដោយបញ្ចប់វដ្តសំណួរ។

- ការបញ្ចូល និងការឆ្លើយតបរបស់អ្នកប្រើប្រាស់ត្រូវបានរក្សាទុកក្នុង ក្រុមហ៊ុន Amazon DynamoDB ដើម្បីផ្តល់បរិបទដល់ LLM សម្រាប់វគ្គបច្ចុប្បន្ន និងពីអន្តរកម្មកន្លងមក។ រយៈពេលនៃព័ត៌មានបន្តនៅក្នុង DynamoDB ត្រូវបានគ្រប់គ្រងដោយកម្មវិធី។

ទិដ្ឋភាពបច្ចេកទេស

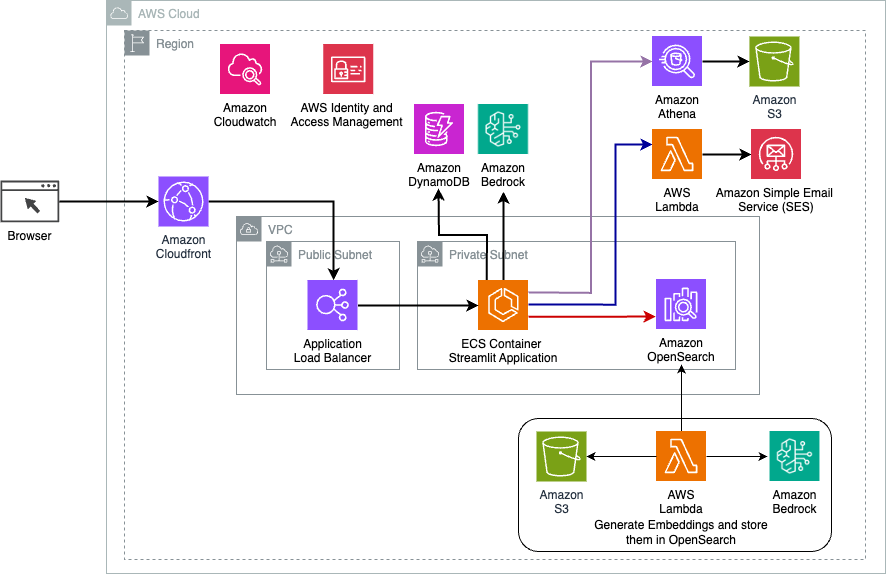

ដ្យាក្រាមខាងក្រោមបង្ហាញពីស្ថាបត្យកម្មនៃដំណោះស្រាយការនាំផ្លូវថាមវន្ត LangChain ។

កម្មវិធីបណ្តាញនេះត្រូវបានបង្កើតឡើងនៅលើ Streamlit ដែលបង្ហោះនៅលើ Amazon ECS ជាមួយ Fargate ហើយវាត្រូវបានចូលប្រើដោយប្រើ Application Load Balancer ។ យើងប្រើ Anthropic's Claude v2.1 នៅលើ Amazon Bedrock ជា LLM របស់យើង។ កម្មវិធីបណ្តាញធ្វើអន្តរកម្មជាមួយគំរូដោយប្រើបណ្ណាល័យ LangChain ។ វាក៏មានអន្តរកម្មជាមួយនឹងសេវាកម្ម AWS ផ្សេងៗដូចជា OpenSearch Service, Athena, និង DynamoDB ដើម្បីបំពេញតម្រូវការរបស់អ្នកប្រើប្រាស់ចុងក្រោយ។

អត្ថប្រយោជន៍

ដំណោះស្រាយនេះផ្តល់អត្ថប្រយោជន៍ដូចខាងក្រោមៈ

- ភាពស្មុគស្មាញនៃការអនុវត្ត៖

- ទោះបីជាវាទាមទារកូដ និងការអភិវឌ្ឍន៍ផ្ទាល់ខ្លួនក៏ដោយ LangChain ផ្តល់នូវភាពបត់បែន និងការគ្រប់គ្រងកាន់តែច្រើនលើតក្កវិជ្ជាផ្លូវ និងការរួមបញ្ចូលជាមួយសមាសធាតុផ្សេងៗ។

- ការគ្រប់គ្រងមូលដ្ឋានទិន្នន័យវ៉ិចទ័រដូចជាសេវាកម្ម OpenSearch ទាមទារឱ្យមានការដំឡើងបន្ថែម និងកិច្ចខិតខំប្រឹងប្រែងក្នុងការកំណត់រចនាសម្ព័ន្ធ។ ដំណើរការវ៉ិចទ័រត្រូវបានអនុវត្តនៅក្នុងកូដ។

- ការរួមបញ្ចូលជាមួយសេវាកម្ម AWS អាចពាក់ព័ន្ធនឹងកូដផ្ទាល់ខ្លួន និងការកំណត់រចនាសម្ព័ន្ធបន្ថែមទៀត។

- បទពិសោធន៍អ្នកអភិវឌ្ឍន៍៖

- វិធីសាស្រ្តផ្អែកលើ Python របស់ LangChain និងឯកសារទូលំទូលាយអាចទាក់ទាញអ្នកអភិវឌ្ឍន៍ដែលធ្លាប់ស្គាល់ Python និងឧបករណ៍ប្រភពបើកចំហ។

- ការអភិវឌ្ឍន៍ និងការបំបាត់កំហុសភ្លាមៗអាចត្រូវការការខិតខំប្រឹងប្រែងដោយដៃបន្ថែមទៀតបើប្រៀបធៀបទៅនឹងការប្រើប្រាស់កុងសូល Amazon Bedrock ។

- ភាពរហ័សរហួននិងភាពបត់បែន៖

- LangChain គាំទ្រ LLMs ជាច្រើនដែលអនុញ្ញាតឱ្យអ្នកប្តូររវាងម៉ូដែល ឬអ្នកផ្តល់សេវាផ្សេងៗ ជំរុញភាពបត់បែន។

- ធម្មជាតិប្រភពបើកចំហរបស់ LangChain អនុញ្ញាតឱ្យមានការកែលម្អ និងការប្ដូរតាមបំណងដែលជំរុញដោយសហគមន៍។

- សុវត្ថិភាព:

- ក្នុងនាមជាក្របខ័ណ្ឌប្រភពបើកចំហ LangChain ប្រហែលជាត្រូវការការត្រួតពិនិត្យសុវត្ថិភាព និងការត្រួតពិនិត្យយ៉ាងម៉ត់ចត់បន្ថែមទៀតនៅក្នុងស្ថាប័ន ដែលអាចបន្ថែមការចំណាយលើស។

សន្និដ្ឋាន

ជំនួយការ AI ការសន្ទនាគឺជាឧបករណ៍បំប្លែងសម្រាប់សម្រួលប្រតិបត្តិការ និងបង្កើនបទពិសោធន៍អ្នកប្រើប្រាស់។ ការបង្ហោះនេះបានស្វែងយល់ពីវិធីសាស្រ្តដ៏មានឥទ្ធិពលពីរដោយប្រើប្រាស់សេវាកម្ម AWS: ភ្នាក់ងារគ្រប់គ្រងសម្រាប់ Amazon Bedrock និងប្រភពបើកចំហរដែលអាចបត់បែនបាន LangChain ថាមវន្ត routing ។ ជម្រើសរវាងវិធីសាស្រ្តទាំងនេះពឹងផ្អែកលើតម្រូវការរបស់ស្ថាប័ន ចំណូលចិត្តក្នុងការអភិវឌ្ឍន៍ និងកម្រិតដែលចង់បាន។ ដោយមិនគិតពីផ្លូវដែលត្រូវអនុវត្តនោះ AWS ផ្តល់សិទ្ធិអំណាចឱ្យអ្នកបង្កើតជំនួយការ AI ដ៏ឆ្លាតវៃដែលផ្លាស់ប្តូរទំនាក់ទំនងអាជីវកម្ម និងអតិថិជន

ស្វែងរកលេខកូដដំណោះស្រាយ និងការដាក់ពង្រាយទ្រព្យសម្បត្តិនៅក្នុងរបស់យើង។ ឃ្លាំង GitHubដែលជាកន្លែងដែលអ្នកអាចអនុវត្តតាមជំហានលម្អិតសម្រាប់វិធីសាស្រ្ត AI សន្ទនានីមួយៗ។

អំពីនិពន្ធនេះ

អាមឺរ ហាក់មេ គឺជាស្ថាបត្យករដំណោះស្រាយ AWS ដែលមានមូលដ្ឋាននៅរដ្ឋ Pennsylvania ។ គាត់សហការជាមួយអ្នកលក់កម្មវិធីឯករាជ្យ (ISVs) នៅក្នុងតំបន់ភាគឦសាន ដោយជួយពួកគេក្នុងការរចនា និងបង្កើតវេទិកាដែលអាចធ្វើមាត្រដ្ឋានបាន និងទំនើបនៅលើ AWS Cloud។ អ្នកជំនាញផ្នែក AI/ML និង AI ជំនាន់ថ្មី Ameer ជួយអតិថិជនដោះសោសក្តានុពលនៃបច្ចេកវិទ្យាទំនើបទាំងនេះ។ ក្នុងពេលទំនេរ គាត់ចូលចិត្តជិះម៉ូតូ និងចំណាយពេលវេលាប្រកបដោយគុណភាពជាមួយគ្រួសារ។

អាមឺរ ហាក់មេ គឺជាស្ថាបត្យករដំណោះស្រាយ AWS ដែលមានមូលដ្ឋាននៅរដ្ឋ Pennsylvania ។ គាត់សហការជាមួយអ្នកលក់កម្មវិធីឯករាជ្យ (ISVs) នៅក្នុងតំបន់ភាគឦសាន ដោយជួយពួកគេក្នុងការរចនា និងបង្កើតវេទិកាដែលអាចធ្វើមាត្រដ្ឋានបាន និងទំនើបនៅលើ AWS Cloud។ អ្នកជំនាញផ្នែក AI/ML និង AI ជំនាន់ថ្មី Ameer ជួយអតិថិជនដោះសោសក្តានុពលនៃបច្ចេកវិទ្យាទំនើបទាំងនេះ។ ក្នុងពេលទំនេរ គាត់ចូលចិត្តជិះម៉ូតូ និងចំណាយពេលវេលាប្រកបដោយគុណភាពជាមួយគ្រួសារ។

សារ៉ុន លី គឺជាស្ថាបត្យករ AI/ML Solutions នៅ Amazon Web Services ដែលមានមូលដ្ឋាននៅទីក្រុង Boston ជាមួយនឹងចំណង់ចំណូលចិត្តក្នុងការរចនា និងបង្កើតកម្មវិធី Generative AI នៅលើ AWS។ នាងសហការជាមួយអតិថិជនដើម្បីប្រើប្រាស់សេវាកម្ម AWS AI/ML សម្រាប់ដំណោះស្រាយប្រកបដោយភាពច្នៃប្រឌិត។

សារ៉ុន លី គឺជាស្ថាបត្យករ AI/ML Solutions នៅ Amazon Web Services ដែលមានមូលដ្ឋាននៅទីក្រុង Boston ជាមួយនឹងចំណង់ចំណូលចិត្តក្នុងការរចនា និងបង្កើតកម្មវិធី Generative AI នៅលើ AWS។ នាងសហការជាមួយអតិថិជនដើម្បីប្រើប្រាស់សេវាកម្ម AWS AI/ML សម្រាប់ដំណោះស្រាយប្រកបដោយភាពច្នៃប្រឌិត។

កៅសា កាម៉ាល់ គឺជាស្ថាបត្យករដំណោះស្រាយជាន់ខ្ពស់នៅ Amazon Web Services ដែលមានបទពិសោធន៍ជាង 15 ឆ្នាំនៅក្នុងប្រព័ន្ធស្វ័យប្រវត្តិកម្មហេដ្ឋារចនាសម្ព័ន្ធ និងកន្លែងសុវត្ថិភាព។ គាត់ជួយអតិថិជនក្នុងការរចនា និងបង្កើតដំណោះស្រាយ DevSecOps និង AI/ML ដែលអាចធ្វើមាត្រដ្ឋានបាននៅក្នុងពពក។

កៅសា កាម៉ាល់ គឺជាស្ថាបត្យករដំណោះស្រាយជាន់ខ្ពស់នៅ Amazon Web Services ដែលមានបទពិសោធន៍ជាង 15 ឆ្នាំនៅក្នុងប្រព័ន្ធស្វ័យប្រវត្តិកម្មហេដ្ឋារចនាសម្ព័ន្ធ និងកន្លែងសុវត្ថិភាព។ គាត់ជួយអតិថិជនក្នុងការរចនា និងបង្កើតដំណោះស្រាយ DevSecOps និង AI/ML ដែលអាចធ្វើមាត្រដ្ឋានបាននៅក្នុងពពក។

- SEO ដែលដំណើរការដោយមាតិកា និងការចែកចាយ PR ។ ទទួលបានការពង្រីកថ្ងៃនេះ។

- PlatoData.Network Vertical Generative Ai. ផ្តល់អំណាចដល់ខ្លួនអ្នក។ ចូលប្រើទីនេះ។

- PlatoAiStream Web3 Intelligence ។ ចំណេះដឹងត្រូវបានពង្រីក។ ចូលប្រើទីនេះ។

- ផ្លាតូអេសជី។ កាបូន CleanTech, ថាមពល, បរិស្ថាន, ពន្លឺព្រះអាទិត្យ ការគ្រប់គ្រងកាកសំណល់។ ចូលប្រើទីនេះ។

- ផ្លាតូសុខភាព។ ជីវបច្ចេកវិទ្យា និង ភាពវៃឆ្លាត សាកល្បងគ្លីនិក។ ចូលប្រើទីនេះ។

- ប្រភព: https://aws.amazon.com/blogs/machine-learning/enhance-conversational-ai-with-advanced-routing-techniques-with-amazon-bedrock/