כדי להילחם בהפצת חומרי התעללות מינית בילדים (CSAM), קואליציה של מפתחי בינה מלאכותית מובילה - כולל גוגל, Meta ו-OpenAI - נשבעה לאכוף מעקות בטיחות סביב הטכנולוגיה המתפתחת.

הקבוצה נרתמה על ידי שני ארגונים ללא מטרות רווח: קבוצת טכנולוגיה לילדים Thorn ו- All Tech is Human מניו יורק. תורן, שנקראה בעבר קרן DNA, הושקה ב-2012 על ידי השחקנים דמי מור ואשטון קוצ'ר.

The collective pledge was announced Tuesday along with a new Thorn report advocating a “Safety by Design” principle in generative AI development that would prevent the creation of child sexual abuse material (CSAM) across the entire lifecycle of an AI model.

“We urge all companies developing, deploying, maintaining, and using generative AI technologies and products to commit to adopting these Safety by Design principles and demonstrate their dedication to preventing the creation and spread of CSAM, AIG-CSAM, and other acts of child sexual abuse and exploitation,” Thorn אמר בהצהרה.

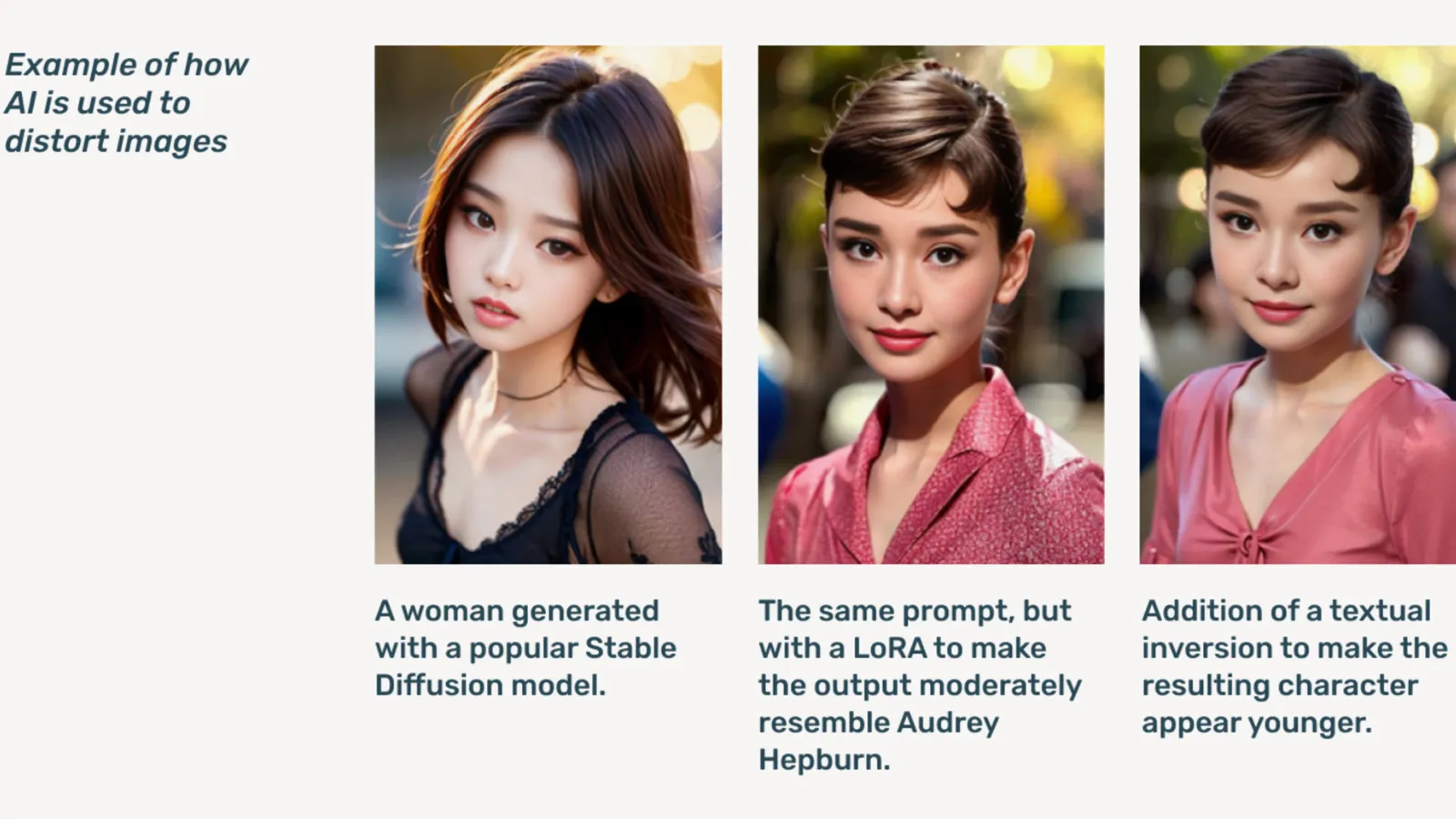

AIG-CSAM הוא CSAM שנוצר על ידי AI, שהדוח ממחיש שיכול להיות קל יחסית ליצירה.

Thorn develops כלים and resources focused on defending children from sexual abuse and exploitation. In its 2022 impact report, the organization said over 824,466 files containing child abuse material were found. Last year, Thorn reported more than 104 million files of suspected CSAM were reported in the U.S. alone.

Already a problem online, deepfake child pornography skyrocketed after generative AI models became publicly available, with stand-alone AI models that don’t need cloud services being circulated on אינטרנט אפל פורומים.

AI גנרטיבי, אמר Thorn, עושה יצירת נפחי תוכן קלה יותר כעת מאי פעם. טורף ילד יחיד עלול ליצור כמויות עצומות של חומרי התעללות מינית בילדים (CSAM), כולל התאמת תמונות וסרטונים מקוריים לתוכן חדש.

"נהירה של AIG-CSAM מהווה סיכונים משמעותיים למערכת אקולוגית של בטיחות ילדים שכבר חייבת במס, ומחמירה את האתגרים העומדים בפני רשויות אכיפת החוק בזיהוי והצלה של קורבנות קיימים להתעללות, ומגדילה את מידת הקורבנות החדשה של ילדים נוספים", מציין Thorn.

Thorn’s report outlines a series of principles the generative AI developers would follow to prevent their technology from being used to create child pornography, including responsibly sourcing training מערכי נתונים, incorporating feedback loops and stress-testing strategies, employing content history or “provenance” with adversarial misuse in mind, and responsibly hosting their respective AI models.

Others signing onto the pledge include מיקרוסופט, אנתרופית, Mistral AI, אמזון בעברית, יציבות AI, Civit AI, ו מטפיזיקה, each releasing separate statements today.

"חלק מהאתוס שלנו ב-Metaphysic הוא פיתוח אחראי בעולם בינה מלאכותית, נכון, זה עניין של העצמה, אבל זה קשור באחריות", אמר סמנכ"ל השיווק של Metaphysic, אלחנדרו לופז. פענוח. "אנחנו מזהים במהירות שלהתחיל ולהתפתח זה אומר ממש לשמור על הפגיעים ביותר בחברה שלנו, שהם ילדים, ולמרבה הצער, הקצה האפל ביותר של הטכנולוגיה הזו, המשמשת לחומרי התעללות מינית בילדים בצורות של פורנוגרפיה מזויפת עמוקה. , זה קרה."

הושק ב2021, מטפיזיקה came to prominence last year after it was revealed several Hollywood stars, including Tom Hanks, Octavia Spencer, and Anne Hathaway, were using Metaphysic Pro technology to digitize characteristics of their likeness in a bid to retain ownership over the traits necessary to train an AI model.

OpenAI סירבה להגיב יותר על היוזמה, במקום זאת סיפקה פענוח הצהרה פומבית של המנהיג שלה לבטיחות ילדים, צ'לסי קרלסון.

“We care deeply about the safety and responsible use of our tools, which is why we’ve built strong guardrails and safety measures into ChatGPT and DALL-E,” Carlson said in a הצהרה. “We are committed to working alongside Thorn, All Tech is Human and the broader tech community to uphold the Safety by Design principles and continue our work in mitigating potential harms to children.”

פענוח פנה לחברים אחרים בקואליציה אך לא שמע מיד.

“At Meta, we’ve spent over a decade working to keep people safe online. In that time, we’ve developed numerous tools and features to help prevent and combat potential harm—and as predators have adapted to try and evade our protections, we’ve continued to adapt too,” meta אמר בהצהרה מוכנה.

“Across our products, we proactively detect and remove CSAE material through a combination of hash-matching technology, artificial intelligence classifiers, and human reviews,” Google‘s vice president of trust and safety solutions Susan Jasper wrote in a post. “Our policies and protections are designed to detect all kinds of CSAE, including AI-generated CSAM. When we identify exploitative content we remove it and take the appropriate action, which may include reporting it to NCMEC.”

In October, the UK watchdog group, the אינטרנט Watch Foundation, warned that AI-generated child abuse material could ‘overwhelm’ האינטרנט.

נערך על ידי ריאן אוזאווה.

הישאר מעודכן בחדשות הקריפטו, קבל עדכונים יומיים בתיבת הדואר הנכנס שלך.

- הפצת תוכן ויחסי ציבור מופעל על ידי SEO. קבל הגברה היום.

- PlatoData.Network Vertical Generative Ai. העצים את עצמך. גישה כאן.

- PlatoAiStream. Web3 Intelligence. הידע מוגבר. גישה כאן.

- PlatoESG. פחמן, קלינטק, אנרגיה, סביבה, שמש, ניהול פסולת. גישה כאן.

- PlatoHealth. מודיעין ביוטכנולוגיה וניסויים קליניים. גישה כאן.

- מקור: https://decrypt.co/227731/aig-csam-google-meta-openai-fight-ai-child-sexual-abuse-material