Model bahasa besar (LLM) dengan miliaran parameter saat ini berada di garis depan pemrosesan bahasa alami (NLP). Model-model ini mengguncang lapangan dengan kemampuannya yang luar biasa untuk menghasilkan teks, menganalisis sentimen, menerjemahkan bahasa, dan banyak lagi. Dengan akses ke sejumlah besar data, LLM memiliki potensi untuk merevolusi cara kita berinteraksi dengan bahasa. Meskipun LLM mampu melakukan berbagai tugas NLP, mereka dianggap generalis dan bukan spesialis. Untuk melatih LLM menjadi ahli dalam domain tertentu, biasanya diperlukan penyempurnaan.

Salah satu tantangan utama dalam melatih dan menerapkan LLM dengan miliaran parameter adalah ukurannya, yang dapat menyulitkan untuk menyesuaikannya ke dalam GPU tunggal, perangkat keras yang biasa digunakan untuk pembelajaran mendalam. Skala besar model ini membutuhkan sumber daya komputasi performa tinggi, seperti GPU khusus dengan memori dalam jumlah besar. Selain itu, ukuran model ini dapat membuatnya mahal secara komputasi, yang secara signifikan dapat meningkatkan waktu pelatihan dan inferensi.

Dalam posting ini, kami menunjukkan bagaimana kita dapat menggunakan Mulai Lompatan Amazon SageMaker untuk menyempurnakan model pembuatan teks bahasa besar dengan mudah pada kumpulan data khusus domain dengan cara yang sama seperti Anda melatih dan menerapkan model apa pun di Amazon SageMaker. Secara khusus, kami menunjukkan bagaimana Anda dapat menyempurnakan model bahasa GPT-J 6B untuk pembuatan teks finansial menggunakan JumpStart SDK dan Studio Amazon SageMaker UI pada kumpulan data pengajuan SEC yang tersedia untuk umum.

JumpStart membantu Anda dengan cepat dan mudah memulai pembelajaran mesin (ML) dan menyediakan serangkaian solusi untuk kasus penggunaan paling umum yang dapat dilatih dan diterapkan dengan mudah hanya dengan beberapa langkah. Semua langkah dalam demo ini tersedia di notebook yang disertakan Menyempurnakan pembuatan teks model GPT-J 6B pada kumpulan data khusus domain.

Ikhtisar solusi

Di bagian berikut, kami menyediakan demonstrasi langkah demi langkah untuk menyempurnakan LLM untuk tugas pembuatan teks melalui JumpStart Studio UI dan Python SDK. Secara khusus, kami membahas topik-topik berikut:

- Gambaran umum data pengarsipan SEC dalam domain keuangan yang modelnya disesuaikan

- Ikhtisar model LLM GPT-J 6B yang telah kami pilih untuk disempurnakan

- Demonstrasi dua cara berbeda untuk menyempurnakan LLM menggunakan JumpStart:

- Gunakan JumpStart secara terprogram dengan SageMaker Python SDK

- Akses JumpStart menggunakan UI Studio

- Evaluasi model fine-tuning dengan membandingkannya dengan model pra-pelatihan tanpa fine-tuning

Penyempurnaan mengacu pada proses mengambil model bahasa terlatih dan melatihnya untuk tugas yang berbeda tetapi terkait menggunakan data tertentu. Pendekatan ini disebut juga dengan belajar transfer, yang melibatkan transfer pengetahuan yang dipelajari dari satu tugas ke tugas lainnya. LLM seperti GPT-J 6B dilatih pada sejumlah besar data tanpa label dan dapat disesuaikan pada kumpulan data yang lebih kecil, membuat model bekerja lebih baik di domain tertentu.

Sebagai contoh bagaimana performa meningkat saat model disesuaikan, pertimbangkan untuk mengajukan pertanyaan berikut:

“Apa yang mendorong pertumbuhan penjualan di Amazon?”

Tanpa fine-tuning, responnya adalah:

“Amazon adalah pengecer online terbesar di dunia. Ini juga merupakan pasar online terbesar di dunia. Itu juga dunia”

Dengan fine tuning, responnya adalah:

“Pertumbuhan penjualan di Amazon terutama didorong oleh peningkatan penggunaan pelanggan, termasuk peningkatan pilihan, harga yang lebih rendah, dan peningkatan kenyamanan, serta peningkatan penjualan oleh penjual lain di situs web kami.”

Peningkatan dari fine-tuning terbukti.

Kami menggunakan teks keuangan dari pengarsipan SEC untuk menyempurnakan GPT-J 6B LLM untuk aplikasi keuangan. Di bagian berikutnya, kami memperkenalkan data dan LLM yang akan disempurnakan.

Kumpulan data pengarsipan SEC

Pengajuan SEC sangat penting untuk regulasi dan pengungkapan di bidang keuangan. Pengajuan memberi tahu komunitas investor tentang kondisi bisnis perusahaan dan prospek masa depan perusahaan. Teks dalam pengarsipan SEC mencakup keseluruhan operasi perusahaan dan kondisi bisnis. Karena potensi nilai prediktifnya, pengarsipan ini merupakan sumber informasi yang baik bagi investor. Meskipun pengajuan SEC ini tersedia untuk umum bagi siapa pun, mengunduh pengarsipan yang diurai dan membuat kumpulan data bersih dengan fitur tambahan adalah latihan yang menghabiskan waktu. Kami memungkinkan ini dalam beberapa panggilan API di JumpStart SDK industri.

Menggunakan API SageMaker, kami mengunduh laporan tahunan (Pengajuan 10-K; Lihat Cara Membaca 10-K untuk informasi lebih lanjut) untuk sejumlah besar perusahaan. Kami memilih laporan pengarsipan SEC Amazon untuk tahun 2021–2022 sebagai data pelatihan untuk menyempurnakan model GPT-J 6B. Secara khusus, kami menggabungkan laporan pengarsipan SEC perusahaan pada tahun yang berbeda ke dalam satu file teks kecuali untuk bagian "Diskusi dan Analisis Manajemen", yang berisi pernyataan berwawasan ke depan oleh manajemen perusahaan dan digunakan sebagai data validasi.

Harapannya adalah bahwa setelah menyempurnakan model pembuatan teks GPT-J 6B pada dokumen keuangan SEC, model tersebut mampu menghasilkan output tekstual terkait keuangan yang berwawasan luas, dan oleh karena itu dapat digunakan untuk menyelesaikan beberapa tugas NLP khusus domain.

Model bahasa besar GPT-J 6B

GPT-J 6B adalah model 6 miliar parameter sumber terbuka yang dirilis oleh Eleuther AI. GPT-J 6B telah dilatih pada kumpulan besar data teks dan mampu melakukan berbagai tugas NLP seperti pembuatan teks, klasifikasi teks, dan peringkasan teks. Meskipun model ini mengesankan pada sejumlah tugas NLP tanpa memerlukan penyesuaian apa pun, dalam banyak kasus Anda perlu menyempurnakan model pada kumpulan data tertentu dan tugas NLP yang ingin Anda selesaikan. Kasus penggunaan termasuk chatbot khusus, pembuatan ide, ekstraksi entitas, klasifikasi, dan analisis sentimen.

Akses LLM di SageMaker

Sekarang setelah kami mengidentifikasi kumpulan data dan model yang akan kami sempurnakan, JumpStart menyediakan dua jalan untuk mulai menggunakan penyempurnaan pembuatan teks: SageMaker SDK dan Studio.

Gunakan JumpStart secara terprogram dengan SageMaker SDK

Kami sekarang membahas contoh bagaimana Anda dapat menggunakan SageMaker JumpStart SDK untuk mengakses LLM (GPT-J 6B) dan menyempurnakannya pada kumpulan data pengarsipan SEC. Setelah menyelesaikan penyempurnaan, kami akan menerapkan model yang telah disempurnakan dan membuat inferensi terhadapnya. Semua langkah dalam posting ini tersedia di buku catatan terlampir: Menyempurnakan pembuatan teks model GPT-J 6B pada kumpulan data khusus domain.

Dalam contoh ini, JumpStart menggunakan SageMaker Memeluk Wajah Wadah Pembelajaran Mendalam (DLC) dan Kecepatan Dalam perpustakaan untuk menyempurnakan model. Pustaka DeepSpeed dirancang untuk mengurangi daya komputasi dan penggunaan memori dan untuk melatih model terdistribusi besar dengan paralelisme yang lebih baik pada perangkat keras komputer yang ada. Ini mendukung pelatihan terdistribusi node tunggal, memanfaatkan pemeriksaan gradien dan paralelisme model untuk melatih model besar pada satu instans pelatihan SageMaker dengan beberapa GPU. Dengan JumpStart, kami mengintegrasikan pustaka DeepSpeed dengan DLC SageMaker Hugging Face untuk Anda dan mengurus semuanya di bawah terpal. Anda dapat dengan mudah menyempurnakan model pada kumpulan data khusus domain tanpa menyiapkannya secara manual.

Sempurnakan model pra-terlatih pada data khusus domain

Untuk menyempurnakan model yang dipilih, kita perlu mendapatkan URI model tersebut, serta skrip pelatihan dan gambar penampung yang digunakan untuk pelatihan. Untuk mempermudah, ketiga input ini hanya bergantung pada nama model, versi (untuk daftar model yang tersedia, lihat Algoritma bawaan dengan Tabel Model yang telah dilatih sebelumnya), dan jenis instans yang ingin Anda latih. Ini ditunjukkan dalam cuplikan kode berikut:

Kami mengambil kembali model_id sesuai dengan model yang sama yang ingin kita gunakan. Dalam hal ini, kami menyempurnakan huggingface-textgeneration1-gpt-j-6b.

Menentukan hyperparameter melibatkan pengaturan nilai untuk berbagai parameter yang digunakan selama proses pelatihan model ML. Parameter ini dapat memengaruhi performa dan akurasi model. Pada langkah berikut, kami membuat hyperparameter dengan menggunakan pengaturan default dan menentukan nilai khusus untuk parameter seperti epochs dan learning_rate:

JumpStart menyediakan daftar lengkap hyperparameter yang tersedia untuk disesuaikan. Daftar berikut memberikan ikhtisar bagian dari hyperparameter utama yang digunakan untuk menyempurnakan model. Untuk daftar lengkap hyperparameter, lihat notebook Menyempurnakan pembuatan teks model GPT-J 6B pada kumpulan data khusus domain.

- zaman – Menentukan paling banyak berapa zaman dari kumpulan data asli yang akan diulang.

- tingkat_belajar – Mengontrol ukuran langkah atau kecepatan pembelajaran dari algoritme pengoptimalan selama pelatihan.

- eval_langkah – Menentukan berapa banyak langkah yang harus dijalankan sebelum mengevaluasi model pada set validasi selama pelatihan. Set validasi adalah subset dari data yang tidak digunakan untuk pelatihan, melainkan digunakan untuk memeriksa kinerja model pada data yang tidak terlihat.

- berat_peluruhan – Mengontrol kekuatan regularisasi selama pelatihan model. Regularisasi adalah teknik yang membantu mencegah model melakukan overfitting pada data pelatihan, yang dapat menghasilkan performa yang lebih baik pada data yang tidak terlihat.

- fp16 – Mengontrol apakah akan menggunakan pelatihan presisi fp16 16-bit (campuran) alih-alih pelatihan 32-bit.

- evaluasi_strategi – Strategi evaluasi yang digunakan selama pelatihan.

- gradien_akumulasi_langkah – Jumlah langkah pembaruan untuk mengakumulasikan gradien, sebelum melakukan langkah mundur/perbarui.

Untuk perincian lebih lanjut tentang hyperparameter, lihat pejabatnya Dokumentasi Pelatih Wajah Memeluk.

Sekarang Anda dapat menyempurnakan model JumpStart ini pada kumpulan data khusus Anda sendiri menggunakan SageMaker SDK. Kami menggunakan data pengarsipan SEC yang kami jelaskan sebelumnya. Data kereta dan validasi dihosting di bawah train_dataset_s3_path dan validation_dataset_s3_path. Format data yang didukung termasuk CSV, JSON, dan TXT. Untuk data CSV dan JSON, data teks digunakan dari kolom yang disebut text atau kolom pertama jika tidak ditemukan kolom bernama teks. Karena ini untuk penyempurnaan pembuatan teks, tidak diperlukan label kebenaran dasar. Kode berikut adalah contoh SDK tentang cara menyempurnakan model:

Setelah kami menyiapkan Estimator SageMaker dengan hyperparameter yang diperlukan, kami membuat instance estimator SageMaker dan memanggil .fit metode untuk mulai menyempurnakan model kita, meneruskannya Layanan Penyimpanan Sederhana Amazon (Amazon S3) URI untuk data pelatihan kami. Seperti yang Anda lihat, entry_point skrip yang disediakan bernama transfer_learning.py (sama untuk tugas dan model lain), dan saluran data input diteruskan ke .fit harus diberi nama kereta dan validasi.

JumpStart juga mendukung pengoptimalan hyperparameter dengan Tuning model otomatis SageMaker. Untuk detailnya, lihat contoh buku catatan.

Terapkan model yang telah disesuaikan

Saat pelatihan selesai, Anda dapat menerapkan model yang telah disesuaikan. Untuk melakukannya, yang perlu kita dapatkan hanyalah URI skrip inferensi (kode yang menentukan bagaimana model digunakan untuk inferensi setelah diterapkan) dan URI gambar wadah inferensi, yang menyertakan server model yang sesuai untuk meng-host model yang kita pilih. Lihat kode berikut:

Setelah beberapa menit, model kami diterapkan dan kami bisa mendapatkan prediksi darinya secara real time!

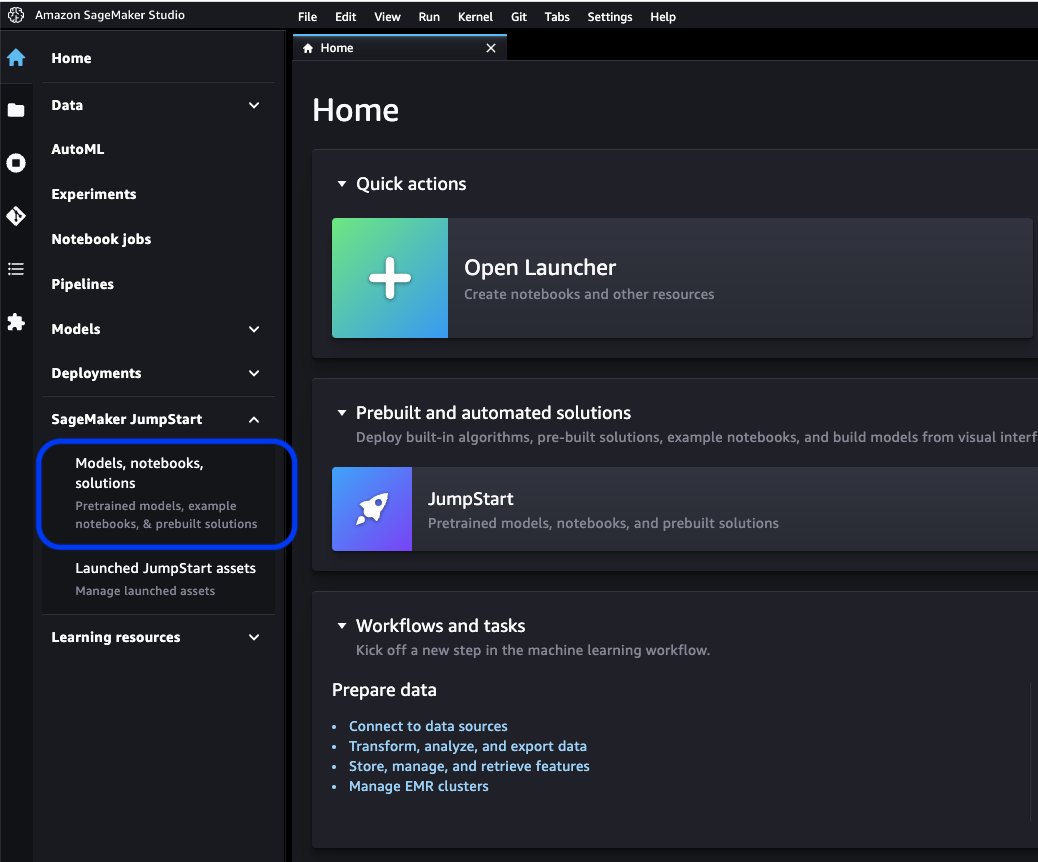

Akses JumpStart melalui UI Studio

Cara lain untuk menyempurnakan dan menerapkan model JumpStart adalah melalui UI Studio. UI ini menyediakan solusi low-code/no-code untuk menyempurnakan LLM.

Di konsol Studio, pilih Model, notebook, solusi bawah SageMaker JumpStart di panel navigasi.

Di bilah pencarian, cari model yang ingin Anda sempurnakan dan terapkan.

Dalam kasus kami, kami memilih kartu model GPT-J 6B. Di sini kita dapat langsung menyempurnakan atau menggunakan LLM.

Evaluasi model

Saat mengevaluasi LLM, kita bisa menggunakan perplexity (PPL). PPL adalah ukuran umum seberapa baik model bahasa mampu memprediksi kata berikutnya secara berurutan. Dalam istilah yang lebih sederhana, ini adalah cara untuk mengukur seberapa baik model dapat memahami dan menghasilkan bahasa mirip manusia.

Skor kebingungan yang lebih rendah berarti model terbukti berkinerja lebih baik dalam memprediksi kata berikutnya. Dalam istilah praktis, kita dapat menggunakan kebingungan untuk membandingkan model bahasa yang berbeda dan menentukan mana yang berkinerja lebih baik pada tugas tertentu. Kami juga dapat menggunakannya untuk melacak kinerja model tunggal dari waktu ke waktu. Untuk detail lebih lanjut, lihat Kebingungan model dengan panjang tetap.

Kami mengevaluasi performa model melalui perbandingan performa sebelum dan sesudah penyempurnaan. PPL dipancarkan dalam pekerjaan pelatihan amazoncloudwatch log. Selain itu, kami melihat output yang dihasilkan oleh model sebagai respons terhadap petunjuk pengujian tertentu.

| Metrik evaluasi pada data validasi | Sebelum fine-tuning | Setelah fine-tuning |

| Kebingungan (PPL) | 8.147 | 1.437 |

Performa model yang ditingkatkan ditunjukkan oleh dua eksperimen:

- Pembuatan teks – Kami menunjukkan bahwa keluaran GPT-J yang disetel dengan baik menghasilkan teks yang memiliki kemiripan dengan kumpulan data SEC, menunjukkan bahwa ia telah belajar untuk meniru pola bahasa dan konvensi dari domain regulasi keuangan

- Pembelajaran zero-shot – Kami menunjukkan bahwa GPT-J yang disetel dengan baik menunjukkan kinerja yang jauh lebih baik daripada GPT-J yang tidak disetel dengan baik pada jawaban pertanyaan zero-shot

Untuk eksperimen pembuatan teks, kami menggunakan parameter inferensi berikut untuk mencapai hasil kami: max_length dari 400 (jumlah token yang dikembalikan), num_return_sequences dari 1 (jumlah contoh teks tanggapan), top_k dari 250 (pilih dari salah satu dari 250 kemungkinan kelanjutan teratas), top_p dari 0.8 (pilih hanya dari kelanjutan yang kemungkinannya minimal 80%), do_sample is True (pengambilan sampel), dan temperature dari 1 (suhu tinggi adalah keacakan yang lebih besar dalam tanggapan). Untuk detail lebih lanjut tentang parameter, lihat Konfigurasi Generasi. Tabel berikut membandingkan GPT-J yang disetel halus dan yang tidak disetel halus pada tugas penyelesaian teks.

| Contoh inferensi | Keluaran dari GPT-J 6B Sebelum Penyetelan Halus | Keluaran dari GPT-J 6B Setelah Penyetelan Halus |

| Laporan Formulir 10-K ini menunjukkan hal itu |

Laporan Formulir 10-K ini menunjukkan bahwa: Laba bersih Perseroan yang diatribusikan kepada Perseroan untuk tahun yang berakhir pada tanggal 31 Desember 2016 adalah $3,923,000, atau $0.21 per saham dilusian, dibandingkan dengan $3,818,000, atau $0.21 per saham dilusian, untuk tahun yang berakhir pada tanggal 31 Desember 2015. Laba bersih Perseroan yang diatribusikan kepada Perseroan untuk tahun yang berakhir pada tanggal 31 Desember 2016 adalah $4,816,000, atau $0.28 per saham dilusian, dibandingkan dengan $4,726,000, atau $0.27 per saham dilusian, untuk tahun yang berakhir pada tanggal 31 Desember 2015. Laba bersih Perseroan yang diatribusikan kepada Perseroan untuk tahun yang berakhir pada tanggal 31 Desember 2016 adalah $5,828,000, atau $0.34 per saham dilusian, dibandingkan dengan $5,716,000, atau $0.33 per saham dilusian, untuk tahun yang berakhir pada tanggal 31 Desember 2015. Pada tanggal 21 Agustus 2009, Perusahaan mengajukan Form 10-Q untuk kuartal yang berakhir pada tanggal 31 Desember 2008. Pada tanggal 21 Agustus 2009, Perusahaan mengajukan Form 10-Q untuk kuartal yang berakhir pada tanggal 30 September 2008. Pada tanggal 21 Agustus 2009, Perusahaan mengajukan Formulir 10-Q untuk kuartal yang berakhir pada tanggal 31 Maret 2009. |

Laporan Formulir 10-K ini menunjukkan bahwa:(1) Nama, alamat, dan nomor telepon pendaftar, adalah sebagai berikut:Amazon.com, Inc. c/o Ernst & Young LLPSeattle, Washington Perhatian: Sekretaris Perusahaan (2) Untuk tujuan Pasal III Securities Exchange Act of 1934, nama dan alamat pendaftar adalah sebagai berikut:(3) Jangka waktu pelaporan Exchange Act pendaftar adalah dari dan termasuk 1 Januari 2020 sampai sekarang.(4) Penilaian subjektif pendaftar adalah bahwa laporan keuangan, dan informasi keuangan lainnya yang disertakan dalam laporan ini, menyajikan secara wajar dalam semua hal yang material, kondisi keuangan, hasil operasi, dan arus kas pendaftar pada, dan untuk, periode yang disajikan dalam laporan ini.(5) Manajemen pendaftar penilaiannya adalah bahwa laporan keuangan, dan informasi keuangan lainnya yang termasuk dalam laporan ini, disajikan secara wajar dalam semua hal yang material, kondisi keuangan, hasil operasi, dan arus kas pendaftar pada, dan untuk, periode yang disajikan dalam laporan ini./s/ Ernst & Young LLPSeattle, Washington29 Januari 2020EX-31.1 5 amzn-20201231xex311.htm EX-31.1 DokumenExhibit 31.1SERTIFIKASISI, Andrew R. Jassy, menyatakan bahwa:1. Saya telah meninjau Formulir 10-K dari Amazon.com, Inc.;2. Berdasarkan pengetahuan saya, laporan ini tidak mengandung pernyataan yang tidak benar tentang fakta material atau menghilangkan pernyataan fakta material yang diperlukan untuk membuat pernyataan yang dibuat, mengingat keadaan di mana pernyataan tersebut dibuat, tidak menyesatkan sehubungan dengan periode yang dicakup oleh laporan ini. laporan; |

| Kami melayani konsumen melalui |

Kami melayani konsumen melalui: Blog kami Apakah Anda seorang pemilik bisnis yang ingin mengembangkan bisnis Anda? Apakah Anda ingin menciptakan bisnis yang lebih efektif dan efisien? Apakah Anda ingin belajar bagaimana mengembangkan bisnis Anda? Jika Anda menjawab "ya" untuk semua pertanyaan ini, maka Anda perlu membaca artikel ini. Langkah pertama untuk mengembangkan bisnis Anda adalah memahami bisnis Anda. Anda harus dapat menjawab pertanyaan-pertanyaan berikut tentang bisnis Anda: Siapa pelanggan Anda? Apa produk atau layanan Anda? Apa proposisi penjualan unik Anda? Apa strategi pemasaran Anda? Apa ramalan penjualan Anda? Apa ramalan penjualan Anda? Apa ramalan penjualan Anda? Apa ramalan penjualan Anda? Apa ramalan penjualan Anda? |

Kami melayani konsumen melalui: Amazon.com, pengecer produk fisik dan digital; Amazon Web Services, yang menyediakan layanan infrastruktur teknologi yang memungkinkan hampir semua jenis bisnis; Amazon Enterprise Solutions, yang memberi perusahaan teknologi dan layanan khusus untuk memungkinkan proses bisnis yang lebih baik dan meningkatkan efisiensi dan produktivitas; dan Audible, penerbit buku audio digital. Kami melayani pengembang dan perusahaan dari semua ukuran melalui AWS, yang menawarkan serangkaian luas komputasi global, penyimpanan, database, dan penawaran layanan lainnya. Kami juga memproduksi dan menjual perangkat elektronik. Kami telah mengatur operasi kami menjadi dua segmen utama: Amerika Utara dan Internasional. Lihat Butir 8 Bagian II, “”Laporan Keuangan dan Data Tambahan-Catatan 12-Informasi Segmen.”” Lihat Butir 7 Bagian II, “Pembahasan dan Analisis Manajemen atas Kondisi Keuangan dan Hasil Operasi-Hasil Operasi-Informasi Tambahan” ” untuk informasi tambahan tentang penjualan bersih kami. Konsumen Kami melayani konsumen melalui toko online dan fisik kami dan berfokus pada pemilihan, harga, dan kenyamanan. Kami merancang toko kami untuk memungkinkan ratusan juta produk unik dijual oleh kami dan oleh pihak ketiga di lusinan kategori produk. Pelanggan mengakses penawaran kami melalui situs web, aplikasi seluler, Alexa, dan secara fisik mengunjungi toko kami. Kami juga memproduksi dan menjual perangkat Kindle. Kami berusaha untuk menawarkan kepada pelanggan kami harga serendah mungkin melalui penawaran pengiriman dan harga produk sehari-hari yang rendah, dan untuk meningkatkan efisiensi operasi kami sehingga kami dapat terus menurunkan harga untuk pelanggan kami. Kami juga menyediakan fungsionalitas yang mudah digunakan, pemenuhan yang cepat dan andal, serta layanan pelanggan yang tepat waktu. Selain itu, kami menawarkan Amazon Prime, program keanggotaan yang mencakup pengiriman gratis tanpa batas untuk lebih dari 100 juta item, akses ke streaming tak terbatas dari puluhan ribu film dan episode TV, dan manfaat lainnya. |

| Tahun ini kami sangat fokus pada |

Tahun ini kami secara khusus berfokus pada: Peran sistem perawatan kesehatan dalam pencegahan obesitas dan diabetes Peran sistem perawatan kesehatan dalam pencegahan obesitas dan diabetes Peran sistem perawatan kesehatan dalam pencegahan obesitas dan diabetes Peran sistem perawatan kesehatan dalam pencegahan obesitas dan diabetes Peran sistem perawatan kesehatan dalam pencegahan obesitas dan diabetes Peran sistem perawatan kesehatan dalam pencegahan obesitas dan diabetes Peran sistem perawatan kesehatan dalam pencegahan obesitas dan diabetes |

Tahun ini kami secara khusus berfokus pada: - Ekspansi internasional yang berkelanjutan, termasuk pengembangan bisnis baru di segmen pasar internasional yang ada, serta pengembangan segmen pasar internasional baru; - Memperluas basis pelanggan kami, termasuk meningkatkan penjualan ke pelanggan yang sudah ada dan menarik pelanggan baru; - Mengembangkan peluang bisnis baru dan mengadakan perjanjian komersial, termasuk melalui perizinan dan pengaturan lainnya, dengan perusahaan lain, atau melalui akuisisi perusahaan lain; -Mengembangkan teknologi yang menyediakan layanan pelanggan yang ditingkatkan dan memberikan produk dan layanan kami secara efisien; -Mengembangkan penawaran produk dan layanan baru dan menggabungkannya ke dalam penawaran produk dan layanan yang sudah ada dan baru; -Mengembangkan sistem yang efisien dan efektif untuk mendukung bisnis kami;dan -Bisnis lain dan inisiatif strategis. Kami percaya bahwa menawarkan harga rendah kepada pelanggan kami merupakan hal mendasar bagi kesuksesan masa depan kami. Salah satu cara kami menawarkan harga yang lebih rendah adalah melalui penawaran pengiriman gratis yang menghasilkan biaya bersih bagi kami dalam pengiriman produk, dan melalui keanggotaan di Amazon Prime, yang menyediakan pengiriman gratis untuk jutaan item dan akses ke film dan konten lainnya. Kami juga menawarkan promosi lain yang memungkinkan kami menurunkan biaya penjualan bersih. Kami telah mengatur operasi kami menjadi dua segmen utama: Amerika Utara dan Internasional. Lihat Butir 8 Bagian II, “”Laporan Keuangan dan Data Tambahan-Catatan 12-Informasi Segmen.”” Lihat Butir 7 Bagian II,”“Pembahasan dan Analisis Manajemen atas Kondisi Keuangan dan Hasil Operasi-Hasil Operasi-Informasi Tambahan”” untuk informasi tambahan tentang penjualan bersih kami. Konsumen Kami melayani konsumen melalui situs web ritel dan toko fisik kami dan berfokus pada pemilihan, harga, dan kenyamanan. |

Untuk percobaan kedua dengan tugas menjawab pertanyaan zero-shot, kami menetapkan max_length menjadi nilai yang berbeda (masing-masing 40, 200, dan 40) berdasarkan output yang kami harapkan dari setiap pertanyaan. Parameter dari top_k, top_p, do_sample, temperature ditetapkan sebagai 250, 0.8, False, dan 0, masing-masing. Kami menyetel suhu mendekati 0 untuk mengontrol keacakan keluaran, sedangkan dalam tugas pembuatan teks kami menyetelnya mendekati 1 untuk membuat model lebih kreatif. Tabel berikut membandingkan hasilnya. Untuk setiap pertanyaan, keluaran dari GPT-J yang disetel halus lebih akurat daripada yang tidak disetel halus.

| Memasukkan | Keluaran dari GPT-J 6B Sebelum Penyetelan Halus | Keluaran dari GPT-J 6B Setelah Penyetelan Halus |

| Tentang apakah Item 7 dari pengarsipan 10-K SEC?: |

Tentang apakah Item 7 dari pengarsipan 10-K SEC?: Butir 7 dari pengarsipan 10-K SEC adalah sebagai berikut: “Perseroan tidak menerima kerugian material apapun |

Butir 7. Analisis dan Pembahasan Manajemen atas Kondisi Keuangan dan Hasil Operasional Forward-Looking Statements |

| Bagaimana dampak pandemi COVID-19 terhadap bisnis Amazon?: |

Bagaimana dampak pandemi COVID-19 terhadap bisnis Amazon?: Bisnis Amazon terkena dampak pandemi COVID-19 dalam beberapa cara. Perusahaan mengalami penurunan jumlah keanggotaan Prime, yang merupakan bagian besar dari bisnisnya. Perusahaan juga melihat penurunan jumlah keanggotaan Perdana. Amazon juga mengalami penurunan jumlah pesanan yang ditempatkan di situs webnya. Perusahaan juga mengalami penurunan jumlah orang yang berbelanja di situsnya. Amazon juga mengalami penurunan jumlah orang yang berbelanja di situsnya. Amazon juga mengalami penurunan jumlah orang yang berbelanja di situsnya. Amazon juga mengalami penurunan jumlah orang yang berbelanja di situsnya. Amazon juga mengalami penurunan jumlah orang yang berbelanja |

Bagaimana dampak pandemi COVID-19 terhadap bisnis Amazon?:Pandemi COVID-19 telah memengaruhi bisnis kami dalam beberapa cara. Pertama, hal itu mengganggu rantai pasokan kami, dan memengaruhi permintaan pelanggan, yang pada gilirannya memengaruhi penjualan dan hasil operasi kami. Kedua, ini telah meningkatkan pengeluaran kami untuk periklanan dan pemasaran, yang mungkin tidak efektif dalam jangka panjang. Ketiga, telah meningkatkan pengeluaran kami untuk infrastruktur teknologi dan kapasitas komputasi, yang mungkin tidak efektif dalam jangka panjang. Keempat, meningkatkan pengeluaran kami untuk pemenuhan dan layanan pelanggan, yang mungkin tidak efektif dalam jangka panjang. Terakhir, ini meningkatkan pengeluaran kami untuk konten, yang mungkin tidak efektif dalam jangka panjang. Lihat Butir 8 Bagian II, “Laporan Keuangan dan Data Tambahan — Catatan 1 — Uraian Kebijakan Bisnis dan Akuntansi. |

| Apa yang mendorong pertumbuhan penjualan di Amazon?: | Amazon adalah pengecer online terbesar di dunia. Ini juga merupakan pasar online terbesar di dunia. Itu juga dunia' | Pertumbuhan penjualan di Amazon terutama didorong oleh peningkatan penggunaan pelanggan, termasuk peningkatan pilihan, harga yang lebih rendah, dan peningkatan kenyamanan, serta peningkatan penjualan oleh penjual lain di situs web kami. |

Membersihkan

Untuk menghindari tagihan berkelanjutan, hapus titik akhir inferensi SageMaker. Anda dapat menghapus titik akhir melalui konsol SageMaker atau dari notebook menggunakan perintah berikut:

Kesimpulan

JumpStart adalah kemampuan di SageMaker yang memungkinkan Anda memulai ML dengan cepat. JumpStart menggunakan model terlatih sumber terbuka untuk memecahkan masalah umum ML seperti klasifikasi gambar, deteksi objek, klasifikasi teks, klasifikasi pasangan kalimat, dan menjawab pertanyaan.

Dalam postingan ini, kami menunjukkan cara menyempurnakan dan menerapkan LLM terlatih (GPT-J 6B) untuk pembuatan teks berdasarkan dataset pengisian SEC. Kami mendemonstrasikan bagaimana model berubah menjadi pakar domain keuangan dengan menjalani proses penyempurnaan hanya pada dua laporan tahunan perusahaan. Penyempurnaan ini memungkinkan model menghasilkan konten dengan pemahaman tentang topik keuangan dan presisi yang lebih tinggi. Cobalah solusinya sendiri dan beri tahu kami bagaimana kelanjutannya di komentar.

Penting: Posting ini hanya untuk tujuan demonstrasi. Ini bukan nasihat keuangan dan tidak boleh diandalkan sebagai nasihat keuangan atau investasi. Pos menggunakan model pra-pelatihan pada data yang diperoleh dari database SEC EDGAR. Anda bertanggung jawab untuk mematuhi syarat dan ketentuan akses EDGAR jika Anda menggunakan data SEC.

Untuk mempelajari lebih lanjut tentang JumpStart, lihat posting berikut:

Tentang Penulis

Dr Xin Huang adalah Ilmuwan Terapan Senior untuk Amazon SageMaker JumpStart dan algoritme bawaan Amazon SageMaker. Dia berfokus pada pengembangan algoritme pembelajaran mesin yang dapat diskalakan. Minat penelitiannya adalah di bidang pemrosesan bahasa alami, pembelajaran mendalam yang dapat dijelaskan pada data tabular, dan analisis kuat pengelompokan ruang-waktu non-parametrik. Dia telah menerbitkan banyak makalah di konferensi ACL, ICDM, KDD, dan Royal Statistical Society: Series A.

Dr Xin Huang adalah Ilmuwan Terapan Senior untuk Amazon SageMaker JumpStart dan algoritme bawaan Amazon SageMaker. Dia berfokus pada pengembangan algoritme pembelajaran mesin yang dapat diskalakan. Minat penelitiannya adalah di bidang pemrosesan bahasa alami, pembelajaran mendalam yang dapat dijelaskan pada data tabular, dan analisis kuat pengelompokan ruang-waktu non-parametrik. Dia telah menerbitkan banyak makalah di konferensi ACL, ICDM, KDD, dan Royal Statistical Society: Series A.

Marc Karpa adalah Arsitek ML dengan tim Layanan Amazon SageMaker. Dia berfokus untuk membantu pelanggan merancang, menerapkan, dan mengelola beban kerja ML dalam skala besar. Di waktu luangnya, ia senang bepergian dan menjelajahi tempat-tempat baru.

Marc Karpa adalah Arsitek ML dengan tim Layanan Amazon SageMaker. Dia berfokus untuk membantu pelanggan merancang, menerapkan, dan mengelola beban kerja ML dalam skala besar. Di waktu luangnya, ia senang bepergian dan menjelajahi tempat-tempat baru.

Dr Sanjiv Daso adalah Sarjana Amazon dan Profesor Keuangan dan Ilmu Data Terry di Universitas Santa Clara. Dia memegang gelar pasca sarjana di bidang Keuangan (M.Phil dan PhD dari New York University) dan Ilmu Komputer (MS dari UC Berkeley), dan gelar MBA dari Indian Institute of Management, Ahmedabad. Sebelum menjadi akademisi, beliau bekerja di bisnis derivatif di kawasan Asia-Pasifik sebagai Vice President di Citibank. Dia bekerja pada pembelajaran mesin multimodal di bidang aplikasi keuangan.

Dr Sanjiv Daso adalah Sarjana Amazon dan Profesor Keuangan dan Ilmu Data Terry di Universitas Santa Clara. Dia memegang gelar pasca sarjana di bidang Keuangan (M.Phil dan PhD dari New York University) dan Ilmu Komputer (MS dari UC Berkeley), dan gelar MBA dari Indian Institute of Management, Ahmedabad. Sebelum menjadi akademisi, beliau bekerja di bisnis derivatif di kawasan Asia-Pasifik sebagai Vice President di Citibank. Dia bekerja pada pembelajaran mesin multimodal di bidang aplikasi keuangan.

Arun Kumar Lokanatha adalah Arsitek Solusi ML Senior dengan tim Layanan Amazon SageMaker. Dia berfokus untuk membantu pelanggan membuat, melatih, dan memigrasikan beban kerja produksi ML ke SageMaker dalam skala besar. Dia berspesialisasi dalam pembelajaran mendalam, terutama di bidang NLP dan CV. Di luar pekerjaan, dia senang berlari dan mendaki.

Arun Kumar Lokanatha adalah Arsitek Solusi ML Senior dengan tim Layanan Amazon SageMaker. Dia berfokus untuk membantu pelanggan membuat, melatih, dan memigrasikan beban kerja produksi ML ke SageMaker dalam skala besar. Dia berspesialisasi dalam pembelajaran mendalam, terutama di bidang NLP dan CV. Di luar pekerjaan, dia senang berlari dan mendaki.

- Konten Bertenaga SEO & Distribusi PR. Dapatkan Amplifikasi Hari Ini.

- Platoblockchain. Intelijen Metaverse Web3. Pengetahuan Diperkuat. Akses Di Sini.

- Mencetak Masa Depan bersama Adryenn Ashley. Akses Di Sini.

- Sumber: https://aws.amazon.com/blogs/machine-learning/financial-text-generation-using-a-domain-adapted-fine-tuned-large-language-model-in-amazon-sagemaker-jumpstart/