Penulis: Vitalik Buterin melalui Blog Vitalik Buterin

Terima kasih khusus kepada tim Worldcoin dan Modulus Labs, Xinyuan Sun, Martin Koeppelmann dan Illia Polosukhin atas masukan dan diskusi.

Banyak orang selama bertahun-tahun menanyakan pertanyaan serupa kepada saya: apa itu persimpangan antara crypto dan AI yang saya anggap paling bermanfaat? Ini adalah pertanyaan yang masuk akal: kripto dan AI adalah dua tren teknologi (perangkat lunak) utama dalam dekade terakhir, dan rasanya seperti itu. harus menjadi semacam hubungan antara keduanya. Sangat mudah untuk menghasilkan sinergi pada tingkat yang dangkal: desentralisasi kripto bisa menyeimbangkan sentralisasi AI, AI tidak tembus cahaya dan kripto menghadirkan transparansi, AI membutuhkan data, dan blockchain bagus untuk menyimpan dan melacak data. Namun selama bertahun-tahun, ketika orang meminta saya untuk menggali lebih dalam dan berbicara tentang aplikasi spesifik, jawaban saya mengecewakan: “ya, ada beberapa hal tetapi tidak terlalu banyak”.

Dalam tiga tahun terakhir, dengan munculnya AI yang jauh lebih kuat dalam bentuk modern LLM, dan munculnya kripto yang jauh lebih kuat tidak hanya dalam bentuk solusi penskalaan blockchain tetapi juga ZKP, FHE, (dua partai dan N-partai) MPC, saya mulai melihat perubahan ini. Memang ada beberapa penerapan AI yang menjanjikan di dalam ekosistem blockchain, atau AI bersama dengan kriptografi, meskipun penting untuk berhati-hati dalam menerapkan AI. Tantangan khususnya adalah: dalam kriptografi, sumber terbuka adalah satu-satunya cara untuk membuat sesuatu benar-benar aman, namun dalam AI, model (atau bahkan data pelatihannya) bersifat terbuka sangat meningkat kerentanannya terhadap pembelajaran mesin permusuhan serangan. Posting ini akan membahas klasifikasi berbagai cara yang dapat bersinggungan dengan kripto + AI, serta prospek dan tantangan dari setiap kategori.

Empat kategori utama

AI adalah konsep yang sangat luas: Anda dapat menganggap “AI” sebagai kumpulan algoritme yang Anda buat bukan dengan menentukannya secara eksplisit, melainkan dengan membuat sup komputasi besar dan memberikan semacam tekanan pengoptimalan yang mendorong sup tersebut ke arah yang lebih baik. menghasilkan algoritma dengan properti yang Anda inginkan. Deskripsi ini tentu saja tidak boleh dianggap remeh: itu termasuk itu proses bahwa dibuat kita manusia sejak awal! Namun hal ini berarti bahwa algoritme AI memiliki beberapa kesamaan: kemampuannya untuk melakukan hal-hal yang sangat hebat, serta keterbatasan dalam kemampuan kita untuk mengetahui atau memahami apa yang terjadi.

Ada banyak cara untuk mengkategorikan AI; untuk keperluan postingan ini, yang membahas tentang interaksi antara AI dan blockchain (yang telah digambarkan sebagai platform untuk menciptakan “permainan”), saya akan mengkategorikannya sebagai berikut:

- AI sebagai pemain dalam game [viabilitas tertinggi]: AI berpartisipasi dalam mekanisme yang sumber utama insentifnya berasal dari protokol dengan masukan manusia.

- AI sebagai antarmuka ke dalam game [berpotensi tinggi, namun berisiko]: AI membantu pengguna untuk memahami dunia kripto di sekitar mereka, dan untuk memastikan bahwa perilaku mereka (yaitu pesan dan transaksi yang ditandatangani) sesuai dengan niat mereka dan mereka tidak tertipu atau ditipu.

- AI sebagai aturan mainnya [berhati-hatilah]: blockchain, DAO, dan mekanisme serupa yang secara langsung memanggil AI. Pikirkan misalnya. “Hakim AI”

- AI sebagai tujuan permainan [jangka panjang namun menarik]: merancang blockchain, DAO, dan mekanisme serupa dengan tujuan membangun dan memelihara AI yang dapat digunakan untuk tujuan lain, menggunakan bit kripto untuk memberikan insentif yang lebih baik pada pelatihan atau untuk mencegah AI membocorkan data pribadi atau disalahgunakan.

Mari kita bahas ini satu per satu.

AI sebagai pemain dalam sebuah game

Ini sebenarnya adalah kategori yang telah ada selama hampir satu dekade, setidaknya sejak saat itu pertukaran desentralisasi on-chain (DEX) mulai melihat penggunaan yang signifikan. Setiap kali ada pertukaran, ada peluang untuk menghasilkan uang melalui arbitrase, dan bot dapat melakukan arbitrase jauh lebih baik daripada manusia. Kasus penggunaan ini telah ada sejak lama, bahkan dengan AI yang jauh lebih sederhana daripada yang kita miliki saat ini, namun pada akhirnya ini adalah persimpangan AI + kripto yang sangat nyata. Baru-baru ini, kita telah melihat bot arbitrase MEV sering mengeksploitasi satu sama lain. Setiap kali Anda memiliki aplikasi blockchain yang melibatkan lelang atau perdagangan, Anda akan memiliki bot arbitrase.

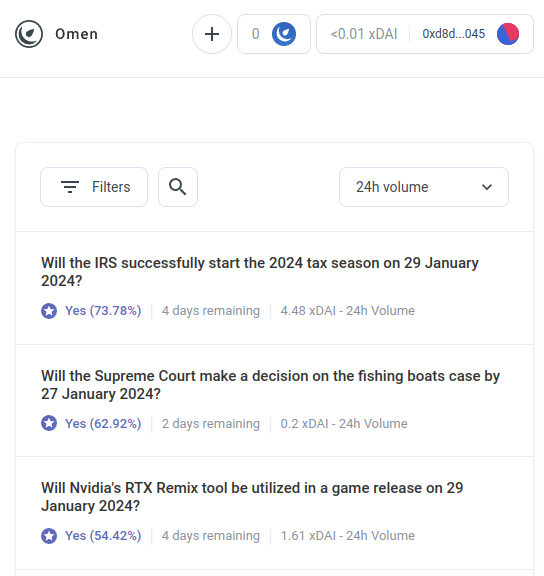

Namun bot arbitrase AI hanyalah contoh pertama dari kategori yang jauh lebih besar, yang saya perkirakan akan segera mencakup banyak aplikasi lainnya. Temui AIOmen, a demo pasar prediksi di mana AI adalah pemainnya:

Salah satu tanggapan terhadap hal ini adalah dengan menunjukkan peningkatan UX yang sedang berlangsung Polipasar atau pasar prediksi baru lainnya, dan berharap bahwa mereka akan berhasil ketika iterasi sebelumnya gagal. Bagaimanapun, ceritanya, orang-orang bersedia bertaruh puluhan miliar untuk olahraga, jadi mengapa orang tidak mengeluarkan cukup uang untuk bertaruh pada pemilu AS atau LK99 bahwa mulai masuk akal bagi pemain yang serius untuk mulai berdatangan? Namun argumen ini harus bertentangan dengan fakta bahwa, iterasi sebelumnya memiliki gagal mencapai tingkat skala ini (setidaknya dibandingkan dengan impian para pendukungnya), sehingga sepertinya Anda perlu sesuatu yang baru untuk membuat pasar prediksi berhasil. Maka tanggapan yang berbeda adalah dengan menunjuk pada satu fitur spesifik dari ekosistem pasar prediksi yang mungkin kita lihat pada tahun 2020an yang tidak kita lihat pada tahun 2010an: kemungkinan partisipasi AI di mana-mana.

AI bersedia bekerja dengan upah kurang dari $1 per jam, dan memiliki pengetahuan tentang ensiklopedia – dan jika itu belum cukup, mereka bahkan dapat diintegrasikan dengan kemampuan pencarian web real-time. Jika Anda membuat pasar, dan memberikan subsidi likuiditas sebesar $50, manusia tidak akan cukup peduli untuk menawar, namun ribuan AI akan dengan mudah mengerumuni seluruh pertanyaan dan membuat tebakan terbaik yang mereka bisa. Insentif untuk mengerjakan satu pertanyaan dengan baik mungkin kecil, namun insentif untuk membuat AI yang dapat membuat prediksi yang baik secara umum mungkin mencapai jutaan. Perhatikan bahwa secara potensial, Anda bahkan tidak memerlukan manusia untuk mengadili sebagian besar pertanyaan: Anda dapat menggunakan sistem perselisihan multi-putaran yang serupa dengan Ahli nujum atau Kleros, di mana AI juga akan berpartisipasi di putaran sebelumnya. Manusia hanya perlu merespons dalam beberapa kasus di mana serangkaian eskalasi telah terjadi dan sejumlah besar uang telah dikucurkan oleh kedua belah pihak.

Ini adalah cara primitif yang kuat, karena ketika “pasar prediksi” dapat dibuat bekerja pada skala mikroskopis, Anda dapat menggunakan kembali primitif “pasar prediksi” untuk berbagai jenis pertanyaan lainnya:

- Apakah postingan media sosial ini dapat diterima berdasarkan [ketentuan penggunaan]?

- Apa yang akan terjadi pada harga saham X (misal, lihat Numerai)

- Apakah akun yang mengirimi saya pesan ini benar-benar Elon Musk?

- Apakah penyerahan pekerjaan di pasar tugas online ini dapat diterima?

- Apakah dapp di https://examplefinance.network scam?

- Is

0x1b54....98c3sebenarnya alamat token ERC20 “Casinu Inu”?

Anda mungkin memperhatikan bahwa banyak dari ide-ide ini mengarah pada apa yang saya sebut “pertahanan informasi" di dalam . Jika didefinisikan secara luas, pertanyaannya adalah: bagaimana kita membantu pengguna membedakan informasi yang benar dan salah serta mendeteksi penipuan, tanpa memberdayakan otoritas terpusat untuk memutuskan benar dan salah siapa yang kemudian menyalahgunakan posisi tersebut? Pada tingkat mikro, jawabannya bisa berupa “AI”. Namun pada tingkat makro, pertanyaannya adalah: siapa yang membangun AI? AI adalah cerminan dari proses yang menciptakannya, sehingga tidak dapat menghindari adanya bias. Oleh karena itu, diperlukan sebuah game dengan level yang lebih tinggi yang dapat menilai seberapa baik kinerja berbagai AI, sehingga AI dapat berpartisipasi sebagai pemain dalam game tersebut..

Penggunaan AI ini, di mana AI berpartisipasi dalam sebuah mekanisme di mana mereka pada akhirnya mendapatkan imbalan atau sanksi (secara probabilistik) melalui mekanisme on-chain yang mengumpulkan masukan dari manusia (sebut saja ini berbasis pasar terdesentralisasi). RLHF?), adalah sesuatu yang menurut saya sangat layak untuk diperhatikan. Sekarang adalah waktu yang tepat untuk melihat lebih dalam kasus penggunaan seperti ini, karena penskalaan blockchain akhirnya berhasil, membuat segala sesuatu yang “mikro” akhirnya dapat dijalankan secara on-chain, yang sebelumnya tidak pernah terjadi.

Kategori aplikasi terkait mengarah ke agen yang sangat otonom menggunakan blockchain untuk bekerja sama dengan lebih baik, baik melalui pembayaran atau melalui penggunaan kontrak pintar untuk membuat komitmen yang kredibel.

AI sebagai antarmuka permainan

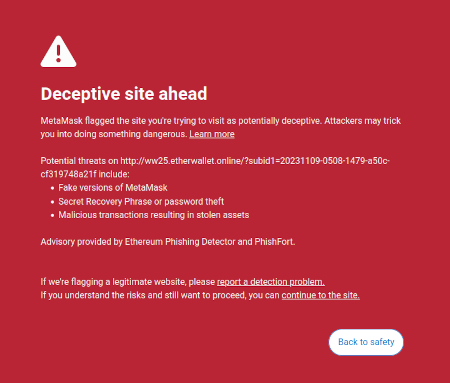

Satu ide yang saya kemukakan dalam diri saya tulisan di adalah gagasan bahwa ada peluang pasar untuk membuat perangkat lunak yang dapat diakses oleh pengguna yang akan melindungi kepentingan pengguna dengan menafsirkan dan mengidentifikasi bahaya di dunia online yang dijelajahi pengguna. Salah satu contoh yang sudah ada adalah fitur deteksi penipuan Metamask:

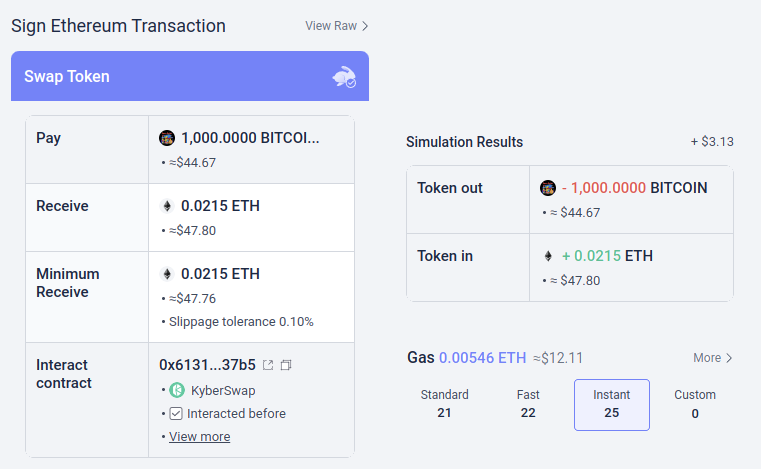

Kemungkinan besar, alat-alat semacam ini bisa dilengkapi dengan AI. AI dapat memberikan penjelasan yang lebih ramah manusia mengenai jenis dapp yang Anda ikuti, konsekuensi dari operasi lebih rumit yang Anda tandatangani, apakah token tertentu asli atau tidak (mis. BITCOIN bukan hanya serangkaian karakter, ini adalah nama mata uang kripto yang sebenarnya, yang bukan merupakan token ERC20 dan memiliki harga yang jauh lebih tinggi dari $0.045, dan LLM modern akan mengetahuinya), dan seterusnya. Ada beberapa proyek yang mulai mengarah ke arah ini (misalnya Dompet LangChain, yang menggunakan AI sebagai a primer antarmuka). Pendapat saya sendiri adalah bahwa antarmuka AI murni mungkin terlalu berisiko saat ini karena meningkatkan risiko lain jenis kesalahan, namun AI yang melengkapi antarmuka yang lebih konvensional menjadi sangat memungkinkan.

Ada satu risiko khusus yang perlu disebutkan. Saya akan membahasnya lebih lanjut di bagian “AI sebagai aturan main” di bawah ini masalah umumnya adalah pembelajaran mesin yang bermusuhan: jika pengguna memiliki akses ke asisten AI di dalam dompet sumber terbuka, orang-orang jahat akan memiliki akses ke asisten AI itu juga, sehingga mereka akan memiliki peluang tak terbatas untuk mengoptimalkan penipuan mereka agar tidak terpicu pertahanan dompet itu. Semua AI modern memiliki bug di suatu tempat, dan itu tidak terlalu sulit untuk proses pelatihan, bahkan hanya dengan satu saja akses terbatas ke model, untuk menemukannya.

Di sinilah “AI yang berpartisipasi dalam pasar mikro on-chain” bekerja lebih baik: setiap AI rentan terhadap risiko yang sama, namun Anda dengan sengaja menciptakan ekosistem terbuka yang terdiri dari lusinan orang yang terus-menerus mengulangi dan memperbaikinya secara berkelanjutan. Selain itu, setiap AI bersifat tertutup: keamanan sistem berasal dari keterbukaan aturan permainan, bukan cara kerja internal masing-masing pemain.

Ringkasan: AI dapat membantu pengguna memahami apa yang terjadi dalam bahasa sederhana, dapat berfungsi sebagai tutor real-time, dapat melindungi pengguna dari kesalahan, namun berhati-hatilah saat mencoba menggunakannya secara langsung untuk melawan pemberi informasi yang salah dan penipu yang jahat.

AI sebagai aturan mainnya

Sekarang, kita sampai pada penerapan yang disukai banyak orang, namun menurut saya paling berisiko, dan kita perlu melangkah dengan sangat hati-hati: apa yang saya sebut sebagai AI sebagai bagian dari aturan permainan. Hal ini terkait dengan kegembiraan di kalangan elit politik arus utama mengenai “hakim AI” (misalnya, lihat artikel ini di situs web “KTT Pemerintah Dunia”), dan terdapat analogi dari keinginan ini dalam aplikasi blockchain. Jika kontrak pintar berbasis blockchain atau DAO perlu membuat keputusan subjektif (misalnya apakah produk pekerjaan tertentu dapat diterima dalam kontrak kerja untuk disewa? Manakah interpretasi yang benar dari konstitusi bahasa alami seperti Optimisme? Hukum Rantai?), bisakah Anda menjadikan AI sebagai bagian dari kontrak atau DAO untuk membantu menegakkan aturan ini?

Di sinilah pembelajaran mesin permusuhan akan menjadi tantangan yang sangat berat. Argumen dasar dua kalimat mengapa adalah sebagai berikut:

Jika model AI yang memainkan peran kunci dalam suatu mekanisme ditutup, Anda tidak dapat memverifikasi cara kerja bagian dalamnya, sehingga tidak lebih baik dari aplikasi terpusat. Jika model AI terbuka, maka penyerang dapat mengunduh dan mensimulasikannya secara lokal, dan merancang serangan yang sangat dioptimalkan untuk mengelabui model tersebut, yang kemudian dapat diputar ulang di jaringan langsung.

Sekarang, para pembaca setia blog ini (atau para penghuni dunia kripto) mungkin sudah mendahului saya, dan berpikir: tapi tunggu dulu! Kami tidak memiliki bukti pengetahuan dan bentuk kriptografi keren lainnya. Tentunya kita dapat melakukan keajaiban kripto, dan menyembunyikan cara kerja model sehingga penyerang tidak dapat mengoptimalkan serangan, tetapi pada saat yang sama membuktikan bahwa model dijalankan dengan benar, dan dibuat menggunakan proses pelatihan yang wajar pada kumpulan data dasar yang masuk akal!

Biasanya, ini adalah persis jenis pemikiran yang saya anjurkan baik di blog ini maupun di tulisan saya yang lain. Namun dalam kasus komputasi terkait AI, ada dua keberatan utama:

- Overhead kriptografi: melakukan sesuatu di dalam SNARK (atau MPC atau…) jauh lebih tidak efisien dibandingkan melakukannya “secara jelas”. Mengingat AI sudah sangat intensif secara komputasi, apakah penerapan AI di dalam kotak hitam kriptografi dapat dilakukan secara komputasi?

- Serangan pembelajaran mesin permusuhan kotak hitam: ada cara untuk mengoptimalkan serangan terhadap model AI bahkan tanpa mengetahui banyak hal tentang cara kerja internal model. Dan jika Anda bersembunyi terlalu banyak, Anda berisiko mempersulit siapa pun yang memilih data pelatihan untuk merusak model peracunan serangan.

Keduanya merupakan lubang kelinci yang rumit, jadi mari kita bahas masing-masing lubang tersebut satu per satu.

Overhead kriptografi

Gadget kriptografi, terutama yang bertujuan umum seperti ZK-SNARKs dan MPC, memiliki overhead yang tinggi. Sebuah blok Ethereum membutuhkan waktu beberapa ratus milidetik bagi klien untuk memverifikasi secara langsung, namun menghasilkan ZK-SNARK untuk membuktikan kebenaran blok tersebut dapat memakan waktu berjam-jam. Overhead yang umum terjadi pada gadget kriptografi lainnya, seperti MPC, bisa lebih buruk lagi. Komputasi AI sudah mahal: LLM yang paling canggih hanya dapat menghasilkan kata-kata individual sedikit lebih cepat daripada kemampuan manusia untuk membacanya, belum lagi biaya komputasi yang sering kali bernilai jutaan dolar. latihan para model. Perbedaan kualitas antara model papan atas dan model yang mencoba berhemat jauh lebih besar biaya pelatihan or jumlah parameter besar. Pada pandangan pertama, ini adalah alasan yang sangat bagus untuk mencurigai keseluruhan proyek yang mencoba menambahkan jaminan pada AI dengan membungkusnya dalam kriptografi.

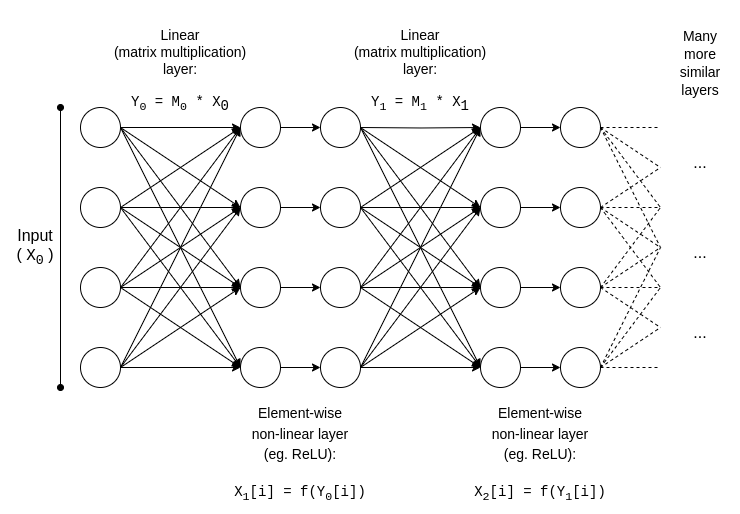

Untungnya, bagaimanapun, AI adalah a tipe yang sangat spesifik komputasi, yang membuatnya dapat menerima semua jenis optimasi yang tidak dapat dimanfaatkan oleh jenis komputasi yang lebih “tidak terstruktur” seperti ZK-EVM. Mari kita periksa struktur dasar model AI:

y = max(x, 0)). Secara asimtotik, perkalian matriks menghabiskan sebagian besar pekerjaan: mengalikan dua N*N Matriks membutuhkan �(�2.8) waktu, sedangkan jumlah operasi non-linier jauh lebih kecil. Hal ini sangat berguna untuk kriptografi, karena banyak bentuk kriptografi yang dapat melakukan operasi linier (yang merupakan perkalian matriks, setidaknya jika Anda mengenkripsi modelnya tetapi tidak mengenkripsi inputnya) hampir “gratis”.

Jika Anda seorang kriptografer, Anda mungkin pernah mendengar fenomena serupa dalam konteksnya enkripsi homomorfik: tampil tambahan pada ciphertext terenkripsi sangat mudah, tapi perkalian sangat sulit dan kami tidak menemukan cara apa pun untuk melakukannya dengan kedalaman tak terbatas hingga tahun 2009.

Untuk ZK-SNARK, persamaannya adalah protokol seperti ini dari tahun 2013, yang menunjukkan a kurang dari 4x overhead pada pembuktian perkalian matriks. Sayangnya, overhead pada lapisan non-linear masih tetap signifikan, dan implementasi terbaik dalam praktiknya menunjukkan overhead sekitar 200x. Namun ada harapan bahwa hal ini dapat dikurangi melalui penelitian lebih lanjut; melihat presentasi ini dari Ryan Cao untuk pendekatan terbaru berdasarkan GKR, dan pendekatan saya sendiri penjelasan sederhana tentang cara kerja komponen utama GKR.

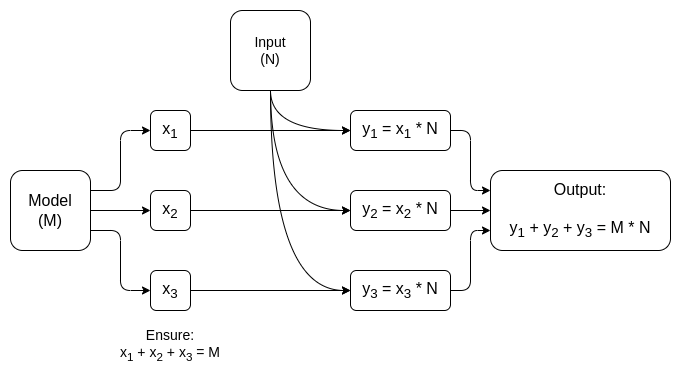

Namun untuk banyak aplikasi, kami tidak hanya menginginkannya membuktikan agar keluaran AI dihitung dengan benar, kami juga menginginkannya menyembunyikan modelnya. Ada pendekatan naif dalam hal ini: Anda dapat membagi model sehingga kumpulan server berbeda menyimpan setiap lapisan secara berlebihan, dan berharap beberapa server yang membocorkan beberapa lapisan tidak membocorkan terlalu banyak data. Namun ada juga bentuk-bentuk yang sangat efektif komputasi multi-pihak yang terspesialisasi.

Dalam kedua kasus tersebut, pesan moral dari cerita ini sama: bagian terbesar dari komputasi AI adalah perkalian matriks, yang dapat dilakukan sangat efisien ZK-SNARK atau MPC (atau bahkan FHE), sehingga total biaya penempatan AI di dalam kotak kriptografi ternyata sangat rendah. Secara umum, lapisan non-linierlah yang merupakan hambatan terbesar meskipun ukurannya lebih kecil; mungkin teknik yang lebih baru seperti argumen pencarian dapat membantu.

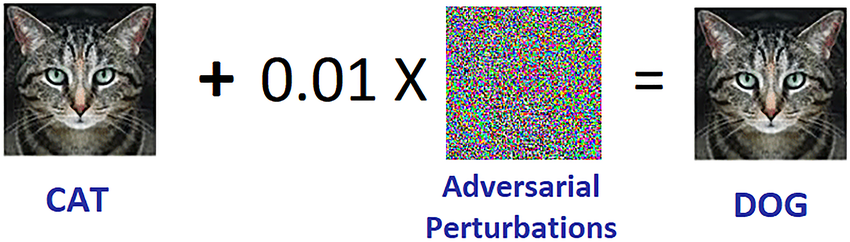

Pembelajaran mesin permusuhan kotak hitam

Sekarang, mari kita bahas masalah besar lainnya: jenis serangan yang dapat Anda lakukan meskipun konten model dijaga kerahasiaannya dan Anda hanya memiliki "akses API" ke model tersebut. Mengutip a kertas dari 2016:

Banyak model pembelajaran mesin yang rentan terhadap contoh permusuhan: masukan yang dibuat khusus untuk menyebabkan model pembelajaran mesin menghasilkan keluaran yang salah. Contoh permusuhan yang memengaruhi satu model sering kali memengaruhi model lain, meskipun kedua model tersebut memiliki arsitektur berbeda atau dilatih pada set pelatihan berbeda, selama kedua model dilatih untuk melakukan tugas yang sama. Oleh karena itu, penyerang dapat melatih model penggantinya sendiri, membuat contoh permusuhan terhadap penggantinya, dan mentransfernya ke model korban, dengan sedikit informasi tentang korban.

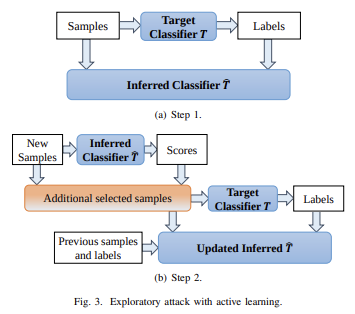

Berpotensi, Anda bahkan dapat membuat serangan dengan mengetahui hanya data pelatihan, meskipun Anda memiliki akses yang sangat terbatas atau tidak sama sekali terhadap model yang Anda coba serang. Pada tahun 2023, serangan semacam ini terus menjadi masalah besar.

Untuk secara efektif mengurangi serangan kotak hitam semacam ini, kita perlu melakukan dua hal:

- Benar-benar membatasi siapa atau apa yang dapat menanyakan model dan berapa banyak. Kotak hitam dengan akses API tidak terbatas tidak aman; kotak hitam dengan akses API yang sangat terbatas mungkin.

- Sembunyikan data pelatihan, sekaligus menjaga kepercayaan bahwa proses yang digunakan untuk membuat data pelatihan tidak rusak.

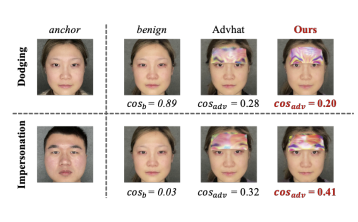

Proyek yang paling banyak melakukan yang pertama mungkin adalah Worldcoin, yang mana saya menganalisis versi sebelumnya (di antara protokol lainnya) secara panjang lebar. di sini. Worldcoin menggunakan model AI secara ekstensif pada tingkat protokol, untuk (i) mengubah pemindaian iris menjadi “kode iris” pendek yang mudah dibandingkan untuk kesamaan, dan (ii) memverifikasi bahwa benda yang dipindai sebenarnya adalah manusia. Pertahanan utama yang diandalkan oleh Worldcoin adalah fakta itu Ia tidak membiarkan siapa pun memanggil model AI begitu saja: melainkan menggunakan perangkat keras tepercaya untuk memastikan bahwa model tersebut hanya menerima masukan yang ditandatangani secara digital oleh kamera bola tersebut..

Pendekatan ini tidak dijamin berhasil: ternyata Anda dapat melakukan serangan permusuhan terhadap AI biometrik dalam bentuk tambalan fisik atau perhiasan yang bisa Anda pasang di wajah Anda:

Tapi harapannya adalah jika Anda menggabungkan semua pertahanan bersama-sama, menyembunyikan model AI itu sendiri, sangat membatasi jumlah kueri, dan mengharuskan setiap kueri diautentikasi, Anda dapat melakukan serangan musuh dengan cukup sulit sehingga sistem bisa aman.

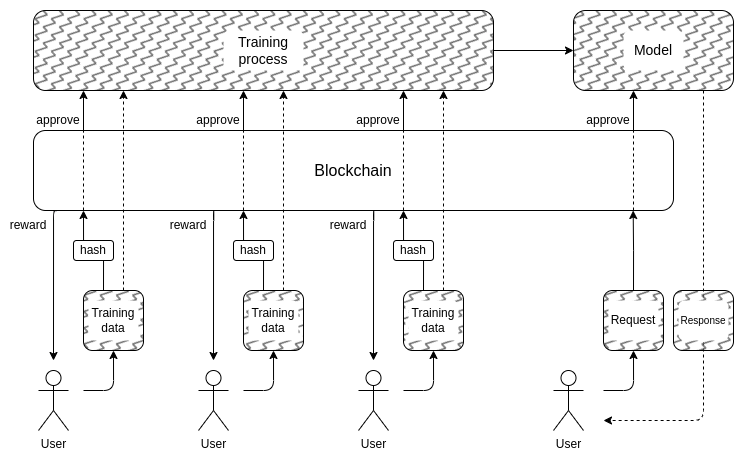

Dan ini membawa kita ke bagian kedua: bagaimana kita menyembunyikan data pelatihan? Di sinilah “DAO yang mengatur AI secara demokratis” mungkin sebenarnya masuk akal: kita dapat membuat DAO on-chain yang mengatur proses siapa yang diizinkan mengirimkan data pelatihan (dan pengesahan apa yang diperlukan pada data itu sendiri), siapa yang diizinkan membuat kueri, dan berapa banyak, serta menggunakan teknik kriptografi seperti MPC untuk mengenkripsi seluruh alur pembuatan dan menjalankan AI dari setiap masukan pelatihan pengguna hingga keluaran akhir setiap kueri. DAO ini secara bersamaan dapat memenuhi tujuan yang sangat populer, yaitu memberikan kompensasi kepada orang-orang yang mengirimkan data.

- Overhead kriptografi masih bisa menjadi terlalu tinggi agar arsitektur kotak hitam semacam ini dapat bersaing dengan pendekatan “percayalah” yang tertutup dan tradisional.

- Ternyata bisa jadi seperti itu tidak ada cara yang baik untuk membuat proses pengiriman data pelatihan terdesentralisasi dan terlindung terhadap serangan keracunan.

- Gadget komputasi multi-pihak bisa rusak jaminan keamanan atau privasi mereka karena peserta berkolusi: lagipula, hal ini terjadi pada jembatan mata uang kripto lintas rantai lagi dan lagi.

Salah satu alasan mengapa saya tidak memulai bagian ini dengan label peringatan merah besar yang mengatakan “JANGAN LAKUKAN HAKIM AI, ITU DYSTOPIAN”, adalah karena masyarakat kita sudah sangat bergantung pada hakim AI terpusat yang tidak dapat dipertanggungjawabkan: algoritma yang menentukan jenis penilaian apa yang akan dilakukan. postingan dan opini politik disebarkan dan di-deboost, atau bahkan disensor, di media sosial. Saya pikir itu memperluas tren ini lebih lanjut pada tahap ini adalah ide yang cukup buruk, tapi menurut saya kemungkinannya kecil komunitas blockchain lebih banyak bereksperimen dengan AI akan menjadi hal yang berkontribusi memperburuknya.

Faktanya, ada beberapa cara yang cukup mendasar dan berisiko rendah yang dapat dilakukan oleh teknologi kripto untuk menjadikan sistem terpusat yang ada ini menjadi lebih baik, yang saya yakini. Salah satu teknik sederhananya adalah AI terverifikasi dengan publikasi tertunda: ketika situs media sosial membuat peringkat postingan berbasis AI, situs tersebut dapat menerbitkan ZK-SNARK yang membuktikan hash model yang menghasilkan peringkat tersebut. Situs tersebut dapat berkomitmen untuk mengungkapkan model AI-nya setelahnya, misalnya. penundaan satu tahun. Setelah model terungkap, pengguna dapat memeriksa hash untuk memverifikasi bahwa model yang benar telah dirilis, dan komunitas dapat menjalankan pengujian pada model tersebut untuk memverifikasi keadilannya. Penundaan publikasi akan memastikan bahwa pada saat model tersebut terungkap, model tersebut sudah ketinggalan jaman.

Jadi dibandingkan dengan terpusat dunia, pertanyaannya adalah tidak if kita bisa berbuat lebih baik, tapi seberapa banyak. Untuk dunia yang terdesentralisasiNamun, penting untuk berhati-hati: jika seseorang membangun misalnya. pasar prediksi atau stablecoin yang menggunakan oracle AI, dan ternyata oracle tersebut dapat diserang, itu adalah sejumlah besar uang yang bisa hilang dalam sekejap.

AI sebagai tujuan permainan

Jika teknik di atas untuk membuat AI pribadi terdesentralisasi yang dapat diskalakan, yang isinya adalah kotak hitam yang tidak diketahui oleh siapa pun, benar-benar dapat berfungsi, maka teknik ini juga dapat digunakan untuk membuat AI dengan kegunaan yang melampaui blockchain. Tim protokol NEAR membuat ini a tujuan inti dari pekerjaan mereka yang sedang berlangsung.

Ada dua alasan untuk melakukan ini:

- Jika kamu bisa membuat "AI kotak hitam yang dapat dipercaya” dengan menjalankan proses pelatihan dan inferensi menggunakan beberapa kombinasi blockchain dan MPC, maka banyak aplikasi yang penggunanya khawatir sistemnya bias atau curang dapat mengambil manfaat darinya. Banyak orang telah menyatakan keinginannya pemerintahan yang demokratis AI yang penting secara sistemis yang akan kita andalkan; teknik kriptografi dan berbasis blockchain bisa menjadi jalan untuk melakukan hal tersebut.

- Dari sebuah Keamanan AI Dari sudut pandang ini, ini akan menjadi teknik untuk menciptakan AI terdesentralisasi yang juga memiliki tombol pemutus (kill switch) alami, dan dapat membatasi permintaan yang berupaya menggunakan AI untuk perilaku jahat.

Perlu juga dicatat bahwa “menggunakan insentif kripto untuk memberi insentif pada pembuatan AI yang lebih baik” dapat dilakukan tanpa harus menggunakan kriptografi untuk mengenkripsinya sepenuhnya: pendekatan seperti BitTensor termasuk dalam kategori ini.

Kesimpulan

Kini, ketika blockchain dan AI menjadi lebih kuat, terdapat semakin banyak kasus penggunaan di persimpangan kedua area tersebut. Namun, beberapa kasus penggunaan ini jauh lebih masuk akal dan lebih kuat dibandingkan kasus penggunaan lainnya. Secara umum, kasus penggunaan di mana mekanisme yang mendasarinya terus dirancang secara kasar seperti sebelumnya, tetapi secara individual pemain menjadi AI, yang memungkinkan mekanisme tersebut beroperasi secara efektif pada skala yang jauh lebih mikro, merupakan hal yang paling menjanjikan dan paling mudah dilakukan.

Yang paling menantang untuk dilakukan dengan benar adalah aplikasi yang mencoba menggunakan blockchain dan teknik kriptografi untuk menciptakan “singleton”: satu AI tepercaya terdesentralisasi yang akan diandalkan oleh beberapa aplikasi untuk tujuan tertentu. Aplikasi-aplikasi ini menjanjikan, baik dari segi fungsionalitas maupun untuk meningkatkan keamanan AI dengan cara menghindari risiko sentralisasi yang terkait dengan pendekatan yang lebih umum terhadap masalah tersebut. Namun ada juga banyak kemungkinan kegagalan asumsi yang mendasarinya; oleh karena itu, ada baiknya kita berhati-hati, terutama ketika menerapkan aplikasi ini dalam konteks bernilai tinggi dan berisiko tinggi.

Saya berharap dapat melihat lebih banyak upaya penggunaan AI yang konstruktif di semua bidang ini, sehingga kita dapat melihat mana di antara bidang-bidang tersebut yang benar-benar layak dalam skala besar.

Penulis: Vitalik Buterin

- Konten Bertenaga SEO & Distribusi PR. Dapatkan Amplifikasi Hari Ini.

- PlatoData.Jaringan Vertikal Generatif Ai. Berdayakan Diri Anda. Akses Di Sini.

- PlatoAiStream. Intelijen Web3. Pengetahuan Diperkuat. Akses Di Sini.

- PlatoESG. Karbon, teknologi bersih, energi, Lingkungan Hidup, Tenaga surya, Penanganan limbah. Akses Di Sini.

- PlatoHealth. Kecerdasan Uji Coba Biotek dan Klinis. Akses Di Sini.

- BlockOffset. Modernisasi Kepemilikan Offset Lingkungan. Akses Di Sini.

- Sumber: Kecerdasan Data Plato.