Postingan ini ditulis bersama Justin Miles, Liv d'Aliberti, dan Joe Kovba dari Leidos.

Leidos adalah pemimpin solusi sains dan teknologi Fortune 500 yang bekerja untuk mengatasi beberapa tantangan terberat di dunia dalam pasar pertahanan, intelijen, keamanan dalam negeri, sipil, dan layanan kesehatan. Dalam postingan ini, kami membahas bagaimana Leidos bekerja dengan AWS untuk mengembangkan pendekatan terhadap inferensi model bahasa besar (LLM) yang menjaga privasi menggunakan Enklave AWS Nitro.

LLM dirancang untuk memahami dan menghasilkan bahasa mirip manusia, dan digunakan di banyak industri, termasuk pemerintahan, perawatan kesehatan, keuangan, dan kekayaan intelektual. LLM memiliki penerapan yang luas, termasuk chatbots, pembuatan konten, terjemahan bahasa, analisis sentimen, sistem penjawab pertanyaan, mesin pencari, dan pembuatan kode. Memperkenalkan inferensi berbasis LLM ke dalam sistem juga berpotensi menimbulkan ancaman privasi, termasuk eksfiltrasi model, pelanggaran privasi data, dan manipulasi layanan berbasis LLM yang tidak disengaja. Arsitektur teknis perlu diterapkan untuk memastikan bahwa LLM tidak memaparkan informasi sensitif selama inferensi.

Postingan ini membahas bagaimana Nitro Enclave dapat membantu melindungi penerapan model LLM, khususnya yang menggunakan informasi identitas pribadi (PII) atau informasi kesehatan yang dilindungi (PHI). Postingan ini hanya untuk tujuan pendidikan dan tidak boleh digunakan di lingkungan produksi tanpa kontrol tambahan.

Ikhtisar LLM dan Nitro Enclave

Kasus penggunaan potensial adalah chatbot kueri sensitif berbasis LLM yang dirancang untuk menjalankan layanan tanya jawab yang berisi PII dan PHI. Sebagian besar solusi chatbot LLM saat ini secara eksplisit memberi tahu pengguna bahwa mereka tidak boleh menyertakan PII atau PHI saat memasukkan pertanyaan karena masalah keamanan. Untuk memitigasi kekhawatiran ini dan melindungi data pelanggan, pemilik layanan terutama mengandalkan perlindungan pengguna seperti berikut:

- Redaksi – Proses mengidentifikasi dan mengaburkan informasi sensitif seperti PII dalam dokumen, teks, atau bentuk konten lainnya. Hal ini dapat dicapai dengan memasukkan data sebelum dikirim ke model atau LLM yang dilatih untuk menyunting respons mereka secara otomatis.

- Otentikasi multi-faktor – Proses keamanan yang mengharuskan pengguna menyediakan beberapa metode autentikasi untuk memverifikasi identitas mereka guna mendapatkan akses ke LLM.

- Transport Layer Security (TLS) – Protokol kriptografi yang menyediakan komunikasi aman yang meningkatkan privasi data dalam transit antara pengguna dan layanan LLM.

Meskipun praktik ini meningkatkan postur keamanan layanan, namun hal ini tidak cukup untuk melindungi semua informasi sensitif pengguna dan informasi sensitif lainnya yang dapat disimpan tanpa sepengetahuan pengguna.

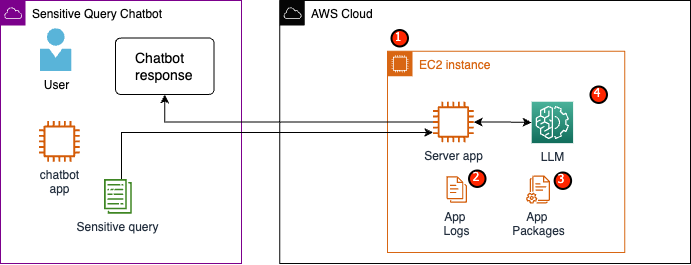

Dalam contoh kasus penggunaan kami, layanan LLM dirancang untuk menjawab pertanyaan tunjangan kesehatan karyawan atau menyediakan program pensiun pribadi. Mari kita menganalisis contoh arsitektur berikut dan mengidentifikasi area risiko privasi data.

Area risiko potensial adalah sebagai berikut:

- Pengguna yang memiliki hak istimewa memiliki akses ke instance yang menampung server. Perubahan yang tidak disengaja atau tidak sah pada layanan dapat mengakibatkan data sensitif terekspos dengan cara yang tidak diinginkan.

- Pengguna harus percaya bahwa layanan tidak akan mengekspos atau menyimpan informasi sensitif dalam log aplikasi.

- Perubahan pada paket aplikasi dapat menyebabkan perubahan pada layanan, yang mengakibatkan terbukanya data sensitif.

- Pengguna yang memiliki hak istimewa dengan akses ke instans memiliki akses tidak terbatas ke LLM yang digunakan oleh layanan. Perubahan dapat menyebabkan informasi yang salah atau tidak akurat dikembalikan kepada pengguna.

Nitro Enclaves memberikan isolasi tambahan untuk Anda Cloud komputasi elastis Amazon (Amazon EC2), melindungi data yang digunakan dari akses tidak sah, termasuk pengguna tingkat admin. Dalam arsitektur sebelumnya, perubahan yang tidak disengaja mungkin saja mengakibatkan data sensitif tetap berada dalam teks biasa dan secara tidak sengaja terungkap kepada pengguna yang mungkin tidak perlu mengakses data tersebut. Dengan Nitro Enclave, Anda membuat lingkungan terisolasi dari instans EC2, memungkinkan Anda mengalokasikan sumber daya CPU dan memori ke enclave. Daerah kantong ini adalah mesin virtual yang sangat membatasi. Dengan menjalankan kode yang menangani data sensitif dalam enklave, tidak ada proses induk yang dapat melihat data enklave.

Nitro Enclaves menawarkan manfaat berikut:

- Isolasi Memori dan CPU – Ini bergantung pada Nitro Hypervisor untuk mengisolasi CPU dan memori enclave dari pengguna, aplikasi, dan perpustakaan pada instans induk. Fitur ini membantu mengisolasi enclave dan perangkat lunak Anda, dan secara signifikan mengurangi luas permukaan untuk kejadian yang tidak diinginkan.

- Mesin virtual terpisah – Enclave adalah mesin virtual terpisah yang terpasang pada instans EC2 untuk lebih melindungi dan memproses data yang sangat sensitif dengan aman.

- Tidak ada akses interaktif – Enclave hanya menyediakan konektivitas soket lokal yang aman dengan instance induknya. Mereka tidak memiliki penyimpanan persisten, akses interaktif, atau jaringan eksternal.

- Pengesahan kriptografi – Penawaran Nitro Enklave pengesahan kriptografi, sebuah proses yang digunakan untuk membuktikan identitas enklave dan memverifikasi bahwa hanya kode resmi yang berjalan di enklave Anda.

- Integrasi AWS – Nitro Enclave terintegrasi dengan Layanan Manajemen Kunci AWS (AWS KMS), memungkinkan Anda mendekripsi file yang telah dienkripsi menggunakan AWS KMS di dalam enklave. Manajer Sertifikat AWS (ACM) untuk Nitro Enclave memungkinkan Anda menggunakan sertifikat SSL/TLS publik dan privat dengan aplikasi web dan server Anda yang berjalan pada instans EC2 dengan Nitro Enclave.

Anda dapat menggunakan fitur-fitur yang disediakan oleh Nitro Enclaves untuk membantu memitigasi risiko yang terkait dengan data PII dan PHI. Kami merekomendasikan untuk menyertakan Nitro Enclave dalam layanan LLM saat menangani data pengguna yang sensitif.

Ikhtisar solusi

Mari kita periksa arsitektur layanan contoh, yang sekarang termasuk Nitro Enclaves. Dengan menggabungkan Nitro Enclaves, seperti yang ditunjukkan pada gambar berikut, LLM menjadi chatbot yang lebih aman untuk menangani data PHI atau PII.

Data pengguna, termasuk PII, PHI, dan pertanyaan, tetap terenkripsi selama proses permintaan-respons saat aplikasi dihosting dalam enclave. Langkah-langkah yang dilakukan pada saat inferensi adalah sebagai berikut:

- Aplikasi chatbot menghasilkan kredensial AWS sementara dan meminta pengguna untuk memasukkan pertanyaan. Pertanyaannya, yang mungkin berisi PII atau PHI, kemudian dienkripsi melalui AWS KMS. Input pengguna terenkripsi digabungkan dengan kredensial sementara untuk membuat permintaan terenkripsi.

- Data terenkripsi dikirim ke server HTTP yang dihosting oleh Flask sebagai permintaan POST. Sebelum menerima data sensitif, titik akhir ini harus dikonfigurasi untuk HTTP.

- Aplikasi klien menerima permintaan POST dan meneruskannya melalui saluran lokal yang aman (misalnya, vsock) ke aplikasi server yang berjalan di dalam Nitro Enclaves.

- Aplikasi server Nitro Enclaves menggunakan kredensial sementara untuk mendekripsi permintaan, menanyakan LLM, dan menghasilkan respons. Pengaturan khusus model disimpan di dalam enklave dan dilindungi dengan pengesahan kriptografi.

- Aplikasi server menggunakan kredensial sementara yang sama untuk mengenkripsi respons.

- Respons terenkripsi dikembalikan ke aplikasi chatbot melalui aplikasi klien sebagai respons dari permintaan POST.

- Aplikasi chatbot mendekripsi respons menggunakan kunci KMS dan menampilkan teks biasa kepada pengguna.

Prasyarat

Sebelum memulai, Anda memerlukan prasyarat berikut untuk menerapkan solusi:

Konfigurasikan instans EC2

Selesaikan langkah-langkah berikut untuk mengonfigurasi instans EC2:

- Luncurkan r5.8xbesar Instans EC2 menggunakan amzn2-ami-kernel-5.10-hvm-2.0.20230628.0-x86_64-gp2 AMI dengan Nitro Enklave diaktifkan.

- Instal Nitro Enclaves CLI untuk membangun dan menjalankan aplikasi Nitro Enclaves:

sudo amazon-linux-extras install aws-nitro-enclaves-cli -ysudo yum install aws-nitro-enclaves-cli-devel -y

- Verifikasi instalasi Nitro Enclaves CLI:

nitro-cli –version- Versi yang digunakan dalam postingan ini adalah 1.2.2

- Instal Git dan Docker untuk membuat image Docker dan unduh aplikasi dari GitHub. Tambahkan pengguna instans Anda ke grup Docker ( adalah pengguna instans IAM Anda):

sudo yum install git -ysudo usermod -aG ne <USER>sudo usermod -aG docker <USER>sudo systemctl start docker && sudo systemctl enable docker

- Mulai dan aktifkan layanan pengalokasi Nitro Enclaves dan proxy vsock:

sudo systemctl start nitro-enclaves-allocator.service && sudo systemctl enable nitro-enclaves-allocator.servicesudo systemctl start nitro-enclaves-vsock-proxy.service && sudo systemctl enable nitro-enclaves-vsock-proxy.service

Nitro Enclave menggunakan koneksi soket lokal yang disebut vsock untuk membuat saluran aman antara instance induk dan enclave.

Setelah semua layanan dimulai dan diaktifkan, mulai ulang instance untuk memverifikasi bahwa semua grup pengguna dan layanan berjalan dengan benar:

sudo shutdown -r now

Konfigurasikan layanan pengalokasi Nitro Enclaves

Nitro Enclave adalah lingkungan terisolasi yang menetapkan sebagian CPU dan memori instance untuk menjalankan enclave. Dengan layanan pengalokasi Nitro Enclaves, Anda dapat menunjukkan berapa banyak CPU dan berapa banyak memori yang akan diambil dari instance induk untuk menjalankan enclave.

Ubah sumber daya cadangan enklave menggunakan editor teks (untuk solusi kami, kami mengalokasikan 8 CPU dan 70,000 MiB memori untuk menyediakan sumber daya yang cukup):

vi /etc/nitro_enclaves/allocatory.yaml

Mengkloning proyek

Setelah Anda mengonfigurasi instans EC2, Anda dapat mengunduh kode untuk menjalankan chatbot sensitif dengan LLM di dalam Nitro Enclaves.

Anda perlu memperbarui server.py file dengan ID kunci KMS sesuai yang Anda buat di awal untuk mengenkripsi respons LLM.

- Kloning proyek GitHub:

cd ~/ && git clone https://<THE_REPO.git>

- Arahkan ke folder proyek untuk membangun

enclave_baseGambar Docker yang berisi Kit Pengembangan Perangkat Lunak Nitro Enclave (SDK) untuk dokumen pengesahan kriptografi dari Nitro Hypervisor (langkah ini dapat memakan waktu hingga 15 menit):cd /nitro_llm/enclave_basedocker build ./ -t “enclave_base”

Simpan LLM di Instans EC2

Kami menggunakan Bloom 560m LLM sumber terbuka untuk pemrosesan bahasa alami guna menghasilkan tanggapan. Model ini tidak disesuaikan dengan PII dan PHI, namun menunjukkan bagaimana LLM dapat hidup di dalam enklave. Model juga perlu disimpan pada instance induk agar dapat disalin ke enclave melalui Dockerfile.

- Navigasi ke proyek:

cd /nitro_llm

- Instal persyaratan yang diperlukan untuk menyimpan model secara lokal:

pip3 install requirements.txt

- Jalankan

save_model.pyaplikasi untuk menyimpan model di dalamnya/nitro_llm/enclave/bloomdirektori:python3 save_model.py

Bangun dan jalankan image Nitro Enclaves

Untuk menjalankan Nitro Enclaves, Anda perlu membuat file image enclave (EIF) dari image Docker aplikasi Anda. Dockerfile yang terletak di direktori enclave berisi file, kode, dan LLM yang akan dijalankan di dalam enclave.

Membangun dan menjalankan enklave akan memakan waktu beberapa menit untuk menyelesaikannya.

- Arahkan ke akar proyek:

cd /nitro_llm

- Bangun file gambar enklave sebagai

enclave.eif:nitro-cli build-enclave --docker-uri enclave:latest --output-file enclave.eif

Ketika enclave dibangun, serangkaian hash unik dan register konfigurasi platform (PCR) akan dibuat. PCR adalah pengukuran yang berdekatan untuk membuktikan identitas perangkat keras dan aplikasi. PCR ini akan diperlukan untuk pengesahan kriptografi dan digunakan selama langkah pembaruan kebijakan kunci KMS.

- Jalankan enklave dengan sumber daya dari

allocator.service(menambahkan--attach-consoleargumen di akhir akan menjalankan enklave dalam mode debug):nitro-cli run-enclave --cpu-count 8 --memory 70000 --enclave-cid 16 --eif-path enclave.eif

Anda perlu mengalokasikan setidaknya empat kali ukuran file EIF. Ini dapat dimodifikasi di allocator.service dari langkah sebelumnya.

- Verifikasi enklave berjalan dengan perintah berikut:

nitro-cli describe-enclaves

Perbarui kebijakan kunci KMS

Selesaikan langkah-langkah berikut untuk memperbarui kebijakan kunci KMS Anda:

- Di konsol AWS KMS, pilih Kunci yang dikelola pelanggan di panel navigasi.

- Cari kunci yang Anda buat sebagai prasyarat.

- Pilih Edit pada kebijakan utama.

- Perbarui kebijakan utama dengan informasi berikut:

- ID akun Anda

- Nama pengguna IAM Anda

- Peran instans lingkungan Cloud9 yang diperbarui

- tindakan

kms:Encryptdankms:Decrypt - Enklave PCR (misalnya, PCR0, PCR1, PCR2) ke kebijakan kunci Anda dengan pernyataan kondisi

Lihat kode kebijakan utama berikut:

Simpan aplikasi chatbot

Untuk meniru aplikasi chatbot kueri sensitif yang berada di luar akun AWS, Anda perlu menyimpan chatbot.py aplikasi dan jalankan di dalam lingkungan Cloud9. Lingkungan Cloud9 Anda akan menggunakan peran instansnya untuk kredensial sementara guna memisahkan izin dari EC2 yang menjalankan enclave. Selesaikan langkah-langkah berikut:

- Di konsol Cloud9, buka lingkungan yang Anda buat.

- Salin kode berikut ke dalam file baru seperti

chatbot.pyke dalam direktori utama. - Instal modul yang diperlukan:

pip install boto3Pip install requests

- Di konsol Amazon EC2, catat IP yang terkait dengan instans Nitro Enclave Anda.

- Perbarui variabel URL di

http://<ec2instanceIP>:5001.

- Jalankan aplikasi chatbot:

-

python3 chat.py

Saat berjalan, terminal akan meminta masukan pengguna dan mengikuti diagram arsitektur dari sebelumnya untuk menghasilkan respons yang aman.

Jalankan chatbot tanya jawab pribadi

Sekarang setelah Nitro Enclaves aktif dan berjalan pada instans EC2, Anda dapat mengajukan pertanyaan PHI dan PII pada chatbot Anda dengan lebih aman. Mari kita lihat sebuah contoh.

Dalam lingkungan Cloud9, kami mengajukan pertanyaan kepada chatbot kami dan memberikan nama pengguna kami.

AWS KMS mengenkripsi pertanyaan, yang terlihat seperti tangkapan layar berikut.

Kemudian dikirim ke enclave dan diminta ke LLM yang diamankan. Pertanyaan dan tanggapan LLM akan terlihat seperti tangkapan layar berikut (hasil dan tanggapan terenkripsi hanya terlihat di dalam enklave dalam mode debug).

Hasilnya kemudian dienkripsi menggunakan AWS KMS dan dikembalikan ke lingkungan Cloud9 untuk didekripsi.

Membersihkan

Selesaikan langkah-langkah berikut untuk membersihkan sumber daya Anda:

- Hentikan instans EC2 yang dibuat untuk menampung enclave Anda.

- Hapus lingkungan Cloud9.

- Hapus kunci KMS.

- Hapus peran instans EC2 dan izin pengguna IAM.

Kesimpulan

Dalam postingan ini, kami menunjukkan cara menggunakan Nitro Enclaves untuk menerapkan layanan tanya jawab LLM yang mengirim dan menerima informasi PII dan PHI dengan lebih aman. Ini diterapkan di Amazon EC2, dan enklave tersebut terintegrasi dengan AWS KMS yang membatasi akses ke kunci KMS, sehingga hanya Nitro Enclave dan pengguna akhir yang diizinkan untuk menggunakan kunci tersebut dan mendekripsi pertanyaan.

Jika Anda berencana untuk menskalakan arsitektur ini untuk mendukung beban kerja yang lebih besar, pastikan proses pemilihan model sesuai dengan persyaratan model Anda dengan sumber daya EC2. Selain itu, Anda harus mempertimbangkan ukuran permintaan maksimum dan dampaknya terhadap server HTTP serta waktu inferensi terhadap model. Banyak dari parameter ini dapat disesuaikan melalui model dan pengaturan server HTTP.

Cara terbaik untuk menentukan pengaturan dan persyaratan spesifik untuk beban kerja Anda adalah melalui pengujian dengan LLM yang disesuaikan. Meskipun postingan ini hanya menyertakan pemrosesan bahasa alami untuk data sensitif, Anda dapat memodifikasi arsitektur ini untuk mendukung LLM alternatif yang mendukung audio, visi komputer, atau multi-modalitas. Prinsip keamanan yang sama yang disoroti di sini dapat diterapkan pada data dalam format apa pun. Sumber daya yang digunakan untuk membuat postingan ini tersedia di GitHub repo.

Bagikan bagaimana Anda akan mengadaptasi solusi ini untuk lingkungan Anda di bagian komentar.

Tentang Penulis

Justin Miles adalah insinyur cloud di Sektor Modernisasi Digital Leidos di bawah Kantor Teknologi. Di waktu luangnya, dia menikmati bermain golf dan jalan-jalan.

Liv d'Aliberti adalah seorang peneliti dalam Akselerator AI/ML Leidos di bawah Kantor Teknologi. Penelitian mereka berfokus pada pembelajaran mesin yang menjaga privasi.

Chris Renzo adalah Sr. Solution Architect dalam organisasi AWS Defense and Aerospace. Di luar pekerjaan, dia menikmati keseimbangan antara cuaca hangat dan perjalanan.

Joe Kovba adalah Wakil Presiden di Sektor Modernisasi Digital Leidos. Di waktu luangnya, dia menikmati menjadi wasit pertandingan sepak bola dan bermain softball.

- Konten Bertenaga SEO & Distribusi PR. Dapatkan Amplifikasi Hari Ini.

- PlatoData.Jaringan Vertikal Generatif Ai. Berdayakan Diri Anda. Akses Di Sini.

- PlatoAiStream. Intelijen Web3. Pengetahuan Diperkuat. Akses Di Sini.

- PlatoESG. Karbon, teknologi bersih, energi, Lingkungan Hidup, Tenaga surya, Penanganan limbah. Akses Di Sini.

- PlatoHealth. Kecerdasan Uji Coba Biotek dan Klinis. Akses Di Sini.

- Sumber: https://aws.amazon.com/blogs/machine-learning/large-language-model-inference-over-confidential-data-using-aws-nitro-enclaves/