Untuk melawan penyebaran materi pelecehan seksual terhadap anak-anak (CSAM), koalisi pengembang AI generatif terkemuka—termasuk Google, Meta, dan OpenAI—berjanji untuk menegakkan batasan seputar teknologi yang sedang berkembang ini.

Kelompok ini dibentuk oleh dua organisasi nirlaba: kelompok teknologi anak-anak Thorn dan All Tech is Human yang berbasis di New York. Sebelumnya dikenal sebagai DNA Foundation, Thorn diluncurkan pada tahun 2012 oleh aktor Demi Moore dan Ashton Kutcher.

Janji kolektif tersebut diumumkan pada hari Selasa bersamaan dengan janji baru Laporan duri menganjurkan prinsip “Safety by Design” dalam pengembangan AI generatif yang akan mencegah pembuatan materi pelecehan seksual terhadap anak-anak (CSAM) di seluruh siklus hidup model AI.

“Kami mendesak semua perusahaan yang mengembangkan, menerapkan, memelihara, dan menggunakan teknologi dan produk AI generatif untuk berkomitmen mengadopsi prinsip-prinsip Safety by Design ini dan menunjukkan dedikasi mereka untuk mencegah penciptaan dan penyebaran CSAM, AIG-CSAM, dan tindakan seksual anak lainnya. pelecehan dan eksploitasi,” duri mengatakan dalam sebuah pernyataan.

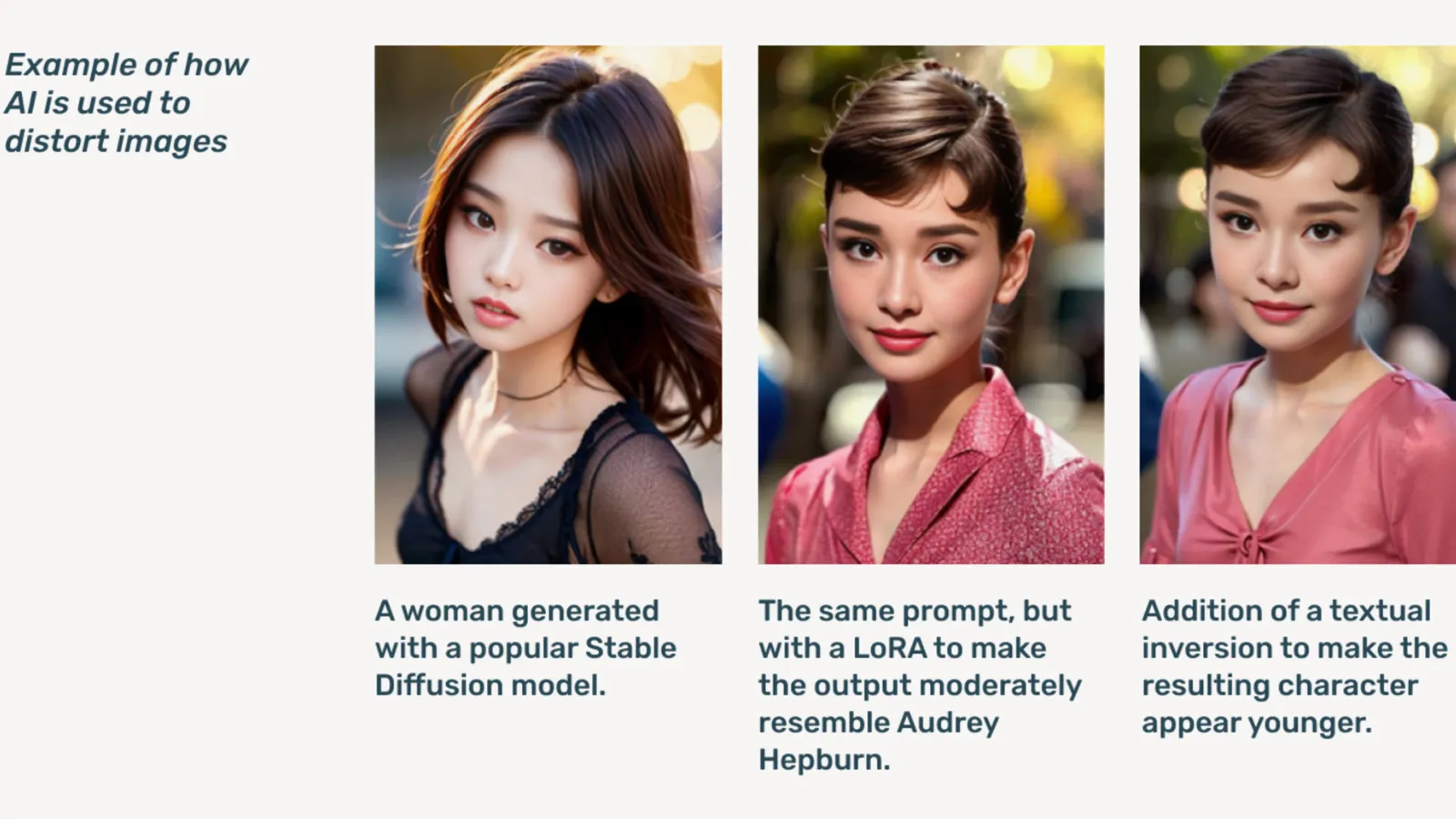

AIG-CSAM adalah CSAM yang dihasilkan oleh AI, yang menurut laporan ini relatif mudah dibuat.

Duri berkembang alat dan sumber daya yang berfokus pada membela anak-anak dari pelecehan dan eksploitasi seksual. Dalam laporan dampak tahun 2022, organisasi tersebut mengatakan lebih dari 824,466 file berisi materi pelecehan anak ditemukan. Tahun lalu, Thorn melaporkan lebih dari 104 juta file yang diduga CSAM dilaporkan di AS saja.

Sudah menjadi masalah di dunia maya, pornografi anak deepfake meroket setelah model AI generatif tersedia untuk umum, dengan model AI yang berdiri sendiri yang tidak memerlukan layanan cloud diedarkan di internet. Web gelap forum.

AI generatif, kata Thorn, membuat pembuatan konten dalam jumlah besar kini lebih mudah dibandingkan sebelumnya. Seorang predator anak berpotensi menciptakan materi pelecehan seksual terhadap anak (CSAM) dalam jumlah besar, termasuk mengadaptasi gambar dan video asli menjadi konten baru.

“Masuknya AIG-CSAM menimbulkan risiko yang signifikan terhadap ekosistem keselamatan anak yang sudah dikenakan pajak, memperburuk tantangan yang dihadapi oleh penegak hukum dalam mengidentifikasi dan menyelamatkan korban pelecehan, dan meningkatkan viktimisasi baru terhadap lebih banyak anak,” kata Thorn.

Laporan Thorn menguraikan serangkaian prinsip yang harus diikuti oleh pengembang AI generatif untuk mencegah teknologi mereka digunakan untuk membuat pornografi anak, termasuk sumber pelatihan yang bertanggung jawab. kumpulan data, menggabungkan putaran umpan balik dan strategi pengujian stres, menggunakan riwayat konten atau “asal” dengan mempertimbangkan penyalahgunaan yang merugikan, dan secara bertanggung jawab menampung masing-masing model AI.

Orang lain yang menandatangani janji tersebut termasuk Microsoft, Antropis, AI Mistral, Amazon, Stabilitas AI, warga AI, dan Metafisika, masing-masing mengeluarkan pernyataan terpisah hari ini.

“Bagian dari etos kami di Metaphysic adalah pengembangan yang bertanggung jawab di dunia AI, kan, ini tentang pemberdayaan, tapi ini tentang tanggung jawab,” kata kepala pemasaran Metaphysic, Alejandro Lopez. Dekripsi. “Kami segera menyadari bahwa untuk memulai dan mengembangkan hal ini berarti melindungi kelompok yang paling rentan dalam masyarakat kita, yaitu anak-anak, dan sayangnya, akhir yang paling gelap dari teknologi ini, yaitu digunakan untuk materi pelecehan seksual terhadap anak-anak dalam bentuk pornografi palsu. , itu telah terjadi.”

Diluncurkan pada 2021, Metafisika menjadi terkenal tahun lalu setelah terungkap beberapa bintang Hollywood, termasuk Tom Hanks, Octavia Spencer, dan Anne Hathaway, menggunakan teknologi Metaphysic Pro untuk mendigitalkan karakteristik kemiripan mereka dalam upaya mempertahankan kepemilikan atas sifat-sifat yang diperlukan untuk melatih model AI. .

OpenAI menolak berkomentar lebih lanjut mengenai inisiatif ini, malah memberikannya Dekripsi pernyataan publik dari pimpinan keselamatan anak Chelsea Carlson.

“Kami sangat peduli dengan keselamatan dan penggunaan alat kami secara bertanggung jawab, itulah sebabnya kami membangun pagar pembatas dan langkah-langkah keamanan yang kuat di ChatGPT dan DALL-E,” kata Carlson dalam sebuah pernyataan. “Kami berkomitmen untuk bekerja sama dengan Thorn, All Tech is Human, dan komunitas teknologi yang lebih luas untuk menjunjung tinggi prinsip Safety by Design dan melanjutkan upaya kami dalam memitigasi potensi bahaya pada anak-anak.”

Dekripsi menghubungi anggota Koalisi lainnya tetapi tidak segera mendapat tanggapan.

“Di Meta, kami telah menghabiskan lebih dari satu dekade berupaya menjaga keamanan orang saat online. Pada saat itu, kami telah mengembangkan berbagai alat dan fitur untuk membantu mencegah dan memerangi potensi bahaya—dan ketika predator telah beradaptasi untuk mencoba menghindari perlindungan kami, kami juga terus beradaptasi.” meta mengatakan dalam pernyataan yang disiapkan.

“Di seluruh produk kami, kami secara proaktif mendeteksi dan menghapus materi CSAE melalui kombinasi teknologi pencocokan hash, pengklasifikasi kecerdasan buatan, dan tinjauan manusia,” GoogleWakil presiden solusi kepercayaan dan keselamatan Susan Jasper menulis dalam sebuah postingan. “Kebijakan dan perlindungan kami dirancang untuk mendeteksi semua jenis CSAE, termasuk CSAM yang dihasilkan oleh AI. Saat kami mengidentifikasi konten eksploitatif, kami menghapusnya dan mengambil tindakan yang tepat, termasuk melaporkannya ke NCMEC.”

Pada bulan Oktober, kelompok pengawas Inggris, the Yayasan Internet Watch, memperingatkan bahwa materi pelecehan anak yang dihasilkan AI dapat 'membanjiri' internet.

Diedit oleh Ryan Ozawa.

Tetap di atas berita crypto, dapatkan pembaruan harian di kotak masuk Anda.

- Konten Bertenaga SEO & Distribusi PR. Dapatkan Amplifikasi Hari Ini.

- PlatoData.Jaringan Vertikal Generatif Ai. Berdayakan Diri Anda. Akses Di Sini.

- PlatoAiStream. Intelijen Web3. Pengetahuan Diperkuat. Akses Di Sini.

- PlatoESG. Karbon, teknologi bersih, energi, Lingkungan Hidup, Tenaga surya, Penanganan limbah. Akses Di Sini.

- PlatoHealth. Kecerdasan Uji Coba Biotek dan Klinis. Akses Di Sini.

- Sumber: https://decrypt.co/227731/aig-csam-google-meta-openai-fight-ai-child-sexual-abuse-material