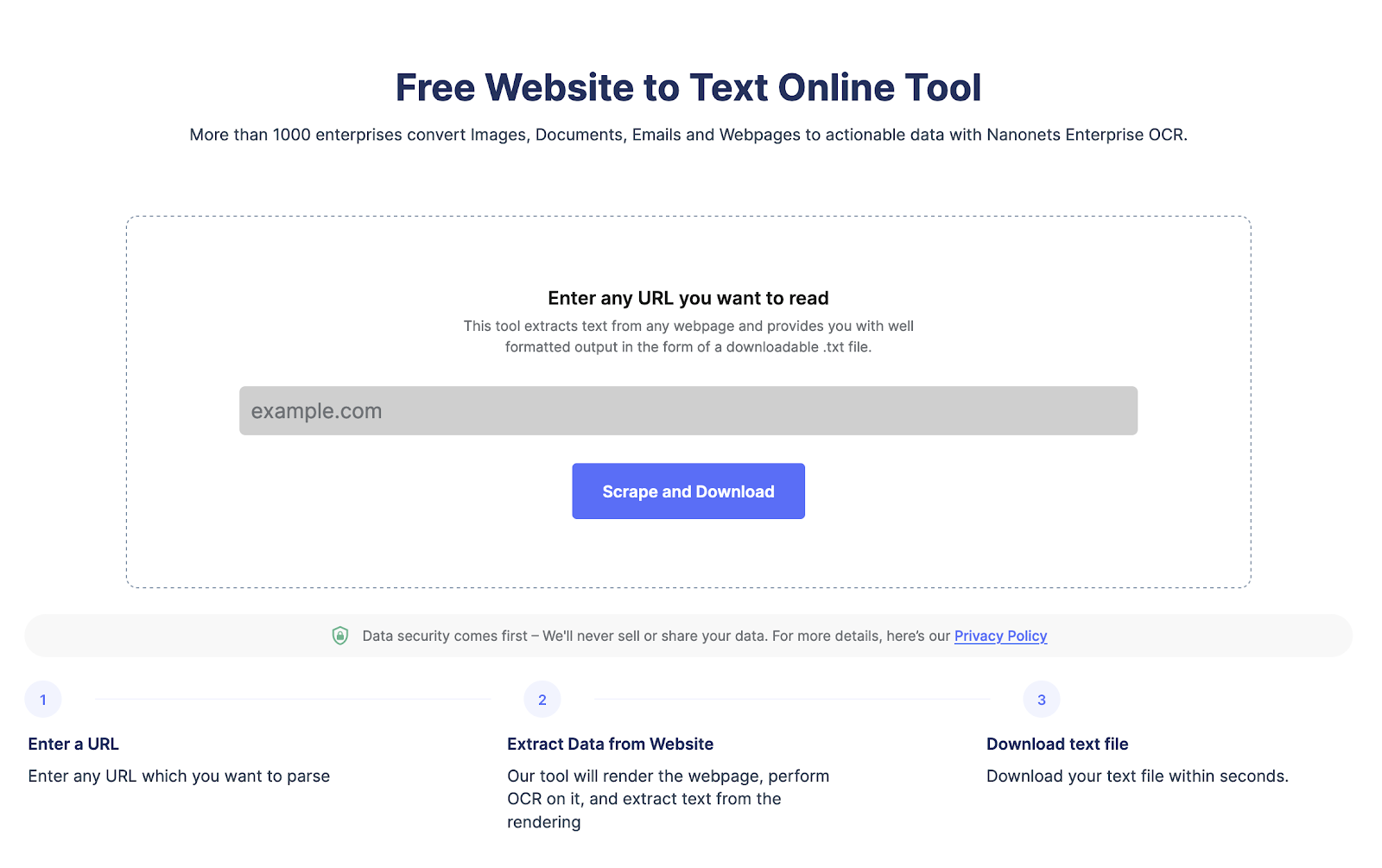

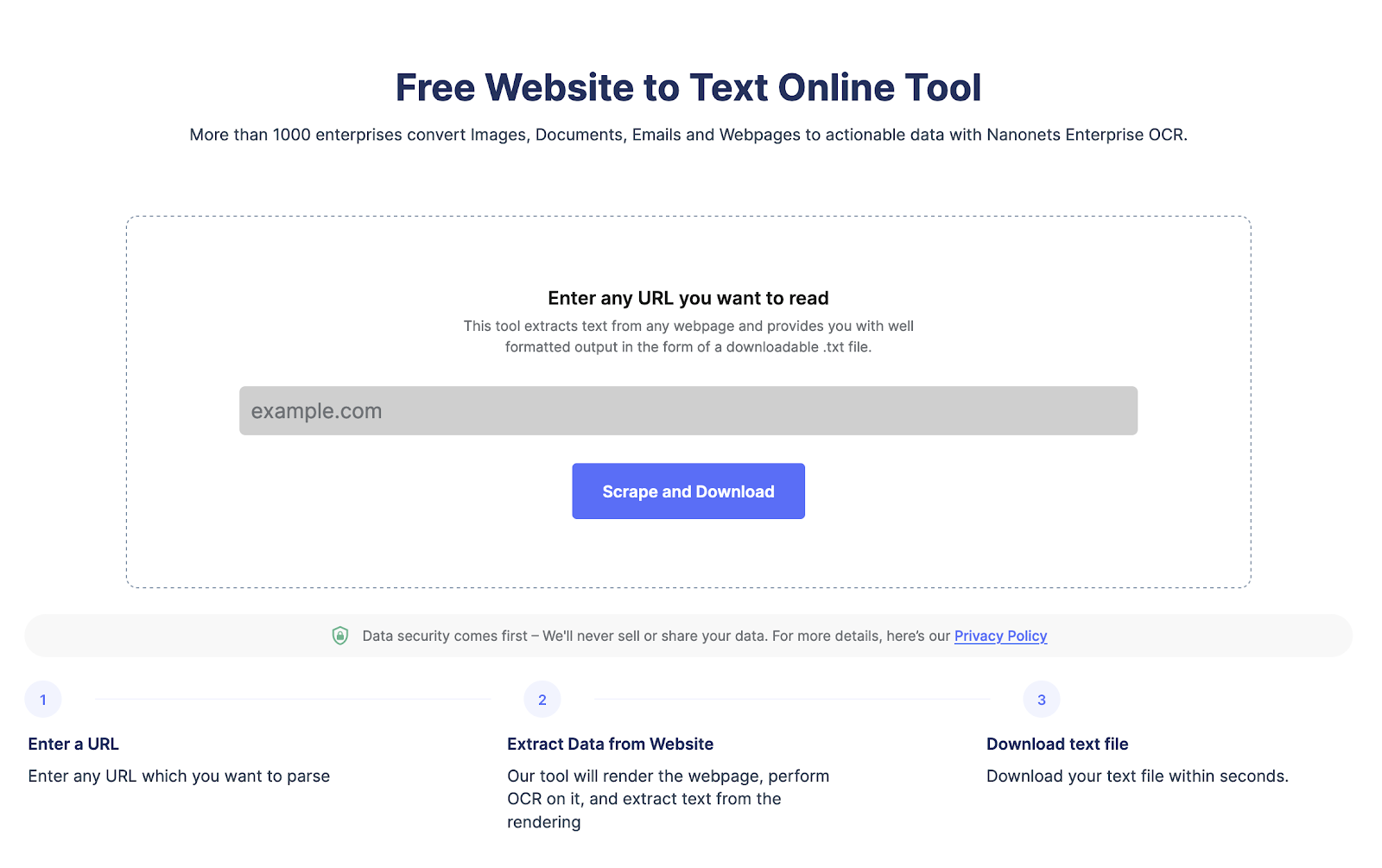

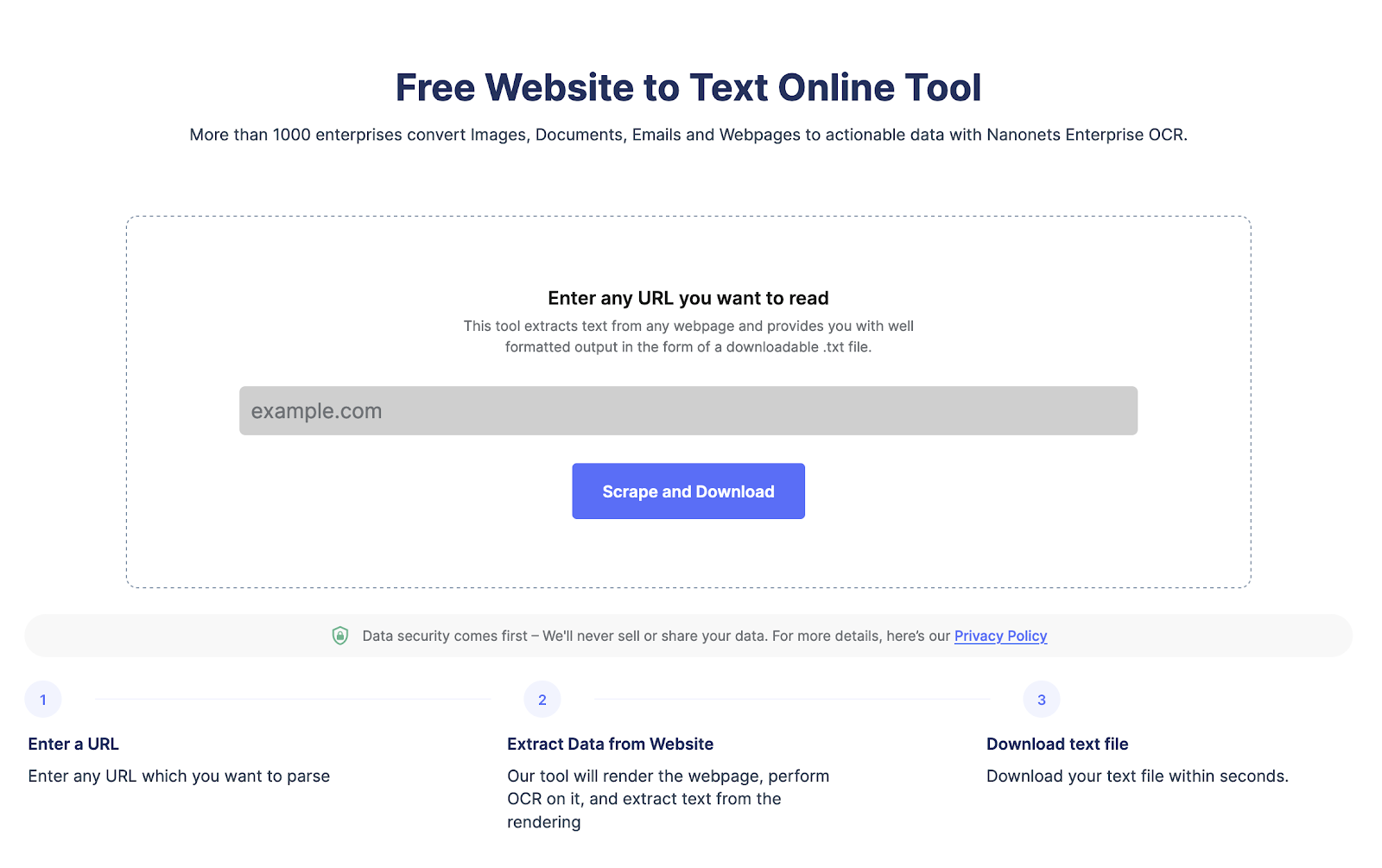

Vous cherchez à extraire des données d'une page Web ?

Rendez-vous sur Nanonets grattoir de site Web, Ajoutez l'URL et cliquez sur "Scrape" et téléchargez instantanément le texte de la page Web sous forme de fichier. Essayez-le gratuitement maintenant.

Qu'est-ce que le web scraping et ses avantages ?

Le grattage Web est utilisé pour extraire automatiquement les données des pages Web à grande échelle. Le scraping Web est effectué pour convertir des données dans des structures HTML complexes en un format structuré tel qu'une feuille de calcul ou une base de données, et utilisé à diverses fins telles que la recherche, l'analyse et l'automatisation.

Voici quelques-unes des raisons pour lesquelles les gens utilisent le web scraping :

- Extrayez efficacement les données de la page Web pour une analyse avancée.

- Gardez un œil sur les développements des sites Web des concurrents et gardez un œil sur les changements dans leurs offres de produits, leurs tactiques ou leurs prix.

- Récupérez des prospects ou des données d'e-mail de LinkedIn ou d'un autre répertoire.

- Automatisez des tâches telles que la saisie de données, le remplissage de formulaires et d'autres tâches répétitives, ce qui vous fait gagner du temps et améliore votre efficacité.

Pourquoi devriez-vous utiliser Node.js pour le scraping Web ?

Node.js est largement utilisé car il s'agit d'une plate-forme légère, performante et efficace. Voici quelques raisons pour lesquelles node.js est un excellent choix pour le scraping Web :

- Node.js peut gérer plusieurs demandes de scraping Web en parallèle.

- Il a une grande communauté qui fournit un support et crée des bibliothèques de grattage Web significatives.

- Node.js est multiplateforme, ce qui en fait un choix polyvalent pour les projets de scraping Web

- Node.js est facile à apprendre, surtout si vous connaissez déjà JavaScript

- Node.js a une prise en charge intégrée des requêtes HTTP, ce qui facilite la récupération et l'analyse des pages HTML à partir de sites Web.

- Node.js est hautement évolutif, ce qui est important pour le web scraping lors du traitement d'un grand volume de données

Vous cherchez à extraire des données d'une page Web ?

Rendez-vous sur Nanonets grattoir de site Web, Ajoutez l'URL et cliquez sur "Scrape" et téléchargez instantanément le texte de la page Web sous forme de fichier. Essayez-le gratuitement maintenant.

Comment scraper des pages web avec Node JS ?

Étape 1 Configuration de votre environnement :

Vous devez installer node.js si vous ne l'avez pas déjà fait. Vous pouvez le télécharger en utilisant le site officiel.

Étape 2 Installation des packages nécessaires pour le scraping Web avec Node.js :

Node.js a plusieurs options pour le scraping Web comme Cheerio, Puppeteer et request. Vous pouvez les installer facilement en utilisant la commande suivante.

npm install cheerio

npm install puppeteer

npm install requestÉtape 3 Configuration de votre répertoire de projet :

Vous devez créer un nouveau répertoire pour le nouveau projet. Et puis accédez à l'invite de commande pour créer un nouveau fichier pour stocker votre code de grattage Web NodeJS.

Vous pouvez créer un nouveau répertoire et un nouveau fichier à l'aide de la commande suivante :

mkdir my-web-scraper

cd my-web-scraper

touch scraper.jsÉtape 4 Faire des requêtes HTTP avec Node.js :

Pour scraper des pages Web, vous devez faire des requêtes HTTP. Maintenant, Node.js a un module http intégré. Cela facilite les demandes. Vous pouvez également utiliser des axios ou des demandes pour faire une demande.

Voici le code pour faire des requêtes http avec node.js

const http = require('http');

const url = 'https://example.com';

http.get(url, (res) => {

let data = '';

res.on('data', (chunk) => {

data += chunk;

});

res.on('end', () => {

console.log(data);

});

});Remplacez http.//example.com par l'url de votre choix pour scraper les pages web,

Étape 5 Scraper HTML avec Node.js :

Une fois que vous avez le contenu HTML d'une page Web, vous devez l'analyser pour extraire les données dont vous avez besoin. Plusieurs bibliothèques tierces sont disponibles pour l'analyse HTML dans Node.js, telles que Cheerio et JSDOM.

Voici un exemple d'extrait de code utilisant Cheerio pour analyser le HTML et extraire les données :

const cheerio = require('cheerio');

const request = require('request');

const url = 'https://example.com';

request(url, (error, response, html) => {

if (!error && response.statusCode == 200) {

const $ = cheerio.load(html);

const title = $('title').text();

const firstParagraph = $('p').first().text();

console.log(title);

console.log(firstParagraph);

}

});Ce code utilise la bibliothèque de requêtes pour récupérer le contenu HTML de la page Web à l'URL, puis utilise Cheerio pour analyser le code HTML et extraire le titre et le premier paragraphe.

Comment gérer le javascript et le contenu dynamique avec Node.js ?

De nombreuses pages Web modernes utilisent JavaScript pour rendre le contenu dynamique, ce qui rend difficile leur extraction. Pour gérer le rendu JavaScript, vous pouvez utiliser des navigateurs sans tête comme Puppeteer et Playwright, qui vous permettent de simuler un environnement de navigateur et de récupérer du contenu dynamique.

Voici un exemple d'extrait de code utilisant Puppeteer pour récupérer une page Web qui affiche du contenu avec JavaScript :

const puppeteer = require('puppeteer');

(async () => {

const browser = await puppeteer.launch();

const page = await browser.newPage();

await page.goto('https://example.com');

const title = await page.$eval('title', el => el.textContent);

const firstParagraph = await page.$eval('p', el => el.textContent);

console.log(title);

console.log(firstParagraph);

await browser.close();

})();Ce code utilise Puppeteer pour lancer un navigateur sans tête, accéder à la page Web à l'url et extraire le titre et le premier paragraphe. La méthode page.$eval() sélectionne et extrait les données des éléments HTML.

Voici quelques bibliothèques que vous pouvez utiliser pour scraper facilement des pages Web à l'aide de NodeJS :

Cheerio : est une implémentation rapide, flexible et légère du noyau jQuery conçu pour le côté serveur.

JSDOM : est une implémentation en pur JavaScript du DOM pour Node.js. Il fournit un moyen de créer un environnement DOM dans Node.js et de le manipuler avec une API standard.

Marionnettiste: est une bibliothèque Node.js qui fournit une API de haut niveau pour contrôler Chrome ou Chromium sans tête. Il peut être utilisé pour le grattage Web, les tests automatisés, l'exploration et le rendu.

Meilleures pratiques pour le scraping Web avec Node.js

Voici quelques bonnes pratiques à suivre lors de l'utilisation de Node.js pour le web scraping :

- Avant de gratter un site Web, lisez ses conditions d'utilisation. Assurez-vous que la page Web n'a pas de restrictions sur le grattage Web ou la fréquence de grattage des pages Web.

- Limitez le nombre de requêtes HTTP pour éviter de surcharger le site Web en contrôlant la fréquence des requêtes.

- Définissez des en-têtes appropriés dans vos requêtes HTTP pour imiter le comportement d'un utilisateur normal.

- Mettez en cache les pages Web et les données extraites pour réduire la charge sur le site Web.

- Le scraping Web peut être sujet aux erreurs en raison de la complexité et de la variabilité des sites Web.

- Surveillez et ajustez votre activité de scraping et ajustez votre limitation de débit, vos en-têtes et d'autres paramètres selon vos besoins.

Vous cherchez à extraire des données d'une page Web ?

Rendez-vous sur Nanonets grattoir de site Web, Ajoutez l'URL et cliquez sur "Scrape" et téléchargez instantanément le texte de la page Web sous forme de fichier. Essayez-le gratuitement maintenant.

- Contenu propulsé par le référencement et distribution de relations publiques. Soyez amplifié aujourd'hui.

- Platoblockchain. Intelligence métaverse Web3. Connaissance Amplifiée. Accéder ici.

- La source: https://nanonets.com/blog/web-scraping-with-node-js/