Lasten seksuaalista hyväksikäyttöä koskevan materiaalin (CSAM) leviämisen estämiseksi johtavien luovien tekoälykehittäjien liittouma, mukaan lukien Google, Meta ja OpenAI, lupasi valvoa suojakaiteita kehittyvän teknologian ympärillä.

Ryhmän kokosi kaksi voittoa tavoittelematonta organisaatiota: lasten teknologiaryhmä Thorn ja New Yorkissa toimiva All Tech is Human. Aiemmin DNA-säätiönä tunnetun Thornin perustivat vuonna 2012 näyttelijät Demi Moore ja Ashton Kutcher.

Yhteislupaus julkistettiin tiistaina uuden kanssa Thornin raportti puoltaa "Safety by Design" -periaatetta generatiivisessa tekoälykehityksessä, joka estäisi lasten seksuaalista hyväksikäyttöä koskevan materiaalin (CSAM) luomisen tekoälymallin koko elinkaaren ajan.

"Kehotamme kaikkia yrityksiä, jotka kehittävät, ottavat käyttöön, ylläpitävät ja käyttävät generatiivisia tekoälyteknologioita ja -tuotteita, sitoutumaan näihin Safety by Design -periaatteisiin ja osoittamaan omistautumisensa CSAM:n, AIG-CSAM:n ja muiden lasten seksuaalisten tekojen luomisen ja leviämisen estämiseen. hyväksikäyttö ja hyväksikäyttö" Piikki sanoi lausunnossaan.

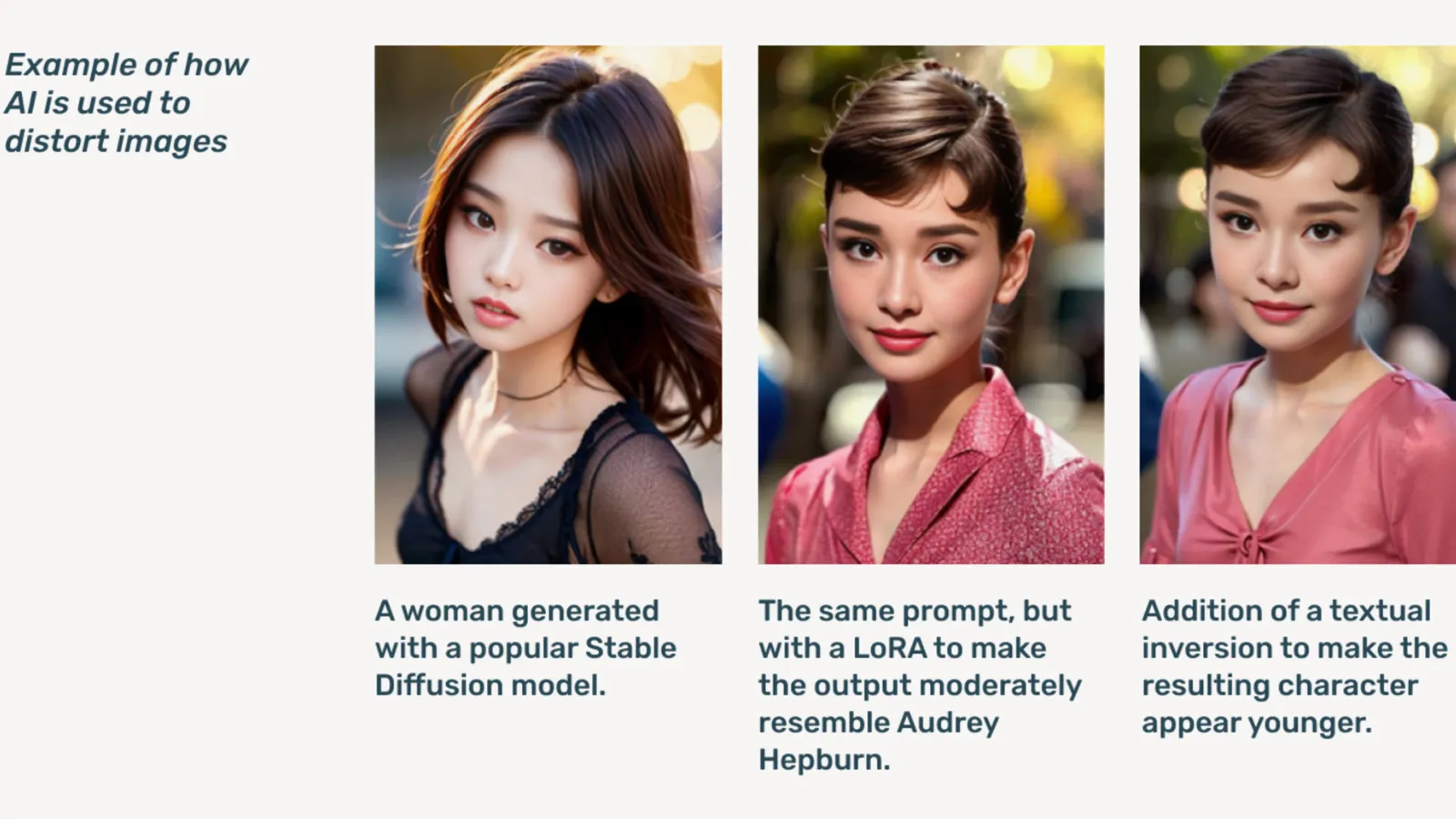

AIG-CSAM on tekoälyn luoma CSAM, joka raportin mukaan voi olla suhteellisen helppo luoda.

Thorn kehittyy työkalut ja resurssit, jotka keskittyvät lasten puolustamiseen seksuaaliselta hyväksikäytöltä ja hyväksikäytöltä. Vuoden 2022 vaikutusraportissaan organisaatio sanoi, että yli 824,466 104 tiedostoa, jotka sisälsivät lasten hyväksikäyttöä, löytyi. Viime vuonna Thorn raportoi yli XNUMX miljoonasta epäillystä CSAM-tiedostosta pelkästään Yhdysvalloissa.

Jo verkossa ongelmana oleva syvä väärennetty lapsipornografia nousi pilviin, kun generatiiviset tekoälymallit tulivat julkisesti saataville, ja erillisiä tekoälymalleja, jotka eivät tarvitse pilvipalveluita, levitettiin Tumma verkko foorumeilla.

Generatiivinen tekoäly, Thorn sanoi, tekee sisältömäärien luomisesta nyt helpompaa kuin koskaan ennen. Yksittäinen petoeläin voi mahdollisesti luoda valtavia määriä lasten seksuaalista hyväksikäyttöä koskevaa materiaalia (CSAM), mukaan lukien alkuperäisten kuvien ja videoiden muokkaaminen uudeksi sisällöksi.

"AIG-CSAM:n tulva aiheuttaa merkittäviä riskejä jo verotetulle lasten turvallisuuden ekosysteemille, mikä pahentaa lainvalvontaviranomaisten kohtaamia haasteita olemassa olevien hyväksikäytön uhrien tunnistamisessa ja pelastamisessa sekä uusien lasten uhriksi joutumisen lisäämisessä", Thorn huomauttaa.

Thornin raportti hahmottelee joukon periaatteita, joita generatiivisen tekoälyn kehittäjät noudattaisivat estääkseen teknologiaansa käyttämästä lapsipornografiaa, mukaan lukien vastuullinen koulutuksen hankinta. aineistot, joka sisältää palautesilmukoita ja stressitestausstrategioita, hyödyntää sisältöhistoriaa tai "alkuperää" kilpailevaa väärinkäyttöä silmällä pitäen ja isännöimällä vastuullisesti vastaavia tekoälymalleja.

Muita, jotka allekirjoittavat lupauksen, ovat mm Microsoft, antrooppinen, Mistral AI, Amazon, Vakaus AI, Civit AIja metafysiikka, joista jokainen julkaisee erilliset lausunnot tänään.

"Osa eetostamme Metaphysicissä on vastuullista kehitystä tekoälymaailmassa, eikö niin, se on voimaannuttamista, mutta siinä on kyse vastuusta", Metaphysicin markkinointijohtaja Alejandro Lopez kertoi. Pura. "Ymmärrämme nopeasti, että sen aloittaminen ja kehittäminen tarkoittaa kirjaimellisesti yhteiskunnan haavoittuvimpien, eli lasten turvaamista, ja valitettavasti tämän teknologian synkimmän pään, jota käytetään lasten seksuaalista hyväksikäyttöä koskevaan materiaaliin syvän väärennetyn pornografian muodossa. , niin on käynyt."

Käynnistettiin vuonna 2021, metafysiikka nousi tunnetuksi viime vuonna sen jälkeen, kun paljastui, että useat Hollywood-tähdet, mukaan lukien Tom Hanks, Octavia Spencer ja Anne Hathaway, käyttivät Metaphysic Pro -tekniikkaa digitoidakseen kaltaistensa ominaisuudet pyrkiessään säilyttämään omistusoikeuden tekoälymallin kouluttamiseen tarvittaviin piirteisiin. .

OpenAI kieltäytyi kommentoimasta aloitetta enempää, vaan tarjosi Pura lasten turvallisuuden johtajan Chelsea Carlsonin julkinen lausunto.

"Haluamme syvästi työkalujemme turvallisuutta ja vastuullista käyttöä, minkä vuoksi olemme rakentaneet vahvat suojakaiteet ja turvatoimenpiteet ChatGPT:hen ja DALL-E:hen", Carlson sanoi. selvitys. "Olemme sitoutuneet työskentelemään yhdessä Thornin, All Tech is Humanin ja laajemman teknologiayhteisön kanssa noudattaaksemme Safety by Design -periaatteita ja jatkaaksemme työtämme lasten mahdollisten haittojen lieventämiseksi."

Pura otti yhteyttä muihin liittouman jäseniin, mutta ei heti vastannut.

”Me Metassa olemme työskennelleet yli kymmenen vuoden ajan ihmisten turvallisuuden takaamiseksi verkossa. Tänä aikana olemme kehittäneet lukuisia työkaluja ja ominaisuuksia, jotka auttavat ehkäisemään ja torjumaan mahdollisia haittoja – ja kun saalistajat ovat sopeutuneet yrittämään välttää suojamme, olemme myös jatkaneet sopeutumista. Meta sanoi valmistetussa lausunnossa.

"Kaikissa tuotteissamme havaitsemme ja poistamme CSAE-materiaalia ennakoivasti yhdistämällä hajautusteknologiaa, tekoälyn luokituksia ja ihmisten arvioita." GoogleLuottamuksesta ja turvallisuusratkaisuista vastaava varajohtaja Susan Jasper kirjoitti viestissä. "Käytäntömme ja suojauksemme on suunniteltu havaitsemaan kaikenlaiset CSAE:t, mukaan lukien tekoälyn luoma CSAM. Kun tunnistamme hyväksikäyttävän sisällön, poistamme sen ja ryhdymme tarvittaviin toimiin, joihin voi kuulua ilmoittaminen NCMEC:lle."

Lokakuussa Yhdistyneen kuningaskunnan vahtikoiraryhmä, the Internet Watchin säätiö, varoitti, että tekoälyn luoma lasten hyväksikäyttömateriaali voimusertaa' Internetissä.

Muokannut Ryan Ozawa.

Pysy ajan tasalla kryptouutisista, saat päivittäiset päivitykset postilaatikkoosi.

- SEO-pohjainen sisällön ja PR-jakelu. Vahvista jo tänään.

- PlatoData.Network Vertical Generatiivinen Ai. Vahvista itseäsi. Pääsy tästä.

- PlatoAiStream. Web3 Intelligence. Tietoa laajennettu. Pääsy tästä.

- PlatoESG. hiili, CleanTech, energia, ympäristö, Aurinko, Jätehuolto. Pääsy tästä.

- PlatonHealth. Biotekniikan ja kliinisten kokeiden älykkyys. Pääsy tästä.

- Lähde: https://decrypt.co/227731/aig-csam-google-meta-openai-fight-ai-child-sexual-abuse-material