Οι βοηθοί συνομιλίας τεχνητής νοημοσύνης (AI) έχουν σχεδιαστεί για να παρέχουν ακριβείς απαντήσεις σε πραγματικό χρόνο μέσω της έξυπνης δρομολόγησης των ερωτημάτων στις πιο κατάλληλες λειτουργίες AI. Με υπηρεσίες τεχνητής νοημοσύνης που δημιουργούνται από AWS όπως Θεμέλιο του Αμαζονίου, οι προγραμματιστές μπορούν να δημιουργήσουν συστήματα που διαχειρίζονται με εξειδίκευση και ανταποκρίνονται στα αιτήματα των χρηστών. Το Amazon Bedrock είναι μια πλήρως διαχειριζόμενη υπηρεσία που προσφέρει μια επιλογή από μοντέλα θεμελίωσης υψηλής απόδοσης (FM) από κορυφαίες εταιρείες τεχνητής νοημοσύνης όπως AI21 Labs, Anthropic, Cohere, Meta, Stability AI και Amazon χρησιμοποιώντας ένα μόνο API, μαζί με ένα ευρύ σύνολο δυνατότητες που χρειάζεστε για να δημιουργήσετε παραγωγικές εφαρμογές τεχνητής νοημοσύνης με ασφάλεια, απόρρητο και υπεύθυνη τεχνητή νοημοσύνη.

Αυτή η ανάρτηση αξιολογεί δύο βασικές προσεγγίσεις για την ανάπτυξη βοηθών τεχνητής νοημοσύνης: τη χρήση διαχειριζόμενων υπηρεσιών όπως π.χ Πράκτορες για το Amazon Bedrock, και χρησιμοποιώντας τεχνολογίες ανοιχτού κώδικα όπως LangChain. Εξερευνούμε τα πλεονεκτήματα και τις προκλήσεις του καθενός, ώστε να μπορείτε να επιλέξετε την καταλληλότερη διαδρομή για τις ανάγκες σας.

Τι είναι ο βοηθός AI;

Ο βοηθός AI είναι ένα έξυπνο σύστημα που κατανοεί ερωτήματα φυσικής γλώσσας και αλληλεπιδρά με διάφορα εργαλεία, πηγές δεδομένων και API για την εκτέλεση εργασιών ή την ανάκτηση πληροφοριών για λογαριασμό του χρήστη. Οι αποτελεσματικοί βοηθοί τεχνητής νοημοσύνης διαθέτουν τις ακόλουθες βασικές δυνατότητες:

- Επεξεργασία φυσικής γλώσσας (NLP) και ροή συνομιλίας

- Ενσωμάτωση γνωσιακής βάσης και σημασιολογικές αναζητήσεις για την κατανόηση και ανάκτηση σχετικών πληροφοριών με βάση τις αποχρώσεις του πλαισίου συνομιλίας

- Εκτέλεση εργασιών, όπως ερωτήματα βάσης δεδομένων και προσαρμοσμένες AWS Lambda λειτουργίες

- Χειρισμός εξειδικευμένων συνομιλιών και αιτημάτων χρηστών

Δείχνουμε τα οφέλη των βοηθών τεχνητής νοημοσύνης χρησιμοποιώντας τη διαχείριση συσκευών Internet of Things (IoT) ως παράδειγμα. Σε αυτήν την περίπτωση χρήσης, η τεχνητή νοημοσύνη μπορεί να βοηθήσει τους τεχνικούς να διαχειρίζονται αποτελεσματικά τα μηχανήματα με εντολές που ανακτούν δεδομένα ή αυτοματοποιούν εργασίες, απλοποιώντας τις λειτουργίες στην κατασκευή.

Agents for Amazon Bedrock προσέγγιση

Πράκτορες για το Amazon Bedrock σας επιτρέπει να δημιουργείτε εφαρμογές τεχνητής νοημοσύνης που δημιουργούνται, οι οποίες μπορούν να εκτελούν εργασίες πολλαπλών βημάτων στα συστήματα και τις πηγές δεδομένων μιας εταιρείας. Προσφέρει τις ακόλουθες βασικές δυνατότητες:

- Αυτόματη δημιουργία προτροπής από οδηγίες, λεπτομέρειες API και πληροφορίες πηγής δεδομένων, εξοικονομώντας εβδομάδες άμεσης προσπάθειας μηχανικής

- Ανάκτηση Augmented Generation (RAG) για ασφαλή σύνδεση πρακτόρων με πηγές δεδομένων μιας εταιρείας και παροχή σχετικών απαντήσεων

- Ενορχήστρωση και εκτέλεση εργασιών πολλαπλών βημάτων αναλύοντας τα αιτήματα σε λογικές ακολουθίες και καλώντας τα απαραίτητα API

- Ορατότητα του συλλογισμού του πράκτορα μέσω ενός ίχνους αλυσίδας σκέψης (CoT), επιτρέποντας την αντιμετώπιση προβλημάτων και την καθοδήγηση της συμπεριφοράς του μοντέλου

- Προτάσεις μηχανικής για την τροποποίηση του προτύπου προτροπής που δημιουργείται αυτόματα για βελτιωμένο έλεγχο των πρακτόρων

Μπορείτε να χρησιμοποιήσετε το Agents για το Amazon Bedrock και Βάσεις γνώσεων για το Amazon Bedrock να δημιουργήσει και να αναπτύξει βοηθούς AI για περίπλοκες περιπτώσεις χρήσης δρομολόγησης. Παρέχουν στρατηγικό πλεονέκτημα για προγραμματιστές και οργανισμούς απλοποιώντας τη διαχείριση της υποδομής, ενισχύοντας την επεκτασιμότητα, βελτιώνοντας την ασφάλεια και μειώνοντας την αδιαφοροποίητη ανύψωση βαρέων βαρών. Επιτρέπουν επίσης απλούστερο κώδικα επιπέδου εφαρμογής επειδή η λογική δρομολόγησης, η διανυσματοποίηση και η μνήμη διαχειρίζονται πλήρως.

Επισκόπηση λύσεων

Αυτή η λύση εισάγει έναν βοηθό συνομιλίας AI προσαρμοσμένο για τη διαχείριση και τις λειτουργίες συσκευών IoT κατά τη χρήση του Claude v2.1 της Anthropic στο Amazon Bedrock. Η βασική λειτουργικότητα του βοηθού AI διέπεται από ένα ολοκληρωμένο σύνολο οδηγιών, γνωστών ως α προτροπή συστήματος, το οποίο οριοθετεί τις δυνατότητές του και τους τομείς εξειδίκευσής του. Αυτή η καθοδήγηση διασφαλίζει ότι ο βοηθός AI μπορεί να χειριστεί ένα ευρύ φάσμα εργασιών, από τη διαχείριση πληροφοριών συσκευής έως την εκτέλεση λειτουργικών εντολών.

Εξοπλισμένος με αυτές τις δυνατότητες, όπως περιγράφεται λεπτομερώς στην προτροπή του συστήματος, ο βοηθός τεχνητής νοημοσύνης ακολουθεί μια δομημένη ροή εργασιών για την αντιμετώπιση των ερωτήσεων των χρηστών. Το παρακάτω σχήμα παρέχει μια οπτική αναπαράσταση αυτής της ροής εργασίας, απεικονίζοντας κάθε βήμα από την αρχική αλληλεπίδραση του χρήστη έως την τελική απόκριση.

Η ροή εργασίας αποτελείται από τα ακόλουθα βήματα:

- Η διαδικασία ξεκινά όταν ένας χρήστης ζητά από τον βοηθό να εκτελέσει μια εργασία. για παράδειγμα, ζητώντας τα μέγιστα σημεία δεδομένων για μια συγκεκριμένη συσκευή IoT

device_xxx. Αυτή η εισαγωγή κειμένου καταγράφεται και αποστέλλεται στον βοηθό τεχνητής νοημοσύνης. - Ο βοηθός AI ερμηνεύει την εισαγωγή κειμένου του χρήστη. Χρησιμοποιεί το παρεχόμενο ιστορικό συνομιλιών, ομάδες ενεργειών και βάσεις γνώσεων για να κατανοήσει το πλαίσιο και να καθορίσει τις απαραίτητες εργασίες.

- Αφού αναλυθεί και κατανοηθεί η πρόθεση του χρήστη, ο βοηθός τεχνητής νοημοσύνης ορίζει εργασίες. Αυτό βασίζεται στις οδηγίες που ερμηνεύονται από τον βοηθό σύμφωνα με την προτροπή του συστήματος και τα στοιχεία του χρήστη.

- Στη συνέχεια, οι εργασίες εκτελούνται μέσω μιας σειράς κλήσεων API. Αυτό γίνεται χρησιμοποιώντας Αντιδρώ προτροπή, η οποία αναλύει την εργασία σε μια σειρά βημάτων που επεξεργάζονται διαδοχικά:

- Για ελέγχους μετρήσεων συσκευής, χρησιμοποιούμε το

check-device-metricsομάδα δράσης, η οποία περιλαμβάνει μια κλήση API στις συναρτήσεις Lambda που στη συνέχεια κάνουν ερώτημα Αμαζόν Αθηνά για τα ζητούμενα δεδομένα. - Για άμεσες ενέργειες συσκευής όπως εκκίνηση, διακοπή ή επανεκκίνηση, χρησιμοποιούμε το

action-on-deviceομάδα δράσης, η οποία καλεί μια συνάρτηση Λάμδα. Αυτή η λειτουργία ξεκινά μια διαδικασία που στέλνει εντολές στη συσκευή IoT. Για αυτήν την ανάρτηση, η συνάρτηση Lambda στέλνει ειδοποιήσεις χρησιμοποιώντας Απλή υπηρεσία email της Amazon (Amazon SES). - Χρησιμοποιούμε Γνωσιακές Βάσεις για το Amazon Bedrock για να ανακτήσουμε από ιστορικά δεδομένα που είναι αποθηκευμένα ως ενσωματώσεις στο Amazon OpenSearch Service διανυσματική βάση δεδομένων.

- Για ελέγχους μετρήσεων συσκευής, χρησιμοποιούμε το

- Μετά την ολοκλήρωση των εργασιών, η τελική απάντηση δημιουργείται από το Amazon Bedrock FM και μεταφέρεται πίσω στον χρήστη.

- Το Agents for Amazon Bedrock αποθηκεύει αυτόματα πληροφορίες χρησιμοποιώντας μια κατάσταση συνεδρίας για να διατηρήσει την ίδια συνομιλία. Η κατάσταση διαγράφεται αφού παρέλθει ένα ρυθμιζόμενο χρονικό όριο αδράνειας.

Τεχνική επισκόπηση

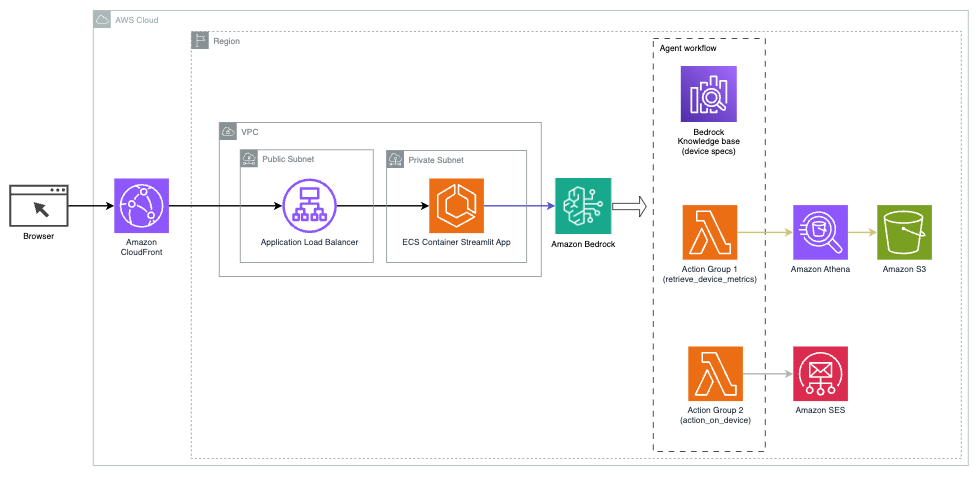

Το παρακάτω διάγραμμα απεικονίζει την αρχιτεκτονική για την ανάπτυξη ενός βοηθού AI με τους Agents για το Amazon Bedrock.

Αποτελείται από τα ακόλουθα βασικά στοιχεία:

- Διασύνδεση συνομιλίας – Η διεπαφή συνομιλίας χρησιμοποιεί το Streamlit, μια βιβλιοθήκη Python ανοιχτού κώδικα που απλοποιεί τη δημιουργία προσαρμοσμένων, οπτικά ελκυστικών εφαρμογών ιστού για μηχανική μάθηση (ML) και επιστήμη δεδομένων. Φιλοξενείται στις Υπηρεσία ελαστικών εμπορευματοκιβωτίων Amazon (Amazon ECS) με AWS Fargate, και η πρόσβαση σε αυτό γίνεται χρησιμοποιώντας ένα Application Load Balancer. Μπορείτε να χρησιμοποιήσετε το Fargate με το Amazon ECS για εκτέλεση δοχεία χωρίς να χρειάζεται να διαχειρίζεστε διακομιστές, συμπλέγματα ή εικονικές μηχανές.

- Πράκτορες για το Amazon Bedrock – Το Agents for Amazon Bedrock ολοκληρώνει τα ερωτήματα των χρηστών μέσω μιας σειράς συλλογιστικών βημάτων και αντίστοιχων ενεργειών που βασίζονται σε Προτροπή ReAct:

- Βάσεις γνώσεων για το Amazon Bedrock – Το Knowledge Bases for Amazon Bedrock παρέχει πλήρως διαχειριζόμενη ΚΟΥΡΕΛΙ για να παρέχει στον βοηθό AI πρόσβαση στα δεδομένα σας. Στην περίπτωση χρήσης μας, ανεβάσαμε τις προδιαγραφές της συσκευής σε ένα Απλή υπηρεσία αποθήκευσης Amazon (Amazon S3) κάδος. Χρησιμεύει ως πηγή δεδομένων στη βάση γνώσεων.

- Ομάδες δράσης – Αυτά είναι καθορισμένα σχήματα API που καλούν συγκεκριμένες λειτουργίες Lambda για αλληλεπίδραση με συσκευές IoT και άλλες υπηρεσίες AWS.

- Anthropic Claude v2.1 στο Amazon Bedrock – Αυτό το μοντέλο ερμηνεύει τα ερωτήματα των χρηστών και ενορχηστρώνει τη ροή των εργασιών.

- Amazon Titan Embeddings – Αυτό το μοντέλο χρησιμεύει ως μοντέλο ενσωμάτωσης κειμένου, μετατρέποντας το κείμενο της φυσικής γλώσσας—από μεμονωμένες λέξεις σε σύνθετα έγγραφα—σε αριθμητικά διανύσματα. Αυτό επιτρέπει δυνατότητες διανυσματικής αναζήτησης, επιτρέποντας στο σύστημα να αντιστοιχίζει σημασιολογικά ερωτήματα χρήστη με τις πιο σχετικές καταχωρήσεις βάσης γνώσεων για αποτελεσματική αναζήτηση.

Η λύση είναι ενσωματωμένη με υπηρεσίες AWS όπως το Lambda για την εκτέλεση κώδικα σε απόκριση σε κλήσεις API, το Athena για τα σύνολα δεδομένων ερωτημάτων, την υπηρεσία OpenSearch για αναζήτηση μέσω βάσεων γνώσης και το Amazon S3 για αποθήκευση. Αυτές οι υπηρεσίες συνεργάζονται για να παρέχουν μια απρόσκοπτη εμπειρία για τη διαχείριση λειτουργιών συσκευών IoT μέσω εντολών φυσικής γλώσσας.

Oφέλη

Αυτή η λύση προσφέρει τα ακόλουθα οφέλη:

- Πολυπλοκότητα υλοποίησης:

- Απαιτούνται λιγότερες γραμμές κώδικα, επειδή το Agents for Amazon Bedrock αφαιρεί μεγάλο μέρος της υποκείμενης πολυπλοκότητας, μειώνοντας την προσπάθεια ανάπτυξης

- Η διαχείριση διανυσματικών βάσεων δεδομένων όπως η Υπηρεσία OpenSearch είναι απλοποιημένη, επειδή οι Βάσεις Γνώσης για το Amazon Bedrock χειρίζονται τη διανυσματική και αποθήκευση

- Η ενσωμάτωση με διάφορες υπηρεσίες AWS είναι πιο βελτιωμένη μέσω προκαθορισμένων ομάδων δράσης

- Εμπειρία προγραμματιστή:

- Η κονσόλα Amazon Bedrock παρέχει μια φιλική προς το χρήστη διεπαφή για άμεση ανάπτυξη, δοκιμή και ανάλυση βασικών αιτιών (RCA), βελτιώνοντας τη συνολική εμπειρία προγραμματιστή

- Ευελιξία και ευελιξία:

- Το Agents for Amazon Bedrock επιτρέπει απρόσκοπτες αναβαθμίσεις σε νεότερα FM (όπως το Claude 3.0) όταν αυτά γίνουν διαθέσιμα, ώστε η λύση σας να παραμένει ενημερωμένη με τις πιο πρόσφατες εξελίξεις

- Οι ποσοστώσεις και οι περιορισμοί υπηρεσιών διαχειρίζονται από το AWS, μειώνοντας τα γενικά έξοδα της υποδομής παρακολούθησης και κλιμάκωσης

- Ασφάλεια:

- Το Amazon Bedrock είναι μια πλήρως διαχειριζόμενη υπηρεσία, που τηρεί τα αυστηρά πρότυπα ασφάλειας και συμμόρφωσης της AWS, απλοποιώντας ενδεχομένως τις οργανωτικές αξιολογήσεις ασφάλειας

Αν και το Agents for Amazon Bedrock προσφέρει μια βελτιωμένη και διαχειριζόμενη λύση για τη δημιουργία εφαρμογών τεχνητής νοημοσύνης συνομιλίας, ορισμένοι οργανισμοί μπορεί να προτιμούν μια προσέγγιση ανοιχτού κώδικα. Σε τέτοιες περιπτώσεις, μπορείτε να χρησιμοποιήσετε πλαίσια όπως το LangChain, τα οποία θα συζητήσουμε στην επόμενη ενότητα.

Δυναμική προσέγγιση δρομολόγησης LangChain

Το LangChain είναι ένα πλαίσιο ανοιχτού κώδικα που απλοποιεί τη δημιουργία τεχνητής νοημοσύνης συνομιλίας επιτρέποντας την ενσωμάτωση μεγάλων μοντέλων γλώσσας (LLM) και δυνατοτήτων δυναμικής δρομολόγησης. Με τη γλώσσα έκφρασης LangChain (LCEL), οι προγραμματιστές μπορούν να ορίσουν το δρομολόγηση, το οποίο σας επιτρέπει να δημιουργήσετε μη ντετερμινιστικές αλυσίδες όπου η έξοδος ενός προηγούμενου βήματος καθορίζει το επόμενο βήμα. Η δρομολόγηση βοηθά στην παροχή δομής και συνέπειας στις αλληλεπιδράσεις με τα LLM.

Για αυτήν την ανάρτηση, χρησιμοποιούμε το ίδιο παράδειγμα με τον βοηθό AI για τη διαχείριση συσκευών IoT. Ωστόσο, η κύρια διαφορά είναι ότι πρέπει να χειριζόμαστε τις προτροπές του συστήματος ξεχωριστά και να αντιμετωπίζουμε κάθε αλυσίδα ως ξεχωριστή οντότητα. Η αλυσίδα δρομολόγησης αποφασίζει την αλυσίδα προορισμού με βάση την είσοδο του χρήστη. Η απόφαση λαμβάνεται με την υποστήριξη ενός LLM περνώντας το μήνυμα προτροπής συστήματος, το ιστορικό συνομιλιών και την ερώτηση του χρήστη.

Επισκόπηση λύσεων

Το παρακάτω διάγραμμα απεικονίζει τη ροή εργασίας της λύσης δυναμικής δρομολόγησης.

Η ροή εργασίας αποτελείται από τα ακόλουθα βήματα:

- Ο χρήστης υποβάλλει μια ερώτηση στον βοηθό AI. Για παράδειγμα, "Ποιες είναι οι μέγιστες μετρήσεις για τη συσκευή 1009;"

- Ένα LLM αξιολογεί κάθε ερώτηση μαζί με το ιστορικό συνομιλίας από την ίδια συνεδρία για να προσδιορίσει τη φύση της και σε ποια θεματική περιοχή εμπίπτει (όπως SQL, δράση, αναζήτηση ή SME). Το LLM ταξινομεί την είσοδο και η αλυσίδα δρομολόγησης LCEL παίρνει αυτήν την είσοδο.

- Η αλυσίδα δρομολογητή επιλέγει την αλυσίδα προορισμού με βάση την είσοδο και το LLM παρέχεται με την ακόλουθη προτροπή συστήματος:

Το LLM αξιολογεί την ερώτηση του χρήστη μαζί με το ιστορικό συνομιλίας για να καθορίσει τη φύση του ερωτήματος και σε ποια θεματική περιοχή εμπίπτει. Στη συνέχεια, το LLM ταξινομεί την είσοδο και εξάγει μια απάντηση JSON στην ακόλουθη μορφή:

Η αλυσίδα δρομολογητή χρησιμοποιεί αυτήν την απόκριση JSON για να καλέσει την αντίστοιχη αλυσίδα προορισμού. Υπάρχουν τέσσερις αλυσίδες προορισμού για συγκεκριμένο θέμα, η καθεμία με τη δική της προτροπή συστήματος:

- Τα ερωτήματα που σχετίζονται με την SQL αποστέλλονται στην αλυσίδα προορισμού SQL για αλληλεπιδράσεις με βάση δεδομένων. Μπορείτε να χρησιμοποιήσετε το LCEL για την κατασκευή του Αλυσίδα SQL.

- Οι ερωτήσεις προσανατολισμένες στη δράση επικαλούνται την προσαρμοσμένη αλυσίδα προορισμού Lambda για την εκτέλεση λειτουργιών. Με το LCEL, μπορείτε να ορίσετε το δικό σας προσαρμοσμένη λειτουργία; στην περίπτωσή μας, είναι μια συνάρτηση που εκτελεί μια προκαθορισμένη συνάρτηση Lambda για την αποστολή ενός email με αναλυμένο αναγνωριστικό συσκευής. Παράδειγμα εισαγωγής χρήστη μπορεί να είναι "Τερματισμός συσκευής 1009".

- Οι έρευνες εστιασμένες στην αναζήτηση προχωρούν στο ΚΟΥΡΕΛΙ αλυσίδα προορισμού για ανάκτηση πληροφοριών.

- Οι ερωτήσεις που σχετίζονται με τις ΜΜΕ πηγαίνουν στην αλυσίδα προορισμού ΜΜΕ/ειδικών για εξειδικευμένες πληροφορίες.

- Κάθε αλυσίδα προορισμού λαμβάνει την είσοδο και εκτελεί τα απαραίτητα μοντέλα ή λειτουργίες:

- Η αλυσίδα SQL χρησιμοποιεί το Athena για την εκτέλεση ερωτημάτων.

- Η αλυσίδα RAG χρησιμοποιεί την Υπηρεσία OpenSearch για σημασιολογική αναζήτηση.

- Η προσαρμοσμένη αλυσίδα Lambda εκτελεί λειτουργίες Lambda για ενέργειες.

- Η αλυσίδα ΜΜΕ/ειδών παρέχει πληροφορίες χρησιμοποιώντας το μοντέλο Amazon Bedrock.

- Οι απαντήσεις από κάθε αλυσίδα προορισμού διατυπώνονται σε συνεκτικές πληροφορίες από το LLM. Στη συνέχεια, αυτές οι πληροφορίες παραδίδονται στον χρήστη, ολοκληρώνοντας τον κύκλο ερωτημάτων.

- Η είσοδος και οι απαντήσεις του χρήστη αποθηκεύονται στο Amazon DynamoDB για την παροχή πλαισίου στο LLM για την τρέχουσα συνεδρία και από προηγούμενες αλληλεπιδράσεις. Η διάρκεια των διαρκών πληροφοριών στο DynamoDB ελέγχεται από την εφαρμογή.

Τεχνική επισκόπηση

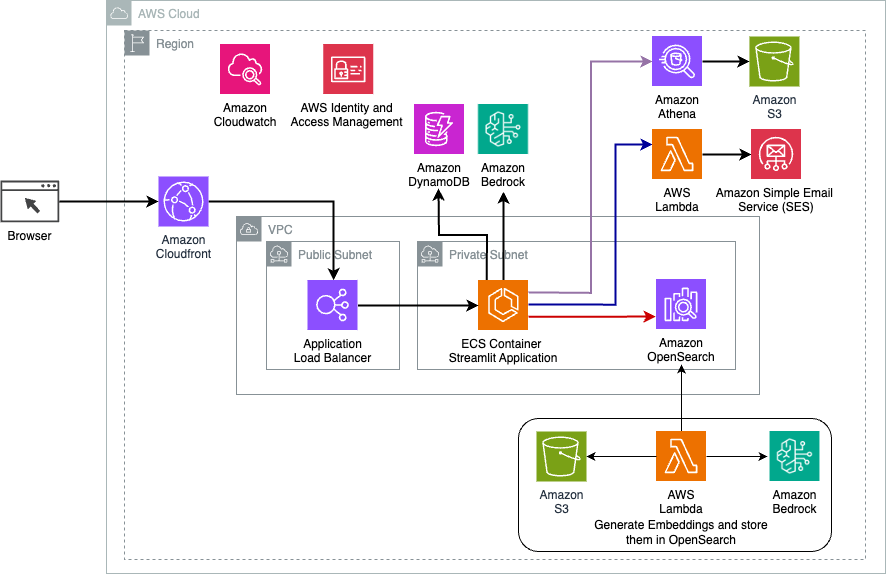

Το παρακάτω διάγραμμα απεικονίζει την αρχιτεκτονική της λύσης δυναμικής δρομολόγησης LangChain.

Η διαδικτυακή εφαρμογή είναι χτισμένη σε Streamlit που φιλοξενείται στο Amazon ECS με Fargate και η πρόσβαση σε αυτήν γίνεται χρησιμοποιώντας ένα Application Load Balancer. Χρησιμοποιούμε το Anthropic's Claude v2.1 στο Amazon Bedrock ως το LLM μας. Η εφαρμογή Ιστού αλληλεπιδρά με το μοντέλο χρησιμοποιώντας βιβλιοθήκες LangChain. Επίσης, αλληλεπιδρά με διάφορες άλλες υπηρεσίες AWS, όπως το OpenSearch Service, το Athena και το DynamoDB για να ικανοποιήσει τις ανάγκες των τελικών χρηστών.

Oφέλη

Αυτή η λύση προσφέρει τα ακόλουθα οφέλη:

- Πολυπλοκότητα υλοποίησης:

- Αν και απαιτεί περισσότερο κώδικα και προσαρμοσμένη ανάπτυξη, το LangChain παρέχει μεγαλύτερη ευελιξία και έλεγχο στη λογική δρομολόγησης και ενσωμάτωση με διάφορα στοιχεία.

- Η διαχείριση διανυσματικών βάσεων δεδομένων όπως η Υπηρεσία OpenSearch απαιτεί πρόσθετες προσπάθειες ρύθμισης και διαμόρφωσης. Η διαδικασία διανυσματοποίησης υλοποιείται σε κώδικα.

- Η ενσωμάτωση με υπηρεσίες AWS ενδέχεται να περιλαμβάνει περισσότερο προσαρμοσμένο κώδικα και διαμόρφωση.

- Εμπειρία προγραμματιστή:

- Η προσέγγιση που βασίζεται στην Python και η εκτεταμένη τεκμηρίωση της LangChain μπορεί να είναι ελκυστικές για προγραμματιστές που είναι ήδη εξοικειωμένοι με την Python και τα εργαλεία ανοιχτού κώδικα.

- Η έγκαιρη ανάπτυξη και εντοπισμός σφαλμάτων ενδέχεται να απαιτούν περισσότερη μη αυτόματη προσπάθεια σε σύγκριση με τη χρήση της κονσόλας Amazon Bedrock.

- Ευελιξία και ευελιξία:

- Το LangChain υποστηρίζει ένα ευρύ φάσμα LLM, επιτρέποντάς σας να κάνετε εναλλαγή μεταξύ διαφορετικών μοντέλων ή παρόχων, ενισχύοντας την ευελιξία.

- Η φύση ανοιχτού κώδικα του LangChain επιτρέπει βελτιώσεις και προσαρμογές με γνώμονα την κοινότητα.

- Ασφάλεια:

- Ως πλαίσιο ανοιχτού κώδικα, το LangChain ενδέχεται να απαιτεί πιο αυστηρούς ελέγχους ασφαλείας και ελέγχους εντός των οργανισμών, προσθέτοντας ενδεχομένως γενικά έξοδα.

Συμπέρασμα

Οι βοηθοί συνομιλίας AI είναι μετασχηματιστικά εργαλεία για τον εξορθολογισμό των λειτουργιών και τη βελτίωση των εμπειριών των χρηστών. Αυτή η ανάρτηση διερεύνησε δύο ισχυρές προσεγγίσεις που χρησιμοποιούν υπηρεσίες AWS: τους διαχειριζόμενους Agents για το Amazon Bedrock και την ευέλικτη, ανοιχτού κώδικα δυναμική δρομολόγηση LangChain. Η επιλογή μεταξύ αυτών των προσεγγίσεων εξαρτάται από τις απαιτήσεις του οργανισμού σας, τις προτιμήσεις ανάπτυξης και το επιθυμητό επίπεδο προσαρμογής. Ανεξάρτητα από την πορεία που ακολουθήσατε, το AWS σάς δίνει τη δυνατότητα να δημιουργήσετε έξυπνους βοηθούς τεχνητής νοημοσύνης που φέρνουν επανάσταση στις αλληλεπιδράσεις επιχειρήσεων και πελατών

Βρείτε τον κωδικό λύσης και τα στοιχεία ανάπτυξης στο δικό μας Αποθετήριο GitHub, όπου μπορείτε να ακολουθήσετε τα λεπτομερή βήματα για κάθε προσέγγιση συνομιλίας AI.

Σχετικά με τους Συγγραφείς

Αμέερ Χακμέ είναι αρχιτέκτονας λύσεων AWS με έδρα την Πενσυλβάνια. Συνεργάζεται με τους Ανεξάρτητους Προμηθευτές Λογισμικού (ISV) στη βορειοανατολική περιοχή, βοηθώντας τους στο σχεδιασμό και την κατασκευή επεκτάσιμων και σύγχρονων πλατφορμών στο AWS Cloud. Εμπειρογνώμονας στο AI/ML και τη γενετική τεχνητή νοημοσύνη, ο Ameer βοηθά τους πελάτες να ξεκλειδώσουν τις δυνατότητες αυτών των τεχνολογιών αιχμής. Στον ελεύθερο χρόνο του, απολαμβάνει να οδηγεί τη μοτοσικλέτα του και να περνά ποιοτικό χρόνο με την οικογένειά του.

Αμέερ Χακμέ είναι αρχιτέκτονας λύσεων AWS με έδρα την Πενσυλβάνια. Συνεργάζεται με τους Ανεξάρτητους Προμηθευτές Λογισμικού (ISV) στη βορειοανατολική περιοχή, βοηθώντας τους στο σχεδιασμό και την κατασκευή επεκτάσιμων και σύγχρονων πλατφορμών στο AWS Cloud. Εμπειρογνώμονας στο AI/ML και τη γενετική τεχνητή νοημοσύνη, ο Ameer βοηθά τους πελάτες να ξεκλειδώσουν τις δυνατότητες αυτών των τεχνολογιών αιχμής. Στον ελεύθερο χρόνο του, απολαμβάνει να οδηγεί τη μοτοσικλέτα του και να περνά ποιοτικό χρόνο με την οικογένειά του.

Σάρον Λι είναι αρχιτέκτονας λύσεων AI/ML στην Amazon Web Services με έδρα τη Βοστώνη, με πάθος να σχεδιάζει και να δημιουργεί Generative AI εφαρμογές στο AWS. Συνεργάζεται με πελάτες για να αξιοποιήσει τις υπηρεσίες AWS AI/ML για καινοτόμες λύσεις.

Σάρον Λι είναι αρχιτέκτονας λύσεων AI/ML στην Amazon Web Services με έδρα τη Βοστώνη, με πάθος να σχεδιάζει και να δημιουργεί Generative AI εφαρμογές στο AWS. Συνεργάζεται με πελάτες για να αξιοποιήσει τις υπηρεσίες AWS AI/ML για καινοτόμες λύσεις.

Καουσάρ Καμάλ είναι ανώτερος αρχιτέκτονας λύσεων στην Amazon Web Services με πάνω από 15 χρόνια εμπειρία στον αυτοματισμό υποδομής και στον χώρο ασφάλειας. Βοηθά τους πελάτες να σχεδιάσουν και να δημιουργήσουν επεκτάσιμες λύσεις DevSecOps και AI/ML στο Cloud.

Καουσάρ Καμάλ είναι ανώτερος αρχιτέκτονας λύσεων στην Amazon Web Services με πάνω από 15 χρόνια εμπειρία στον αυτοματισμό υποδομής και στον χώρο ασφάλειας. Βοηθά τους πελάτες να σχεδιάσουν και να δημιουργήσουν επεκτάσιμες λύσεις DevSecOps και AI/ML στο Cloud.

- SEO Powered Content & PR Distribution. Ενισχύστε σήμερα.

- PlatoData.Network Vertical Generative Ai. Ενδυναμώστε τον εαυτό σας. Πρόσβαση εδώ.

- PlatoAiStream. Web3 Intelligence. Ενισχύθηκε η γνώση. Πρόσβαση εδώ.

- PlatoESG. Ανθρακας, Cleantech, Ενέργεια, Περιβάλλον, Ηλιακός, Διαχείριση των αποβλήτων. Πρόσβαση εδώ.

- PlatoHealth. Ευφυΐα βιοτεχνολογίας και κλινικών δοκιμών. Πρόσβαση εδώ.

- πηγή: https://aws.amazon.com/blogs/machine-learning/enhance-conversational-ai-with-advanced-routing-techniques-with-amazon-bedrock/